JoyVASA是京東健康國際公司開源的音頻驅動的數字人頭項目,基于擴散模型技術,根據音頻信號生成與音頻同步的面部動態和頭部運動。JoyVASA能實現人物的唇形同步和表情控制,還擴展到動物頭像的動畫生成,在多語種支持和跨物種動畫化方面具有廣泛的應用潛力。

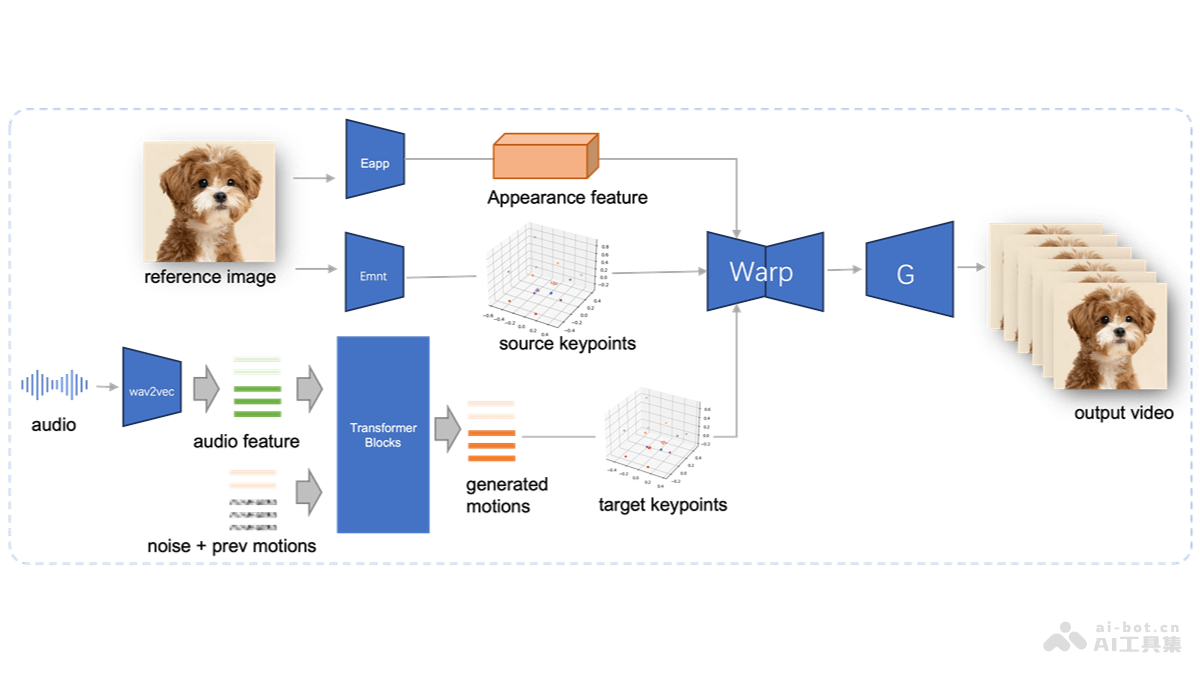

JoyVASA的主要功能音頻驅動的面部動畫:根據輸入的音頻信號生成與之同步的面部動畫,包括嘴唇動作和表情變化。唇形同步:基于音頻與嘴唇動作的精確匹配,實現逼真的對話效果。表情控制:控制和生成特定的面部表情,增強動畫的表現力。動物面部動畫:JoyVASA能生成動物的面部動態,擴展應用范圍。多語言支持:基于在包含中文和英文數據的混合數據集上訓練,JoyVASA支持多語言動畫生成。高質量視頻生成:項目能生成高分辨率和高質量的動畫視頻,提升觀看體驗。JoyVASA的技術原理解耦面部表示:JoyVASA用解耦的面部表示框架,將動態面部表情從靜態3D面部表示中分離出來,生成更長的視頻。擴散模型:項目用擴散模型(diffusion model)直接從音頻提示中生成運動序列,運動序列與角色身份無關。兩階段訓練:第一階段:分離靜態面部特征和動態運動特征,靜態特征捕獲面部的身份特征,動態特征編碼面部表情、縮放、旋轉和平移等動態元素。第二階段:訓練一個擴散變換器(diffusion transformer),從音頻特征中生成運動特征。音頻特征提取:用wav2vec2編碼器提取輸入語音的音頻特征,作為生成運動序列的條件。運動序列生成:基于擴散模型在滑動窗口中采樣音頻驅動的運動序列,運動序列包括面部表情和頭部運動。JoyVASA的項目地址項目官網:jdh-algo.github.io/JoyVASAGitHub倉庫:https://github.com/jdh-algo/JoyVASAHuggingFace模型庫:https://huggingface.co/jdh-algo/JoyVASAarXiv技術論文:https://arxiv.org/pdf/2411.09209JoyVASA的應用場景虛擬助手:在智能家居、客戶服務和技術支持中,以為虛擬助手提供逼真的面部動畫和表情,提升用戶交互體驗。娛樂和媒體:用在生成或增強角色的面部表情和動作,減少傳統動作捕捉的需求。為游戲角色提供更自然的面部表情和動畫,提升游戲的沉浸感。社交媒體:用戶可以利用JoyVASA生成自己的虛擬形象,用于視頻聊天或社交媒體平臺上的內容創作。教育和培訓:在在線教育平臺中,創建虛擬教師,提供更具吸引力的教學體驗。在醫療、軍事等領域,模擬人物反應和表情,用于專業訓練。廣告和營銷:創建吸引人的虛擬代言人,用于廣告宣傳,提高品牌形象的吸引力。

JoyVASA的主要功能音頻驅動的面部動畫:根據輸入的音頻信號生成與之同步的面部動畫,包括嘴唇動作和表情變化。唇形同步:基于音頻與嘴唇動作的精確匹配,實現逼真的對話效果。表情控制:控制和生成特定的面部表情,增強動畫的表現力。動物面部動畫:JoyVASA能生成動物的面部動態,擴展應用范圍。多語言支持:基于在包含中文和英文數據的混合數據集上訓練,JoyVASA支持多語言動畫生成。高質量視頻生成:項目能生成高分辨率和高質量的動畫視頻,提升觀看體驗。JoyVASA的技術原理解耦面部表示:JoyVASA用解耦的面部表示框架,將動態面部表情從靜態3D面部表示中分離出來,生成更長的視頻。擴散模型:項目用擴散模型(diffusion model)直接從音頻提示中生成運動序列,運動序列與角色身份無關。兩階段訓練:第一階段:分離靜態面部特征和動態運動特征,靜態特征捕獲面部的身份特征,動態特征編碼面部表情、縮放、旋轉和平移等動態元素。第二階段:訓練一個擴散變換器(diffusion transformer),從音頻特征中生成運動特征。音頻特征提取:用wav2vec2編碼器提取輸入語音的音頻特征,作為生成運動序列的條件。運動序列生成:基于擴散模型在滑動窗口中采樣音頻驅動的運動序列,運動序列包括面部表情和頭部運動。JoyVASA的項目地址項目官網:jdh-algo.github.io/JoyVASAGitHub倉庫:https://github.com/jdh-algo/JoyVASAHuggingFace模型庫:https://huggingface.co/jdh-algo/JoyVASAarXiv技術論文:https://arxiv.org/pdf/2411.09209JoyVASA的應用場景虛擬助手:在智能家居、客戶服務和技術支持中,以為虛擬助手提供逼真的面部動畫和表情,提升用戶交互體驗。娛樂和媒體:用在生成或增強角色的面部表情和動作,減少傳統動作捕捉的需求。為游戲角色提供更自然的面部表情和動畫,提升游戲的沉浸感。社交媒體:用戶可以利用JoyVASA生成自己的虛擬形象,用于視頻聊天或社交媒體平臺上的內容創作。教育和培訓:在在線教育平臺中,創建虛擬教師,提供更具吸引力的教學體驗。在醫療、軍事等領域,模擬人物反應和表情,用于專業訓練。廣告和營銷:創建吸引人的虛擬代言人,用于廣告宣傳,提高品牌形象的吸引力。