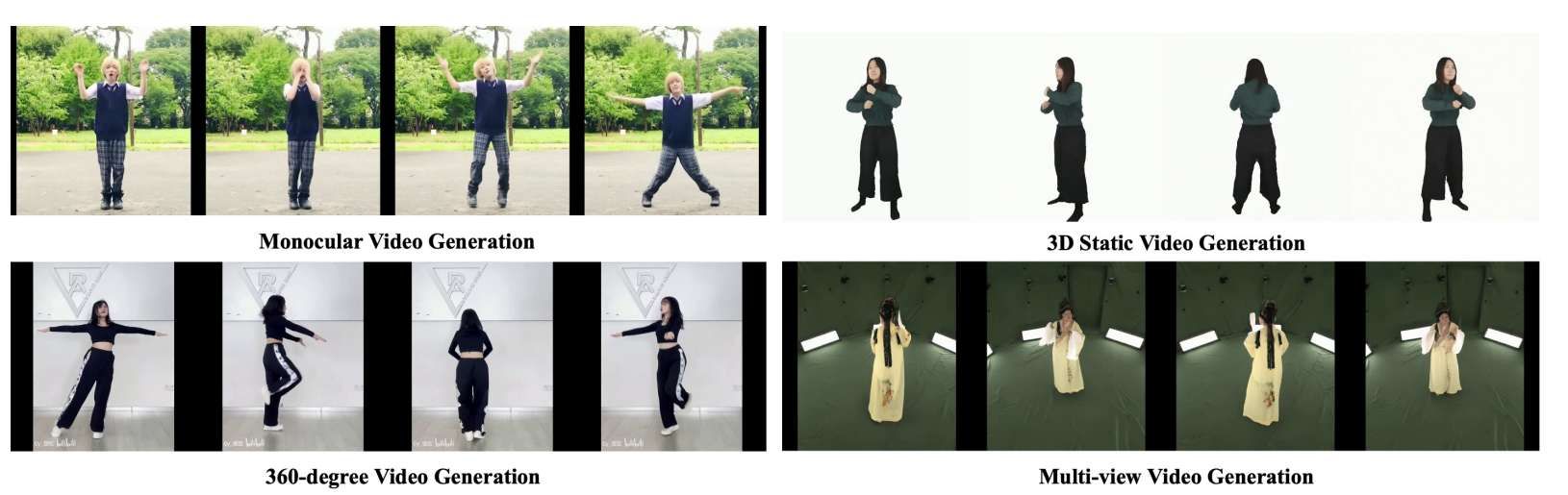

為虛擬現實等領域的多媒體應用鋪平了道路

(中國AI網 2024年11月29日)在一項研究中,清華大學團隊提出了一種從單個圖像生成360度高質量,時空連貫人類視頻的新方法。所述框架結合了diffusion transformer在捕獲跨視點和時間全局相關性的優勢,以及CNN用于精確條件注入的優勢。

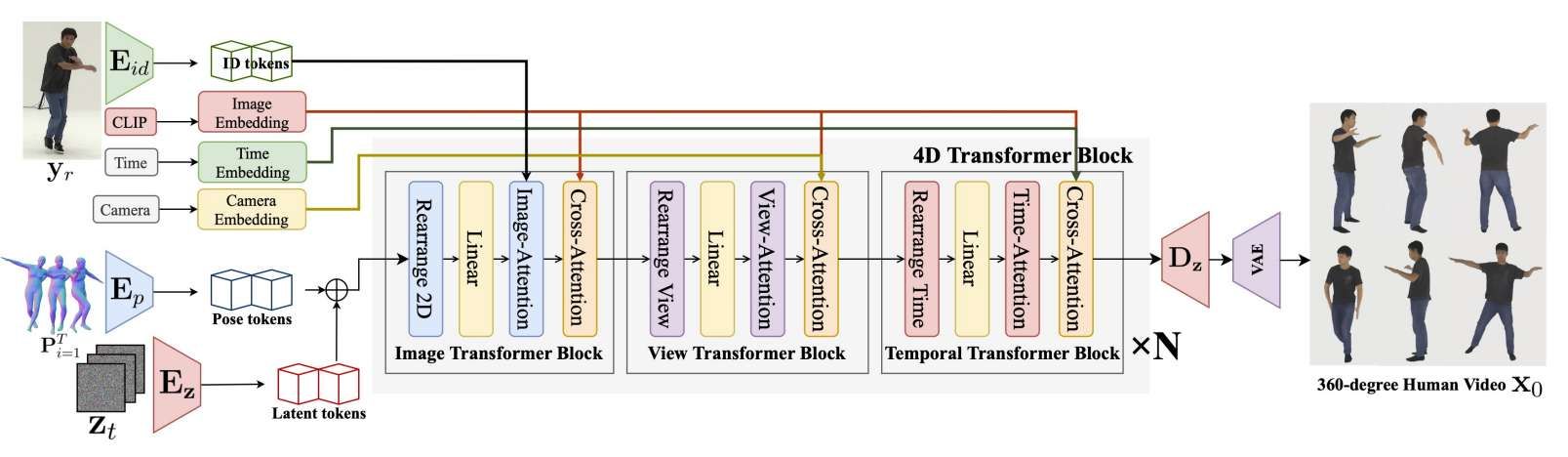

解決方案的核心是一個hierarchical 4D transformer架構,它可以將自關注分解為視圖、時間步長和空間維度,從而實現對4D空間的高效建模。通過將人的身份、camera參數和時間信號注入各自的transformer,可以實現精確的調節,并且克服了以前基于生成對抗網絡或vanilla diffusio模型的方法的局限性

為了訓練這個模型,團隊收集了一個多維數據集,包括圖像、視頻、多視圖數據和有限的4D鏡頭,以及量身定制的多維訓練策略。大量的實驗證明了所述方法能夠合成360度逼真,連貫的人體運動視頻,從而為虛擬現實等領域的多媒體應用鋪平了道路。

人身視頻生成是視頻生成領域的一個活躍研究課題,它在虛擬現實等領域有著廣泛的應用。另外,生成逼真的真人視頻對于推進多媒體技術和實現新形式的人機交互具有重要意義。

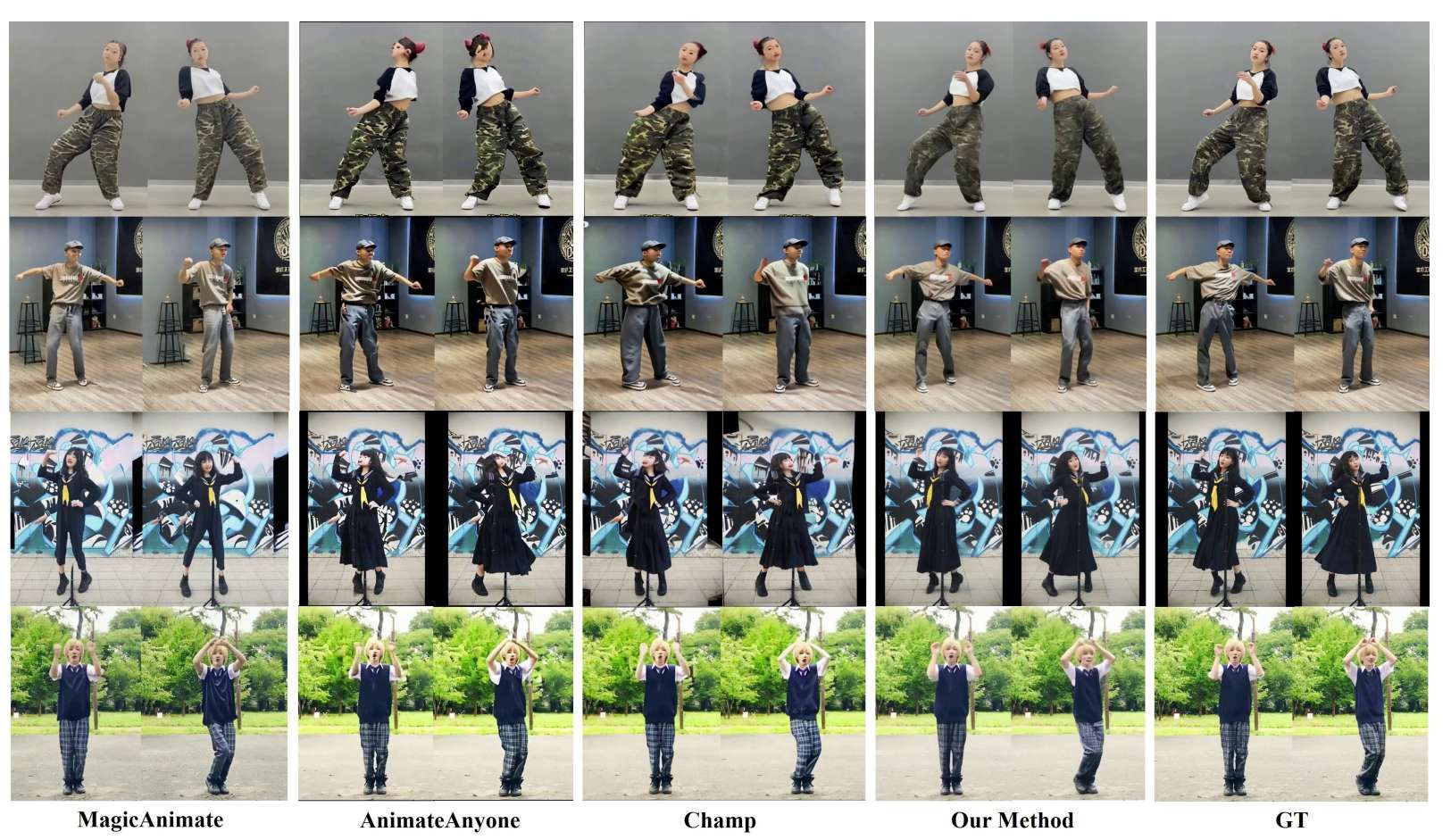

最近,隨著diffusion模型的快速發展,利用diffusion模型生成人類視頻已成為主流方法。為了將人類先驗作為控制條件納入diffusion模型,有研究人員采用了基于骨架的方案,而其他方法則基于SMPL身體模型模板,將SMPL衍生的表示或直接密集姿態嵌入注入diffusion模型。

目前基于CNN架構的人類視頻diffusion模型可以以像素對齊的方式向網絡注入控制條件。然而,UNet對局部卷積操作的依賴使其更側重于局部生成,導致全局方面的性能相對較差,特別是在生成長而復雜的人體動作時。

另外,相關方法只考慮人體本身,忽略了camer視角的視點信息,特別是對于360度人身視頻生成等視點變化較大的場景。

將視點控制信號整合到網絡中,同時保持不同視點和時間之間的一致性,這是一個重大挑戰。為了克服跨視圖和時間生成復雜人體運動的挑戰,清華大學團隊提出了一種結合CNN和diffusion transformer優勢的視頻生成網絡架構。

首先,利用3D SMPL模型而不是2D骨架圖來有效地整合視圖信息和跨多個視點的對應關系。所述方法使用normal human map的渲染作為魯棒的視圖依賴制導,隨后通過基于CNN的編碼器進行處理,以鼓勵網絡捕獲與視圖相關的信息,并精確地注入像素對齊的條件。

然而,在使用基于CNN的架構生成長視頻時,如何保證時間一致性依然是一個挑戰。最近,OpenAI最近在長視頻生成方面的研究采用了diffusion transformer架構,并比基于CNN的模型展示了更好的真實感和時空相干性。

受其啟發,研究人員推出了一個用于人類視頻生成的4D diffusion transformer,它不僅具有更大的可擴展性潛力,而且展示了學習復雜360度人類視頻生成的能力。通過采用不同維度的統一注意力機制,4D DiT可以有效地構建不同視角和時間的時空對應關系,從而保持生成的人類視頻的時空一致性。

然而,直接應用diffusion transformer來學習視圖和時間的相關性在計算成本方面令人望而卻步。所以,團隊提出了一種高效的新型4D transformer結構。其核心原理是通過自關注來級聯學習四維空間(視圖、時間、高度、寬度)的相關性。

具體來說,他們將4D diffusion transformer分解為三個transformer塊:2D圖像transformer塊、時間transformer塊和視圖transformer塊,每個transformer塊都關注4D空間的不同維度。這三種類型的塊相互連接,形成一個4D transformer塊。然后將多個這樣的4D transformer塊級聯以構建最終的4D transformer。這有效地捕獲了跨視點(視圖)和時間步長(時間)的身體部位(高度、寬度)之間的相互關系。

為了增強4D diffusion transformer在SMPL運動之外的可控性,研究人員在各自的網絡模塊中集成了額外的控制信號,包括人的身份、時間信息和camera參數。通過CLIP和基于CNN的編碼器提取的人類身份嵌入和latent token合并到圖像transformer中。從camera參數導出的camera嵌入集成到視圖transformer中,而時間嵌入被集成到時間transformer中。

通過所述模塊,可以有效地將各種控制條件注入到網絡中,以便于視點操縱和生成高保真、一致的人類視頻。另外,為了訓練所提出的4D diffusion transformer模型,團隊同時收集了一個大型多維數據集,并設計了一個多維訓練策略,以充分利用所有可用的數據模式。

所述多維數據集包括圖像,視頻,多視圖視頻,3D掃描,以及跨越不同視點和時間步長的有限數量的4D掃描。在推理階段,他們提出了一種時空一致的diffusion采樣策略,以在有限的時空窗口約束下生成長360度視頻。策略分兩個階段實施。第一階段將360度視頻視為單目長視頻序列,最大化時間窗口以確保長期時間一致性。第二階段將360度視頻視為多視點視頻剪輯的集合,使用較大的視點窗口和較小的時間窗口,以鼓勵視點之間的一致性。

相關論文:Human4DiT: 360-degree Human Video Generation with 4D Diffusion Transformer

總的來說,團隊提出了一種新的人體視頻生成方法:僅將單個圖像作為輸入,并在360度視點下生成動態人體運動的時空相干視頻。所述解決方案采用了一種高效的4D transformer架構來建模跨多個領域的相關性,包括視圖、時間和姿勢。

結合UNets進行精確的條件注入,模型可以在多維數據集上進行訓練。經過訓練,方法可以合成360度逼真,連貫的人體運動視頻。

當然,團隊坦誠,所述方法不是生成顯式4D模型,而是直接從給定的視點合成2D視頻,并通過注意機制隱式編碼4D場景結構。在渲染360度視頻時,缺乏明確的4D表示會導致一定的偽影。