Delta-CoMe是清華大學(xué)NLP實(shí)驗(yàn)室聯(lián)合OpenBMB開源社區(qū)、北京大學(xué)和上海財(cái)經(jīng)大學(xué)提出的新型增量壓縮算法,一個(gè)80G的A100 GPU能輕松加載多達(dá)50個(gè)7B模型,節(jié)省顯存約8倍,同時(shí)模型性能幾乎與壓縮前的微調(diào)模型相當(dāng)。Delta-CoMe基于結(jié)合低秩分解和低比特量化技術(shù),用模型參數(shù)增量(Delta)的低秩特性,實(shí)現(xiàn)混合精度壓縮。這種方法能在大幅降低存儲(chǔ)和推理成本的同時(shí),保持模型性能幾乎無損,尤其在處理數(shù)學(xué)、代碼和多模態(tài)等復(fù)雜任務(wù)時(shí)表現(xiàn)出色。

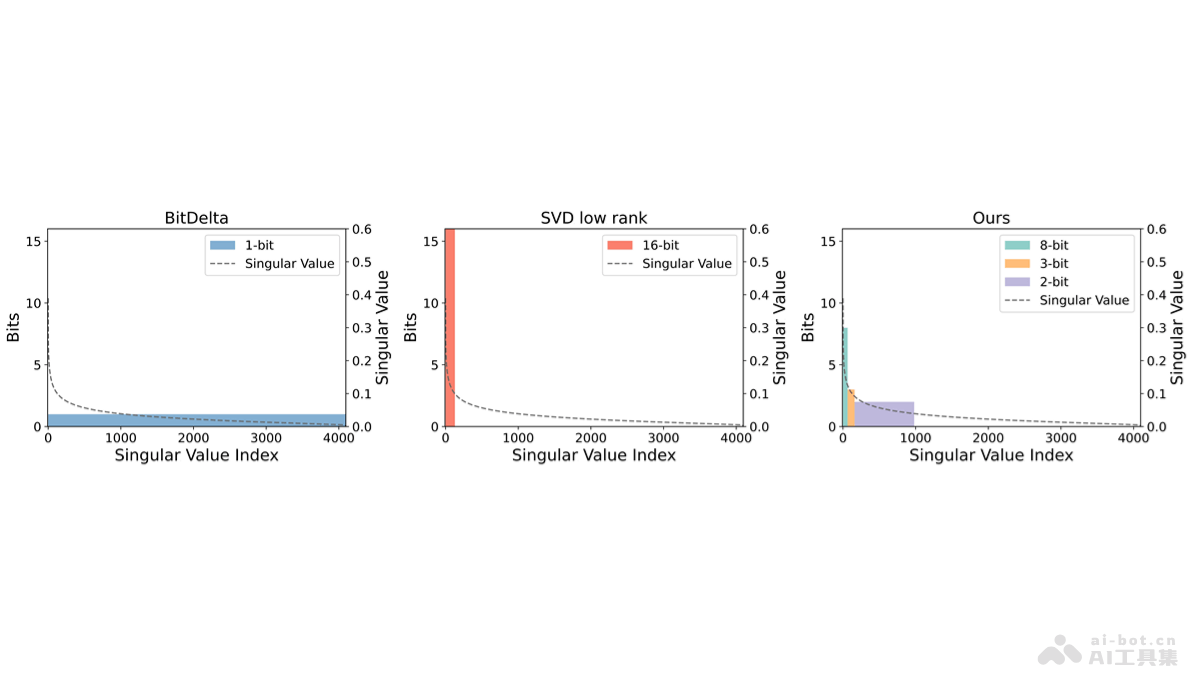

Delta-CoMe的主要功能模型壓縮:基于混合精度壓縮技術(shù),顯著減少大型語言模型(LLMs)的存儲(chǔ)和內(nèi)存需求,讓在有限的硬件資源上部署更多的模型成為可能。性能保持:在壓縮的同時(shí),保持模型的性能,尤其是在復(fù)雜的任務(wù)如數(shù)學(xué)問題解決、代碼生成和多模態(tài)任務(wù)中,確保壓縮后的模型性能接近未壓縮的微調(diào)模型。多任務(wù)處理:支持同時(shí)部署多個(gè)具有不同能力的模型,適用于多租戶和多任務(wù)處理場(chǎng)景,提高模型部署的靈活性和效率。推理速度提升:基于實(shí)現(xiàn)Triton kernel算子,在推理速度上相比PyTorch實(shí)現(xiàn)方式提升近3倍,進(jìn)一步優(yōu)化模型的運(yùn)行效率。Delta-CoMe的技術(shù)原理低秩分解:用奇異值分解(SVD)對(duì)模型參數(shù)增量(Delta)進(jìn)行低秩分解,發(fā)現(xiàn)Delta參數(shù)具有低秩特性,即大部分變化集中在少數(shù)幾個(gè)主成分上。混合精度量化:基于低秩分解的結(jié)果,采用混合精度量化方法,對(duì)不同的奇異向量分配不同的位寬。較大奇異值對(duì)應(yīng)的奇異向量用較高精度表示,而較小奇異值對(duì)應(yīng)的奇異向量用較低精度表示,減少存儲(chǔ)需求。長(zhǎng)尾分布利用:Delta-CoMe觀察到Delta參數(shù)的奇異值呈現(xiàn)長(zhǎng)尾分布,即大部分奇異值較小,只有少數(shù)奇異值較大。因此,對(duì)于小奇異值對(duì)應(yīng)的奇異向量進(jìn)行更激進(jìn)的壓縮,對(duì)于大奇異值對(duì)應(yīng)的奇異向量保留更高的精度。兼容性和泛化性:Delta-CoMe方法適用于特定的模型或任務(wù),而且具有很好的泛化性,能與不同的主干模型(如Llama-2、Llama-3和Mistral)兼容,并在多種任務(wù)上保持良好性能。硬件優(yōu)化:為進(jìn)一步提升推理速度,Delta-CoMe實(shí)現(xiàn)針對(duì)混合精度量化的Triton kernel算子,讓在硬件上的部署更加高效。Delta-CoMe的項(xiàng)目地址GitHub倉(cāng)庫:https://github.com/thunlp/Delta-CoMearXiv技術(shù)論文:https://arxiv.org/pdf/2406.08903Delta-CoMe的應(yīng)用場(chǎng)景多租戶服務(wù):在云計(jì)算環(huán)境中,支持在有限的硬件資源上為每個(gè)客戶提供專用模型,節(jié)省顯存和計(jì)算資源。多任務(wù)處理:在需要同時(shí)處理多種不同任務(wù)的場(chǎng)景中,有效地壓縮和部署不同任務(wù)的模型。端側(cè)部署:在資源受限的邊緣計(jì)算設(shè)備上,減少模型的存儲(chǔ)和內(nèi)存占用。模型微調(diào)服務(wù):對(duì)于需要頻繁微調(diào)以適應(yīng)新數(shù)據(jù)或新任務(wù)的模型,用壓縮微調(diào)后的模型增量,減少存儲(chǔ)和推理成本。學(xué)術(shù)研究和開發(fā):研究人員和開發(fā)者壓縮和部署大型語言模型,進(jìn)行實(shí)驗(yàn)和開發(fā),不受硬件資源的限制。

Delta-CoMe的主要功能模型壓縮:基于混合精度壓縮技術(shù),顯著減少大型語言模型(LLMs)的存儲(chǔ)和內(nèi)存需求,讓在有限的硬件資源上部署更多的模型成為可能。性能保持:在壓縮的同時(shí),保持模型的性能,尤其是在復(fù)雜的任務(wù)如數(shù)學(xué)問題解決、代碼生成和多模態(tài)任務(wù)中,確保壓縮后的模型性能接近未壓縮的微調(diào)模型。多任務(wù)處理:支持同時(shí)部署多個(gè)具有不同能力的模型,適用于多租戶和多任務(wù)處理場(chǎng)景,提高模型部署的靈活性和效率。推理速度提升:基于實(shí)現(xiàn)Triton kernel算子,在推理速度上相比PyTorch實(shí)現(xiàn)方式提升近3倍,進(jìn)一步優(yōu)化模型的運(yùn)行效率。Delta-CoMe的技術(shù)原理低秩分解:用奇異值分解(SVD)對(duì)模型參數(shù)增量(Delta)進(jìn)行低秩分解,發(fā)現(xiàn)Delta參數(shù)具有低秩特性,即大部分變化集中在少數(shù)幾個(gè)主成分上。混合精度量化:基于低秩分解的結(jié)果,采用混合精度量化方法,對(duì)不同的奇異向量分配不同的位寬。較大奇異值對(duì)應(yīng)的奇異向量用較高精度表示,而較小奇異值對(duì)應(yīng)的奇異向量用較低精度表示,減少存儲(chǔ)需求。長(zhǎng)尾分布利用:Delta-CoMe觀察到Delta參數(shù)的奇異值呈現(xiàn)長(zhǎng)尾分布,即大部分奇異值較小,只有少數(shù)奇異值較大。因此,對(duì)于小奇異值對(duì)應(yīng)的奇異向量進(jìn)行更激進(jìn)的壓縮,對(duì)于大奇異值對(duì)應(yīng)的奇異向量保留更高的精度。兼容性和泛化性:Delta-CoMe方法適用于特定的模型或任務(wù),而且具有很好的泛化性,能與不同的主干模型(如Llama-2、Llama-3和Mistral)兼容,并在多種任務(wù)上保持良好性能。硬件優(yōu)化:為進(jìn)一步提升推理速度,Delta-CoMe實(shí)現(xiàn)針對(duì)混合精度量化的Triton kernel算子,讓在硬件上的部署更加高效。Delta-CoMe的項(xiàng)目地址GitHub倉(cāng)庫:https://github.com/thunlp/Delta-CoMearXiv技術(shù)論文:https://arxiv.org/pdf/2406.08903Delta-CoMe的應(yīng)用場(chǎng)景多租戶服務(wù):在云計(jì)算環(huán)境中,支持在有限的硬件資源上為每個(gè)客戶提供專用模型,節(jié)省顯存和計(jì)算資源。多任務(wù)處理:在需要同時(shí)處理多種不同任務(wù)的場(chǎng)景中,有效地壓縮和部署不同任務(wù)的模型。端側(cè)部署:在資源受限的邊緣計(jì)算設(shè)備上,減少模型的存儲(chǔ)和內(nèi)存占用。模型微調(diào)服務(wù):對(duì)于需要頻繁微調(diào)以適應(yīng)新數(shù)據(jù)或新任務(wù)的模型,用壓縮微調(diào)后的模型增量,減少存儲(chǔ)和推理成本。學(xué)術(shù)研究和開發(fā):研究人員和開發(fā)者壓縮和部署大型語言模型,進(jìn)行實(shí)驗(yàn)和開發(fā),不受硬件資源的限制。