單目輸入的自監(jiān)督立體視頻合成

(中國(guó)AI網(wǎng) 2025年04月23日)在空間計(jì)算和虛擬現(xiàn)實(shí)領(lǐng)域,單目輸入的立體視頻合成是一項(xiàng)要求非常高的任務(wù)。主要挑戰(zhàn)在于缺乏高質(zhì)量的成對(duì)立體視頻用于訓(xùn)練,并且難以保持幀間的時(shí)空一致性。現(xiàn)有的方法主要是通過直接將新視圖合成NVS技術(shù)應(yīng)用于視頻,但面臨諸如無法有效表示動(dòng)態(tài)場(chǎng)景和需要大量訓(xùn)練數(shù)據(jù)等限制。

在一項(xiàng)研究中,阿里巴巴團(tuán)隊(duì)介紹了一種新的基于視頻擴(kuò)散模型的自監(jiān)督立體視頻合成范式,稱為SpatialDreamer。

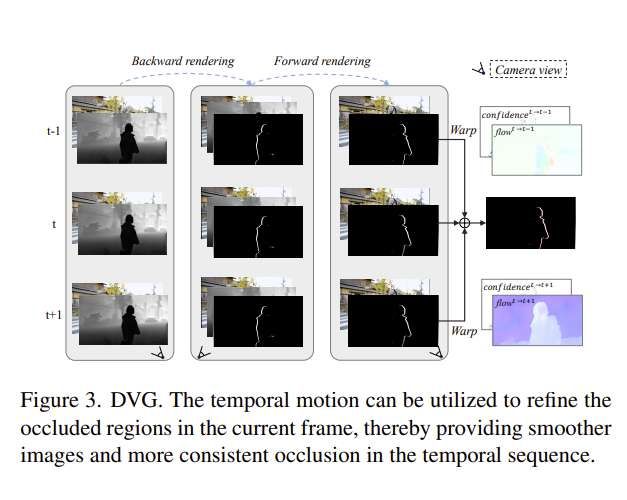

首先,針對(duì)立體視頻數(shù)據(jù)不足的問題,他們提出了一種基于深度的視頻生成模塊DVG,采用正向向后渲染機(jī)制生成具有幾何先驗(yàn)和時(shí)間先驗(yàn)的配對(duì)視頻。

利用DVG生成的數(shù)據(jù),團(tuán)隊(duì)提出了RefinerNet以及一個(gè)自我監(jiān)督的合成框架,目標(biāo)是促進(jìn)高效和專門的訓(xùn)練。更重要的是,他們?cè)O(shè)計(jì)了一個(gè)一致性控制模塊。模塊由立體偏差強(qiáng)度度量和時(shí)間交互學(xué)習(xí)模塊TIL組成,并分別用于幾何一致性和時(shí)間一致性保證。

與各種基準(zhǔn)方法進(jìn)行的比較結(jié)果顯示了其優(yōu)越的性能。

單目輸入立體視頻合成的目的是在給定視圖的基礎(chǔ)上生成具有幾何和時(shí)空一致性的目標(biāo)視圖視頻,在Apple Vision Pro等虛擬現(xiàn)實(shí)內(nèi)容中有著廣泛的應(yīng)用。任務(wù)的主要困難在于缺乏足夠的高質(zhì)量成對(duì)立體視頻用于訓(xùn)練,以及保持兩個(gè)視圖之間的幾何一致性以及保持生成幀之間的時(shí)間一致性。

生成立體內(nèi)容的傳統(tǒng)方法包括使用雙攝像頭設(shè)置捕獲場(chǎng)景。然而,圖像的獲取涉及使用專業(yè)級(jí)攝像頭,導(dǎo)致大量的成本。

深度學(xué)習(xí)的最新進(jìn)展主要是通過直接將單目到立體或多視角圖像生成技術(shù)應(yīng)用于視頻來解決所述問題,但經(jīng)常面臨與幾何和時(shí)空不一致性相關(guān)的挑戰(zhàn)。

如圖1所示,基于NVS的方法難以保持準(zhǔn)確的時(shí)空一致性,這是因?yàn)樵趶?fù)雜的動(dòng)態(tài)場(chǎng)景中,幀之間的時(shí)間一致性和成對(duì)視圖之間的空間信息難以處理。

在研究中,阿里巴巴團(tuán)隊(duì)提出了一種基于視頻擴(kuò)散模型的自監(jiān)督立體視頻合成范式,稱為SpatialDreamer,而它可以同時(shí)解決數(shù)據(jù)不足和時(shí)空不一致的問題。

首先,團(tuán)隊(duì)設(shè)計(jì)了一個(gè)基于深度的視頻數(shù)據(jù)生成模塊DVG來解決數(shù)據(jù)不足的問題。在不需要數(shù)據(jù)標(biāo)注的情況下,DVG采用正向向后渲染的方式構(gòu)建兩個(gè)視圖的訓(xùn)練對(duì)。

另外,他們利用光流獲得的幀間運(yùn)動(dòng)來改進(jìn)視頻數(shù)據(jù)的生成,以細(xì)化立體遮擋遮罩。這種方法使DVG能夠產(chǎn)生保持幾何和時(shí)間一致性的成對(duì)視頻數(shù)據(jù)。利用DVG生成的配對(duì)視頻,團(tuán)隊(duì)進(jìn)一步提出了RefinerNet,以及一個(gè)自我監(jiān)督的視頻合成框架,以實(shí)現(xiàn)高效和有針對(duì)性的訓(xùn)練。

更重要的是,通過訪問足夠的配對(duì)視頻,他們?cè)O(shè)計(jì)了一致性控制模塊。其中,模塊由立體偏差強(qiáng)度度量和時(shí)間交互學(xué)習(xí)模塊TIL組成。立體偏差強(qiáng)度的目的是為了在不同的現(xiàn)實(shí)場(chǎng)景中生成立體視頻。

系統(tǒng)進(jìn)一步利用立體感知損失來監(jiān)督模型學(xué)習(xí)latent空間中成對(duì)視圖特征之間的差值大小。TIL將來自長(zhǎng)時(shí)間幀的潛在特征集成為全局信息,以增強(qiáng)生成結(jié)果的時(shí)間相干性。

團(tuán)隊(duì)指出,訓(xùn)練過程分為兩個(gè)階段。在第一個(gè)訓(xùn)練階段,專注于視頻中的單個(gè)幀。對(duì)U-Net去噪中的時(shí)間層進(jìn)行凍結(jié),去掉TIL模塊。RefinerNet模型和去噪U(xiǎn)-Net分別使用SD2.1和SVD的預(yù)訓(xùn)練權(quán)值進(jìn)行初始化。

變分自編碼器、編碼器和解碼器以及對(duì)比語言圖像預(yù)訓(xùn)練(CLIP)圖像編碼器的權(quán)值均保持固定。這一階段的目的是讓模型在有參考圖像和新的視點(diǎn)姿態(tài)的情況下學(xué)習(xí)合成新的視點(diǎn)圖像。在第二階段,用視頻序列訓(xùn)練時(shí)序?qū)雍蚑IL模塊。這使模型能夠有效地捕獲時(shí)間上下文信息。

大量的實(shí)驗(yàn)與各種基準(zhǔn)方法的比較表明,它達(dá)到了最先進(jìn)的性能。值得注意的是,SpatialDreamer滿足了現(xiàn)實(shí)世界應(yīng)用的需求,沒有抖動(dòng),幾何和時(shí)間不一致。

相關(guān)論文:SpatialDreamer: Self-supervised Stereo Video Synthesis from Monocular Input

總的來說,團(tuán)隊(duì)介紹了一種使用視頻擴(kuò)散模型的自監(jiān)督立體視頻合成方法,稱為SpatialDreamer。所述方法解決了數(shù)據(jù)不足和幀間時(shí)空不一致的問題。

其中,為了解決數(shù)據(jù)不足的問題,開發(fā)了一個(gè)基于深度的視頻生成模塊,使用正向向后渲染機(jī)制來生成具有幾何和時(shí)間先驗(yàn)的渲染視頻。另外,提出RefinerNet以及一個(gè)自監(jiān)督合成框架,以便使用DVG生成的數(shù)據(jù)進(jìn)行高效和專用的訓(xùn)練。同時(shí),他們還設(shè)計(jì)了一致性控制模塊,以確保幾何和時(shí)間的一致性。

SpatialDreamer優(yōu)于所有其他開源立體圖像和視頻合成方法,并有可能在未來擴(kuò)展到虛擬現(xiàn)實(shí)應(yīng)用中。