姿態估計

(中國AI網 2025年05月06日)對于AR等用例,估計手持物體姿態是一項重要但具有挑戰性的任務。一個前景方向是利用多模態數據,如顏色RGB和深度圖像。隨著3D傳感器的日益普及,一系列的機器學習方法已經出現。

然而,現有的方法面臨兩個主要挑戰。首先,當手遮擋所持物體時,它們會面臨精度下降的問題,從而模糊了姿態估計所需的關鍵特征。另外,手-對象交互引入了非剛性轉換,令問題進一步復雜化。當手改變握著物體的形狀或結構時,就會發生這種情況,比如擠壓一個軟球時,會扭曲物體的感知形狀。

其次,目前大多數技術從單獨的RGB和RGB- D主干中提取特征,然后在特征級別進行融合。由于這兩個主干處理本質上不同的模態,這種融合可能導致表征分布的變化,意味著從RGB圖像中學習到的特征可能與從RGB- D輸入中提取的特征不一致,從而影響姿態估計。另外在微調期間,兩個主干網之間的密集交互會導致性能中斷,并限制了合并RGB特性的好處。

為了解決相關問題,日本芝浦工業大學團隊開發了一種創新的深度神經網絡,專門用于使用RGB-D圖像進行姿態估計。

研究人員指出:“我們深度學習框架的關鍵創新在于基于Vote的融合機制,有效地集成了2D (RGB)和3D(深度)關鍵點,同時解決了手引起的遮擋和融合多模態數據的困難。另外,它解耦了學習過程,并結合了一個基于自注意的手-物交互模型,從而產生了實質性的改進。”

所提出的深度學習框架由四個部分組成:從2D圖像和3D點云數據中提取高維特征的主干、Vote模塊、基于Vote的新型融合模塊和手部感知對象姿態估計模塊。

一開始,2D和3D骨架從RGB-D圖像中預測手和物體的2D和3D關鍵點。關鍵點是指輸入圖像中有意義的位置,有助于描述手和物體的姿態。接下來,每個骨干中的Vote模塊獨立地為各自的關鍵點投票。

然后通過基于Vote的融合模型對投票進行整合。模型使用基于半徑的鄰域投影和通道關注機制動態地將2D和3D投票組合在一起。前者保留局部信息,而后者適應不同的輸入條件,從而確保魯棒性和準確性。

這種基于Vote的融合有效地利用了RGB和深度信息的優勢,減輕了手引起的遮擋和不對齊的影響,從而實現了準確的手-物體姿態估計。

最后一個組件是手感知物體姿態估計模塊,通過使用自注意機制捕獲手和物體關鍵點之間的復雜關系,進一步提高了精度。這允許系統考慮由不同手的姿態和握持引起的非剛性轉換。

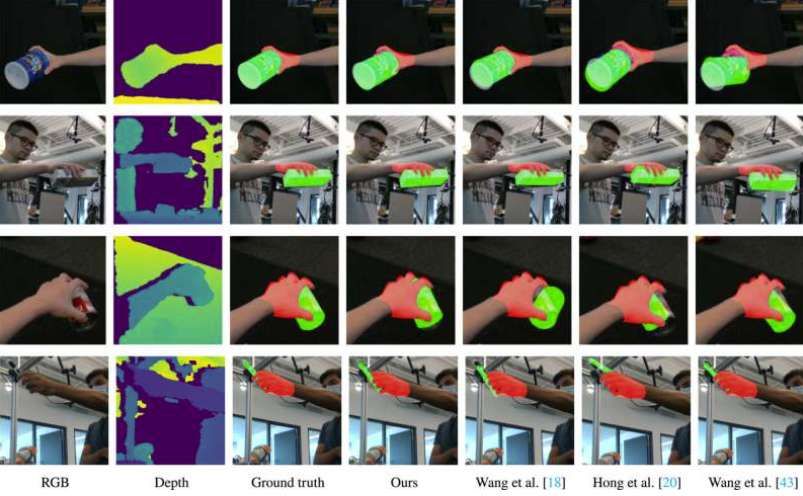

為了測試框架,研究人員在三個公共數據集進行了實驗。結果表明,與最先進的方法相比,所述方法在準確性(高達15%)和穩健性方面有了顯著提高。

另外,現場實驗表明,平均精度為76.8%,與現有方法相比性能提高高達13.9%。不僅只是這樣,框架在沒有細化的情況下實現了40毫秒和200毫秒的推理時間,證明了現實世界的適用性。

團隊表示:“我們的方法不僅更準確,而且比許多現有技術更簡單。它有可能加速人工智能系統的部署,比如沉浸式AR/VR技術。”

相關論文:Vote-based multimodal fusion for hand-held object pose estimation

總的來說,這種創新的方法可以幫助推進AR技術,幫助模擬更逼真的手-物交互。