生成更逼真、物理上更合理的3D交互姿態

(中國AI網 2025年05月12日)從文本描述生成逼真的三維人-物交互(HOI)是一個活躍的研究課題,在虛擬和增強現實等領域具有潛在的應用前景。然而,由于缺乏大規模交互數據和難以確保物理合理性,特別是在域外(OOD)場景中,創建高質量的3D HOD依然具有挑戰性。

目前的方法傾向于關注身體或手,這限制了它們產生逼真交互的能力。在一項研究中,來自中國科學院,中國科技學院大學,山東大學和北京科技大學等機構的團隊提出了OOD-HOI。

這是一個文本驅動的框架,用于生成全身人-對象交互,而它可以很好地泛化到新的對象和動作。所述方法集成了一個dual-branch反擴散模型來合成初始交互姿態,一個接觸引導的交互精細化器來提高基于預測接觸面積的物理精度,以及一個包括語義調整和幾何變形在內的動態適應機制來提高魯棒性。

實驗結果表明,與現有方法相比,OOD- HOI可以在OOD場景中生成更逼真、物理上更合理的3D交互姿態。

文本驅動的三維人物交互合成(HOI)近年來備受關注,其目的是在人與物體之間產生連貫的、語義上有意義的交互。精確的3D HOI方法在虛擬現實和增強現實等各個領域顯示出巨大的應用潛力。因此,為各種應用程序創建物理上合理且與上下文相關的3D場景至關重要。

盡管做出了顯著的努力,但由于缺乏大規模交互數據和物理先驗,從文本描述生成三維人機交互依然面臨重大挑戰。具體而言,與3D人體運動生成相比,現有的人-物交互數據集大約要小10倍。

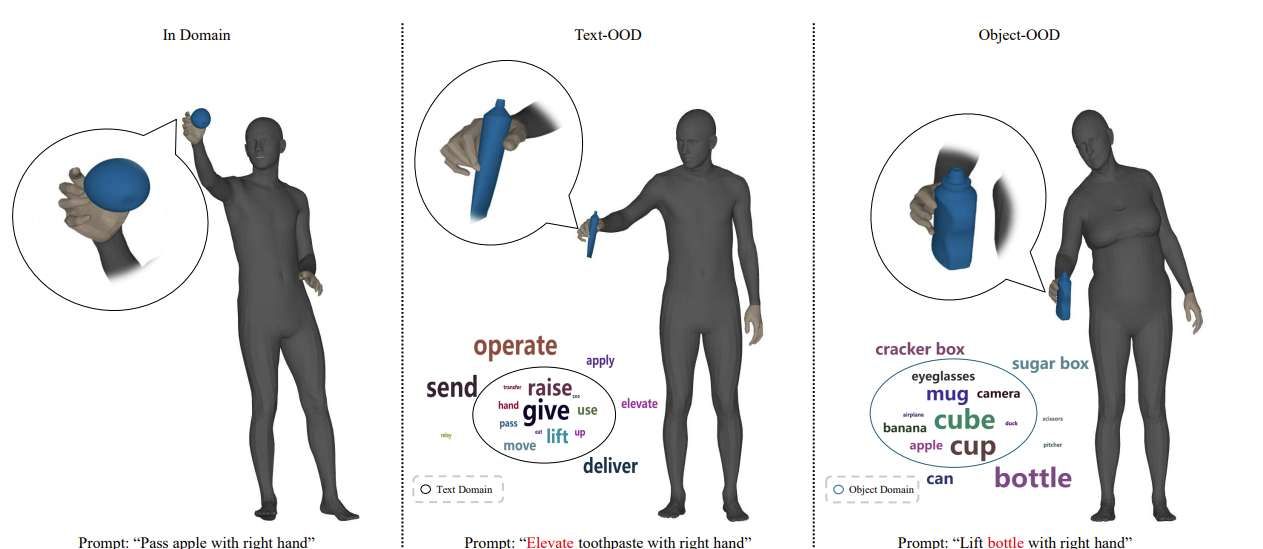

另外,相關數據集是從特定場景(例如動捕或模擬)中收集。最近先進的文本到3D HOI方法在域外場景下表現出顯著的性能下降,特別是在細粒度文本描述或基于圖像的姿態估計器指導下的多樣性和可控性方面。

另一方面,由于文本描述固有的模糊性,生成幾何上和語義上合理的抓取物體的全身化身是具有挑戰性的。

為了解決上述問題,現有的文本驅動3D HOI合成方法涉及擴展現有的擴散模型,以生成人-物交互,而這大致可分為兩種:以身體為中心的方法和以手為中心的方法。

前一種方法側重于建模身體-物體接觸,捕獲交互的一般運動趨勢,但往往忽略手的精確作用。這種遺漏限制了它們產生完全真實的交互的能力,因為手在操縱物體時起著至關重要的作用。

另一方面,以手為中心的方法生成了手抓動作,但忽略了身體的其他部分,導致手的動作與身體的姿勢和互動的背景不一致,從而導致不夠現實的結果。

三維人機交互生成的另一個重要問題是處理域外(OOD)泛化。當訓練模型遇到與訓練數據顯著偏離的提示時,例如新對象、不尋常的動作或模型以前從未見過的獨特的人-對象組合,就會出現這種情況。

GraspTTA提出了域外對象泛化的測試時間適應范式,InterDreamer利用大語言模型生成相應的似是而非的人-對象交互。盡管相關方法在通常的動作層面方面已經實現了泛化能力,但在新對象層面,它們依然難以產生合理的上下文交互。

所以,團隊結合人體、手和物體的生成,提出了一種新的文本驅動的三維人-物交互的域外生成方法,命名為OOD-HOI。

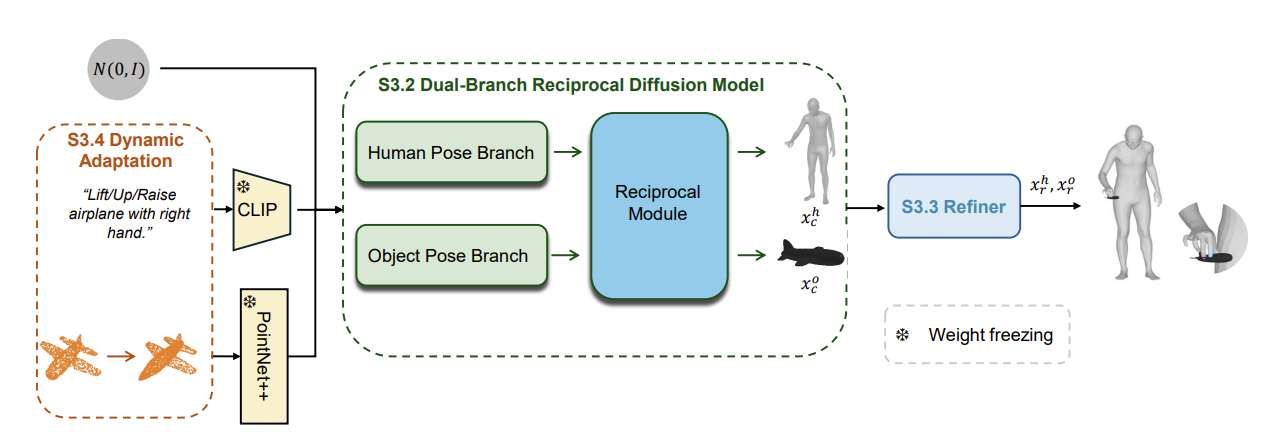

具體來說,提出的OOD-HOI包括三個組成:雙分支互反擴散模型,接觸引導的相互作用細化器和動態自適應。具體而言,dual-branch反擴散模塊旨在從文本描述和物體點云以組合方式生成全身交互。

接觸引導的交互細化器通過將預測的接觸面積作為可在推斷時應用于擴散過程的指導來修正相互作用姿態。

為了提高泛化能力,研究人員進一步提出了一種動態自適應方法來增強未見對象和各種文本描述的生成。具體來說,他們認為泛化的重點是文本描述和動作以及各種對象之間的對齊。因此,引入語義調整和幾何變形來分別解決文本- OOD和對象- ODD問題。

相關論文:OOD-HOI: Text-Driven 3D Whole-Body Human-Object Interactions Generation Beyond Training Domains

總的來說,團隊提出了一種新的文本驅動方法,通過聯合考慮人體、手和物體之間的信息交換來生成全身人-物體交互。這是通過兩階段框架實現:

使用雙分支互反擴散模型生成初始交互姿態

根據預測的接觸面積改進初始人-物姿態。

為了解決域外問題,研究人員引入了動態自適應,包括語義調整和幾何變形。實驗結果驗證了所提出方法在域內和域外數據集的有效性,表明方法優于最先進的基線,具有增強的物理合理性和魯棒性。