暈動癥預測

(中國AI網 2025年05月15日)暈動癥是沉浸式虛擬現實體驗廣泛普及的一個重大障礙,因為它會極大地破壞用戶的參與度和舒適度。研究表明,暈動癥可以在頭部和眼動追蹤數據以及其他生理數據中得到顯著反映。

盡管應用了CNN和LSTM等深度學習技術,但模型往往難以捕獲多個數據模式之間的復雜交互,缺乏實時推理能力,限制了它們的實際應用。

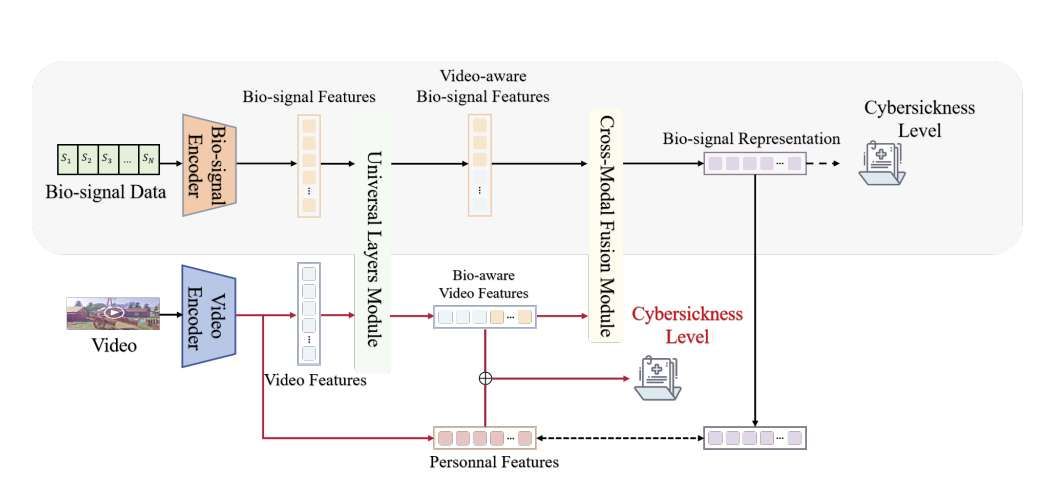

為了解決這一差距,香港科技大學(廣州)團隊提出了一種輕量級模型,利用基于transformer的編碼器來處理生物信號特征,并通過PP-TSN網絡來提取視頻特征。然后,通過跨模態融合模塊集成功能,創建一個視頻感知生物信號表示,支持基于視覺和生物信號輸入的暈動癥預測。

模型經過輕量級框架的訓練,在包含眼動和頭部追蹤數據、生理數據和VR視頻的公共數據集進行了驗證,并在暈動癥預測方面展示了最先進的性能,僅使用VR視頻輸入就實現了93.13%的高精度。相關發現表明,所提出方法不僅能夠有效、實時地預測暈動癥,而且解決了VR環境中長期存在的模態交互問題。

VR正在迅速發展,圖形、運動追蹤和用戶舒適度方面的進步推動了新應用和沉浸式體驗的發展,并擴大了VR在各個領域的應用范圍,包括醫療保健領域、工業安全領域、游戲領域等等。

然而,引起頭暈、惡心和不適等癥狀的暈動癥依然是VR廣泛采用和長期使用的重大障礙。所以,業界正在進行的研究重點是了解和減輕暈動癥的影響,以改善用戶體驗和VR可用性。

盡管有研究人員嘗試通過多模態方法來解決相關挑戰,但模型并沒有充分考慮不同模態之間的相互關系。為了克服這一限制,香港科技大學(廣州)團隊選擇了帶有生理數據的頭部和眼動追蹤,而不是腦電圖,因為所述因素同樣顯示出與暈動癥的高度相關性。

團隊解決了生物信號和視頻內容的模態協作和模態糾纏。網絡設計包含共享功能模塊,以鼓勵跨模態的協作,同時保留模態特定的模塊來處理模態糾纏的挑戰。然而,使用時間序列數據依然面臨額外的挑戰。例如,處理數據類型的高計算成本限制了實時應用,使當前模型無法充分適應用戶行為和環境變化。

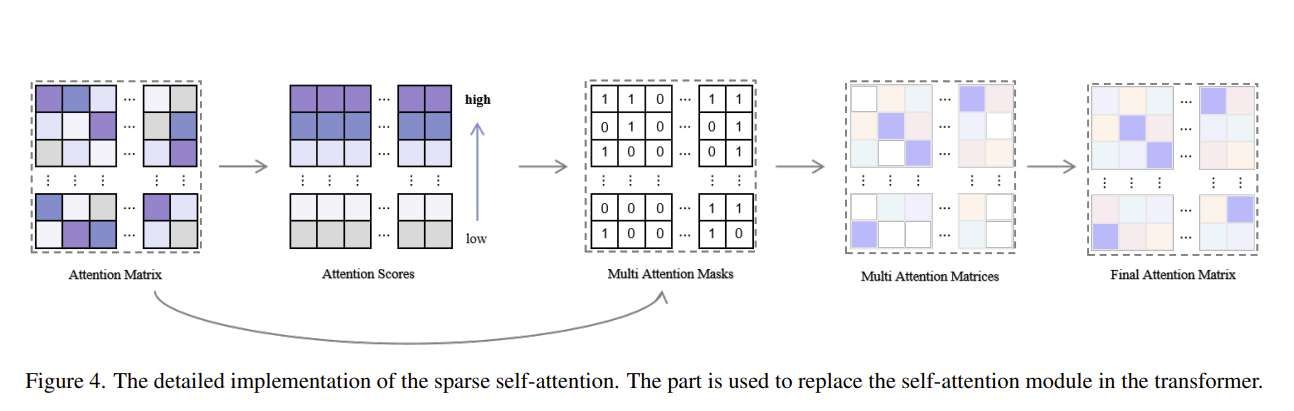

所以,對于視頻感知生物信號表示學習,研究人員采用基于transformer的稀疏自關注模型,以減少提取生物信號特征時的計算成本。

同時,基于PP-TSN的編碼器網絡從視頻中捕獲視覺特征。然后將生物信號和視覺特征結合在一個融合模塊中,以產生視頻感知的生物信號表示。表示隨后用于重新訓練基于PP-TSN的網絡,使其能夠僅使用VR視頻內容提取視覺和認知特征,并用于個性化暈動癥預測。

所提出模型由數個關鍵組件組成:生物信號編碼器模塊、視頻編碼器模塊、作為多模態樞紐的通用層模塊和跨模態融合模塊。模型首先采用兩個獨立的單模態編碼器:一個用于編碼視頻數據,另一個用于編碼生物信號數據。編碼器旨在捕獲每個個體形態的固有特征,確保視覺和生理信息都準確地表示出來。

一旦編碼視頻和生物信號數據,它們各自的視覺和認知表征就輸入到通用層模塊中。模塊由多個通用層組成,通過將不同的模態投射到共享的語義空間來對齊它們。這種投影有利于跨模態對齊,同時保留每個模態的原始特征,這對于保持生物信號和視頻輸入的獨特性至關重要。

為了進一步增強這些模態的融合,團隊應用了專用的跨模態融合模塊。所述模塊集成了來自兩種模態的對齊表示,產生了一個穩健的跨模態表示,可以用于下游任務,如預測或分類。通過這種架構,模型有效地融合了來自生物信號和視頻數據的互補信息,從而能夠更全面地了解用戶的生理和視覺狀態。

這項研究最重要的發現在于開發了一種輕量級的跨模式學習框架,可以僅基于VR內容進行個性化暈機預測,將生物信號與VR視頻數據無縫集成。研究結果支持了一個假設,即多模式、個性化的方法比傳統的一刀切方法更有效。

結果與之前關于個性化模型重要性的研究一致,并同時展示了一個更高效的解決方案。模型不僅捕獲了多個數據源之間的關系,而且解決了模態糾纏的挑戰,相較于之前的研究提供了一種更全面、更可擴展的方法來預測暈動癥。

實驗結果表明,用稀疏注意取代自我注意和改進輕型骨干網絡對減少成本時間有很大幫助。這兩種變化都能以更少的推理時間獲得更高的精度。

值得注意的是,本研究使用的是現有的數據集。感官數據的實時采集與預處理相結合的研究存在空白。盡管模型在當前的訓練和測試數據集上表現出色,但其對有限VR內容集的關注可能會限制其在不同VR應用和類型中的適用性。

另外,用戶疲勞或壓力等因素可能會影響結果。所以,需要進一步的研究來確定相關發現在更廣泛的情況下的泛化程度。

為了充分利用該模型的潛力,未來的研究應該擴展數據集,以包括更多樣化的用戶配置文件,涵蓋不同的年齡組和VR經驗水平。優化模型以兼容更廣泛的VR硬件和內容類型同樣至關重要。最后,整合額外的生物信號或環境因素可以進一步了解影響暈動癥的因素。

相關論文:Real-time Cross-modal Cybersickness Prediction in Virtual Realit

總的來說,團隊提出了一個基于視頻感知生物信號表示學習和暈動癥學習的實時個體暈動癥預測輕量級模型。在對生物信號數據進行編碼的過程中,采用了基于transformer的稀疏自關注,以獲得生物信號的特征。同時,利用基于PP-TSN的網絡從視頻中提取視覺特征。將視覺特征和生物信號特征輸入到跨模態融合模塊中,得到視頻感知的生物信號表示。通過將輸出與特定特征匹配,對基于PP-TSN的網絡進行重新訓練,以提取視覺認知特征。在MAC數據集的實驗結果表明,它可以以更少的推理時間實現最先進的性能。