減少了82%以上的訓練時間

(中國AI網 2025年05月15日)有效地從單目視頻重建3D場景依然是計算機視覺的核心挑戰,而這對于虛擬現實和場景理解等應用至關重要。目前,通常采用逐幀遞進重建,不考慮camera姿態,而這在縮放到較長視頻時會產生較高的計算開銷和復合誤差。

為了克服所述問題,得克薩斯大學奧斯汀分校,賓夕法尼亞大學,斯坦福大學,約翰斯·霍普金斯大學和Meta團隊推出了VideoLifter。這種新型的視頻到3D管道在片段的基礎上利用本地到全局策略,實現了極高的效率和SOTA質量。

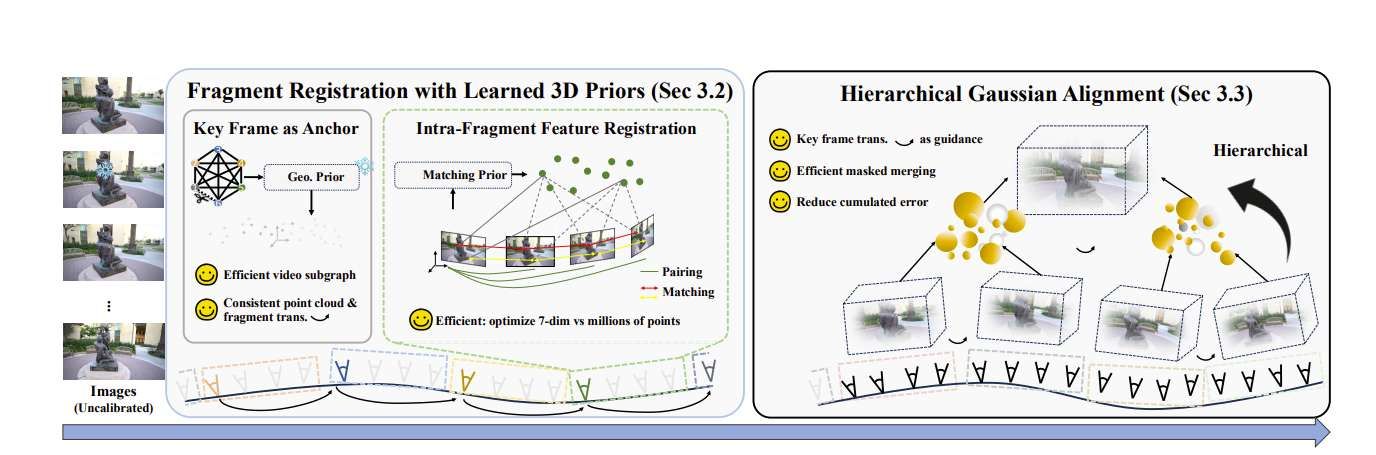

在本地,VideoLifter利用可學習的3D先驗來配準片段,提取必要的信息,用于隨后的3D高斯初始化,強制片段間一致性和優化效率。

在全局,采用基于關鍵幀引導的樹狀分層合并方法進行片段間對齊,并結合高斯點剪枝進行兩兩合并,再進行聯合優化,在保證全局一致性的同時有效降低累積誤差。所述方法顯著加快了重建過程,減少了82%以上的訓練時間,同時保持了比當前SOTA方法更好的視覺質量。

從連續的圖像觀察中有效地重建3D場景是計算機視覺領域的一個長期挑戰。最近,從單個視頻序列(視頻到3D)重建3D場景獲得了廣泛的關注。這一趨勢是由兩個因素驅動:手持式捕獲設備的日益普及,使視頻捕獲對非專業用戶更加實用;以及高保真3D重建方法的最新進展,如神經輻射場NeRF和3DGS。

大多數基于NeRF或3DGS的視頻到3D重建方法嚴重依賴于結構從運動(SfM)來生成初始稀疏重建。然而,當應用于視頻數據時,SfM往往不可靠,甚至是不可行,因為它依賴于光度假設,而相關假設在低紋理或具有挑戰性的照明條件下經常失效。

作為回應,最近的方法已經轉向聯合優化camera姿勢和場景表示,而不是僅僅依賴于基于SfM的初始化。然而,相關方法依然依賴于SfM中精確的camera特性,限制了它們在in the wild視頻場景中的適用性。

更重要的是,不需要SfM的視頻到3D方法通常是從一個標準視圖逐步重建場景,而這有兩個關鍵問題。首先,它們是緩慢和低效的。其次,它們容易出現增量誤差,因為逐幀的方法往往會在較長的視頻序列中累積誤差。

為了解決所述問題,得克薩斯大學奧斯汀分校,賓夕法尼亞大學,斯坦福大學,約翰斯·霍普金斯大學和Meta團隊提出了VideoLifter。

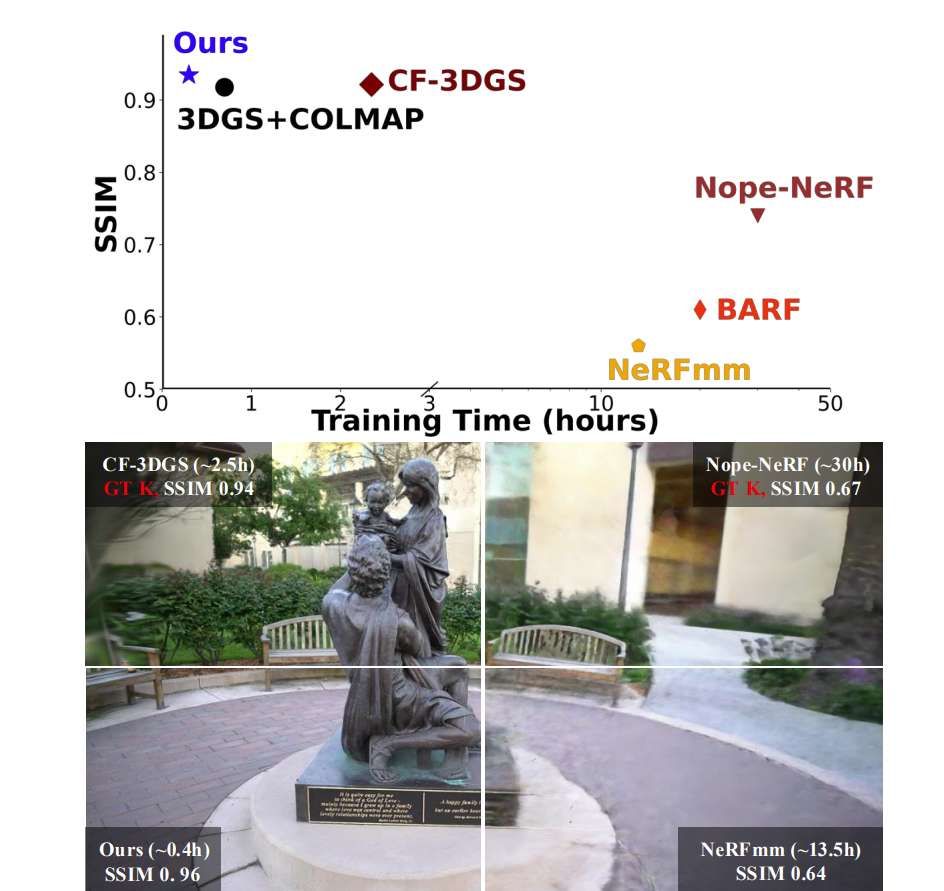

這是一種新型的視頻到3D重建管道,與最先進的方法相比,它實現了5倍的加速和增強的視圖合成質量,如圖1所示。

團隊有效地采用局部到全局流來處理片段基礎上的長序列視頻,然后將片段合并成最終的,全局一致的3D場景。管道由兩項關鍵創新驅動,使得本地到全局的概念在顯著提高效率和大大減少增量誤差的情況下可行。

首先,在具有學習3D先驗(局部)階段的片段配準中,通過利用預訓練的先驗模型來解決第一個問題,從每個片段中提取基本信息。不是像InstantSplat那樣使用3D先驗來初始化3D高斯函數,而是通過以下方式提高效率:

通過僅考慮關鍵幀(設置為第一幀)來強制片段間一致性,在高效子圖而不是完整圖上求解

僅提取片段內每個視圖的基本參數,從而避免了代價高昂的全局點圖優化。

在分層高斯對齊(全局)階段,通過基于樹的分層框架進行片段合并。框架采用關鍵幀引導進行片段間對齊,兩兩合并高斯點剪枝,隨后進行聯合優化,以確保全局一致性并有效減輕累積誤差。

在定量評估合成新視圖的質量中,與其他自校準輻射場方法相比,團隊所提出方法在效率和渲染質量方面取得了卓越的性能,這在很大程度上歸功于解耦片段配準和分層對齊過程。與最相關的基線CF-3DGS相比,所述方法減少了>80%的訓練時間,同時得到了>0.012 LPIPS的提高;在CO3D-V2數據集減少了>85%的訓練時間,同時得到了>0.12 LPIPS的提高。

請注意,VideoLifter不需要任何真實的camera參數,使其更適用于沒有或未能從COLMAP獲得預計算特性的場景。與NeRFmm相比,它不需要ground truth參數,并提供了更好的質量和更少的訓練時間。

對于大規模場景,由于VideoLifter中的分層設計,所提出方法始終在所有測試視圖中產生更清晰的細節,并保留每個片段中優化的精細細節。

對于CO3DV2數據集來說,在沒有任何COLMAP初始化的情況下實現全局一致的3D重建更具挑戰性。依靠單目深度預測來將圖像投影到點云中的基線通常會受到深度尺度不一致的影響,這使得它們很脆弱,容易失敗。相比之下,VideoLifter利用3D幾何先驗來實現穩健的配準,使其在具有挑戰性的環境中具有高度的適應性和彈性。

相關論文:VideoLifter: Lifting Videos to 3D with Fast Hierarchical Stereo Alignment

總的來說,VideoLifter這個框架可以有效地從單目視頻重建3D場景,不需要預先計算camera姿勢或預定義的特性。VideoLifter利用基于學習的立體先驗進行初始稀疏場景重建,并結合三維高斯飛濺的分層對齊方法來產生密集的,全局一致的模型。與之前最先進的方法相比,VideoLifter從隨機視頻中實現了高質量的重建,減少了計算需求。