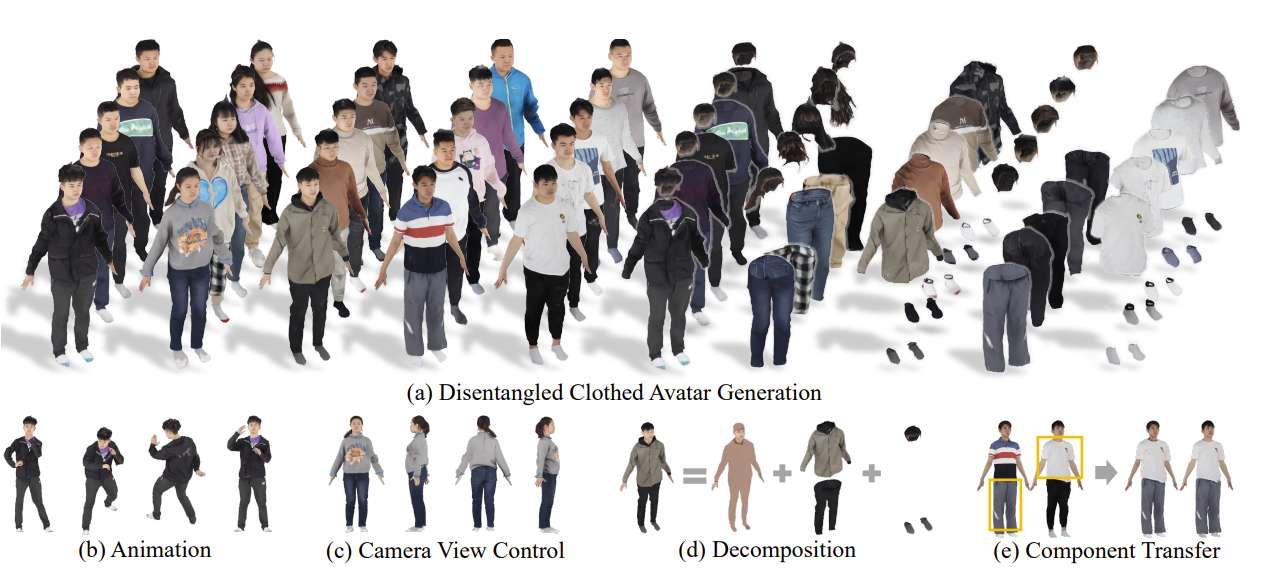

每個(gè)組件都不糾纏,而以前饋方式生成Avatar,每個(gè)Avatar只需要幾秒鐘

(中國AI網(wǎng) 2025年05月21日)穿衣Avatar在虛擬現(xiàn)實(shí)和增強(qiáng)現(xiàn)實(shí)等領(lǐng)域有著廣泛的應(yīng)用。然而,生成具有分離組件(例如身體,頭發(fā)和衣服)的Avatar一直是一個(gè)挑戰(zhàn)。在一項(xiàng)研究中,上海交通大學(xué)和香港大學(xué)團(tuán)隊(duì)提出了LayerAvatar。

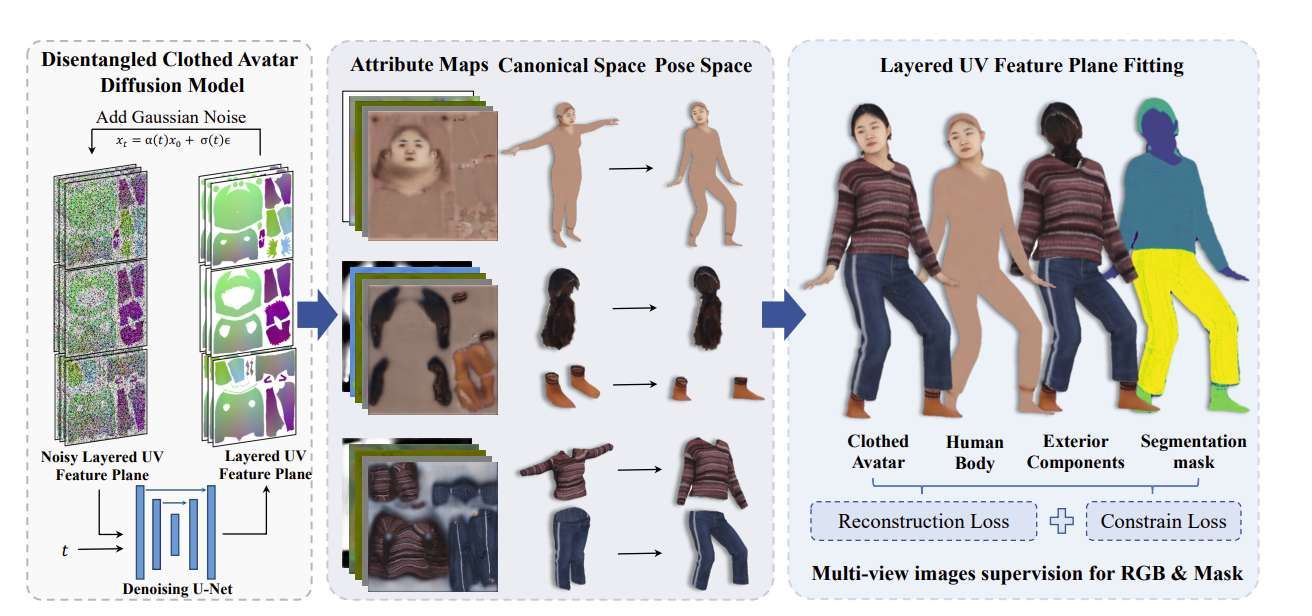

這個(gè)基于前饋擴(kuò)散的方法用于生成組件解糾纏的穿衣Avatar。為了實(shí)現(xiàn)這一點(diǎn),研究人員首先提出了一種分層UV特征平面表示,其中組件分布在基于高斯的UV特征平面的不同層中,并帶有相應(yīng)的語義標(biāo)簽。

這種表示支持高分辨率(1024)和實(shí)時(shí)渲染,以及包括可控手勢和面部表情在內(nèi)的富表現(xiàn)力動畫。以其作為基礎(chǔ),團(tuán)隊(duì)訓(xùn)練了一個(gè)單階段擴(kuò)散模型,并引入約束項(xiàng)來解決人體最內(nèi)層的嚴(yán)重遮擋問題。

大量的實(shí)驗(yàn)證明了所述方法在生成解糾纏的穿衣Avatar方面的性能,每個(gè)Avatar只需要幾秒鐘生成。

對于Avatar,傳統(tǒng)的基于圖形的管道需要3D美術(shù)付出大量的努力。為了減少繁瑣的手工勞動,方便批量生產(chǎn),基于學(xué)習(xí)的自動生成方法近年來得到了廣泛的探索。最近基于學(xué)習(xí)的方法主要將3D表示與生成管道和擴(kuò)散模型結(jié)合起來創(chuàng)建Avatar。

然而,相關(guān)方法往往忽略了Avatar的組成特性,將人體、頭發(fā)和衣服作為一個(gè)整體來表現(xiàn),從而限制了它們在Avatar定制(如布料轉(zhuǎn)移)方面的能力。

Neural-ABC和SMPLicit提供了解纏衣服和人體的參數(shù)化模型,但它們沒有對紋理進(jìn)行建模。HumanLiff提出了一種分層生成過程,首先生成穿著最少衣服的Avatar,然后生成穿著以當(dāng)前層為條件的下一層衣服的Avatar。然而,人體和衣服的特征并沒有完全解開,這使得很難提取每一層的組件,從而降低了編輯能力。

另外,其他方法遵循了DreamFusion的趨勢,通過對二維擴(kuò)散模型的先驗(yàn)知識進(jìn)行優(yōu)化,分別學(xué)習(xí)Avatar的各個(gè)組成,實(shí)現(xiàn)無糾纏的穿衣Avatar生成。相關(guān)方法可以生成穿著衣服的Avatar,每個(gè)組件都可以解開,但它們需要數(shù)小時(shí)來生成單個(gè)Avatar,并且訓(xùn)練時(shí)間將根據(jù)組件的數(shù)量線性增加。

針對以上問題,上海交通大學(xué)和香港大學(xué)團(tuán)隊(duì)提出了LayerAvatar。這種基于前饋擴(kuò)散的方法,可以生成高質(zhì)量的穿衣Avatar,每個(gè)組件都不糾纏,可以轉(zhuǎn)移衣服、頭發(fā)和鞋子。以前饋方式生成Avatar,每個(gè)Avatar只需要幾秒鐘。

為了實(shí)現(xiàn)這一點(diǎn),團(tuán)隊(duì)選擇3D高斯作為底層表示,因?yàn)樗哂懈叻直媛屎蛯?shí)時(shí)渲染的效率,強(qiáng)大的表示能力,以及便于編輯和動畫功能的顯式屬性。然而,由于其非結(jié)構(gòu)化的性質(zhì),與大多數(shù)當(dāng)前的前饋生成管道不兼容,并且難以解除每個(gè)組件的糾纏,所以使用3D高斯函數(shù)表示解糾纏的穿衣Avatar不切實(shí)際。

所以,研究人員引入了一種基于高斯的UV特征平面,將3D高斯特征投影到一個(gè)預(yù)定義的二維UV空間中,每個(gè)3D高斯特征的屬性編碼為局部幾何和紋理latent特征,其通過雙線性插值從二維特征平面中獲得。

為了實(shí)現(xiàn)Avatar組件(例如頭發(fā),鞋子等)的完全解糾纏,基于SMPL-X UV模板在UV特征平面的不同層中表示Avatar組件。考慮到分層表示,可以將生成的Avatar動畫為新穎的姿態(tài),包括面部表情的可控性,并通過從SMPL-X模型中提取混合形狀和蒙皮權(quán)重的先驗(yàn)知識,將每個(gè)組件轉(zhuǎn)換為各種身體形狀。

為了以前饋方式生成分層表示,從多視圖2D圖像中訓(xùn)練了單階段擴(kuò)散模型。為了完全解開每個(gè)組件并確保可信的生成結(jié)果,在單個(gè)組件和整個(gè)組合穿衣Avatar中都使用了監(jiān)督。另外,利用若干先驗(yàn)損失來約束嚴(yán)重遮擋人體的光滑表面和合理的顏色。

研究人員在多個(gè)數(shù)據(jù)集對LayerAvatar進(jìn)行了評估,證明了它在生成無糾纏穿衣Avatar方面的優(yōu)越性能。生成的Avatar支持高分辨率(1024)和實(shí)時(shí)渲染,以及表情姿態(tài)控制。

相關(guān)論文:Disentangled Clothed Avatar Generation with Layered Representatio

總的來說,LayerAvatar是一個(gè)基于前饋擴(kuò)散的方法,并用于生成組件解糾纏的穿衣Avatar。團(tuán)隊(duì)首先提出了一種分層的UV特征平面表示方法,并用相應(yīng)的語義標(biāo)簽表示不同層中Avatar的每個(gè)組成。

然后,訓(xùn)練一個(gè)單階段擴(kuò)散模型來生成每個(gè)特征平面,以獲得每個(gè)組件解糾纏的穿衣Avatar。他們精心設(shè)計(jì)了語義感知的組合渲染和約束條件,以完全解除每個(gè)組件的糾纏。大量的實(shí)驗(yàn)證明了LayerAvatar在完全解纏穿衣Avatar生成和組件轉(zhuǎn)移方面的優(yōu)越性。