僅使用單視圖輸入即可實現一致的沉浸式場景重建

(中國AI網 2025年07月11日)對增強現實和虛擬現實應用日益增長的需求凸顯了從簡單的單視圖圖像制作沉浸式3D場景的重要性。然而,由于單視圖輸入提供的部分先驗,現有的方法往往局限于從單視圖輸入重建低一致性的窄視場3D場景。相關限制使它們無法泛化重建沉浸式場景。

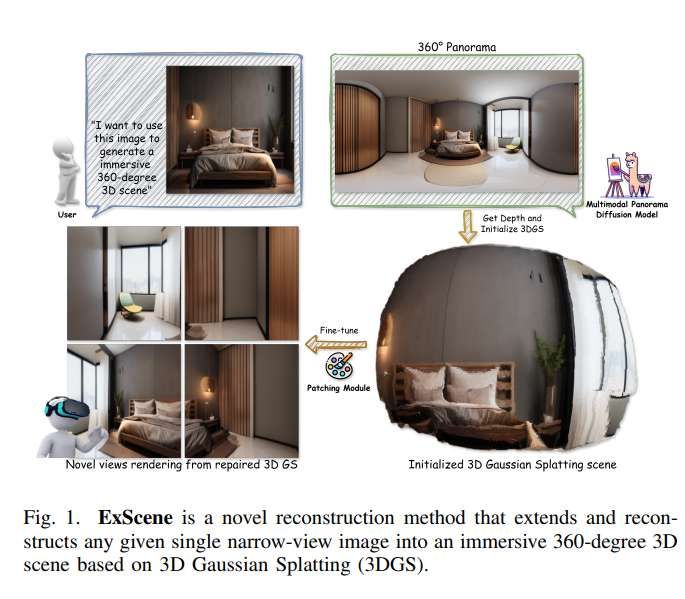

為了解決這個問題,香港中文大學(深圳)未來智聯網絡研究院和香港中文大學(深圳)團隊提出了ExScene。這是一個兩階段的管道,可以從任何給定的單視圖圖像重建沉浸式3D場景。ExScene設計了一種新的多模態擴散模型來生成高保真度和全局一致的全景圖像。

然后,研究人員開發了一種全景深度估計方法,從全景中計算幾何信息,并將幾何信息與高保真全景圖像結合起來訓練初始三維高斯飛濺模型。以其作為基礎,團隊引入了一種具有二維穩定視頻擴散先驗的GS精細技術。他們在擴散去噪過程中加入camera軌跡一致性和顏色幾何先驗,以提高圖像序列間的顏色和空間一致性,然后用于微調初始3DGS模型,從而獲得更好的重建質量。

實驗結果表明,ExScene僅使用單視圖輸入即可實現一致的沉浸式場景重建,大大超過了最先進的基線。

單視圖3D重建技術對于增強現實/虛擬現實領域至關重要。但有限的場景先驗、重建中的場景一致性差、偽影和空心區域等挑戰極大地限制了它們在現實場景中的適用性。盡管神經輻射場NeRF和3DGS具有先進的新穎視圖合成和3D場景構建,但它們依賴于在受控軌跡中拍攝的大量連續圖像,而這對于現實世界的應用來說是不切實際的要求。

盡管最近擴散模型和自回歸模型的突破使單視圖重建取得了顯著進展,但大多數現有方法主要局限于正面場景,并且僅限于實現小角度旋轉或小視點外推。由于迭代過程中的錯誤、引入幾何扭曲、不一致的顏色和偽影,它們無法生成沉浸式的360度重建。

簡而言之,從單一視圖生成沉浸式高保真3D重建依然是一個重大的未解決挑戰。針對這個問題,香港中文大學(深圳)未來智聯網絡研究院和香港中文大學(深圳)團隊引入了ExScene。如圖1所示,所提出方法創新地融合了多模態全景圖像生成技術和3DGS場景細化方法,在三維重建中實現了高保真的顏色表示和幾何一致性。

首先,他們設計了一個具有全景先驗的多模態擴散模型來解決全景圖像生成中的語義不一致問題。這種特殊的模型將文本和圖像特征融合到去噪過程中,以生成語義一致的高保真全景圖。隨后,提出了一種改進的全景深度估計方法,以克服現有全景深度估計方法中的投影失真。最后,使用精確的幾何信息和高保真全景圖像來訓練初始3DGS模型。

在第二階段,引入一個特殊的高斯補丁模塊來解決初始3D模型中的視點遮擋偽影。補丁模塊由一個特定的穩定視頻擴散(SVD)模型驅動,而它融合了多視圖維度感知能力和顏色幾何先驗。這確保了生成的2D圖像序列的3D視圖一致性,提高了3DGS模型的質量。

在不同的單視圖數據集的實驗表明,ExScene在定性和定量上都超過了最先進的方法。消融研究證實了多模態全景圖像生成模塊和高斯補丁模塊在生成高保真全景圖像和重建高質量和一致的3D場景方面的有效性。

值得一提的是,對于數據集,由于沒有公開可用于沉浸式3D場景單視圖重建的統一圖像數據集。所以,團隊使用基線方法和Stable Diffusion V2.1生成的62張單視圖圖像作為ExScene等方法的測試圖像,涵蓋各種室內和室外,真實和模擬場景。

然后,研究人員用4塊Nvidia 3090 GPU進行了實驗。對于單視圖輸入,使用LLaVA生成圖像描述。將圖像和描述合并到擴散模型的去噪過程中,生成全景圖像。他們在一個新的視圖合成數據集訓練奇異值分解模型來學習軌跡先驗。

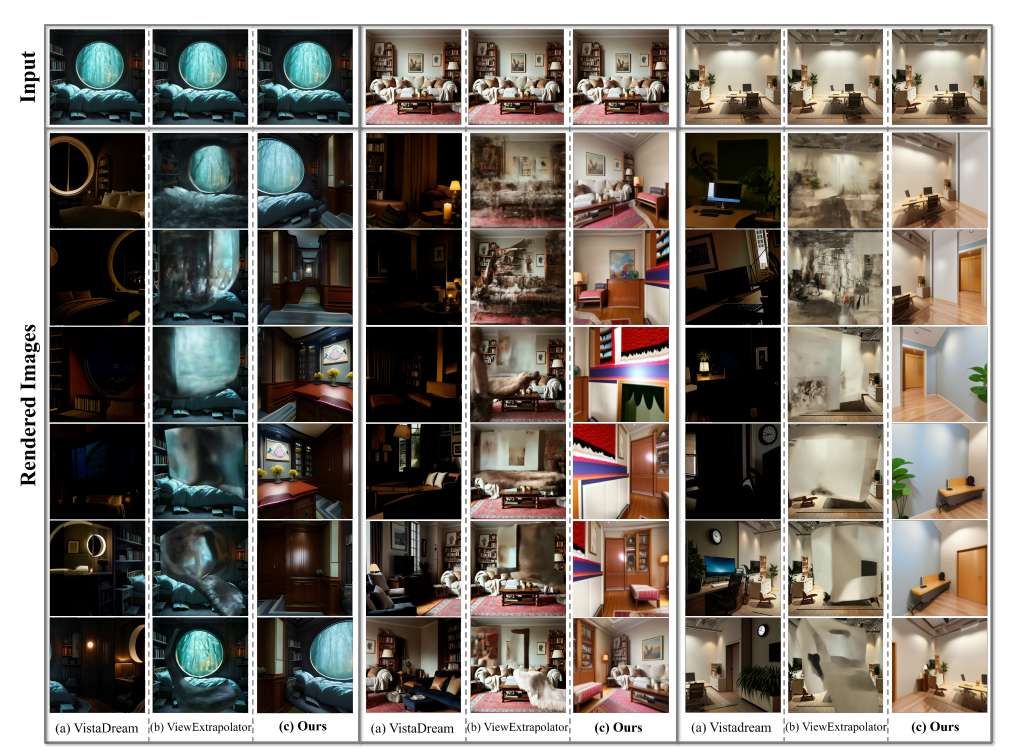

接下來,他們將所提出方法與2種SOTA基線方法進行比較:ViewExtrapolator和VistaDream。ViewExtrapolator利用重新設計的SVD去噪過程和生成先驗進行圖像序列偽影修復。VistaDream使用擴散模型來細化3D支架,并通過多視圖采樣來提高視圖一致性。

圖3展示了所提出方法與在單視圖圖像數據集上評估的基線方法的定性結果。由于錯誤積累,VistaDream呈現顏色和樣式不一致,如圖3 (a)列所示。在圖3 (b)列中,ViewExtrapolator的SVD模塊中缺少camera軌跡先驗導致合成的新視圖失去3D一致性,導致渲染圖像失真和偽影。

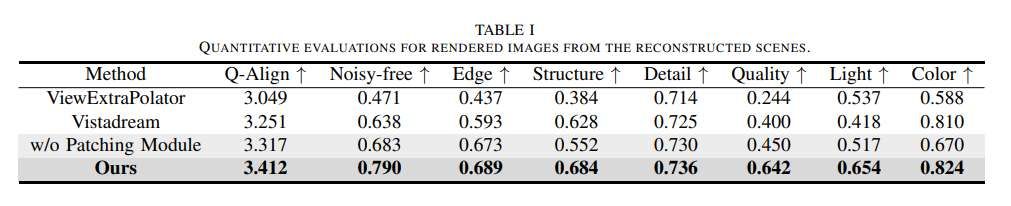

表1中的定量結果和圖3中的定性示例都表明,所提出的ExScene使用多模態全景擴散模型,在擴展場景表示方面明顯優于現有方法。這種增強為初始化和微調后續3D高斯模型提供了全景幾何和顏色先驗,確保了高質量的3D場景重建。另外,模型保證了場景優化過程中多視圖的一致性,同時提高了整體重建質量。這最終導致準確和逼真的場景重建。

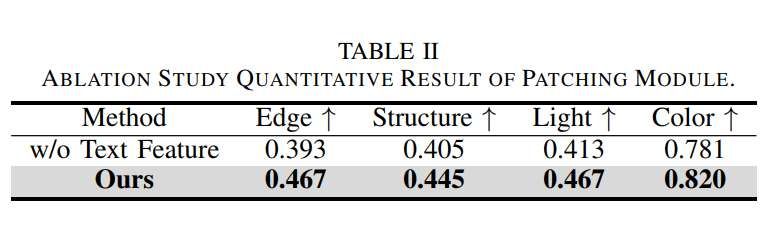

如表2所示,使用一致性指標評估生成的圖像。在沒有語義引導的情況下生成的圖像顯示出鋸齒狀的邊緣和不一致的光線和顏色,突出了語義編碼的有效性。另外,高斯補丁模塊對于修復孔洞和消除偽影至關重要,這對最終質量有重大影響。當模塊移除時,如表1所示(w/o patchching module),高斯模型在失去第二階段的微調過程后,質量顯著下降。相比之下,補丁補模塊有效地消除了扭曲,增強了場景的真實感和質量。

相關論文:ExScene: Free-View 3D Scene Reconstruction with Gaussian Splatting from a Single Image

https://arxiv.org/pdf/2503.23881

總的來說,ExScene這個兩階段框架可用于從單視圖圖像生成沉浸式360度3D場景。在第一階段,使用具有全景先驗的多模態擴散模型來生成高質量的全景圖像,并使用全景深度估計模塊來預測深度信息。然后將組合起來訓練一個初始的三維高斯模型。

在第二階段,使用一種維度感知的穩定視頻擴散方法來修復從初始3D場景渲染的視頻,產生高質量和一致的多視圖圖像。然后使用圖像來改進初始模型以獲得逼真的視覺效果。大量的實驗結果表明,ExScene在沉浸式360度場景的單視圖生成方面超越了最先進的性能。