憑借其在4D與視頻生成方面的能力,Video4DGen為虛擬現實等領域提供了一個功能強大的創作工具

(中國AI網 2025年07月17日)隨著4D(即時序三維)生成技術的發展,人們在各類應用中得以實現更加真實的沉浸式體驗,用戶可以從任意視角探索動態對象或角色。同時,視頻生成模型因其生成真實且富有想象力的畫面能力而受到高度關注,這類模型同時展現出良好的三維一致性,具備充當“世界模擬器”的潛力。

在一項研究中,清華大學,生數科技,同濟大學和香港科技大學團隊提出了Video4DGen,這個全新框架能夠從單個或多個生成視頻中構建4D表示,同時可以用于生成受4D內容引導的視頻。所述框架對于創建在時空維度均保持高度一致性的高保真虛擬內容具有關鍵意義。

Video4DGen生成的4D輸出采用研究人員提出的動態高斯面元(Dynamic Gaussian Surfels, DGS) 表示形式。通過優化時變形變函數,DGS將靜態狀態下的高斯面元轉換為動態變形狀態。團隊設計了針對變形狀態的幾何正則化與外觀細節優化機制,以保持結構完整性和高質量紋理表現。

為實現多視頻驅動的4D生成,并捕獲跨空間、時間與姿態維度的一致表示,他們進一步提出了多視頻對齊機制、根姿態優化策略以及基于姿態的幀采樣方法。通過連續形變場的引入,系統可對每個視頻中的姿態、運動與形變實現精細表達。 同時,為了提升從各視角觀察下的整體真實感,Video4DGen支持基于4D內容的新視角視頻生成,并引入 置信度過濾的DGS(confidence-filtered DGS) 機制來提升合成序列的質量。

研究人員表示,憑借其在4D與視頻生成方面的能力,Video4DGen為虛擬現實等領域提供了一個功能強大的創作工具。

市場對引人入勝的交互式數字環境的需求日益增長,這提高了生成逼真的、動態的多模態內容的重要性,例如4D和視頻。這種動態的多模態生成過程通常不僅涉及捕獲空間和視覺細節,同時涉及捕捉運動的時間動態,這對于確保對象或場景在多個幀和視點之間流暢和一致地移動至關重要。

最近,視頻生成模型因其卓越的制作身臨其境和栩栩如生的框架的能力而引起了人們的注意。模型產生視覺上令人驚嘆的內容,同時表現出強大的3D一致性,在很大程度上增加了它們模擬現實環境的潛力。與發展相平行的是,4D重建在多個方面取得了長足的進步,這涉及捕獲和渲染詳細的時空信息。當與生成視頻技術集成時,這項技術有可能創建捕獲靜態場景和動態序列的模型。這種合成提供了逼真的整體表現,對虛擬現實等應用至關重要。

盡管取得了進步,但基于視頻生成模型實現高保真的4D重建依然面臨著巨大的挑戰。其中一個主要問題是生成的視頻中經常出現的非剛性和幀失真,這會破壞生成的4D內容的時間一致性和空間一致性。應用現有4D方法生成的視頻通常難以保持跨幀和視點的平滑過渡,導致失真和偽影,如閃爍和失準。

另外,從新穎視點生成可信的4D內容,特別是對于原始輸入中未捕獲的區域依然是一個未解決的挑戰。同時,大多數生成的視頻缺乏明確的camera姿態信息,而現有的最先進4D方法需要準確的camera姿態來正確對齊時空結構。

為了應對上述挑戰,清華大學,生數科技,同濟大學和香港科技大學團隊提出了Video4DGen,這是一個多模態動態生成框架,用于聯合執行4D生成和4D引導視頻生成。

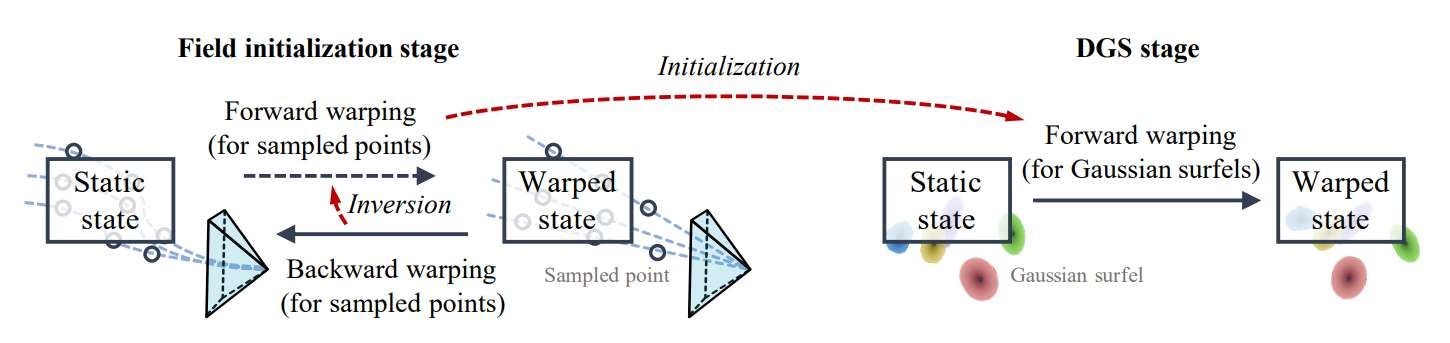

Video4DGen優化了各種姿態和運動尺寸的外觀和幾何形狀,確保了整個生成過程中空間和時間的一致性。框架引入了一種新的四維表示——動態高斯面元(Dynamic Gaussian Surfels, DGS),并通過特殊設計的場初始化來增強。它具有兩個關鍵階段:從單個或多個生成視頻生成4D和由4D表示引導的新視圖視頻生成。

具體而言,所提出的DGS優化了非剛性翹曲函數,將高斯面元從靜態狀態轉換為動態翹曲狀態。這種動態轉換準確地表示隨著時間推移的運動和變形。另外,DGS在另外兩個關鍵方面表現出優越的4D表示性能。

首先,在幾何方面,DGS遵循高斯面元原理,以實現精確的幾何表示。與現有的方法不同,DGS結合了翹曲狀態法線一致性正則化,使面元與具有可學習的連續場的實際表面對齊,以確保在估計法線時平滑翹曲。

其次,對于外觀,DGS通過雙分支結構對高斯曲面的旋轉和縮放參數進行了額外的細化。這種細化減少了翹曲期間閃爍的偽影,并允許精確渲染外觀細節,從而產生高質量的4D表示。

為了克服這一挑戰,團隊將場初始化作為管道中的一個關鍵組件引入。為了建立DGS的連續翹曲場,他們設計了場初始化,保證快速穩定的收斂。通過這個初始化,Video4DGen能夠從單個生成的視頻中實現高保真4D生成。在將單視頻生成擴展到多視頻生成的過程中,團隊設計了靜態共享、連續根姿態優化和姿態引導幀采樣等關鍵機制。

靜態共享通過為靜態狀態保留一組一致的DGS來保持主題結構和外觀的一致性。根姿態優化將主體的全局轉換與靜態狀態跨幀對齊,糾正不匹配并確保平滑過渡。Video4DGen利用神經連續場進行局部和全局姿態調整。另外,姿態引導的幀采樣增強了姿態多樣性,同時避免了訓練過程中特定姿態的過擬合。多視頻生成可以提高全視域4D生成的質量。

Video4DGen同時引入了一種新的4D引導視頻生成方法,通過整合運動和視點的不同組合來增強視頻生成過程。它采用了兩個關鍵策略。首先,經過置信度過濾的DGS機制使用法向對齊來評估像素的可靠性,并且只在輸出中包含高置信度區域。其次,新視點視頻生成對高置信度區域進行逐級去噪細化,對低置信度區域進行變換,保證平滑過渡。

總之,所述策略提高了生成視頻的整體清晰度和連貫性。視頻生成器具有新穎的功能,如“多攝像頭”視頻生成,其中從任何視點同時捕獲相同的運動序列和具有大姿態變化的視頻生成。4D引導視頻生成反過來又增強了4D生成。

基于生成視頻的大量實驗驗證了所提出方法的有效性。團隊同時提供了對象級基準和現實場景級基準的定量和定性比較。結果表明,框架在視覺質量和幾何細節方面都具有優越的性能。

相關論文:Video4DGen: Enhancing Video and 4D Generation through Mutual Optimization

https://arxiv.org/pdf/2504.04153

Video4DGen這個全新框架共同解決了兩個相互關聯的任務:從生成視頻生成4D,4D引導視頻生成。團隊同時提出動態高斯面元(DGS)作為Video4DGen中的4D表示,以在翹曲期間保持高保真的外觀和幾何形狀。實驗驗證了Video4DGen在定量指標和定性評估方面都優于現有方法,突出了其在生成逼真沉浸式4D內容和4D引導視頻內容方面的優勢。

當然,盡管使用DGS的Video4DGen在4D生成中表現出了顯著的性能,但目前依然存在對視頻質量依賴、大場景可擴展性挑戰、以及實時應用中的計算困難等局限性。另外,當為Video4DGen配備生成模型時,就像使用任何生成技術一樣,會存在生成欺騙性內容的風險,所以需要更加謹慎。