高保真3D服裝重建

(中國AI網 2025年07月25日)從圖像中重建3D穿衣人是XR等應用的基礎。盡管最近的進步提高了人體的恢復能力,但準確地重建服裝的幾何形狀——尤其是寬松的服裝——依然是一個懸而未決的挑戰。

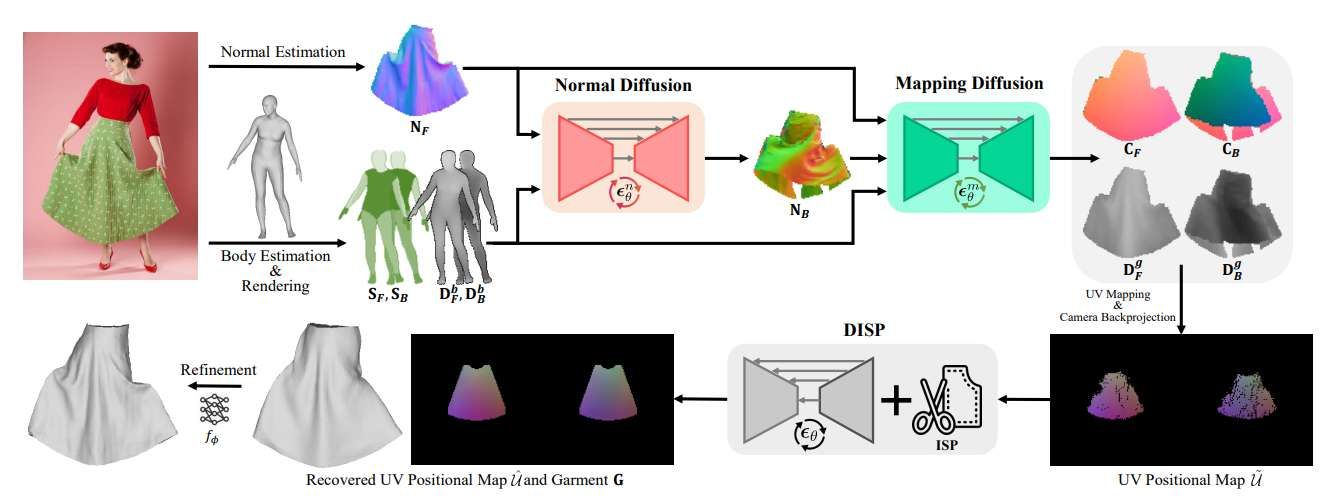

在一項研究中,瑞士洛桑聯邦理工學院和阿聯酋人工智能大學團隊提出了一種從單張圖像進行高保真3D服裝重建的新方法,并在2D和3D表示之間架起了橋梁。所述方案將Implicit Sewing Patterns(ISP) 與生成擴散模型 相結合,在2D UV空間中學習豐富的服裝形狀先驗知識。一個關鍵創新是映射模型,它可以建立2D圖像像素、UV圖案坐標和3D幾何形狀之間的對應關系,通過將學習到的先驗知識與圖像觀察對齊,實現了對3D服裝網格和相應2D圖案的聯合優化。

盡管僅在合成模擬的布料數據進行訓練,但所述方法能有效泛化到真實世界圖像,在緊身和寬松服裝的重建都優于現有方法。重建出的服裝在保持物理合理性的同時,捕獲了精細的幾何細節,可支持包括服裝重定向 和紋理操控 在內的下游應用。

僅從圖像中恢復人體的姿勢和形狀,以及服裝形狀,這存在一系列的應用。包括虛擬試穿、創建3D化身、遠程呈現和沉浸式VR/AR等。近年來,業界在身體姿勢方面取得了巨大進步。然而,準確地模擬服裝依然是一個挑戰。

目前的大多數研究都依賴于一個單一的3D模型來共同代表身體和衣服。盡管這可以產生視覺上令人印象深刻的重建結果,但融合人類和衣服的表現使得不可能進行逼真的布料模擬或虛擬試穿。所以,需要獨立的身體和服裝模型。

服裝復雜的結構使這種建模變得困難。由于服裝是具有近乎無限自由度的薄表面,它們會受到動態因素的復雜變形。服裝的大多數設計風格和形狀變化引入了進一步的復雜性,使建模過程更具挑戰性,獲得真正的3D數據更加困難。反過來,這阻礙了基于學習的服裝重建方法的部署。

為了應對這些挑戰,有人依靠預先設計的網格模板來定義服裝幾何形狀,并使用底層身體模型的線性混合蒙皮(LBS)來捕獲身體運動引起的變形。然而,這需要衣服的網格模板,限制了建模的靈活性和通用性。另外,盡管對緊身衣服非常有效,但它很難準確地模擬寬松的衣服,因為寬松的衣服經常離身體很遠。

在另一方面,有人通過從所謂的ISP模解決這個問題。相關模型以一組單獨的2D面板和與面板相關的3D表面來表示服裝,然后將變形模型應用于3D表面,以便它們可以從身體形狀上大大偏離。變形取決于從目標服裝的輸入圖像估計的法線。這一方法是有效的,但往往會使結果過于平滑。這在一定程度上是因為不同的3D形狀會產生非常相似的圖像,使得正確訓練網絡來預測高保真的表面細節和單一圖像的復雜變形變得困難。另外,服裝的某些部分被系統地遮擋在穿衣人的圖像中。

為了克服所述限制,瑞士洛桑聯邦理工學院和阿聯酋人工智能大學團隊引入了三種擴散方案:學習捕獲復雜服裝形狀的形狀先驗;補充服裝遮擋部分的圖像信息;將2D圖像映射到3D和UV空間,以便通過將它們擬合到形狀先驗來恢復可信的3D形狀。

圖2描述了結果處理管道,而所述方法可以恢復各種服裝的真實3D模型。與現有方法相比,團隊的解決方案可以恢復更多的細節,并獲得更高的重建精度。另外,重建的網格很容易用于下游應用,如服裝重定位和紋理編輯。

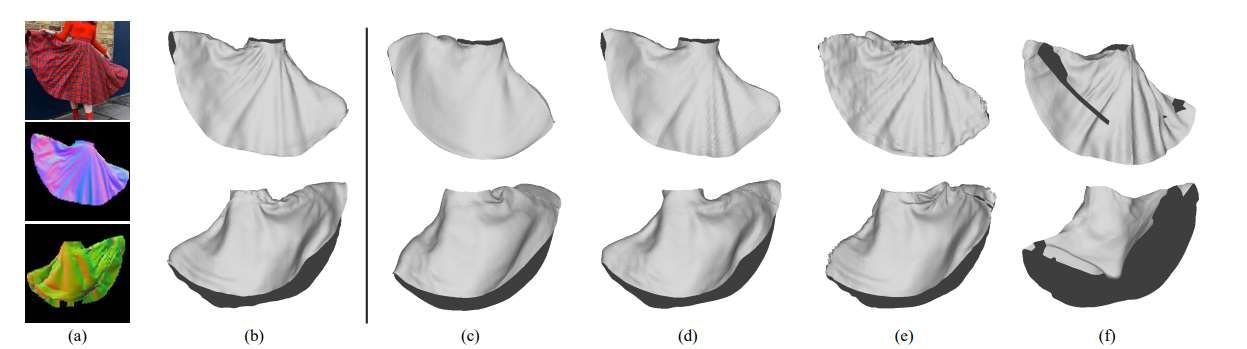

圖7為擬合方法的燒蝕研究。如圖7(c)所示,初始重構沒有經過后細化步驟,無法與圖7(a)所示的輸入圖像完全對齊。引入神經位移場來優化初始網格可以提高重建精度,如圖7(d)所示。通過直接優化頂點位置的進一步細化可以增強皺紋細節,如圖7(b)所示。

然而,在沒有首先優化神經位移場(圖7(e))的情況下應用后細化很難恢復準確的形狀,因為每個頂點都是獨立優化,導致次優結果。最后,圖7(f)顯示了在整個擬合過程中只使用前正態估計的結果。背部表面缺乏約束導致背部不現實的變形。

由于所提出方法為服裝和底層身體生成單獨的模型,所以可以輕松地將其放置在新身體。圖8展示了將重建的襯衫和褲子轉移到不同姿勢和形狀的身體上的重定向結果。由于團隊對服裝的3D模型和相應的2D面板都進行了重建,所以可以很容易地實現紋理編輯。如圖9所示,通過在復原面板繪制圖案或繪制特定的圖形,網格將在相應位置顯示紋理。

相關論文:Single View Garment Reconstruction Using Diffusion Mapping Via Pattern Coordinates

https://arxiv.org/pdf/2504.08353

總的來說,團隊提出了一種從單張圖像中恢復逼真的3D服裝網格的新方法。所提出方案利用ISP和生成擴散模型來學習在2D UV空間中定義的合理服裝形狀先驗。通過利用擴散方案,所述方案補充了服裝遮擋部分的2D觀察,并將其提升到3D空間。另外,研究人員設計了一個基于擴散的映射,跨越2D, 3D和UV空間,使學習先驗與圖像觀測對齊,以產生準確的3D服裝重建。

所提出方法在不同類型的服裝上優于現有的方法,并且所得到的重建很容易適用于下游任務,例如服裝重新定位和紋理編輯。

盡管能夠為各種各樣的服裝產生逼真的3D重建,但所提出方案有一定的局限性。如圖10第四行中間的例子所示,它很難捕獲到非常小的皺紋。這種限制的出現是因為法向損失依賴于一個使用插值和近似進行法向和梯度計算的可微分渲染器。相關近似傾向于平滑高頻幾何細節。

另外,由于小皺紋對整體損失的貢獻很小,所以在優化過程中,它們的梯度可能會被淹沒。總之,所述因素解釋了觀察到的結果。同時,所提出方法目前尚不能處理多層結構的服裝,比如褶邊分層裙。一個潛在的解決方案可能包括在ISP中加入額外的面板以支持分層設計。

所提出方法需要穿衣人的全身圖像,因此不能處理部分服裝或側面視圖的圖像。由于單幅圖像的3D重建固有的性質,所提出方法不能解決深度模糊問題,不能完全捕獲服裝的物理行為。視頻輸入的結果看起來不太穩定。在未來的工作中,我們的目標是通過使用視頻序列建模服裝隨時間的變形來解決這個問題。