在跨對象泛化能力和逼真度方面,所提出方法顯著優于先前的研究。

(中國AI網 2025年07月24日)僅靠少數數個RGB攝像頭就能制造出高質量、逼真的人體化身,這是一個具有挑戰性的問題,并且隨著虛擬現實技術的興起變得越來越重要。為了幫助這種技術實現普及,一種富有前景的解決方案可能是一種可泛化方法,即獲取目標人物的稀疏多視圖圖像,然后生成真實自由視圖渲染圖。

然而,目前的技術水平尚不能擴展到非常大的數據集,所以缺乏多樣性和真實感。為了解決這個問題,馬克斯·普朗克信息學研究所,馬普所薩爾布呂肯視覺計算研究中心,以及谷歌團隊提出了一種全新的、可泛化的全身模型,以稀疏多視角視頻作為驅動信號,它可以在自由視點下渲染逼真人體。模型在維持高逼真度的同時,可以將訓練擴展到數千個研究對象。

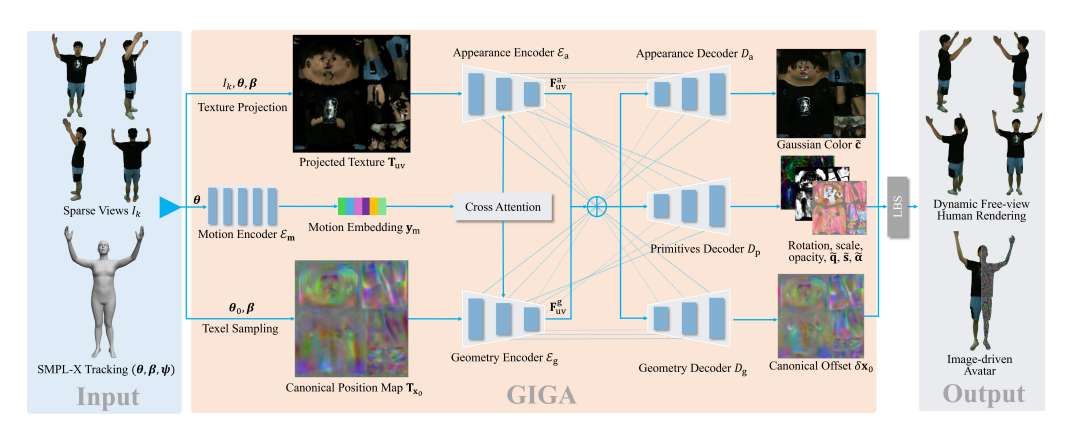

就其核心,研究人員引入了一個MultiHeadUNet架構,它以紋理空間中的稀疏多視圖圖像作為輸入,并預測在人體網格表示為二維紋理的高斯基元。重要的是,在2D中表示稀疏視圖圖像信息,身體形狀和高斯參數,以便可以完全基于2D卷積和注意力機制設計一個深度和可擴展的架構。在測試時,僅需四路輸入視圖以及一個針對目標身份的跟蹤身體模板,即可合成出基于高斯分布的關節式3D Avatar。在跨對象泛化能力和逼真度方面,所提出方法顯著優于先前的研究。

僅靠少數數個RGB攝像頭就能制造出高質量、逼真的人體化身有可能徹底改變虛擬現實等領域。然而,迄今為止的建模挑戰依然未得到解決:在傳感器稀缺和輸入數據有限的情況下實現真實感和保真度;對新穎身份的真正泛化。

在一項研究中,馬克斯·普朗克信息學研究所,馬普所薩爾布呂肯視覺計算研究中心,以及谷歌團隊提嘗試通過利用最近的大規模數據捕獲工作來共同解決相關問題。值得注意的是,這需要一種可泛化的方法,以簡單的前饋方式在測試時合成數字人,而這是本次研究的主題。

最近的相關研究集中在個人特定的化身,即在密集的圓頂狀攝像頭設置上訓練每個主題的學習表示。相關表示可能涉及網格,神經輻射場,點或體積基元,如3DGS。實現這種技術的大眾化十分困難,因為為了獲得高質量的結果,在推理時間驅動角色之前需要密集的攝像頭穹頂。

有的方法旨在利用更簡單的捕獲設置,例如單眼圖像或視頻。但由于輸入少得多,它們的視覺質量往往低于多視圖方法。單圖像到3D重建方法主要側重于足夠的幾何重建,并產生僅由骨骼運動驅動的3D asset,其通常缺乏骨骼運動相關的幾何和外觀變化。所以,為輕量級人體重建和渲染設計一個高質量的方法依然是一個懸而未決的問題:模型必須準確地表示不同的人體外觀、身體類型和服裝配置,并且必須從稀缺的輸入信號中正確地導出與姿態相關的外觀變化。

盡管以前的研究已經在身份泛化方面邁出了有希望的第一步,但它們是在小規模數據集進行訓練和評估,訓練對象非常少。另外,它們的質量和效率受到隱式神經表示和不可擴展網絡架構的限制。

最近,大規模數據集為真正可泛化的人類化身方法鋪平了道路。然而,大規模訓練和評價模型需要特別的考慮。首先,可泛化模型必須學習有意義的特征表示,以擴展到訓練集和訓練集之外。其次,模型架構必須具有計算和內存效率,以捕獲精細細節并實現大規模訓練。第三,這種方法的核心是,3D表示必須在最短的渲染時間內產生高質量的重建,以在訓練期間保持快速的反向傳播,并確保在測試時的快速性能。

為了解決所述挑戰,研究人員提出了GIGA。這種前饋方法用于從稀疏輸入視圖和推理時的跟蹤身體模板合成個性化的虛擬化身。值得注意的是,對于新對象,GIGA不需要對密集的圓頂數據進行個性化培訓。就其核心而言,它將稀疏視圖圖像信息投影到SMPL-X模型的UV空間中,而GIGA預測的數字人表示為一個文本對齊的高斯化身,將任務簡化為2D到2D的圖像轉換。

團隊提出了一個MultiHeadUNet,一個具有多個編碼和解碼頭的UNet,它采用包含投影圖像信息以及形狀和運動代碼的紋理,并回歸每個紋理的高斯外觀和幾何參數。然后,利用交叉注意向模型中注入運動信息,并通過跳skip-connection在不同空間尺度傳播學習信號。架構設計選擇確保從訓練數據中可靠地學習固有特征統計,同時保持模型輸入中包含的個人特定信息。可以使用各自的SMPL-X身體姿勢將預測的高斯參數放置到3D空間中,這允許在訓練期間渲染可與ground truth情況進行比較的2D圖像。

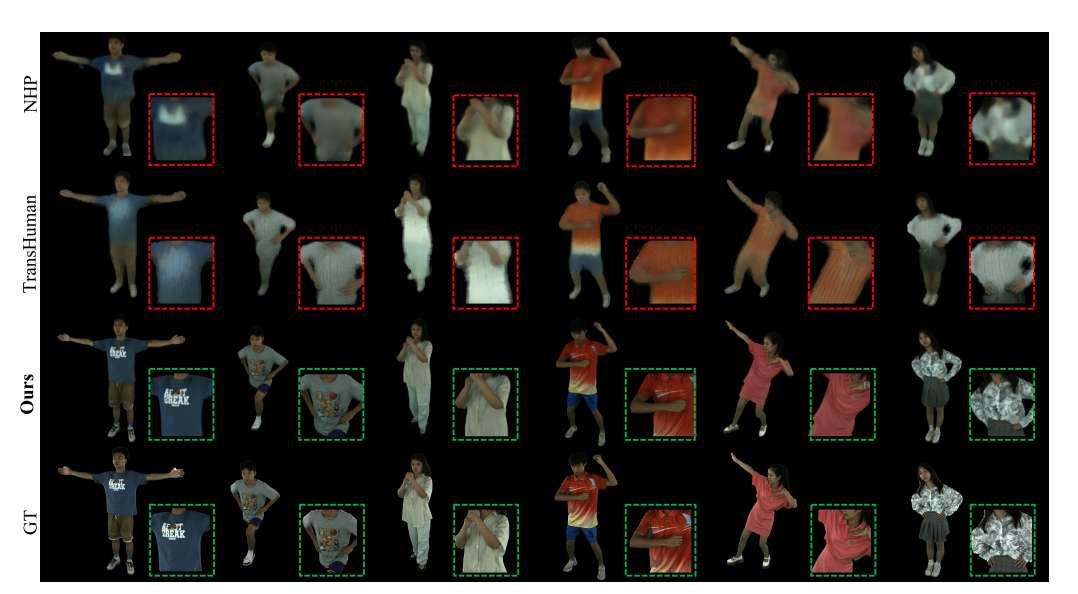

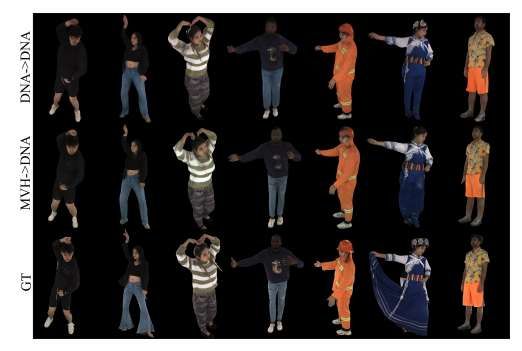

圖3、4和6展示了GIGA對目標對象執行新姿勢的新視圖渲染結果。值得注意的是,GIGA實現了逼真和視圖一致的渲染,并有效地捕獲了服裝褶皺和復雜紋理等精細細節。對于新主題,GIGA實現了與訓練主題相當的渲染質量,證明了其對新身份的泛化能力。

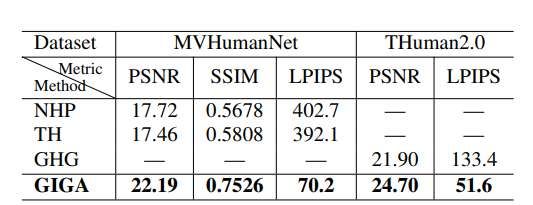

另外,團隊將GIGA與其他通用動態圖像驅動方法進行比較:NHP和TransHuman (TH)。團隊從比較中排除了NNA,這是因為無法從作者提供的代碼中復制訓練結果。研究人員使用MVHumanNet的相同訓練/驗證分割來訓練NHP和TH,并遵循與所提出方法相同的訓練設置。

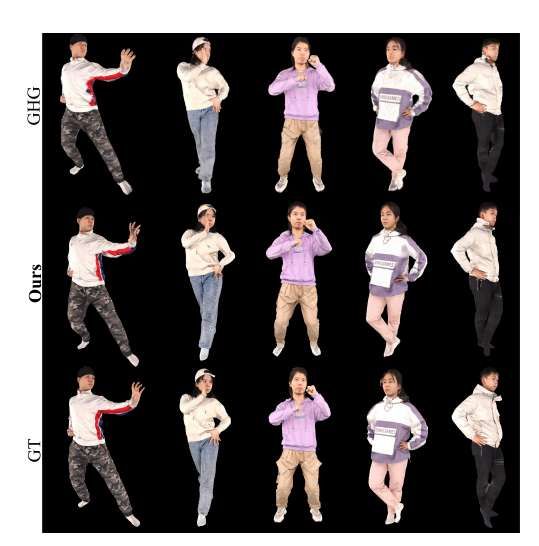

他們同時采用GHG作為基線,并在THuman2.0數據集訓練GIGA。表1提供了GIGA與最先進的通用人類渲染基線的定量比較。圖3提供了定性結果的概述。

NHP依賴于稀疏的3D卷積來處理觀察到的姿態空間中的體積特征,因此,由于遮擋而丟失輸入信號,并且無法泛化到前所未見的身份。盡管在規范模板姿態空間中操作,并對模板進行標記,以便使用基于transformer的網絡進行處理,但TransHuman無法從大型數據收集中學習有意義的先驗。NHP和TransHuman都非常慢,因為它們的核心是隱式表示,這極大地限制了它們的泛化能力。

另一方面,GIGA最大程度地利用了共享文本空間的力量:數字人的所有特征表示都在同一文本空間中定義,中間特征通過skip-connection增強最終預測的質量。MultiHeadUNet的計算效率顯著提高,這就解釋了在定性和定量方面的改進。

當然,盡管比以前的研究效率高得多,但GHG只針對稀疏輸入視圖的靜態重建。GHG同時將人類建模為觀察到的姿勢空間中的一組3D高斯支架,并且不容易擴展到動態場景。GHG通過預訓練一個單獨的紋理網絡來處理高斯顏色預測。

GIGA學會同時使用外觀和幾何特征進行操作,從而在視覺(圖4)和定量上(表1)獲得更高質量的結果。為了演示跨數據集泛化,團隊訓練了GIGA的兩個變體,其中一個變體在DNA-Rendering數據集訓練和測試,而另一個變體在MVHumanNet訓練并在DNA-Rendering測試。表4和圖6表明,所提出方法具有跨數據集的泛化能力,因為在大規模MVHumanNet數據訓練的模型在DNA-Rendering具有可比性,這清楚地表明所提出方法有效地從大型數據集中學習了先驗。

為了對GIGA核心的MultiHeadUNet(IV)進行基準測試,團隊提出了3種具有近似相同可訓練參數數量(?90M)的替代架構:一個簡單的編碼器-解碼器模型,一個在編碼器和解碼器對應的上下采樣塊之間具有skip-connection的傳統UNet (II),以及一個具有2個編碼器Ea, Eg和3個解碼器Da, Dp, Dg但沒有skip-connection的模型(III)。定量地(表2)和定性地(圖5)觀察到,從輸入信號中可以看出,配置IV總體上具有更高的質量,尤其有助于保留良好的外觀細節。

GIGA顯示了前所未有的可擴展性,可以在數千個多視圖視頻進行訓練,這要歸功于高效的表示和高度可擴展的架構,以及在不犧牲渲染質量的情況下各自的泛化。然而,它依然面臨著一定的限制,并應該在未來得到解決。盡管使用SMPL-X作為身體模板極大地促進了泛化,但如果沒有額外的假設或基于物理的先驗,它不允許正確處理非剛性動力學(例如頭發和寬松的衣服)。

在這里,一個更先進的人體形狀,包括服裝幾何可能會減輕所述限制。另外,對參數體模型和運動跟蹤的依賴會導致模板錯位或跟蹤不準確時質量下降。未來的研究可以探索身體形狀和姿態參數的端到端優化。

相關論文:GIGA: Generalizable Sparse Image-driven Gaussian Avatars

https://arxiv.org/pdf/2504.07144

總的來說,團隊提出了一種可泛化的稀疏圖像驅動高斯化身。GIGA在大規模多視圖數據集訓練,以前饋方式從稀疏輸入視圖合成文本對齊的3D高斯化身。所提出方法實現了對新身份的最先進泛化,同時由于可擴展的架構和高效的表示,保留了個人特定姿勢依賴的外觀變化。