一種基于文本或單視圖視頻數(shù)據(jù)合成360視頻的新方法

(中國AI網(wǎng) 2025年07月28日)高分辨率全景視頻內(nèi)容對于虛擬現(xiàn)實(shí)中的沉浸式體驗(yàn)至關(guān)重要,但收集起來并不容易,因?yàn)樗枰獙iT的設(shè)備和復(fù)雜的攝像頭設(shè)置。在一項(xiàng)研究中,英偉達(dá)團(tuán)隊(duì)介紹了VideoPanda,這是一種基于文本或單視圖視頻數(shù)據(jù)合成360視頻的新方法。

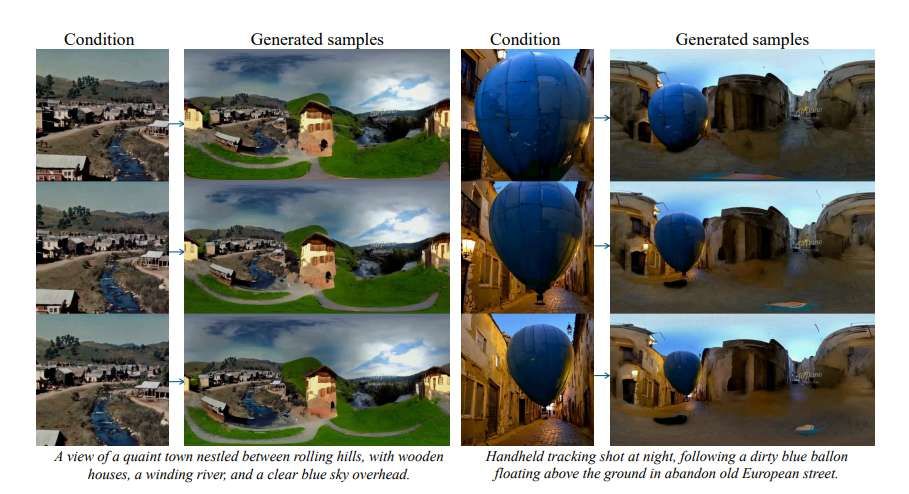

VideoPanda利用多視圖關(guān)注層來增強(qiáng)視頻擴(kuò)散模型,使其能夠生成一致的多視圖視頻,并可以組合成沉浸式全景內(nèi)容。VideoPanda采用純文本和單視圖視頻兩種條件聯(lián)合訓(xùn)練,支持長視頻的自回歸生成。

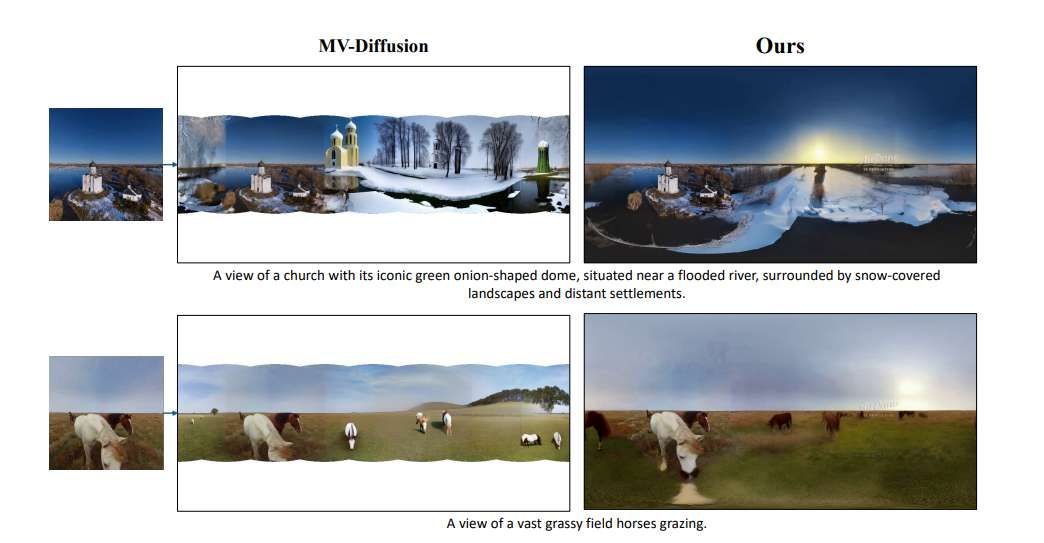

為了克服多視點(diǎn)視頻生成的計算負(fù)擔(dān),對訓(xùn)練過程中使用的持續(xù)時間和攝像頭視圖進(jìn)行隨機(jī)抽樣,并表明模型能夠在推理過程中出色地泛化到生成更多幀。對真實(shí)世界和合成視頻數(shù)據(jù)集的廣泛評估表明,與現(xiàn)有方法相比,VideoPanda在所有輸入條件下生成的360度全景圖更加逼真和連貫。

在虛擬環(huán)境中實(shí)現(xiàn)真正沉浸感的一個關(guān)鍵方面是允許用戶自由地環(huán)顧四周,通過旋轉(zhuǎn)他們的頭部并從所有可能的角度探索周圍環(huán)境。為了實(shí)現(xiàn)這樣的體驗(yàn),有必要訪問高質(zhì)量和高分辨率的全景視頻。然而,錄制這樣的視頻既昂貴又耗時,因?yàn)樗枰獜?fù)雜的攝像頭設(shè)置和專門的設(shè)備。

因此,與單視圖視頻相比,YouTube或Vimeo等平臺可用的全景視頻內(nèi)容依然有限。在這項(xiàng)研究中,英偉達(dá)團(tuán)隊(duì)的目標(biāo)是通過開發(fā)一個生成模型來解決這個問題:能夠從文本提示合成全景視頻,或者通過將單視圖視頻(從Sora等模型生成或錄制)擴(kuò)展為全景格式。

團(tuán)隊(duì)認(rèn)為這是確保沉浸式內(nèi)容更易于訪問和擴(kuò)展的重要一步。

最近,擴(kuò)散模型在生成圖像方面取得了顯著的成功。盡管它們擁有出色的能力,但使用擴(kuò)散模型生成全景視頻提出了重大挑戰(zhàn),主要是由于缺乏高質(zhì)量的全景視頻數(shù)據(jù)集。另外,雖說在推進(jìn)標(biāo)準(zhǔn)視頻生成管道方面取得了實(shí)質(zhì)性進(jìn)展,但很少有人嘗試將相關(guān)技術(shù)應(yīng)用于全景視頻生成。現(xiàn)有的方法要么局限于特定的領(lǐng)域,或僅限于生成靜態(tài)場景。

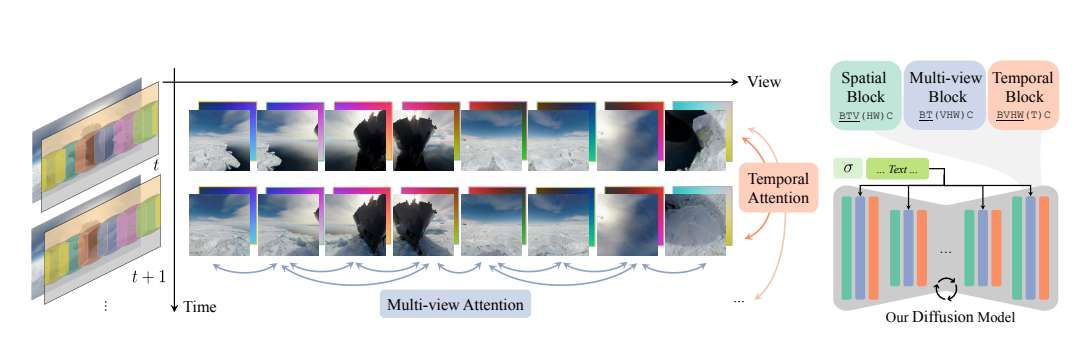

對于英偉達(dá)團(tuán)隊(duì)提出的VideoPanda,它是一種能夠從文本提示和單視圖視頻生成高質(zhì)量全景視頻的新方法,并且可以使用自回歸創(chuàng)建長視頻。所述方案建立在現(xiàn)有視頻擴(kuò)散模型的基礎(chǔ)之上,通過添加多視圖注意層來生成一致的多視圖輸出。這樣做可以確保輸出域(透視圖像)保持接近預(yù)訓(xùn)練視頻模型的原始訓(xùn)練分布(而不是直接生成等矩形投影),從而有助于在生成多個視圖的同時保持視頻質(zhì)量。

由此產(chǎn)生的視圖然后無縫地拼接在一起,以創(chuàng)建一個連貫的全景視頻。團(tuán)隊(duì)在一組不同的數(shù)據(jù)域(包括真實(shí)視頻和合成視頻)評估了模型,并在定量和定性方面證明了與以前的方法相比,而實(shí)驗(yàn)證明它的性能和質(zhì)量都更好。另外,一項(xiàng)用戶研究表明,大多數(shù)參與者更喜歡VideoPanda生成的視頻,而不是來自其他基線模型的視頻。

模型設(shè)計

團(tuán)隊(duì)訓(xùn)練了一個多視點(diǎn)視頻擴(kuò)散模型,在給定文本提示和一組可選的條件幀的情況下,模型能夠共同生成多個不同視點(diǎn)方向的多視點(diǎn)一致視頻,共同覆蓋一個完整的360度全景視頻。架構(gòu)建立在VLDM的基礎(chǔ)之上,結(jié)合了受MVDream 啟發(fā)的多視圖關(guān)注層,并將視圖方向嵌入到模型中。

具體來說,他們添加了3D多視圖自注意層,可以在視頻的每一幀的不同視圖的圖像執(zhí)行自注意。這些層與現(xiàn)有的2D自關(guān)注層以殘差方式結(jié)合使用零初始化卷積。為了讓模型理解視圖方向,使用與latent表示具有相同高度和寬度的射線方向表示,并對每個空間位置的射線方向進(jìn)行編碼。光線是相對于第一個視圖的camera姿態(tài)定義,并且對全局3D平移和旋轉(zhuǎn)不變。視圖嵌入與相應(yīng)的latent通道連接,并使用零初始化卷積在第一層輸入到模型中。

給定一組大小為512 × 512 × 3的目標(biāo)和可選條件幀,使用變分自編碼器(VAE)將每個圖像編碼為大小為64 × 64 × 4的latent表示。為了實(shí)現(xiàn)對特定幀的調(diào)節(jié),采用了CAT3D方法。在訓(xùn)練過程中,根據(jù)擴(kuò)散過程對非條件視圖對應(yīng)的潛波進(jìn)行去噪,而條件框架的潛波基本保持clean。

為了提高魯棒性并防止過擬合,使用噪點(diǎn)增強(qiáng),在輸入條件電位中添加少量噪點(diǎn)σ,并將該值σ傳遞給模型。二進(jìn)制掩碼按信道連接,以區(qū)分輸入潛波和要預(yù)測的目標(biāo)幀。然后訓(xùn)練擴(kuò)散模型來學(xué)習(xí)latent表示在輸入條件下的聯(lián)合分布。團(tuán)隊(duì)結(jié)合了CFG,在訓(xùn)練期間以10%的概率隨機(jī)丟棄條件反射幀。

最后,研究人員觀察到當(dāng)將噪點(diǎn)調(diào)度轉(zhuǎn)向更高的噪點(diǎn)水平時,性能得到了改善,這是因?yàn)槟P捅然疽曨l模型生成更多的圖像幀。他們同時發(fā)現(xiàn),與?-prediction相比,使用v-prediction可以帶來更穩(wěn)定的訓(xùn)練。

訓(xùn)練策略

團(tuán)隊(duì)從“Align Your Latents”中提出的預(yù)訓(xùn)練文本到視頻擴(kuò)散模型VideoLDM初始化模型。根據(jù)之前的研究,將多視圖注意層的權(quán)值初始化為與現(xiàn)有的2D自注意層相同的權(quán)值,以加速訓(xùn)練。

由于研究人員想要調(diào)整噪點(diǎn)調(diào)度(轉(zhuǎn)向更高的噪點(diǎn)水平),并將模型參數(shù)化從?-prediction更改為v-prediction,而不會將模型過度擬合,他們分兩個階段訓(xùn)練模型。在第一階段,從現(xiàn)有的檢查點(diǎn)對單視圖文本到視頻模型進(jìn)行微調(diào),使其適應(yīng)新的噪點(diǎn)調(diào)度和損失目標(biāo)。這個階段是在原始預(yù)訓(xùn)練數(shù)據(jù)的一個子集進(jìn)行,其中包含16幀的標(biāo)準(zhǔn)字幕視頻,并且需要最少的訓(xùn)練時間,因?yàn)槟P涂梢钥焖龠m應(yīng)這些變化。

在第二階段,凍結(jié)視頻模型的空間層,并使用多視圖視頻數(shù)據(jù)微調(diào)其余的空間層。在訓(xùn)練期間,隨機(jī)化視圖和視頻幀的數(shù)量,以增強(qiáng)模型的泛化,并防止過度擬合有限的360度視頻數(shù)據(jù),從而有效地將其用作數(shù)據(jù)增強(qiáng)的一種形式。模型訓(xùn)練成生成以不同大小的視幀矩陣表示的多視圖視頻序列,如3 × 16、4 × 12、6 × 8和8 × 6。他們把這種隨機(jī)化稱為隨機(jī)矩陣。這允許模型在推理期間泛化到新的組合,如8 × 16矩陣。

為了處理多個條件反射場景,團(tuán)隊(duì)訓(xùn)練了一個通用模型。它可以根據(jù)文本、視頻或視頻和第一幀多視圖圖像的組合生成多視圖視頻,并使用多任務(wù)訓(xùn)練策略進(jìn)行自回歸生成。具體來說,二進(jìn)制掩碼是隨機(jī)的,以反映不同的條件設(shè)置。圖3顯示了不同類型的條件作用。

長視頻的自回歸

生成為了生成長全景視頻,團(tuán)隊(duì)使用了自回歸方法(見圖3)。首先,以輸入視頻的前16幀為條件,模型生成一個8 × 16的視幀矩陣。對于后續(xù)的幀,模型的條件是視頻的下15個新幀(一列)和前一步生成的所有8個視圖(一行)中的最后一幀。這個迭代過程使得能夠生成長而連貫的視頻序列,具有平滑的過渡和一致的運(yùn)動。

然而,自回歸生成往往會隨著時間的推移而累積誤差,導(dǎo)致圖像質(zhì)量逐漸下降,并且在幾次迭代后出現(xiàn)明顯的模糊。所以,之前引入的噪點(diǎn)增強(qiáng)有助于緩解這一問題。這種噪點(diǎn)增強(qiáng)有兩個目的:它作為一種數(shù)據(jù)增強(qiáng)技術(shù)來改進(jìn)泛化,并且它允許模型通過學(xué)習(xí)從先前迭代中生成的噪點(diǎn)樣本中恢復(fù)clean信息來進(jìn)行自糾正。

相關(guān)論文:VideoPanda: Video Panoramic Diffusion with Multi-view Attention

https://arxiv.org/pdf/2504.11389

總的來說,團(tuán)隊(duì)提出的VideoPanda是一個全景視頻生成模型。VideoPanda增強(qiáng)了一個預(yù)訓(xùn)練的視頻擴(kuò)散模型,并能夠生成一致的多視圖視頻,共同覆蓋一個完整的全景視頻。研究人員以統(tǒng)一的方式訓(xùn)練VideoPanda,靈活的條件調(diào)節(jié)支持文本和單視圖視頻調(diào)節(jié),并進(jìn)一步支持長視頻的自動回歸生成。

當(dāng)然,盡管VideoPanda展示了令人信服的結(jié)果,但它依然有進(jìn)一步改進(jìn)的空間。模型的生成能力受到基礎(chǔ)視頻模型性能的限制,通過將技術(shù)應(yīng)用于更強(qiáng)大的視頻擴(kuò)散模型可以得到進(jìn)一步的改進(jìn)。