基于單圖像的3D可驅動高斯化身創建方法

(中國AI網 2025年07月31日)在虛擬現實等應用中,從有限的輸入創建逼真的3D化身已經變得越來越重要。盡管神經渲染和3D高斯飛濺等進步已經令高質量的數字人類化身創建和動畫成為可能,但大多數方法依賴于多圖像或多視圖輸入,限制了它們在現實世界中的實用性。

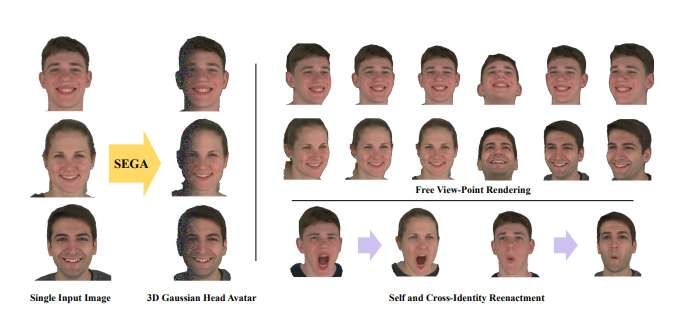

在一項研究中,清華大學深圳國際研究生院和字節跳動團隊提出了SEGA。這種基于單圖像的3D可驅動高斯化身創建的新方法將廣義先驗模型與新分層UV空間高斯飛濺框架相結合,把從大規模2D數據集獲得的先驗知識與從多視圖、多表情和多ID數據中學習到的3D先驗知識無縫結合,實現了對未見身份的強大泛化能力,同時確保了新視點和表情之間的3D一致性。

研究人員進一步提出了一個分層的UV空間高斯飛濺框架,利用FLAME-based結構先驗,并采用雙分支架構來有效地分離動態和靜態面部成分。動態分支對表情驅動的精細細節進行編碼,而靜態分支對表情無關區域進行編碼,從而實現高效的參數推理和預計算。本設計最大限度地利用有限的3D數據,實現動畫和渲染的實時性。

另外,SEGA執行個人特定的微調,以進一步提高生成化身的保真度和真實感。實驗表明,所提出方法在泛化能力、身份保存和表情真實感方面優于最先進的方法。

逼真3D人臉化身的創建對于虛擬現實等應用具有巨大的價值。由于高效率和高渲染質量,三維高斯飛濺已廣泛用于創建逼真的三維化身。然而,相關方法通常需要視頻序列甚至校準的多視圖圖像作為輸入,而這對于普通用戶來說過于繁瑣或不可能實現。

在各種輸入選項中,單個圖像是最容易訪問和用戶友好的方法,使其成為廣泛采用的理想選擇。但由于問題固有的不適定性質,從單個圖像生成高保真的3D化身依然是一項具有挑戰性的任務。它需要從有限的2D觀測推斷復雜的3D幾何和紋理信息,這往往導致深度,遮擋和精細細節的模糊性。

近年來,業內提出了數種從單幅圖像或稀疏視圖圖像生成3D化身的方法。GPAvatar、GAGAvatar、Portrait4D和Portrait4Dv2等方法利用大規模2D數據集來增強視覺保真度,提高不同身份的泛化能力。同時,HeadGAP和One2Avatar等方法采用了可歸納的3D先驗來獲得高質量的結果,但需要多視圖數據來獲得高質量的個性化化身。

盡管有了所述進步,現有的方法依然難以同時泛化到新視點、表情和身份。這一挑戰的出現是因為依賴于2D數據集的方法在從新視點和表情呈現時很容易無法保持3D一致性。另外,依賴于包含有限數量身份的3D數據集的方法往往難以泛化到未見主題。

為了解決這一限制,清華大學深圳國際研究生院和字節跳動團隊提出了SEGA,它可以從單個圖像中創建高質量,可驅動的3D面部化身。所提出方法的核心思想是通過結合2D和3D先驗來解開身份和表情信息的糾纏:使用從大規模2D數據集中學習的先驗來編碼單個輸入圖像的身份信息,并通過3D先驗來實現多視圖和表情的一致性。通過利用在大規模2D人臉數據集預訓練的網絡提取可泛化的2D先驗,并在訓練過程中進一步將其暴露于多表情和多視角的3D數據中,SEGA實現了對未見身份的魯棒泛化,同時實現了準確和3D一致的化身個性化和動畫。

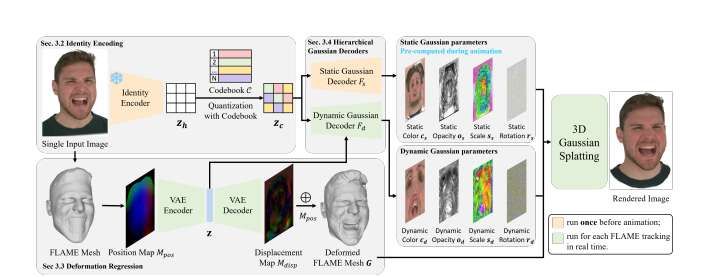

具體來說,SEGA方法首先使用在具有不同身份的2D大規模人臉數據集預訓練的VQ-VAE網絡對身份信息進行編碼,增強了對未見人臉的泛化能力。另外,通過位移VAE捕獲細粒度的幾何細節,預測FLAME-based驅動的面部表情的前頂點位移圖。兩個組件端到端使用3D數據進行聯合訓練,以確保VQ-VAE網絡捕獲的2D先驗與位移VAE和FLAME模型捕獲的3D先驗的一致性和集成性。

SEGA進一步在UV空間中使用分層框架生成高斯飛濺表示。分層框架包括兩個專門的分支:動態分支將位移VAE的latent向量與身份碼相結合,預測3D高斯參數,捕獲表情驅動的細粒度面部特征;靜態分支僅依賴于身份碼,專注于與表情無關的區域,如前額和頭皮。

這種設計允許靜態區域的預計算,在動畫期間實現實時角色性能。通過將網絡分離為動態和靜態分支,獨立處理人類頭部的不同區域,可以提高數據效率(考慮到3D數據集的稀缺性,這是一個至關重要的優勢),同時增強了模型的性能和泛化能力。注意,SEGA方法將2D UV空間的逐像素3D高斯參數回歸到變形的FLAME模型,有效地利用了人臉的結構先驗。最后,為了進一步完善結果,對單個輸入圖像執行特定于個人的微調,然后可以使用高斯飛濺從任何視點渲染逼真的化身.

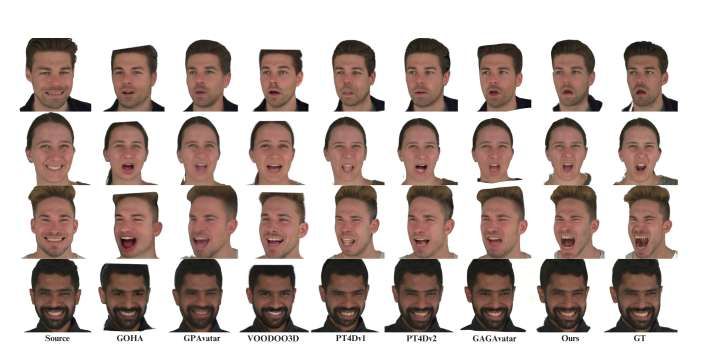

如圖3所示,與其他最先進的方法相比,團隊提出的方法始終能夠獲得更高的面部表情保真度。盡管GAGAvatar能產生更清晰的視覺效果,但它在準確的表情對應方面卻遇到了困難。相比之下,團隊提出的方法顯示出精確的表情匹配和增強的視覺真實感。

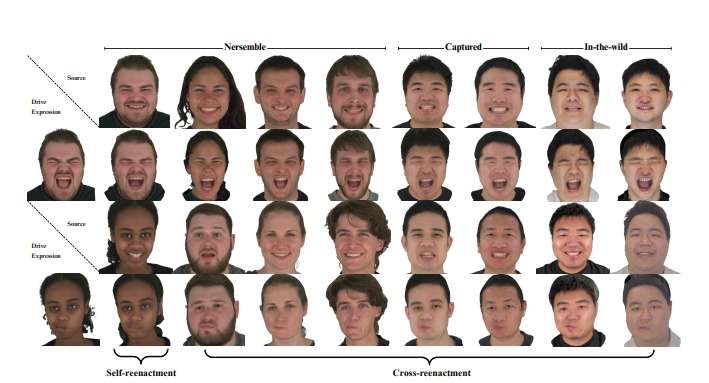

通過全面的跨身份再現實驗,研究人員證明了所提出方法在跨不同數據源的身份表情解糾纏和泛化方面的優勢。如圖4所示,評估跨越了三個不同的數據源:受控的NeRSemble數據集(第1-4列)、高質量多視圖工作室捕獲的數據(第5-6列)和具有挑戰性的in the wild圖像(第7-8列)。

對于跨身份再現,團隊使用另一個人的表情參數來動畫一個人的化身。所有數據源的結果都表明,在準確傳遞表情的同時,SEGA有效地保留了身份特征,這表明表情動態和身份特征之間存在強大的分離。

同時,團隊評估了分層動態-靜態框架:(1)全靜態,僅使用靜態分支;(2)全動態,僅依賴動態分支在1024 × 1024 UV圖生成高斯參數。如表2和圖5所示,在保留面部細節的同時,集成這兩種先驗將在所有度量中產生最佳性能。另外,通過在推理過程中在較小的UV圖生成高斯參數,將計算時間從240ms(動態)減少到50ms。

相關論文:SEGA: Drivable 3D Gaussian Head Avatar from a Single Image

https://arxiv.org/pdf/2504.14373

總的來說,SEGA是一種從單個圖像創建逼真3D頭部化身的新方法。通過將廣義先驗與分層UV空間高斯飛濺框架相結合,SEGA確保了魯棒的泛化,身份保存和表情真實感。分層架構有效地分離動態和靜態面部組件,實現實時性能。大量的實驗表明,SEGA超越了最先進的方法,為虛擬現實等領域的化身創建提供了實用的解決方案。

當然,所提出方法存在一定的局限性。首先,由于訓練數據缺乏樣本,它難以識別戴眼鏡或面部配件的被試的虛擬化身。其次,復雜的頭發和身體建模沒有完全解決,而結合相關區域的專門方法將能增強真實感。最后,所提出方法假設均勻照明,限制了不同照明條件下的真實感。未來的研究將通過整合不同的訓練數據,改進頭發和身體建模,以及探索更可擴展的化身渲染的重照明技術來解決相關問題。