為Codec Avatars帶來可變發型支持

(中國AI網 2025年08月01日)為了構建真正的元宇宙愿景,克服人與人之間,以及人與機會之間的物理距離挑戰,Met一直在探索名為Codec Avatars的項目。借助突破性的技術,Codec Avatars旨在幫助人們在未來快速輕松地創建圖片真實感的虛擬化身,從而令虛擬現實中的社交聯系變得如同現實世界般自然和常見。

根據一份新公布的研究,Meta和韓國首爾大學團隊正在努力為Codec Avatars帶來可變發型支持。

發型作為個人身份的核心要素,反映著個體風格與特征。當代社會允許人們跨越種族或天然發質限制自由選擇發型,使其成為最易改變的外在特征。隨著圖像生成與編輯技術的進步,在圖片中探索不同發型成為了可能,進而推動了對真實可控頭發合成技術的需求。然而在3D虛擬化身領域,實現可媲美的發型遷移或編輯依然具挑戰性。

當前3D虛擬化身技術在視覺質量方面取得顯著突破,已能解耦并獨立控制表情、視角甚至光照等特征。有的研究通過多主體采集數據或合成數據訓練通用先驗模型,構建了合理的3D頭部潛空間。相關模型可通過微調創建新主體的個性化3D虛擬化身。但多數方法依賴于整體建模,忽視了頭部的固有組合特性,導致發型遷移等任務難以實現。

對于從視覺數據中學習解耦的人臉/頭發潛空間,主要挑戰在于多視角含發-無發配對數據集的稀缺性。缺乏這類數據時,模型因無參照基準難以分離頭發與面部屬性。這種配對樣本為解耦提供關鍵監督,但采集過程存在固有困難:參與者通常不愿剃發或佩戴全覆蓋發帽進行無發采集,導致難以獲取多樣化高質量解耦數據。

為突破限制,Meta和韓國首爾大學團隊提出基于影棚多視角數據的3D高斯頭部組合先驗模型。針對含發/無發配對數據缺失問題:

合成無發數據生成

為每個主體配準光頭網格

基于擴散先驗獲取無發紋理

訓練時掩碼圖像頭發區域并渲染禿頭網格生成無發圖像

組合式先驗架構

擴展整體先驗模型學習解耦人臉與頭發的組合3D先驗。依托合成配對數據集,模型以數據高效方式學習人臉/頭發的解耦潛空間。

通用模型可以通過分別建模頭部和頭發,并控制各組件,支持跨訓練身份的人臉與頭發遷移。同時,它可基于未見采集數據微調,生成具備獨立人臉/頭發控制能力的個性化3D虛擬化身。

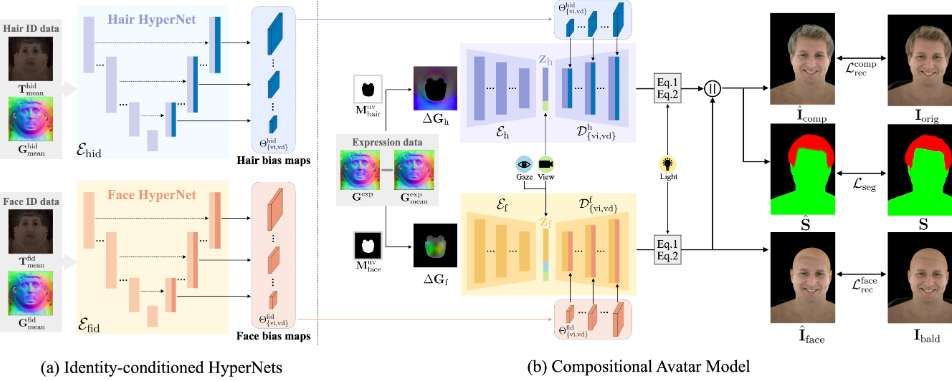

如上圖所示,團隊提出的HairCUP系統包含ID條件化的人臉/頭發超網絡和一個組合式化身模型。超網絡通過UV展開的平均反照率貼圖和幾何貼圖生成多尺度偏置圖,并將其添加到人臉/頭發高斯解碼器的每一層中。組合模型由頭發運動編碼器和面部表情編碼器構成,它們分別生成運動編碼與表情編碼,供解碼器生成高斯要素。

訓練過程中,人臉/頭發數據均來自同一對象,并采用多視角監督和基于分割的分離處理。在測試階段,不同對象的人臉/頭發ID數據及表情數據可實現跨對象混合使用。

相關論文:HairCUP: Hair Compositional Universal Prior for 3D Gaussian Avatars

https://arxiv.org/pdf/2507.19481

總的來說,這項研究攻克了3D頭發編輯領域的核心難題:通過創新合成數據方案突破真實無發數據獲取瓶頸,并建立了首個支持顯式控制、可遷移、可擴展的頭發組合式通用先驗模型,為Codec Avatars提供了關鍵技術支持。