估計注視距離

(中國AI網 2025年08月11日)虛擬現實中的眼動追蹤技術可以提高真實感和沉浸感。知道被注視對象的距離,而不僅僅是注視方向,是至關重要的。一種常用的方法是估計視線距離,即兩眼之間的相對角度,但這種方法的準確性有限,特別是對于較大的距離。或者,VR中的注視距離可以直接從估計注視點的深度圖中檢索。然而,眼動追蹤的不準確性可能導致被測量的注視指向不正確的對象,從而導致錯誤的距離估計。這個問題尤其在盯著小目標或物體邊緣時發生。

為了解決這個問題,德國圖賓根大學團隊引入了一種基于CNN的方法,將深度圖數據與眼動追蹤的收斂信息相結合。實驗表明,模型成功地學會了結合來自兩個特征的信息,并且優于最先進的方法。

虛擬現實系統通常以固定的光學距離呈現圖像,導致感知圖像缺乏自然的深場模糊。用戶的眼睛必須聚焦在這個固定的光學距離上,而雙眼之間的角度必須與虛擬環境中固定物體的距離相匹配。這種不匹配通常稱為視覺輻輳調節沖突(VAC),并且是VR中一個眾所周知的問題,會導致視覺不適和疲勞。

為了解決這個問題,業界已經提出了不同的解決方案,其中包括可提供可變焦距的可調焦透鏡或反射鏡,以模擬與位置相關的圖像模糊的景深效果,或者兩者的結合。這一解決方案主要依賴于對用戶視線的準確估計,尤其是與固定物體的距離,而不僅僅是其方向。

估計注視距離的一種常用方法是在幾何計算中使用會聚角和眼睛之間的距離。這種基于邊緣方法的一個更精細版本搜索兩只眼睛注視光線的交點。一般來說,三維射線并不完全相交,因此與兩條射線垂直的最短線的中點可以作為關注點(PoR) 。基于收斂的計算提供了一個有用的注視距離近似值,但精度通常是有限的。通過濾波,使用ground truth值目標距離的用戶個人校準,更好地考慮了瞳孔間距(IPD)或收斂行為的個體差異,可以改進估計。

在VR環境中,場景的深度分布可以在渲染深度緩沖區中訪問,并可以提供用戶注視方向對象的精確距離。在當前注視位置使用中心深度樣本,或沿著注視方向投射光線的直接方法在許多情況下都可以很好地工作。例如,當注視指向一個大的單一物體或在整潔的場景中,深度緩沖可以可靠地估計注視距離。然而,這種方法在小物體或復雜深度分布的情況下可能會導致問題。因此,有研究人員引入了一種將眼動追蹤數據與深度信息相結合的方法,并采用支持向量回歸(SVR)模型,將基于收斂的估計與注視點周圍采樣的深度值的均值和方差相結合。

改進了以前的方法,但這種方法限制了深度數據提供的潛在信息,因為它不利用單個深度值,而是依賴于匯總的統計測量。德國圖賓根大學團隊認為,通過直接使用深度樣本,ML機器學習模型可以更準確地預測凝視距離。

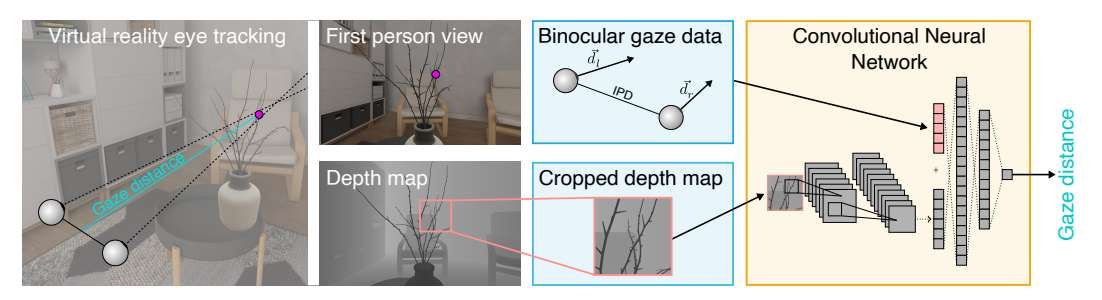

在這項研究中,德國圖賓根大學團隊提出了一種卷積神經網絡(CNN)用于注視距離估計。網絡處理深度數據,在當前注視位置周圍裁剪,然后將多層CNN的輸出與雙目注視數據集成到神經網絡中進行注視距離的回歸。

為了訓練和評估模型,他們收集了一個具有虛擬場景相應深度信息的VR眼動追蹤數據集。參與者完成了一項反應任務,要求他們在兩個虛擬環境中盯著確定的目標:一個是結構化的室內場景,另一個是自然的室外森林場景。接下來,記錄注視數據、相應的深度信息以及參與者與目標之間的ground truth距離。

另外,訓練注視距離模型來預測倒數距離???1,而不是距離??。對于前面描述的AR/VR設備中模擬景深效果或控制可調焦的應用,關鍵參數是(模擬的)optical power。optical power的誤差,即離焦,在短距離上的距離估計誤差不成比例地大。相反,對于較大的距離,這種誤差的影響會減弱。因此,團隊建議將互反距離作為更適合基于ML估計的目標特征。

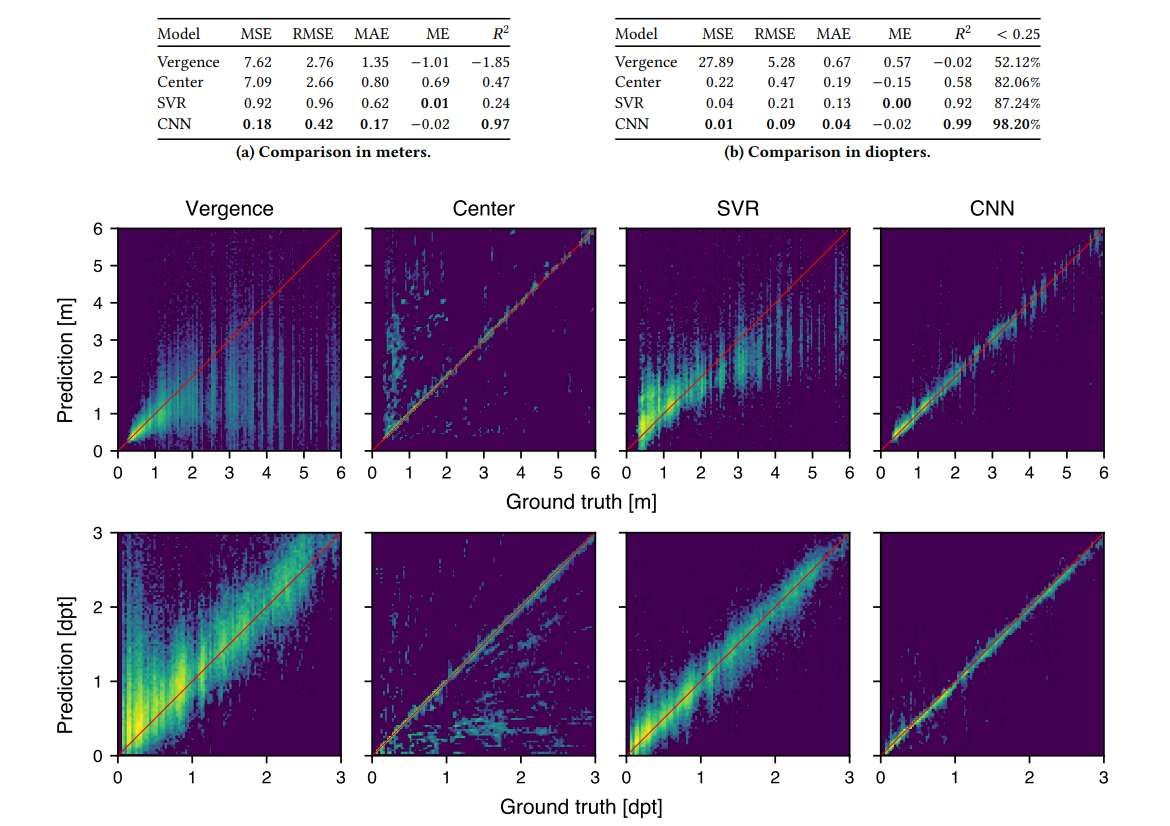

團隊評估了CNN和基線模型的均方誤差(MSE)、均方根誤差(RMSE)、平均絕對誤差(MAE)、平均誤差(ME)和決定系數(??2)。表1a和表1b分別顯示了模型的性能指標。表1b的最后一列顯示了低于0.25 dpt的絕對誤差百分比,代表了對焦誤差的感知閾值,低于閾值的誤差在VR中的可調焦透鏡等應用中是難以察覺的。

圖3可視化了在二維直方圖中繪制的針對ground truth值的單個模型的預測。性能指標和直方圖都顯示了基于收斂和基于中心的方法的缺點。基于輻角的估計僅在第1米內準確,因為在較小的距離上,輻角的變化更為突出。基于中心的方法在所有距離上都顯示出良好的結果,并實現一個合理的??2。然而,如果場景深度方差較大,這種方法的注視方向的微小變化都會導致距離預測的大變化。大量的異常值會影響所有其他性能指標。

盡管在數據集訓練的SVR的性能比前人陳述的結果差,但實現的SVR可以比之前的兩種方法更可靠地預測注視距離。團隊認為數據集中較高的深度復雜性是導致性能結果差異的原因。

另外,CNN實現引入了主體不變性,同時優于以前的方法。直方圖顯示,數據顯示得很好,預測更可靠,在真實情況周圍的傳播更小。這表明成功地學習了如何將眼動追蹤和深度數據信息結合起來解釋。另外,模型可以很好地泛化到不需要單獨用戶校準的未知參與者。圖4顯示了所有引入方法的預測誤差分布。基于收斂的方法和SVR都顯示出廣泛的分布,與前面的陳述一致。基于中心的方法預測誤差分布最窄。然而,這種方法會產生許多異常值,第5和第95百分位數的誤差證明了這一點:距離分別為- 0.04 m和3.51 m,倒數距離分別為- 1.15 dpt和0.01 dpt。CNN在距離為- 0.41 m和0.27 m,倒數距離為- 0.10 dpt和0.03 dpt時,誤差分別為第5和第95百分位,具有更強的魯棒性。

相關論文:CNN-based estimation of gaze distance in virtual reality using eye tracking and depth data

https://dl.acm.org/doi/pdf/10.1145/3715669.3723122

總的來說,團隊引入了一種CNN方法來估計VR中固定對象的(倒數)距離。CNN對估計的注視方向周圍深度分布的空間結構進行處理,并結合雙眼眼動追蹤數據回歸準確的注視距離估計。所提出方法在平均誤差和異常值數量上優于所有基線方法。與基于中心的方法相比,模型大大減少了異常值,證明雙目注視數據提供了相關信息,有助于更準確地解釋深度數據。

特征重要性分析進一步支持了這一點,這表明深度數據和眼動追蹤數據都為模型提供了關鍵信息。模型使用注視信息來解決深度圖數據中的模糊問題,而不是直接計算注視距離。

所提出方法更適用于VR中的注視情境模擬應用。另外,團隊建議將互反距離作為更合適的目標特征用于注視距離估計。在注視隨變聚焦或景深模擬等場景中,相關誤差是由于模擬焦距與注視距離之間的偏差所引起的感知模糊。這種模糊隨著離焦而縮放,即距離的倒數。

為了實現更可靠的預測,可以引入何時接受或放棄結果的標準。另外,利用更先進的深度學習架構,例如操作時間序列,可以極大地提高預測性能,因為之前的深度和眼動追蹤數據包括如何解釋未來數據的相關信息。

所提出方法的潛在局限性包括它對特定VR設備屬性的依賴,如深度圖分辨率或眼球追蹤精度,因為模型可能已經從數據集中學習了特征。更詳細的分析應側重于評估模型對其他設備的通用性,包括來自不同制造商的設備。

另外,根據深度分布的復雜性對我們數據集中的目標位置進行分類,將允許在更簡單和更具挑戰性的注視目標場景中更好地評估模型性能。

但總的來說,團隊提出的方法適用于實時應用(預測時間約為1毫秒),允許使用精確的注視距離估計進行景深模擬或其他應用。另外,對于VR以外的移動眼動追蹤應用,可以考慮采用類似的方法來確定注視距離。例如,自動對焦是一種特殊的眼鏡鏡片,它可以動態對焦固定距離,以支持眼睛隨著年齡的增長而降低的對焦能力。