將平均每個關節(jié)位置誤差(MPJPE)和平均每個頂點位置誤差(MPVPE)降低了2-3%

(中國AI網(wǎng) 2025年08月08日)對于逼真的3D姿態(tài)和形狀重建,理解雙手交互必不可少。然而,現(xiàn)有的方法存在遮擋、模糊和計算效率低等挑戰(zhàn)。為了解決相關問題,中國科學院大學和北京理工大學團隊提出了VM-BHINet,將狀態(tài)空間模型(ssm)引入手部重建,以增強交互建模,同時提高計算效率。核心組件Vision Mamba Interaction Feature Extraction Block(VM-IFEBlock)將狀態(tài)空間模型與局部和全局特征操作相結合,能夠深入理解手的交互。

在InterHand2.6M數(shù)據(jù)集的實驗表明,VM-BHINet將平均每個關節(jié)位置誤差(MPJPE)和平均每個頂點位置誤差(MPVPE)降低了2-3%,顯著優(yōu)于目前最先進的方法。

雙手交互是人類活動的基礎,如協(xié)作任務、情感表達和意圖交流。理解雙手交互對于增強現(xiàn)實/虛擬現(xiàn)實應用至關重要。對雙手交互進行準確的建模和實時重建,不僅可以提高系統(tǒng)的響應能力,而且能夠通過實現(xiàn)自然和直觀的交互改善用戶體驗。

近年來,利用單目RGB圖像進行3D手部姿態(tài)估計取得了重大進展。與早期依賴于多視圖設置的方法不同,單目方法具有實際的優(yōu)勢,可以降低部署成本和硬件要求。然而,它們面臨著獨特的挑戰(zhàn),特別是在涉及交互場景。嚴重的遮擋,模糊的手部外觀和動態(tài)的手部運動引入了顯著的復雜性。

另外,現(xiàn)有的方法往往不能模擬兩只相互作用的手之間復雜的關系,導致不準確和不自然的重建。為了解決相關限制,中國科學院大學和北京理工大學團隊提出了VM-BHINet。

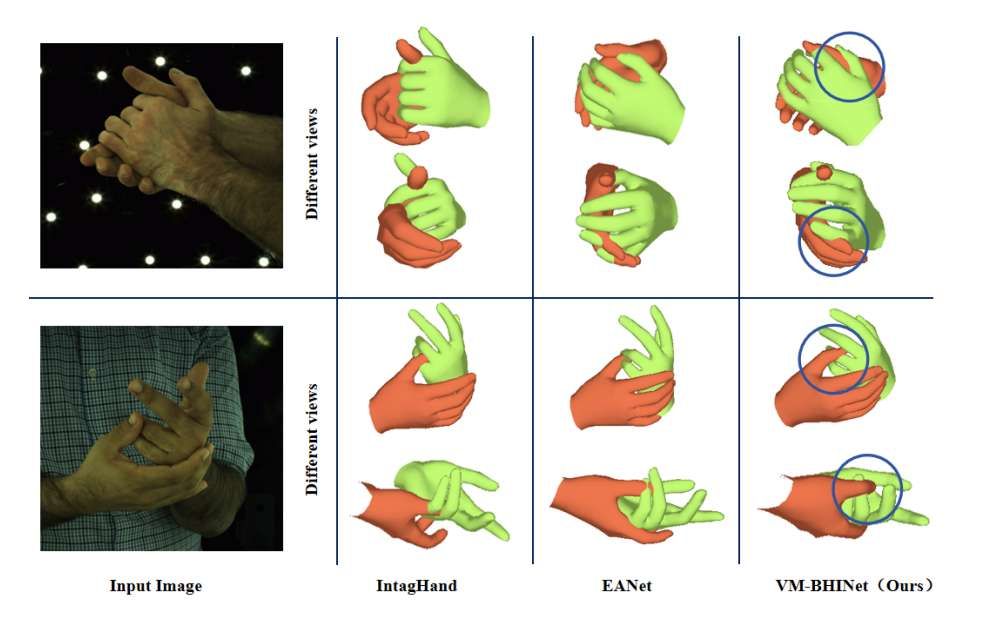

這個框架首次將狀態(tài)空間模型(ssm)集成到3D交互手部重建中,實現(xiàn)了動態(tài)特征建模,提高了計算效率。Vision Mamba Interaction Feature Extraction Block(VM-IFEBlock)是核心組件,它將局部卷積操作與全局特征表示相結合,以增強對復雜手交互的理解。通過利用狀態(tài)空間模型,模型可以捕獲雙手之間的長期依賴關系和動態(tài)交互,有效地解決了遮擋和外觀模糊等挑戰(zhàn)。如圖1所示,VM-BHINet在各種手部姿勢下的視覺表現(xiàn)都非常出色。

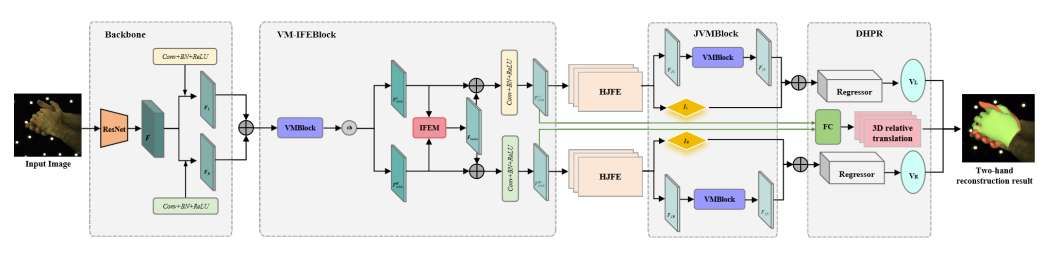

如圖2所示,VM-BHINet由五個主要組件組成:主干網(wǎng)絡、IFEM、HJFE、JVMBlock和DHPR。每個組件在處理和微調(diào)輸入數(shù)據(jù)中起著至關重要的作用,可以逐步提高模型輸出的準確性和魯棒性,包括復雜的3D手網(wǎng)格重建和交互細節(jié)。

所提出的結構首先通過一個主干網(wǎng)絡(Backbone)獲取左右手特征 FL 和 FR。特征隨后拼接并輸入到 VM-IFEBlock 中。在模塊中,拼接后的特征 Fconcat 首先通過 VMBlock 進行增強處理。增強后的特征 Fenh 隨后沿通道維度再次切分為左右手特征 FLenh 和 FRenh。

接下來,交互特征提取模塊(Interaction Feature Extraction Module, IFEM)利用非局部注意力機制(non-local attention mechanisms)提取雙手之間的深層交互特征 Finter。交互特征 Finter 通過后續(xù)的卷積層與原始特征融合,得到 FLfused 和 FRfused,從而進一步增強了特征表示的豐富性和判別力。這種融合使得融合后的特征能夠提供更準確、更全面的數(shù)據(jù)表示,從而提升模型的性能、泛化能力和魯棒性。

然后,手部關節(jié)特征提取器(Hand Joint Feature Extractor, HJFE)首先使用卷積層從增強后的手部特征 FLfused 和 FRfused 中估計每只手的 2.5D 關節(jié)坐標。然后,通過對 2.5D 熱圖應用 soft-argmax 操作,獲得每只手的精確關節(jié)坐標 JL 和 JR,并提取相應的關節(jié)特征(FJL 和 FJR)。特征為精確的手部姿態(tài)估計和 3D 網(wǎng)格重建提供了必需的位置信息和上下文特征,構成了精確、自然的手部重建和交互的基礎。

隨后的 JVMBlock 通過 VMBlock 處理每只手的關節(jié)特征,輸出增強后的關節(jié)特征 FLJ_enh 和 FRJ_enh。

最后,雙手參數(shù)回歸器(Dual Hand Parameter Regressor, DHPR)回歸 MANO 模型的姿態(tài)參數(shù)(θL 和 θR)和形狀參數(shù)(βL 和 βR),并通過全局平均池化和全連接層計算雙手之間的 3D 相對平移。

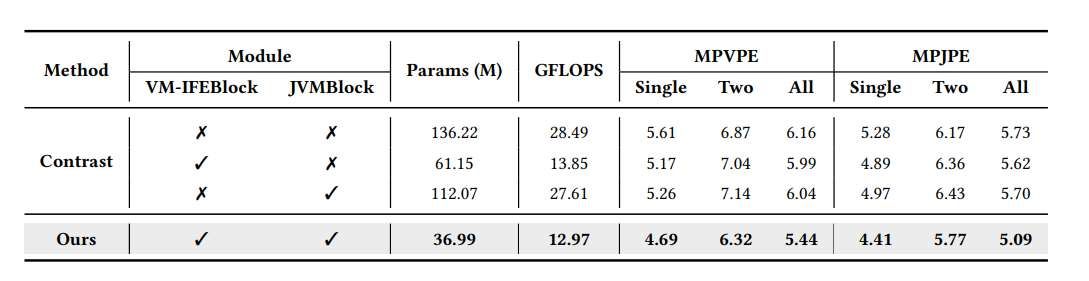

為了驗證所提出方法VM-BHINet的有效性,團隊進行了燒蝕研究,以評估不同成分對模型性能的影響。表1顯示了不同模塊組合對參數(shù)計數(shù)(Params)、計算復雜度(GFLOPS)和預測精度(MPVPE和MPJPE)的影響。MPVPE和MPJPE值報告單手、雙手和整體場景。

燒蝕研究結果表明:當VM-IFEBlock和JVMBlock同時使用時,模型在3D手部網(wǎng)格重建中MPVPE和MPJPE值最低,精度表現(xiàn)最佳。如表1所示,與基線模型相比,具有兩個組件的模型顯示出顯著的改進。在參數(shù)數(shù)量和計算復雜度方面,VM-IFEBlock和JVMBlock結合使用,參數(shù)數(shù)量減少到3699.8萬個,GFLOPS減少到12974個,相比單獨使用VM-IFEBlock(6115萬個參數(shù),13854個GFLOPS)或JVMBlock(11206.9萬個參數(shù),27613個GFLOPS)要低得多。這種參數(shù)和計算復雜度的降低突出了所提出設計的效率。

僅使用VM-IFEBlock時,單手、雙手和整體的MPVPE分別為5.17、7.04和5.99,MPJPE分別為4.89、6.36和5.62。同樣地,僅使用JVMBlock可以提高性能,單手、雙手和整體場景的MPVPE值分別為5.26、7.14和6.04,MPJPE值分別為4.97、6.43和5.70。然而,當這兩個組件一起使用時,性能改善最為顯著,單手、雙手和整體場景的MPVPE值分別為4.69、6.32和5.44,MPJPE值分別為4.41、5.77和5.09。

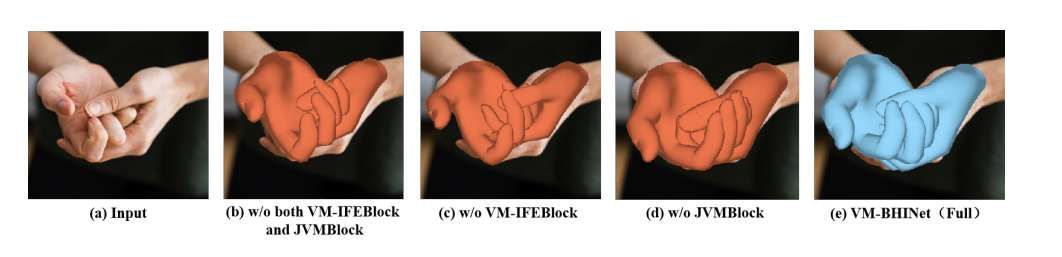

為了補充定量結果,研究人員對InterHand2.6M數(shù)據(jù)集進行了定性消融研究,以更直觀的方式說明每個組件的影響。圖4顯示了去除每個組件VM-IFEBlock和JVMBlock的效果,并顯示了完整模型在3D手動網(wǎng)格恢復中達到了最佳的視覺精度,突出了使用完整模型比單獨使用單個組件的優(yōu)勢。

總體而言,燒蝕研究表明,VM-IFEBlock和JVMBlock的結合不僅提高了模型的預測精度,而且通過減少參數(shù)計數(shù)和GFLOPS顯著提高了計算效率。燒蝕研究強調(diào)了這兩個模塊在提高模型整體性能方面的重要性,證實了它們的集成在3D手工網(wǎng)格重建任務中提供了最佳結果。這些發(fā)現(xiàn)強調(diào)了所提出的方法在同時實現(xiàn)高精度和高效率方面的有效性。

VM-BHINet在精度和計算效率之間取得了最佳平衡,實現(xiàn)了更少的參數(shù)(36.99M)和更低的GFLOPS(12.97)。這使得它成為實時應用的一個非常有前途的解決方案。結果清楚地表明,VM-BHINet在性能和效率方面都優(yōu)于現(xiàn)有方法,使其成為交互式手網(wǎng)格恢復的最先進方法。

圖5展示了在InterHand2.6M數(shù)據(jù)集與之前最先進的方法IntagHand 和EANet的視覺比較。結果表明,VM-BHINet在準確估計手部姿勢和相互作用方面具有優(yōu)越的性能。

相關論文:VM-BHINet:Vision Mamba Bimanual Hand Interaction Network for 3D Interacting Hand Mesh Recovery From a Single RGB Image

https://dl.acm.org/doi/pdf/10.1145/3728308

總的來說,VM-BHINet是一種3D交互手部網(wǎng)格恢復的新方法。通過結合狀態(tài)空間模型,所提出方法有效地解決了遮擋等挑戰(zhàn)。核心創(chuàng)新VM-IFEBlock可以捕獲復雜的手依賴,同時優(yōu)化計算效率。實驗表明,它優(yōu)于最先進的方法,在3D交互手網(wǎng)格恢復基準測試中,在精度和效率方面都取得了卓越的表現(xiàn)。

當然,當前模型在復雜背景和極端光照條件下的魯棒性有待提高,實時性有待進一步優(yōu)化以適應實際應用。另外,模型的跨域泛化能力和處理多手交互場景的能力有待增強。未來的研究可以探索更輕量級的架構、自監(jiān)督學習方法和用戶反饋機制,以減少對標記數(shù)據(jù)的依賴,提高復雜環(huán)境下的性能。