首次在Meta Quest 3實現了3個高斯Avatar的實時同步動畫和渲染(72 FPS)

(中國AI網 2025年08月05日)基于高斯的Avatar已經達到了前所未有的視覺保真度。然而,基于高容量神經網絡的現有方法通常需要桌面GPU來實現單個Avatar的實時性能,并且由于內存和計算帶寬的限制,在VR一體機等移動設備動畫和渲染相關Avatar十分具有挑戰性。

在一項研究中,Meta團隊提出了SqueezeMe。這個簡單而高效的框架可將高保真3D高斯Avatar轉換為輕量級表示,可允許移動設備動畫和計算渲染。

團隊的關鍵觀察是,從神經網絡解碼姿勢相關的高斯屬性會產生不可忽略的內存和計算開銷。受計算機圖形學中廣泛使用的混合形狀和線性姿態校正啟發,研究人員通過將神經網絡學習的姿態校正提取到線性層來解決這個問題。另外,通過在鄰近高斯函數之間共享校正量來進一步減小參數。

將它們與基于Vulkan的自定義管道相結合,團隊首次在Meta Quest 3實現了3個高斯Avatar的實時同步動畫和渲染(72 FPS)。

增強現實與虛擬現實在提供沉浸式體驗方面展現出巨大潛力。模糊物理世界與虛擬世界之間界限的體驗的核心在于高保真全身Avatar,而它將可以支持廣泛的應用,包括遠程呈現、虛擬試穿和沉浸式游戲。

為了普及這類技術,需要提供輕量化形態的AR/VR一體機。但面對高度受限的計算資源,業界正努力以移動級算力實現高保真Avatar的動畫和渲染,從而為Avatar在AR/VR中的廣泛應用鋪平道路。

基于NeRF的高保真3D場景渲染方面取得的進展已顯示出有希望的結果。另外,在移動設備實時渲染體三維視頻已成為可能 。然而,相關方法并不直接適用于Avatar,因為Avatar不僅需要支持靜態場景或預錄制序列的回放,同時需要支持為實時驅動Avatar而動態計算的新動畫方法。

現有能夠實現高保真的方法依賴于大容量神經網絡,根據驅動信號(如身體姿態參數)解碼非剛性校正量。逐幀運行這類解碼器會產生不可忽略的內存和計算開銷,阻礙了高保真Avatar的部署。

為了解決這個問題,Meta團隊提出了SqueezeMe。這是一種將基于3D高斯飛濺的高保真Avatar提煉成輕量級表示的新方法,而相關表示可直接在移動設備進行動畫和渲染。

受計算機圖形學中廣泛使用的姿態相關線性校正的啟發,研究人員計算從姿態參數到3D高斯的幾何與外觀參數(包括旋轉、位移、尺度和球諧系數)的線性映射。具體地說,首先使用大容量卷積神經網絡訓練一個在UV貼圖定義姿態相關校正參數的3D 高斯Avatar。模型僅使用5倍更少的高斯點,就能達到與最先進高斯Avatar方法相當的性能。然后,提取關鍵幀及其關聯的高斯參數,以確保覆蓋各種姿態的均勻性。接著,對關聯的姿態參數到目標校正量進行線性回歸求解。

當然,盡管這種線性提煉極大地簡化了解碼器的計算,線性矩陣的大小依然相對較大,對移動計算造成了不小的內存開銷。團隊觀察到,靜態高斯參數需要保留高頻信號以實現高保真效果,而姿態相關校正量往往是低頻的。基于這一關鍵洞察,他們通過在UV貼圖布局相鄰的高斯點之間共享校正量,從而進一步減少了內存占用。這使得能夠將所需內存減少約16倍,同時將對視覺保真度和高頻人物特定細節的影響降至最低。

在推理過程中,使用基于線性模型計算的參數渲染高斯點,并使用基于Vulkan的自定義渲染器。實驗表明,這一方法允許在Meta Quest頭顯以實時幀率(72 FPS)對最多3個全身Avatar進行動畫和渲染。另外,結果表明所提出方案導致的質量下降微乎其微。

設備端演示: 圖1展示了在VR頭顯同時運行的3個Avatar。解碼器和高斯可視化均在頭顯本地運行。盡管主要評估是在Quest 3頭顯進行,但大多數智能手機和VR頭顯都配備了類似的高通驍龍處理器,這表明在多種移動設備應該能實現類似的結果。

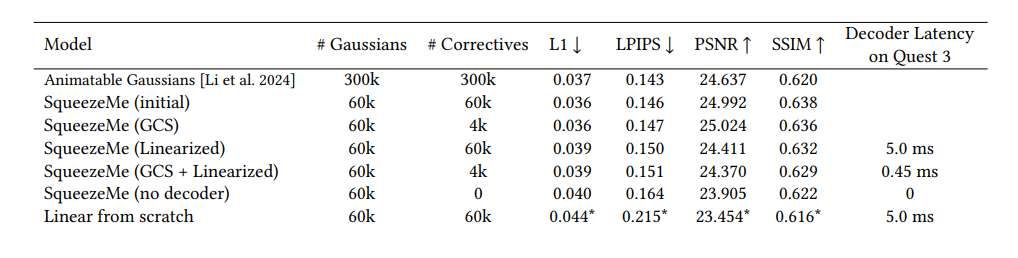

量化比較: 在表1中,團隊將所提出方法的數個版本與可動畫高斯(AG)基線進行了比較。AG擁有30萬個高斯點,可在NVIDIA GPU以10 FPS運行,但它無法在移動設備運行。對于不使用高斯校正量共享(GCS)或線性化的情況,最初的 SqueezeMe模型包含一個卷積解碼器,擁有6萬個高斯點和6萬個校正量。

最初的SqueezeMe模型在L1損失與AG持平;LPIPS 略遜于AG;而其PSNR和SSIM則略優于 AG。所以,初始模型在視覺質量方面與 AG 相當,同時使用了5倍更少的高斯點。

在另一個極端,團隊提出了一個低延遲但質量同時較低的SqueezeMe版本。它沒有解碼器,完全依賴線性混合蒙皮(LBS)來驅動高斯數字人動畫。如表1所示,與AG和初始SqueezeMe模型相比,它在所有指標方面都顯著下降。

為了在復雜度和質量之間取得平衡,研究人員又提出了一個帶有GCS的SqueezeMe版本,它將校正量從6萬個減少到4千個,并采用了一個更小的卷積解碼器;如表1所示,模型在L1損失方面與初始SqueezeMe模型持平,但在LPIPS、PSNR和SSIM略有下降。

最后,他們考慮了線性化的SqueezeMe模型;模型在質量指標方面介于初始模型和無解碼器模型之間,解碼器延遲低至0.45毫秒,這使得線性化模型對于實際的設備端應用極具吸引力。

為了展示兩階段提煉策略的有效性,研究人員考慮了另一種方案:在沒有提煉的情況下從頭開始訓練線性模型。具體來說,使用一個隨機權重初始化線性模型,并通過7種損失函數對其進行訓練。表1顯示,linear from scratch模型產生的結果明顯差于SqueezeMe模型。請注意,對于某個特定人物,即便嘗試了不同的學習率和其他超參數,linear from scratch模型都未能收斂。這表明它不如使用提煉訓練穩定。相關因素說明了提煉對于生成高質量、低延遲高斯Avatar的益處。

為了進行設備端推理,團隊將線性模型的權重量化為8位,激活值量化為16位。具體來說,他們使用了訓練后量化(PTQ),并發現浮點線性模型和量化線性模型產生相同的量化結果。所以,表1中Linearized結果的L1、LPIPS、PSNR和SSIM指標對量化和未量化模型均適用。

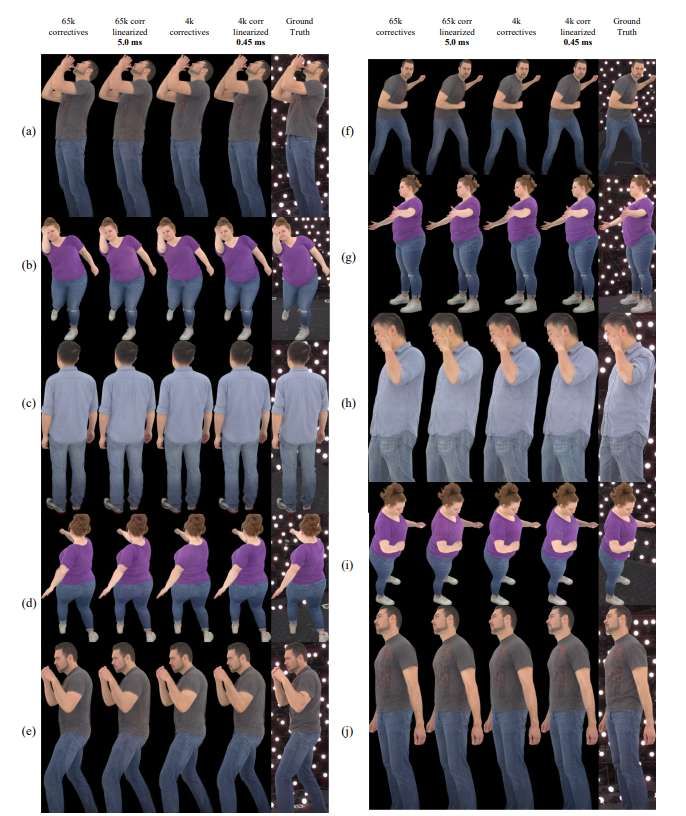

圖5展示了不同模型在不同人物、姿態和camera視角下的代表性示例。即便在手臂、軀干和腿部存在顯著運動的情況,你都可以觀察到了高質量的效果。另外,使用校正量共享將校正量從6.5萬個減少到4千個,并對模型進行線性化,Avatar質量的下降非常小。然而,通過減少校正量數量并對模型進行線性化,團隊能夠將解碼器壓縮到VR頭顯,每次推理延遲僅為0.45毫秒。

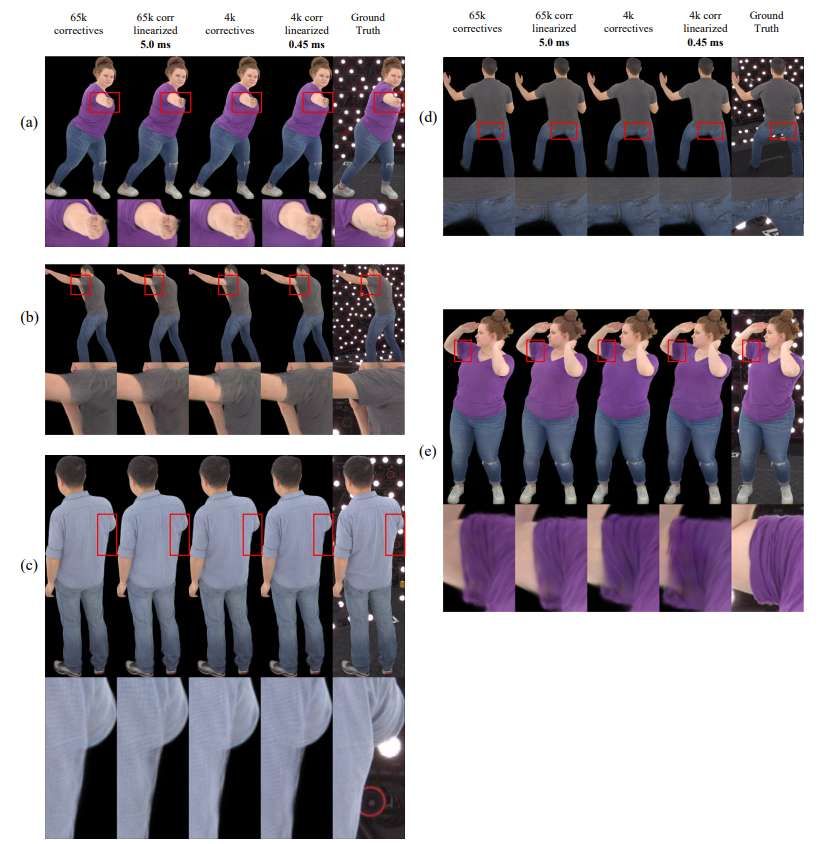

當然這一方案存在一定的局限性。圖6可視化了失敗案例。SqueezeMe模型偶爾會產生模糊的手部(見圖 6(a))和不需要的透明效果(見圖 6(c))。另外,優化(即使用高斯校正量共享將校正量從6萬個減少到4千個,以及線性提煉)引入了額外的偽影,在推理過程中間歇性出現。例如在圖 6(b, e) 中,校正量共享和線性化都可能導致手臂區域(尤其是腋下和T恤袖子與皮膚接觸處)的質量下降。

最后在圖 6(d) 中,可以觀察到校正量共享降低了褲子臀部區域的視覺質量,尤其是在Avatar雙腿分開站立時。對于這方面,一個直觀的解釋是:校正量共享假設相鄰的高斯點會一起移動,但手臂和腿部關節處的高斯點可能更獨立地移動,導致偽影有時出現在所述區域。所以,未來可以通過更自適應地在人體分布高斯點和校正量的方法來解決問題。

相關論文:SqueezeMe: Mobile-Ready Distillation of Gaussian Full-Body Avatars

https://arxiv.org/pdf/2412.15171

總的來說,團隊提出了一個包含多種技術的系統,以提高高斯飛濺在可動畫全身Avatar中的效率,包括緊湊的3D高斯Avatar表示、線性提煉和校正量共享。這將高斯校正解碼器的延遲從基線50毫秒顯著降低到僅0.45毫秒。另外,團隊展示了現在可以在Quest 3頭顯以72 FPS運行3個Avatar。

通過大幅降低計算成本,這項研究不僅推動了VR中高保真Avatar渲染的發展,同時拓展了實際應用的可能性。展望未來,這項技術可以作為擴展Avatar系統以支持更多參與者,并探索其與增強現實系統集成的基礎,從而彌合物理世界與虛擬世界之間的鴻溝。