實現高效的混合模型執行

(中國AI網 2025年09月01日)低延遲與低功耗的邊緣AI對于增強/虛擬現實應用至關重要。 近期進展表明,結合卷積神經網絡和ViT的混合機器學習模型,通常能實現更優的精度/性能權衡。然而,混合ML模型由于其數據流和內存訪問模式的多樣性,可能會在延遲和能效方面帶來系統性的挑戰。

在一項研究中,卡內基梅隆大學,Meta,紐約大學,以及康奈爾大學紐約科技校區團隊利用神經處理單元和CIM的架構異構性,并探索多樣化的執行方案以實現高效的混合模型執行。

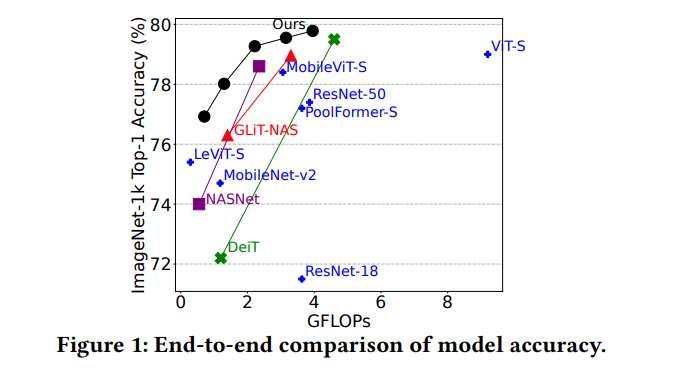

團隊提出了H4H-NAS,這是一個兩階段的神經架構搜索(NAS)框架,用于自動設計面向同時具備NPU和CIM的異構邊緣系統的混合CNN/ViT模型。他們在NAS中提出了一個兩階段的增量式超網訓練方法以提高模型精度。H4H-NAS方法同時配備了一個性能估算器,而所述估算器基于真實硅芯片測量的NPU性能結果以及基于行業IP的CIM性能數據。H4H-NAS在ImageNet-1k分類任務上實現了顯著的(最高達1.34%)Top-1精度提升,以及最高達56.08%的整體延遲降低和41.72%的能耗降低。

增強現實/虛擬現實正日益成為關鍵的下一代人本計算平臺。 然而,大多數AR/VR設備通常具有有限的計算能力、內存容量和功耗預算,但由于AR/VR應用的需求(如手勢追蹤和檢測),又需要完成超低延遲的本地ML推理。同時,為了提高任務性能,用于相關應用的ML模型正變得越來越多樣化。

例如,在計算機視覺領域,ResNet、MobileNet-v2 和ViT的基本塊結構差異巨大,需要在硬件上具備靈活的執行方案。這種多樣性給設計能效跨越各種模型的通用加速器帶來了挑戰:為某一代模型高度優化的加速器,在新模型上可能效率降低。在嚴格的能耗/延遲要求下,涌現了各種邊緣AI加速設計來應對這些挑戰:

NPU: 神經處理單元NPU已成為在邊緣設備嚴格資源限制下加速計算密集型工作負載的流行解決方案。通常,NPU采用脈動陣列作為其核心組件,以高效計算矩陣乘法。

CIM: 然而,隨著計算能力的提升,內存與處理器之間頻繁的數據移動主導了能耗/延遲成本。為了緩解這個問題,存內計算CIM重新興起,以有效減少數據移動。在CIM中,計算單元靠近存儲器(近存計算)甚至與存儲器融合(內存計算),從而提升延遲/能效。CIM推動了基于ReRAM、PCM、MRAM、DRAM等技術的AI/ML及其他工作負載相關加速器的設計。

隨著ML算法/模型和邊緣硬件加速器這兩方面的多樣化進展,當前邊緣AI/ML系統的設計空間變得極其復雜。在這項研究中,團隊提出了一種結合NPU和CIM的通用設計方案,利用NPU和CIM的架構異構性,并通過混合CNN/ViT模型產生的多樣化數據流來加速邊緣AI。

另外,團隊引入了一個以神經架構搜索為核心的自動化設計流程來協同設計混合CNN/ViT模型,以在異構架構上實現最佳的精度/性能權衡。

在研究中,他們專注于協同設計由NPU和CIM組成的混合模型與異構系統,為高效的邊緣AI/ML提供潛在解決方案。團隊開發了一個名為H4H的工作流程,用于自動化算法和硬件的協同設計,以在配備NPU和CIM的異構邊緣系統使用混合的CNN+ViT模型進行高效推理。

神經架構搜索(NAS)是一種高效的方法,可自動化設計大量DNN以發現適合移動部署的高效解決方案。團隊遵循兩階段的OFA-NAS框架開發了H4H-NAS——第一階段進行超網訓練,第二階段進行子網搜索。重點是支持混合模型的靈活搜索空間,并將其部署在異構的NPU+CIM架構。

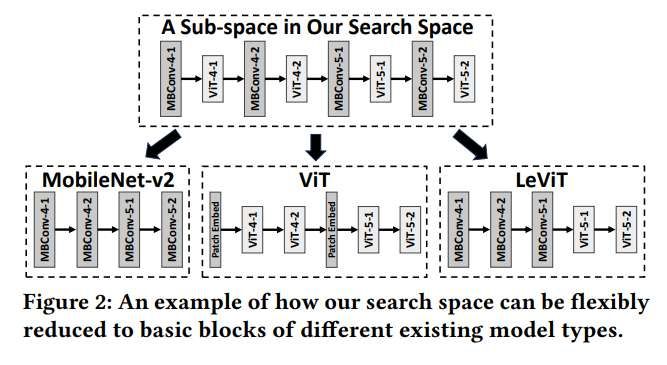

他們使用重復的“卷積 + transformer”塊構建了超網結構。如圖2所示,超網可以靈活地縮減為純CNN模型(如MobileNetv2)、純ViT模型或類似于先前NAS研究的“CNN在前ViT在后”結構。這種設計確保了超網架構的靈活性,使其在搜索過程中能夠縮減為各種模型類型中的最佳模型模式。

當直接使用標準的NAS訓練方案時,可以觀察到在大型混合(CNN+ViT)搜索空間中,子網的性能比在較小的純CNN空間中更差。類似的現象在先前的研究中同樣有觀察到。這種性能下降很可能源于訓練期間不同采樣子網的梯度未對齊。他們進一步觀察到,在混合搜索空間中,這種梯度沖突/未對齊現象被不同塊類型所放大。

為了解決這個梯度沖突問題,團隊提出了一種名為“兩階段增量式超網訓練”的新訓練方案。超網訓練階段分為兩個階段。在第一階段,從超網中移除所有ViT塊,僅使用所有剩余的CNN組件訓練一個部分超網(即首先訓練一個純CNN超網)。

在第二階段,將第一階段所有預訓練的CNN權重加載到完整的混合超網中,并繼續訓練。其基本思路是,在每個階段中,僅屬于同一類型的塊一起訓練。因此,梯度沖突應在每個階段內得到緩解。

一旦超網訓練完成,采用進化搜索來尋找最優子網,同時考慮嚴格的系統能耗/延遲約束。團隊對在異構AI邊緣設備運行的子網進行建模。系統模型將ML模型分解為細粒度組件。對于卷積層,它將不同通道的執行分配到不同的設備上。類似地,對于transformer層,它將Q/K/V的生成以及注意力層中不同頭的執行進行劃分。系統建模工具結合了使用定制硅芯片的測量結果和工業CIM IP的仿真結果。另外,模擬了通過片上網絡在NPU和CIM之間進行數據傳輸所引起的延遲/能耗。因此,為目標子網獲得了精確的延遲和能耗估計。

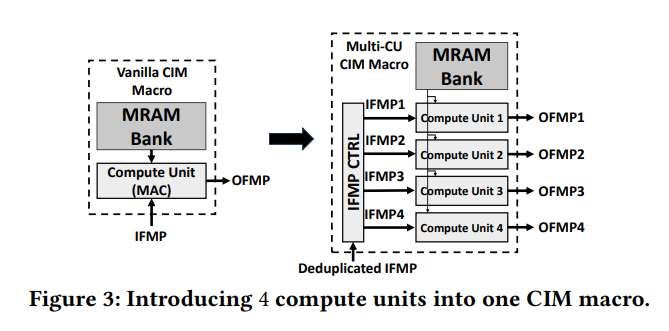

為了實現邊緣ML推理的并行執行,將多個CIM宏單元聚合到一個系統中,同時并行化大型模型層的計算。另外,在單個CIM宏單元內引入了多個計算單元,如圖3(右)所示。這種設計不僅提高了吞吐量,而且能將重復的輸入數據合并并傳輸到同一個CIM宏單元中。輸入特征圖(IFMP)控制器以較低的面積開銷(< 0.1%)重新組織計算所需的數據流。

在評估時,結果基于U55 NPU 的真實硅芯片測量數據和SPICE仿真的工業MRAM-CIM IP。圖1顯示,與先前方法相比,H4H-NAS方法顯著提升了ImageNet-1k分類的精度/延遲前沿。例如,在相同的延遲要求下,配備8個CIM宏單元的H4H設計系統支持的混合模型,其Top-1精度比純NPU系統高出1.34%。同時,對于精度相同的模型,配備8個CIM宏單元的系統進行推理的平均延遲降低了21.99%,最高可達56.08%。

相關論文:H4H: Hybrid Convolution-Transformer Architecture Search for NPU-CIM Heterogeneous Systems for AR/VR Application

https://dl.acm.org/doi/pdf/10.1145/3746238.3746241

對于節能效果,在相同的能耗要求下,配備8個CIM宏單元的系統可以支持精度高出0.614%的混合模型。此外,它實現了平均11.80%、最高33.13%的能耗降低。在一個CIM宏單元內配備4個計算單元的情況下(圖3),與純NPU系統相比,能耗平均降低了19.11%,最高可達41.72%。

有趣的是,H4H-NAS傾向于同時包含CNN和ViT,并在它們之間保持平衡以實現高效推理。幾乎所有搜索到的子網都呈現出類似的比例:2-5個ViT塊與10個CNN塊組合。這一現象表明,具有固定比例的CNN和ViT的重復塊組合是更優的選擇。