查看引用/信息源請點擊:中國AI網

AsynFusion在生成實時、同步的全身動畫方面達到了最先進的性能,在定量和定性評估中均持續優于現有方法

(中國AI網 2025年09月12日)全身音頻驅動虛擬化身姿態與表情生成是創造逼真數字人、增強交互式虛擬代理能力的關鍵任務,在虛擬現實和遠程通信中具有廣泛應用。現有方法通常獨立生成音頻驅動的面部表情和身體姿態,這帶來了一個顯著限制:面部表情與身體姿態元素之間缺乏無縫協調,導致生成的動畫不夠自然和連貫。

為克服這一限制,北京航空航天大學,上海交通大學,中國電信人工智能研究院和GigaAI團隊提出了 AsynFusion,一種利用DiT實現和諧表情與姿態合成的新型框架。

所提出方法基于雙分支DiT架構構建,支持面部表情與身體姿態的并行生成。在模型內部,引入協同同步模塊以促進兩種模態之間的雙向特征交互,以及一種異步LCM采樣策略,在保持高質量輸出的同時降低計算開銷。大量實驗表明,AsynFusion在生成實時、同步的全身動畫方面達到了最先進的性能,在定量和定性評估中均持續優于現有方法。

音頻驅動的虛擬化身表情與姿態生成是一項關鍵任務,目標是在創造能夠將音頻輸入無縫轉化為同步面部表情和身體姿態的逼真數字人。這項任務對于彌合語音與非語言交流之間的鴻溝至關重要,使虛擬化身能夠以自然、動態的方式傳達情感、意圖和個性。這項技術重要性遍及多個領域,包括元宇宙應用。

近年來,業界提出了眾多方法來支持音頻驅動的虛擬化身表情與姿態生成,但主要將語音驅動的面部表情和身體動作合成視為獨立任務。面部表情生成側重于將語音中的情感特征映射到面部肌肉運動以產生自然的動畫,而身體動作合成則探索語音與姿態之間的相關性以生成連貫的全身運動。

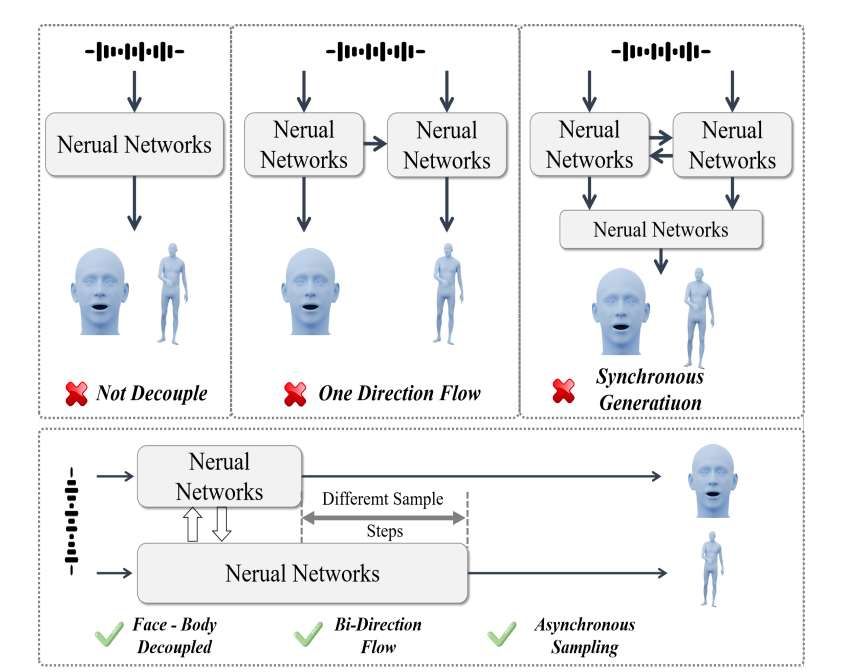

盡管取得了進展,相關方法通常在表情與動作之間缺乏充分的協調。生成模型如 VQ-VAE、GANs和擴散模型提升了同步性和多樣性,實現了表情與動作的統一建模。如圖1所示,近期研究包括:Probtalk(使用統一模型同時生成表情和姿態)、DiffSHEG (使用表情到姿態的單向序列流)以及 EMAGE(結合身體提示以實現更好協調)。最相關的研究 Combo 將表情和動作特征融合為聯合雙向分布。然而,一個關鍵挑戰仍然存在:平衡協調精度與計算效率。更具體地說,表情與動作的同步通常帶來高昂的計算開銷,限制了在延遲敏感場景中生成流暢動畫的能力。

為應對這一挑戰,北京航空航天大學,上海交通大學,中國電信人工智能研究院和GigaAI團隊提出了 AsynFusion,一種利用面部表情與身體姿態生成解耦來實現高效且逼真動畫的新型框架。AsynFusion的核心思想在于分離頭部(表情)和身體(姿態)的生成過程,以促進并行信息處理,同時確保共享特征交互。這種設計不僅尊重了面部表情和姿態元素的不同信息需求,而且結合了異步機制以優化計算效率,而不損害協調質量。

基于此原則,他們設計了一個包含三個關鍵組件的模型:

雙分支DiT架構:支持面部表情與身體姿態的并行生成,并通過雙向特征交互確保其對齊。

協同同步模塊:利用交叉注意力機制建模面部表情與姿態元素之間復雜的依賴關系,增強生成動畫的連貫性和自然動態性。

異步隱一致性模型(LCM)采樣方法:在保持高質量結果的同時降低計算復雜度,實現適用于交互應用的實時性能。

在廣泛使用的基準數據集上進行的大量實驗表明,AsynFusion在生成質量和計算效率方面均能達到最先進的性能。

圖3中展示了方法的可視化結果:(a) 展示了語音“Well, Hello There, My name is…”生成的一系列動作序列。所述可視化證明了雙向特征交互機制在協調面部表情和身體姿態方面的有效性。具體來說,在問候語“Hello There”期間,模型生成了同步的抬手姿態,自然地對齊了相應的面部表情。角色的面部展現出恰當的情感投入(從中性表情過渡到友好表情),同時雙手做出連貫的問候動作。這種協調在嘴部動作和手勢的自然時序配合上尤為明顯,問候姿態的峰值與語音的重音部分重合。

(b) 突出了語音片段“And I always tell…”的動作生成。序列展示了AsynFusion相較于基線方法優越的協調能力。在結果中,當說話者強調單詞“always”時,模型生成了一個漸進式抬手姿態,自然地與語音強度(圖中上升的紅線所示)對齊。這個動態姿態與從中性過渡到強調的恰當面部表情同步,創造了一個連貫的非語言強調表達。此例說明,與以往單獨處理面部表情和身體姿態或僅使用單向信息流的方法相比,雙向信息流實現了更自然、更協調的動作合成。

研究人員使用一套全面的指標評估我們的方法,包括弗雷歇距離(FMD, FGD, FED)以評估整體、姿態和表情質量,以及多樣性(Div)和節拍對齊度(BA)。相關指標對生成動作的分布和時序方面提供了穩健評估。如表1所示,在BEAT、SHOW和BEAT2數據集上,AsynFusion持續超越現有方法。在BEAT數據集上,模型取得了最低的FMD(312.46)和FED(316.97),優于DiffSHEG(FMD 324.67, FED 331.72)及其他方法。

AsynFusion同樣取得了最佳的FGD(421.58),相比CaMN(1635.44)以及基于擴散的方法如DiffGesture(23700.91)和DSG(1907.58)生成了更平滑、更穩定的姿態。在動作動態性方面,AsynFusion在平滑度和表現力之間取得了更好的平衡。相比CaMN(BA = 0.793),模型生成了更具動態性的姿態(BA = 0.917),同時與真實數據水平(BA = 0.915)非常接近。姿態多樣性(Div = 0.561)同樣優于DiffSHEG(Div = 0.536),接近真實數據多樣性(Div = 0.819)。

在SHOW數據集,AsynFusion取得了最低的FMD(3.098)和最高的姿態多樣性(Div = 12.53),優于Combo(Div = 10.36)、TalkSHOW(Div = 12.40)和Probotalk(Div = 10.45)。模型在節拍對齊度(BA = 0.8701)和姿態穩定性(FGD = 2.049)方面也領先,優于TalkSHOW和Combo。在BETA2數據集上,AsynFusion取得了最低的FMD(7.128)和FGD(5.436),優于EMAGE(FMD = 7.310, FGD = 5.512),以及最高的姿態多樣性(Div = 14.23)。總體而言,AsynFusion通過其雙向特征交互和異步采樣,為協調的表情-姿態生成設立了新基準,提供了卓越的動作穩定性、多樣性和同步性。

為評估表情分支和姿態分支之間的最優交互機制,團隊比較了五種變體:(1) 無交互:兩個分支獨立運行,無信息交換;(2) 單向流(E → G):僅允許表情影響姿態(類似于DiffSHEG);(3) 單向流(G → E):僅允許姿態影響表情;(4) 簡單融合:在單個DiT塊中簡單拼接表情和姿態特征;(5) 雙向交互設計。

如表2所示,雙向交互策略在所有評估指標上顯著優于所有替代方案。無交互的基線表現出表情與姿態之間的協調性差(FMD = 352.41),證實了跨分支通信的必要性。盡管兩種單向變體相比基線有所改進,但它們表現出不平衡的性能——表情到姿態流在面部指標上表現優異但在姿態動態性上欠佳(FGD = 435.24),而姿態到表情流則呈現相反趨勢。

這一發現與DiffSHEG中的結論一致。姿態到表情的單向流模型甚至表現比簡單融合方法的結果更差。這一觀察啟發研究人員設計了異步LCM采樣,因為他們發現面部組件需要顯著更少的LCM采樣步驟即可獲得有競爭力的結果。簡單融合方法盡管允許信息交換,但未能有效建模模態間的細微關系(FMD = 340.16)。相比之下,雙向交互設計取得了最佳性能(FMD = 312.46, FED = 316.97, FGD = 421.58),證明了表情與姿態之間動態、平衡的信息流的重要性。

團隊接下來通過比較三種方法評估采樣策略:(1) 傳統DDIM采樣:兩個分支均使用25步;(2) 同步LCM采樣:兩個分支均使用8步;(3) 異步LCM方法:表情分支使用4步,姿態分支使用8步。如表3所示,DDIM采樣實現了高質量,但計算成本高昂(每序列56.4秒)。同步LCM方法將推理時間減少了67%(18.6秒),而質量僅輕微下降(FMD從312.46降至318.13)。

異步LCM策略通過認識到面部表情比身體姿態收斂更快,進一步提升了效率(15.9秒)。值得注意的是,這種自適應方法保持了有競爭力的質量(FMD = 320.59),同時與DDIM相比減少了72%的推理時間。結果表明,異步策略通過使采樣過程適應每個動作組件固有的特性,有效地平衡了質量和計算效率。

最后,將AsynFusion的計算效率與語音伴隨動作合成的最先進方法進行了比較。如表4所示,所提出方法實現了最快的推理時間(每序列15.9秒)和最低的計算復雜度(58.4 GFLOPs),同時保持了有競爭力或更優的質量指標。與Probtalk等統一方法相比,AsynFusion減少了62%的推理時間和57%的計算需求。即使與DiffSHEG等近期高效方法相比,所提出方法也顯示出推理時間減少43%和GFLOPs減少38%。這一顯著改進源于雙分支架構和異步采樣策略,它們有效地并行化計算并優化了每個動作組件的采樣步驟。結果證實,AsynFusion在保持高質量動作合成的同時,成功解決了音頻驅動虛擬化身動畫中的計算效率挑戰。

相關論文:AsynFusion: Towards Asynchronous Latent Consistency Models for Decoupled Whole-Body Audio-Driven Avatars

https://arxiv.org/pdf/2505.15058

總的來說,團隊提出了 AsynFusion,一種用于音頻驅動虛擬化身動畫、推進聯合表情-姿態生成的新型框架。團隊主要貢獻包括:一個具有雙向特征交互的雙分支DiT架構,通過協同同步模塊(CoSync)實現,改進了面部表情與身體姿態之間的協調性;引入了使用隱一致性模型(LCM)的異步采樣策略,在保持高質量動作合成的同時顯著降低了計算開銷。