查看引用/信息源請(qǐng)點(diǎn)擊:中國AI網(wǎng)

富有表現(xiàn)力的虛擬化身

(中國AI網(wǎng) 2025年09月15日)隨著神經(jīng)渲染和運(yùn)動(dòng)捕捉算法的最新進(jìn)展,逼真的人類虛擬化身建模已取得顯著進(jìn)步,為虛擬現(xiàn)實(shí)和增強(qiáng)現(xiàn)實(shí)等行業(yè)應(yīng)用釋放了巨大潛力。然而,現(xiàn)有方法由于對(duì)面部表情和身體運(yùn)動(dòng)采用糾纏式表征,無法提供對(duì)虛擬化身完整、忠實(shí)且富有表現(xiàn)力的控制。

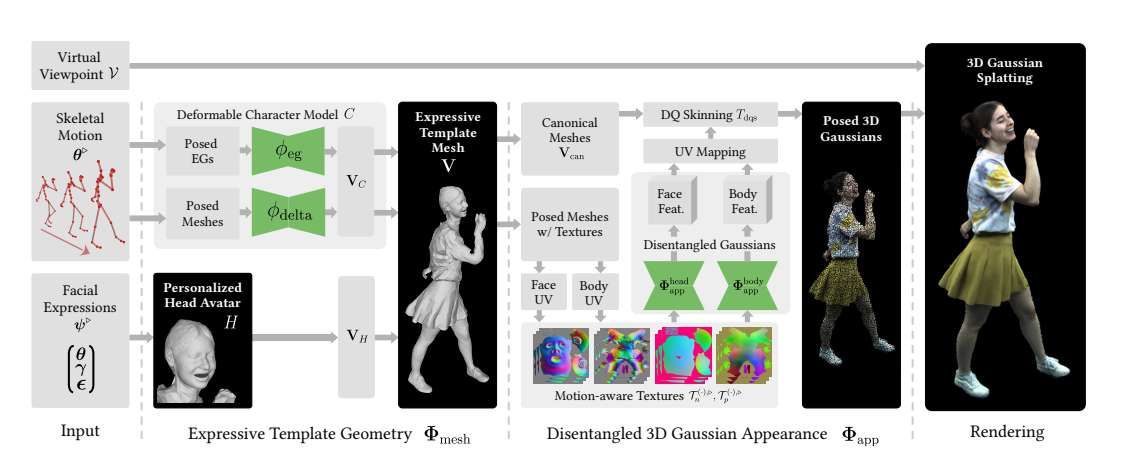

在一項(xiàng)研究中,馬克斯·普朗克信息學(xué)研究所團(tuán)隊(duì)提出了EVA,一個(gè)完全可控且富有表現(xiàn)力的人類虛擬化身框架。它能夠?qū)崿F(xiàn)高保真度的實(shí)時(shí)逼真渲染,同時(shí)支持對(duì)面部表情、身體運(yùn)動(dòng)和手勢(shì)的獨(dú)立控制。具體而言,所提出方法將人類虛擬化身設(shè)計(jì)為一個(gè)雙層模型:一個(gè)富有表現(xiàn)力的模板幾何層和一個(gè)3D高斯外觀層。

首先,他們提出了一種富有表現(xiàn)力的模板跟蹤算法,利用由粗到精的優(yōu)化策略,從多視角視頻中準(zhǔn)確恢復(fù)身體運(yùn)動(dòng)、面部表情和非剛性變形參數(shù)。接著,研究人員提出了一種新穎的解耦式3D高斯外觀模型,旨在有效分離身體和面部的視覺外觀。與統(tǒng)一的高斯參數(shù)估計(jì)方法不同,蘇提出方法采用兩個(gè)專門且獨(dú)立的模塊來分別建模身體和面部。

實(shí)驗(yàn)結(jié)果表明,EVA在渲染質(zhì)量和表現(xiàn)力方面超越了最先進(jìn)的方法,驗(yàn)證了其在創(chuàng)建全身虛擬化身方面的有效性。這項(xiàng)研究代表著向完全可驅(qū)動(dòng)的數(shù)字人體模型邁出了重要一步,使得創(chuàng)建能夠忠實(shí)復(fù)制人體幾何形狀和外觀的逼真數(shù)字化身成為可能。

在快速發(fā)展的數(shù)字領(lǐng)域,創(chuàng)建逼真的虛擬人類化身對(duì)于虛擬現(xiàn)實(shí)和增強(qiáng)現(xiàn)實(shí)等應(yīng)用變得越來越重要。化身彌合了現(xiàn)實(shí)世界交互與數(shù)字空間之間的鴻溝,實(shí)現(xiàn)了逼真的遠(yuǎn)程臨場(chǎng)感和沉浸式虛擬體驗(yàn)。然而,現(xiàn)有方法要么僅提供身體層面的控制,要么無法準(zhǔn)確捕獲身體動(dòng)力學(xué)。這促使業(yè)界努力開發(fā)富有表現(xiàn)力的化身:提供對(duì)身體、手部和面部的完全且解耦的控制;呈現(xiàn)動(dòng)態(tài)運(yùn)動(dòng)和表情的逼真渲染;實(shí)現(xiàn)實(shí)時(shí)推理。

研究人員已經(jīng)探索了各種人體表征方法,以從多視角視頻或3D掃描創(chuàng)建可動(dòng)畫的化身。早期方法使用帶紋理貼圖的模板網(wǎng)格進(jìn)行新視角渲染,但缺乏照片級(jí)的真實(shí)感。近期工作將神經(jīng)渲染與人體模板相結(jié)合,以實(shí)現(xiàn)具有控制能力的逼真渲染。例如,使用規(guī)范神經(jīng)輻射場(chǎng)NeRF結(jié)合神經(jīng)混合權(quán)重場(chǎng)進(jìn)行骨架驅(qū)動(dòng)的變形,但它們難以處理衣物褶皺,且模型推理速度慢。

其他方法則從UV或正交空間中的位置或法線圖預(yù)測(cè)3D高斯分布,實(shí)現(xiàn)了實(shí)時(shí)的逼真渲染,但受限于基礎(chǔ)模板,無法實(shí)現(xiàn)精細(xì)的面部控制。

為了改進(jìn)這一點(diǎn),人們引入了如SMPLX等富有表現(xiàn)力的模板。ExAvatar在SMPL-X上預(yù)測(cè)姿態(tài)相關(guān)的高斯偏移量,但未能捕獲動(dòng)態(tài)的衣物外觀。同樣,DEGAS從身體姿態(tài)和視覺表情編碼器DPE估計(jì)高斯參數(shù),但僅限于基于圖像的面部表情控制。

為了應(yīng)對(duì)相關(guān)挑戰(zhàn),馬克斯·普朗克信息學(xué)研究所團(tuán)隊(duì)提出了EVA,一個(gè)完全富有表現(xiàn)力且解耦的可動(dòng)畫化身框架,能夠根據(jù)身體運(yùn)動(dòng)、表情參數(shù)和任意視角生成實(shí)時(shí)、逼真的人體渲染(見圖1)。

與先前要么依賴于受限于骨骼變換和簡(jiǎn)單蒙皮的網(wǎng)格模板,要么使用像SMPL-X這樣缺乏精確衣物動(dòng)力學(xué)的參數(shù)化模型的方法不同,EVA使用了一個(gè)可變形且完全可控的模板層作為更具表現(xiàn)力的幾何代理。在此基礎(chǔ)上,團(tuán)隊(duì)提出了一個(gè)解耦的高斯外觀層,它在實(shí)現(xiàn)逼真渲染的同時(shí),提供了對(duì)身體、手部和面部的細(xì)粒度控制。

所提出方法在訓(xùn)練過程中利用了演員的密集多視角視頻及相應(yīng)的運(yùn)動(dòng)跟蹤結(jié)果。這一方法始于一個(gè)富有表現(xiàn)力的模板幾何層,構(gòu)建并跟蹤一個(gè)完全可控且可變形的模板。受前人啟發(fā),團(tuán)隊(duì)提出一個(gè)漸進(jìn)式變形過程來初始化個(gè)性化的頭部化身,并使用基于縫合的方法將其與運(yùn)動(dòng)驅(qū)動(dòng)的可變形模板集成。接著,他們引入一個(gè)多階段跟蹤流程,將模板配準(zhǔn)到多視角視頻。

為了提高表情精度,利用多視角面部關(guān)鍵點(diǎn)和逐幀3D重建來優(yōu)化身體運(yùn)動(dòng)。然后,專門從多視角圖像中恢復(fù)面部表情參數(shù)。隨后,采用基于運(yùn)動(dòng)的變形學(xué)習(xí)方法來恢復(fù)粗略的衣物變形。

為了實(shí)現(xiàn)照片級(jí)逼真的渲染,在模板的2D UV空間中構(gòu)建了一個(gè)3D高斯外觀層。與先前的3D高斯化身模型不同,解耦高斯外觀層分離了身體姿態(tài)和面部表情,允許獨(dú)立的參數(shù)控制。具體來說,身體和面部的3D高斯分布分別由兩個(gè)2D U-Net預(yù)測(cè),它們分別由以根節(jié)點(diǎn)為中心的身體運(yùn)動(dòng)和面部表情驅(qū)動(dòng)。由于現(xiàn)有數(shù)據(jù)集沒有同時(shí)捕獲多樣化的面部表情、手勢(shì)和身體運(yùn)動(dòng),團(tuán)隊(duì)引入了一個(gè)包含廣泛身體運(yùn)動(dòng)、詳細(xì)的面部表情和變化手勢(shì)的全新數(shù)據(jù)集,以驗(yàn)證所提出方法并解決現(xiàn)有數(shù)據(jù)集的局限性。

他們將EVA與兩種在多視角數(shù)據(jù)上訓(xùn)練且僅依賴運(yùn)動(dòng)參數(shù)進(jìn)行角色動(dòng)畫的實(shí)時(shí)人體渲染方法進(jìn)行比較:(1) DDC,這種基于網(wǎng)格的方法的幾何通過學(xué)習(xí)的圖變換和頂點(diǎn)位移建模,外觀通過學(xué)習(xí)到的動(dòng)態(tài)紋理表示;(2) ASH,這種混合方法利用DDC生成的可動(dòng)畫模板網(wǎng)格建模幾何,并用高斯飛濺建模動(dòng)態(tài)外觀,但它缺乏對(duì)面部表情的顯式控制。并行研究DEGAS的代碼未公開,無法比較。盡管如此,DEGAS在推理時(shí)需要面部圖像來驅(qū)動(dòng)表情,這與團(tuán)隊(duì)所提出方法(僅需面部表情參數(shù)即可驅(qū)動(dòng)面部)形成鮮明對(duì)比。

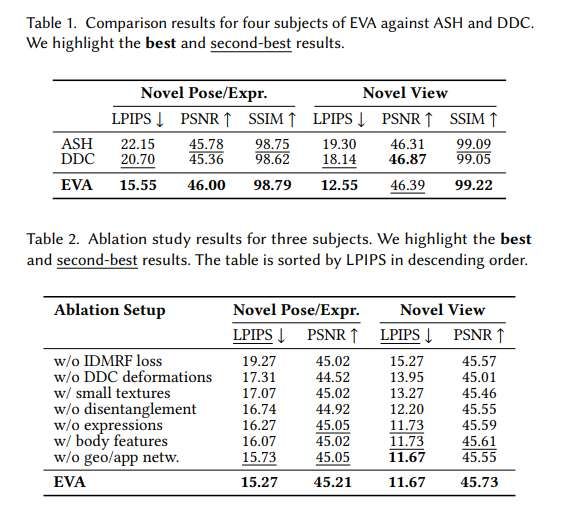

如表1所示,EVA在新視角合成以及新視角、新姿態(tài)和新表情合成方面均定量?jī)?yōu)于競(jìng)爭(zhēng)方法,但DDC在新視角合成上獲得了略高的PSNR——這可能是因?yàn)樗褂昧怂袔遣蓸訋M(jìn)行訓(xùn)練。盡管面部?jī)H出現(xiàn)在部分評(píng)估圖像中且在2K幀中占據(jù)較小區(qū)域,但他們顯式地使用面部表情信息、解耦的模型結(jié)構(gòu)和訓(xùn)練策略共同作用,在渲染質(zhì)量以及對(duì)未見過的姿態(tài)和表情的泛化能力上都帶來了顯著提升。

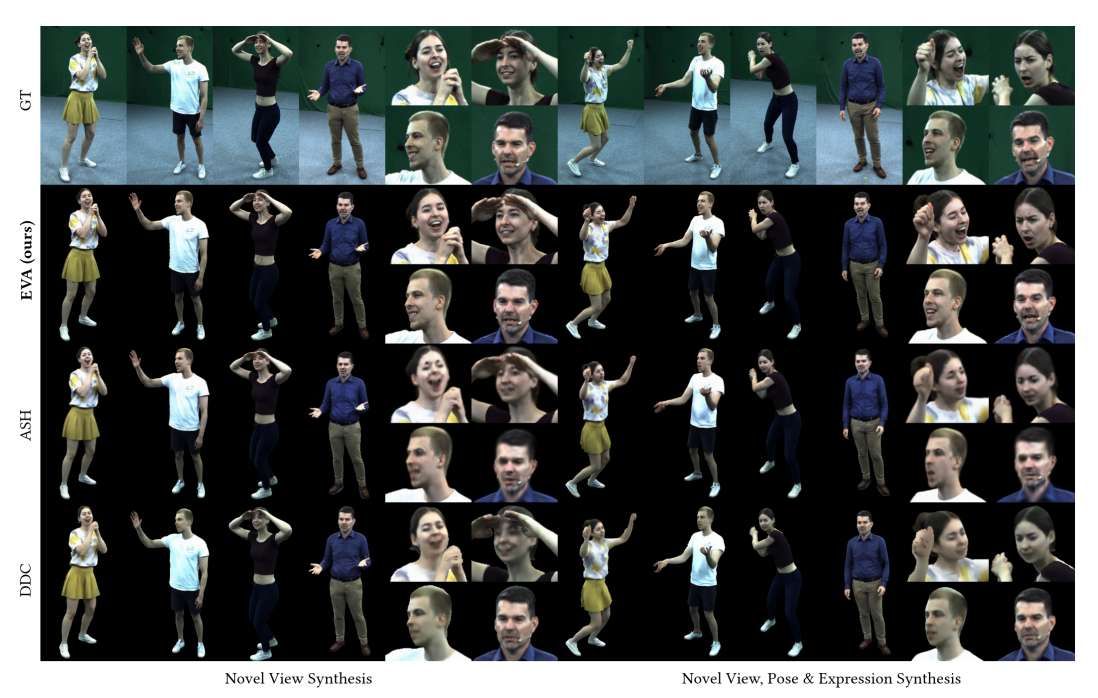

圖6中定性地比較了EVA與ASH和DDC在新視角合成以及新視角、新姿態(tài)和新表情合成方面的效果。EVA捕獲到了詳細(xì)的面部表情,而ASH和DDC未能準(zhǔn)確再現(xiàn)它們。ASH從身體姿態(tài)推斷表情,導(dǎo)致不正確的面部外觀。DDC由于缺乏3D高斯分布且依賴動(dòng)態(tài)紋理,產(chǎn)生的結(jié)果真實(shí)感較低,并遺漏了動(dòng)態(tài)細(xì)節(jié)。兩種方法都因缺乏面部表情建模而產(chǎn)生帶有偽影的模糊結(jié)果。最后,ASH容易過擬合,而團(tuán)隊(duì)的方法通過解耦和有效的正則化克服了這一限制。

他們進(jìn)行了多項(xiàng)消融研究,以評(píng)估關(guān)鍵設(shè)計(jì)選擇和訓(xùn)練組件的貢獻(xiàn)。消融設(shè)置包括:(1) 不含IDMRF損失的模型;(2) 不含運(yùn)動(dòng)相關(guān)DDC變形(僅由蒙皮模板網(wǎng)格驅(qū)動(dòng))的模型;(3) 紋理嵌入尺寸更小的版本(面部64×64,身體128×128);(4) 未顯式解耦頭部和身體的模型;(5) 不以表情參數(shù)作為輸入的變體;(6) 為頭部外觀預(yù)測(cè)添加額外身體特征作為輸入的變體;(7) 未分離幾何和外觀U-Net的版本。

表2使用LPIPS和PSNR指標(biāo),對(duì)這些消融設(shè)置在新視角合成以及新視角、新姿態(tài)和新表情合成方面進(jìn)行了定量比較。EVA在所有消融變體上表現(xiàn)最優(yōu)。值得注意的是,未解耦的變體以及添加了額外身體特征的變體在定量性能上有所下降,因?yàn)榫W(wǎng)絡(luò)常常學(xué)習(xí)面部表情與身體運(yùn)動(dòng)之間錯(cuò)誤的相關(guān)性,而非正確的解耦行為。另外,缺少IDMRF損失會(huì)導(dǎo)致感知質(zhì)量顯著下降。

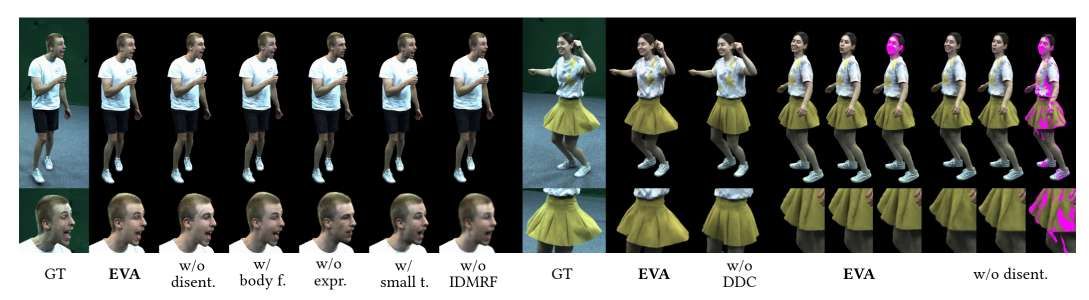

圖7展示了消融研究的定性結(jié)果。完整的EVA模型比缺乏解耦或在頭部外觀預(yù)測(cè)中引入額外身體特征的變體產(chǎn)生了更高質(zhì)量的結(jié)果。同時(shí),模型能夠獨(dú)立改變面部表情和身體姿態(tài)而不影響另一方,突顯了所提出方法的表達(dá)能力。相比之下,沒有面部表情輸入的消融設(shè)置無法準(zhǔn)確重建面部外觀,而紋理嵌入尺寸較小或缺少IDMRF損失的變體產(chǎn)生了明顯更模糊的結(jié)果,進(jìn)一步強(qiáng)調(diào)了這些設(shè)計(jì)選擇的重要性。重要的是,缺少學(xué)習(xí)到的DDC變形的變體無法重建寬松的衣物。

當(dāng)然,EVA在富有表現(xiàn)力人體的逼真渲染方面邁出了重要一步,但依然存在一定的局限性。首先,其基于網(wǎng)格的表征無法處理拓?fù)浣Y(jié)構(gòu)變化。未來的研究可以探索分層表示(如可學(xué)習(xí)的衣物層)以獲得更大的靈活性。EVA同時(shí)固定了描述身體的高斯數(shù)量,限制了多尺度渲染。分層高斯模型可能同時(shí)提供全局結(jié)構(gòu)和精細(xì)細(xì)節(jié)。為頭部和身體使用分離的高斯紋理可能在頸部造成輕微的視覺不一致。在邊界添加一致性損失可能有幫助。而且,當(dāng)前的獨(dú)立預(yù)測(cè)無法建模跨區(qū)域的照明或陰影。光照通過潛在表示建模,受限于訓(xùn)練時(shí)工作室的照明條件。未來可能受益于將基于物理的渲染與富有表現(xiàn)力的全身化身相結(jié)合。

相關(guān)論文:EVA: Expressive Virtual Avatars from Multi-view Videos

https://arxiv.org/pdf/2505.15385

總的來說,EVA是一種用于實(shí)時(shí)、高質(zhì)量且富有表現(xiàn)力的人類化身渲染的新方法。EVA在實(shí)現(xiàn)卓越真實(shí)感的同時(shí),提供了對(duì)化身表情和骨骼運(yùn)動(dòng)的完全控制。其核心在于,EVA利用了一個(gè)富有表現(xiàn)力的人體模板:它集成了面部、手部和身體控制,并結(jié)合了分布在化身表面的3D高斯分布。為了確保對(duì)面部表情和身體姿態(tài)的精確且獨(dú)立的控制,團(tuán)隊(duì)引入了對(duì)身體和頭部的3D高斯預(yù)測(cè)進(jìn)行顯式解耦。研究人員相信,EVA為XR環(huán)境等用例的未來研究和創(chuàng)新奠定了堅(jiān)實(shí)的基礎(chǔ)。