查看引用/信息源請點擊:中國AI網

反向透視

(中國AI網 2025年09月15日)VR頭顯作為數字生態演進的核心組成,它存在一個關鍵挑戰:遮擋用戶眼睛及部分面部區域的特征會阻礙視覺交流,并可能加劇社交隔離。為應對這一問題,新澤西理工學院和中佛羅里達大學團隊提出了RevAvatar。這種創新框架通過運用人工智能方法實現反向透視技術,從而重塑VR頭顯的設計與交互范式。

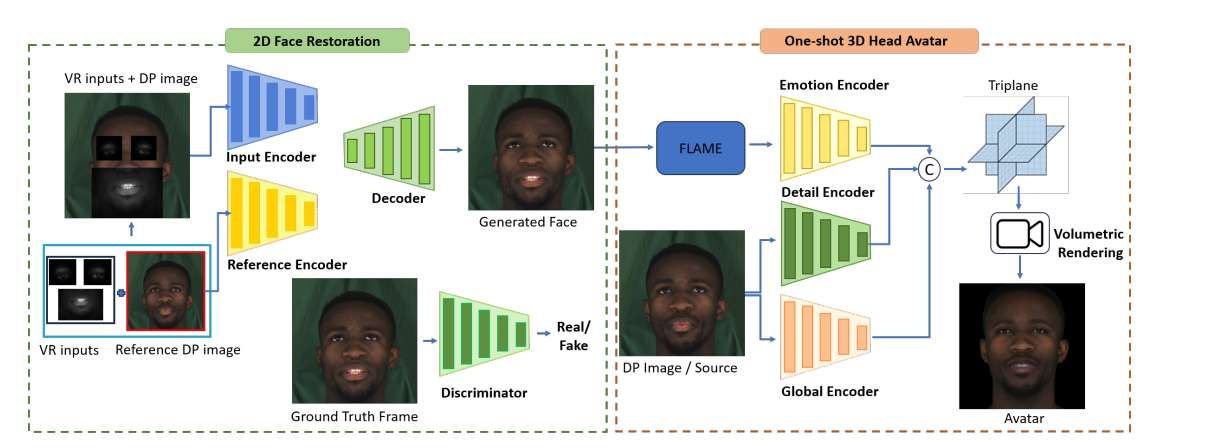

框架集成尖端生成模型與多模態AI技術,能夠根據部分可見的眼部及下半面部區域重建高保真度2D面部圖像,并生成精確的3D頭部虛擬化身。這一突破性進展旨在打通虛擬與物理環境的無縫交互,為VR會議及社交活動等沉浸式體驗奠定基礎。另外,研究人員發布了VR-Face數據集,這個數據集包含20萬個模擬多樣化VR特定條件(如遮擋、光照變化和畸變)的樣本。通過攻克當前VR系統的根本性局限,RevAvatar詮釋了人工智能與新一代技術間的變革性協同效應,為增強虛擬環境中的人際連接與交互提供了強大平臺。

AR與VR已成為改變游戲、遠程協作、教育和醫療等行業的關鍵技術進展。作為沉浸式技術,它們重塑人機界面與數字體驗,開啟新型交互與參與模式。盡管VR頭顯已成為主流消費科技產品,其固有特性卻將用戶與周圍環境隔離,限制了其在共享環境與公共空間中的融合。

眼神交流是人類情感連接的核心,但現有VR頭顯遮蔽用戶眼部與面部表情,切斷了與現實世界的視覺交互。這種透明度的缺失不僅削弱社交臨場感,同時令到旁觀者無法感知用戶對VR內容的投入度或專注狀態。解決這一根本局限需要變革性AI驅動方案來彌合虛擬與物理環境的鴻溝。

反向透視技術正是這類方案之一,它通過重建并顯示用戶眼部與面部表情于頭顯外表面,使旁觀者能實時感知眼神運動與情感表達,有效連通虛擬與物理世界。現有緩解VR隔離的方案雖致力于維持社交臨場感,卻存在眼神運動失真、硬件要求高、面部重建受限及性能不足等問題。另外,盡管照片級虛擬化身生成技術已顯著提升真實感,但其依賴多視角圖像或專用VR頭顯的特性限制了應用。個性化虛擬形象生成則因高度定制需求而難以普及。

為突破當前VR系統局限,新澤西理工學院和中佛羅里達大學團隊提出RevAvatar框架。這個框架僅需最小程度的設備特定微調即可適配不同VR頭顯。與現有方案不同,RevAvatar利用先進AI技術實時重建并顯示用戶眼部與面部表情,打破VR頭顯造成的隔離,實現虛擬與物理環境的無縫交互。

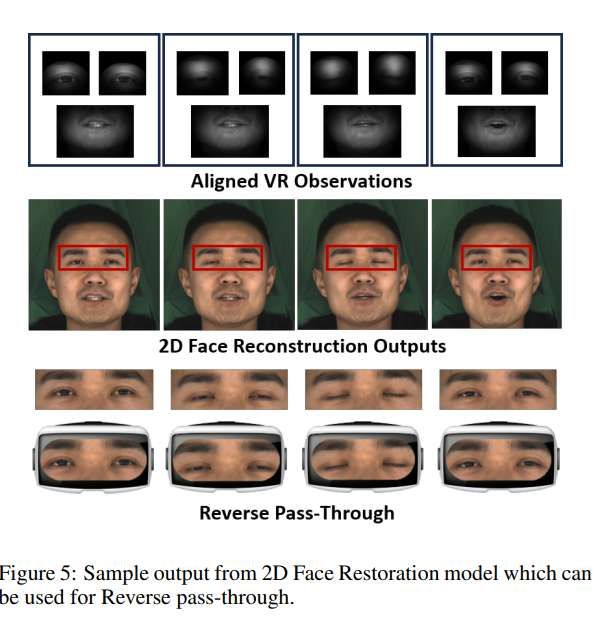

同時,它支持全頭部3D虛擬化身生成,增強虛擬會議等應用的沉浸體驗。其核心流程結合實時2D面部修復(實現”反向透視”)與單樣本3D虛擬形象生成模型,在蘋果M2等移動系統芯片上達到0.008秒推理速度,并兼容消費級混合現實設備。關鍵的是,它無需3D掃描,僅需一張類似自拍的數字化身圖像,極大提升可用性與便捷性。

由于蘋果、三星、Meta和Varjo等品牌設備的攝像頭規格與位置存在差異,開發通用解決方案極具挑戰。為此,團隊推出了VR-Face數據集,包含20萬個模擬多種VR條件(遮擋、光照變化、畸變)的樣本。這個數據集不僅支持RevAvatar開發,更為AI驅動VR技術研究提供基礎資源。

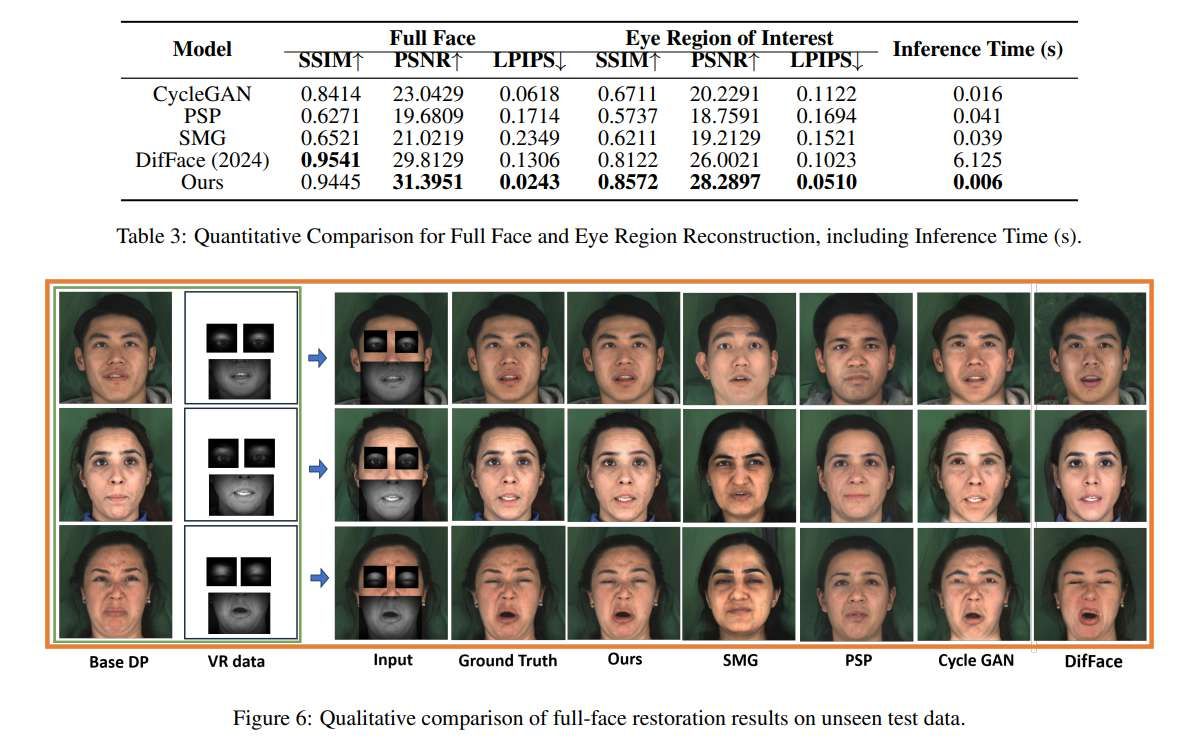

針對2D面部重建模型與虛擬形象,生成512x分辨率圖像,并使用SSIM、PSNR和LPIPS三項指標與真實圖像進行對比評估。相關指標通過結構相似性、像素級差異和感知相關性衡量視覺精度與感知質量。

圖6與表3展示了模型與基線方法的定性與定量對比。盡管采用輕量化設計,但團隊提出的模型依然優于其他基線。CycleGAN雖與其他基于GAN的模型表現相當,但在眼部與下面部的著色與融合上存在嚴重偽影(圖6)。

基于StyleGAN的PSP與SMG模型將輸入映射至潛空間,導致身份特征丟失與重建失真。測試中,SMG傾向于輸出訓練集相似圖像但改變表情,而PSP輸出常偏離真實值(圖6),暴露了StyleGAN類模型對未見數據泛化能力差的缺陷。基于擴散模型的DifFace在全臉重建中獲得高SSIM與PSNR,在保持全局面部結構上優于其他基線,但難以保留個體身份特征,導致面部細微偏移,且擴散過程的迭代特性致使其推理時間過長,難以滿足實時需求。

相比之下,團隊提出的模型對未見面部圖像表現出卓越泛化能力,獲得最高PSNR與最低LPIPS,顯示更優感知質量與清晰度,其推理速度較DifFace快數個量級,極具實時應用效率。圖5展示了本模型如何通過輸出實現VR應用中的實時反向透視功能。

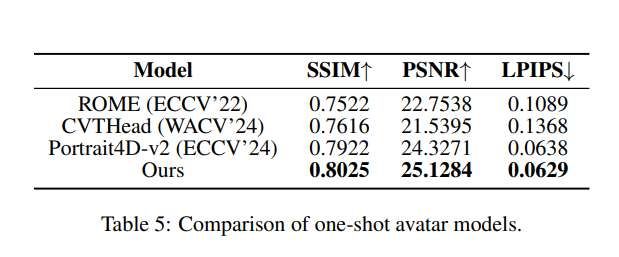

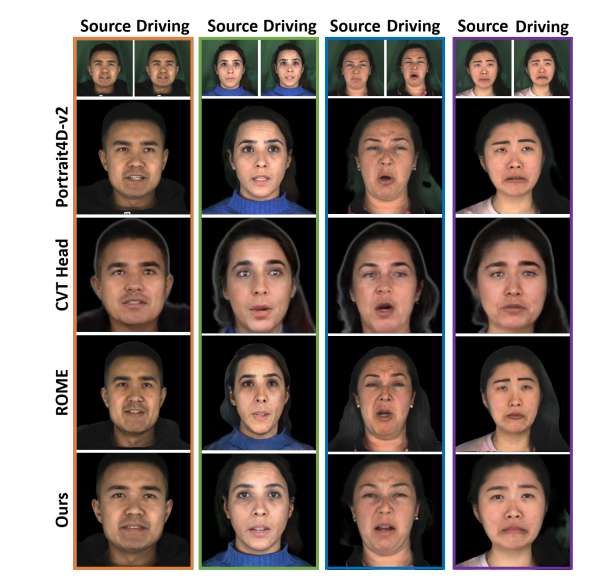

在3D虛擬形象生成方面,對比渲染圖像與真實圖像。如表5所示,模型在關鍵指標上顯著提升,獲得最高SSIM與PSNR及最低LPIPS,表明其在結構完整性與感知質量上均表現優異。高SSIM反映模型捕捉細節與面部特征的準確性,高PSNR凸顯其最小化重建噪點與偽影的魯棒性,低LPIPS則說明輸出圖像在感知上更接近真實值,確保高保真3D虛擬形象的真實紋理。

盡管Portrait4D-v2表現接近本模型,但其輸出在眨眼時存在明顯抖動影響真實感。ROME與CVTHead在保持面部身份特征上困難較大(表現為高LPIPS與低SSIM),其中CVTHead在不同姿態下難以維持身份一致性(圖7)。相比之下,團隊提出的方法有效保留身份特征,生成視覺精確且忠于原貌的虛擬形象,彰顯了模型對多樣化輸入生成高質量3D虛擬形象的卓越泛化能力。

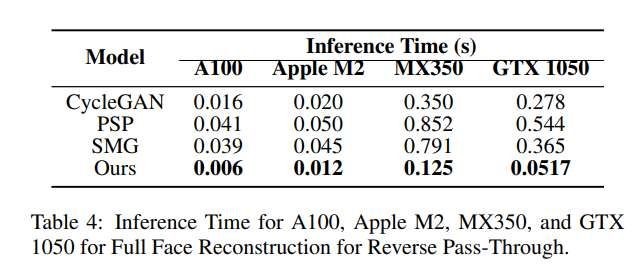

為評估2D面部重建模型在Apple Vision Pro(M2芯片)與Meta Quest 3等VR頭顯實現反向透視的實時性能,在A100 GPU(訓練環境)與Apple M2 SoC以及NVIDIA MX350與GTX1050上測試推理時間。表4顯示,搭載MPS加速的Apple M2推理時間與A100相當,證明其能高效實時運行復雜模型。架構較舊的NVIDIA MX350與GTX1050同樣展現出不錯的模型推理性能。

表6展示了消融實驗的定量結果。結果顯示Cycle-GAN優于AE,帶來更佳重建質量。當參考特征與輸入特征僅拼接而非使用交叉注意力時,模型性能顯著下降,凸顯交叉注意力對捕捉細節以精確重建的重要性。省略參考圖像導致性能降低,因模型難以準確重建遮擋區域(這對真實面部修復至關重要)。缺少上下文信息阻礙模型恢復輸入中被遮擋的面部特征。排除LPIPS損失會降低生成圖像的感知質量(LP分數上升),包含所述損失可通過優化人類感知而非僅像素相似性,幫助模型生成視覺更準確、感知更一致的重建結果。

相關論文:Eye-See-You: Reverse Pass-Through VR and Head Avatars

https://arxiv.org/pdf/2505.18869

總的來說,RevAvatar這一AI驅動方案通過使用用戶DP圖像從追蹤攝像頭恢復全臉圖像,并在VR頭顯外屏實時顯示眼部運動,緩解了VR頭顯引發的社交隔離。同時,RevAvatar支持生成逼真的單樣本全頭部虛擬形象,可用于VR會議與交互。借助RevAvatar與VR-Face,團隊希望為AI驅動VR體驗樹立新基準,增強社交臨場感與沉浸感。