查看引用/信息源請點擊:中國AI網

從極稀疏輸入視角實現360度場景的新視角合成

(中國AI網 2025年09月17日)從極稀疏輸入視角實現360度場景的新視角合成對于虛擬現實和增強現實等應用至關重要。在一項研究中,比利時根特大學和英國鄧迪大學團隊提出一種針對極稀疏視角情況的新視角合成框架。

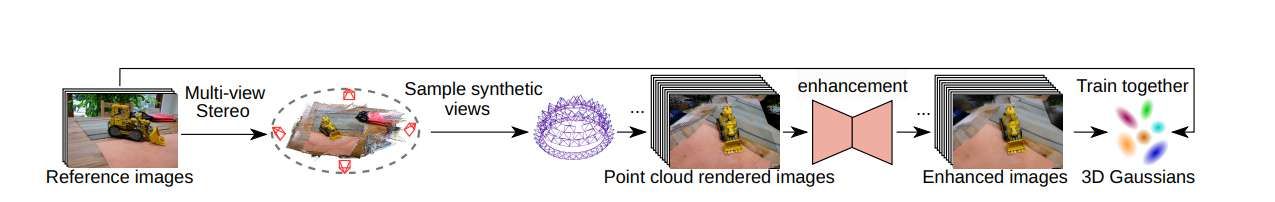

由于傳統SfM方法在極稀疏視角下無法有效估計camera位姿,研究人員采用DUSt3R進行camera位姿估計并生成稠密點云。利用估計的camera位姿,從場景上半球空間密集采樣額外視角,并結合點云渲染合成圖像。通過將稀疏視角的參考圖像與密集采樣的合成圖像相結合來訓練3DGS模型,可擴大三維空間的場景覆蓋范圍,從而解決稀疏視角情況下因輸入有限導致的過擬合問題。

基于自建數據集重訓練擴散模型驅動的圖像增強模型,并通過去除偽影進一步提升了點云渲染圖像的質量。在僅使用四個輸入視角的極端條件下,團隊將所提出框架與基準方法進行比較,而結果表明其在360度場景的極稀疏視角新視角合成方面具有顯著提升。

新視角合成(NVS)是計算機視覺領域的核心挑戰,側重于從未觀測視角渲染圖像。神經輻射場NeRF和3DGS等最新進展已證明利用場景的密集采集圖像生成新視角的強大能力。然而,獲取數百至數千張高度重疊的場景圖像通常耗時且不切實際,尤其對于需要隨時重新采集的大規模場景。

所以,開發從稀疏視角高效重建三維場景的方法日益受到關注。在稀疏視角情況下,NeRF和3DGS常因輸入有限而過擬合,導致嚴重視覺偽影和結構失準。為解決此問題,現有方法提出將基于擴散模型的方法融入NVS流程,以利用其生成能力。

這些方法可分為三類:第一類使用預訓練擴散模型知識并通過分數蒸餾采樣損失指導NVS訓練,但其在極稀疏視角下效果仍不理想;第二類通過在大規模多視角數據集上訓練二維擴散模型生成新視角合成圖像,并將合成圖像與參考圖像聯合訓練三維模型。這類方法需基于大規模數據集從頭訓練,成本高昂且生成圖像可能包含場景原有內容之外的元素;第三類通過微調擴散模型提升NVS渲染圖像質量,并將其作為額外訓練數據。這類方法依賴真實相機位姿,而在極稀疏視角下傳統SfM方法難以準確估計位姿。

在一項研究中,比利時根特大學和英國鄧迪大學團隊提出一種專為極稀疏視角(僅四個輸入)重建360度場景的新框架。他們采用訓練和渲染高效的3DGS作為核心三維表示方法。為解決極稀疏視角下的位姿估計問題,使用DUSt3R估計camera位姿并生成場景稠密點云。

通過從上半球空間密集采樣視角,利用采樣camera位姿和生成的點云渲染額外訓練圖像,從而擴展三維空間的視角覆蓋范圍。與現有方法沿輸入camera軌跡采樣不同,所提出方法從三維空間提供更全面的場景外觀與幾何信息以訓練3DGS模型。隨后,使用基于擴散模型的圖像增強模型去除點云渲染圖像中的偽影。

通過在團隊構建的數據集上重訓練模型,所述方法利用擴散模型的生成能力提升圖像質量,且不引入新內容。3DGS模型結合稀疏視角參考圖像與密集采樣合成圖像進行訓練,能夠利用更多場景外觀與幾何信息,從而提升極稀疏視角下的性能。

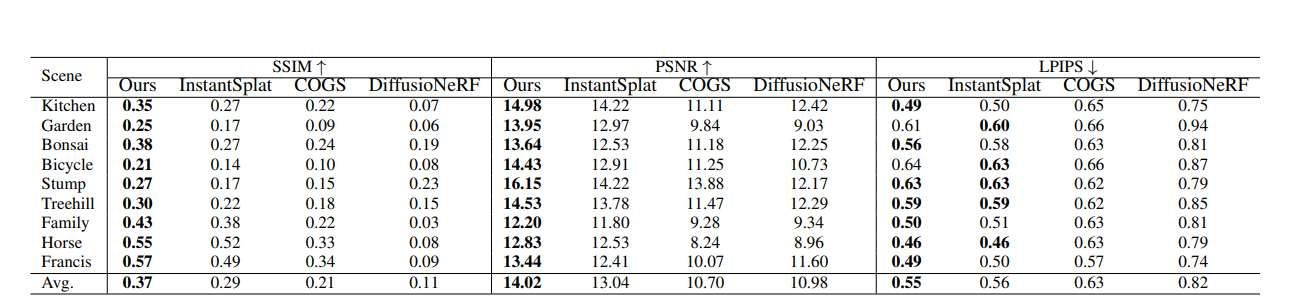

團隊將所提方法與兩種最先進的稀疏視角免位姿方法InstantSplatCOGS進行比較,同時對比了使用COLMAP真實位姿的擴散式NVS技術DiffusioNeRF。定量對比結果(表1)表明所提出方法在所有指標上均優于基準方法:相較InstantSplat,PSNR提升0.98,SSIM提升0.08,LPIPS微增0.01。

定性對比結果(圖2)顯示:DiffusioNeRF因廣角圖像間難以建立對應關系導致幾何模糊,無法有效重建極稀疏視角下的360度場景;COGS因無法準確估計360度場景的相機位姿,導致測試圖像渲染視角錯誤;InstantSplat與所提出方法均利用DUSt3R生成位姿和點云,能有效處理360度場景,而所提出方法通過上半球采樣合成圖像引入更多場景幾何與外觀信息,性能更優。盡管點云未覆蓋的大面積背景區域導致結果中存在空白,但所提出方法仍超越所有基準方法。

研究人員通過消融研究評估各組件的貢獻(表2報告各場景平均指標)。以僅使用參考圖像訓練的InstantSplat為基線,添加合成圖像訓練使PSNR顯著提升0.54;結合感知損失LP和距離加權λ(π)后,PSNR和SSIM進一步分別提升0.19和0.02;增加圖像增強步驟后PSNR再提升0.25。對比沿camera軌跡采樣視角的方法(表3),上半球采樣策略使PSNR和SSIM分別提升0.18和0.01。在DiffBIR框架內重訓練SwinIR模型時(表4),采用MSE損失與上下文損失組合比單用MSE損失顯著提升所有指標(PSNR+0.53,SSIM+0.02,LPIPS-0.01),證明上下文損失能有效處理點云渲染圖像與參考圖像間的錯位問題。

相關論文:Improving Novel view synthesis of 360 Scenes in Extremely Sparse Views by Jointly Training Hemisphere Sampled Synthetic Images

https://arxiv.org/pdf/2505.19264

總的來說,團隊提出了一個提升3DGS在極稀疏視角360度場景中性能的框架,其通過結合參考圖像與基于上半球采樣位姿和DUSt3R點云生成的合成圖像進行訓練,并采用重訓練擴散模型去除合成圖像偽影。實驗證明該方法優于現有基準方法。未來工作將集中于提升輸入點云的完整性與質量,優化點云幾何信息對NVS性能的影響,并探索基于擴散模型的修復技術以增強點云渲染圖像質量。