查看引用/信息源請點擊:中國AI網

實現端到端的場景生成和重建

(中國AI網 2025年09月26日)虛擬現實等應用通常需要能夠對用戶可沿自定義camera軌跡探索的3D場景進行建模。盡管從文本或圖像生成3D對象已取得顯著進展,但創建長距離、3D一致、可探索的3D場景依然是一個復雜且具有挑戰性的問題。在一項研究中,哈爾濱工業大學,東南大學,騰訊和香港城市大學團隊提出了Voyager。這種新穎的視頻擴散框架能夠根據單張圖像和用戶定義的camera路徑,生成世界一致的3D點云序列。

與現有方法不同,Voyager實現了端到端的場景生成和重建,具有幀間固有的一致性,無需依賴3D重建流程(例如運動恢復結構或多視圖立體視覺)。所提出方法集成了三個關鍵組件:

1) 世界一致視頻擴散:一個統一的架構,聯合生成對齊的RGB和深度視頻序列,并以現有世界觀測為條件以確保全局連貫性;2) 長距離世界探索:一個帶有點剔除功能的高效世界緩存,以及具有平滑視頻采樣的自回歸推理,用于實現具有上下文感知一致性的迭代式場景擴展;

3) 可擴展數據引擎:一個用于自動化任意視頻的相機姿態估計和度量深度預測的視頻重建流程,無需手動3D標注即可實現大規模、多樣化的訓練數據整理。

總的來說,所述設計在視覺質量和幾何精度上相比現有方法取得了明顯提升,并具有廣泛的應用。

創建用戶能夠無縫導航的高保真、可探索3D場景,為虛擬現實等廣泛應用提供了動力。然而,構建這類3D世界的傳統工作流程依然受限于人工操作,需要耗費大量精力進行布局設計、資源管理和場景合成。盡管最近的數據驅動方法在生成對象或簡單場景方面顯示出潛力,但它們擴展到復雜場景的能力受到高質量3D場景數據稀缺的限制。這一差距凸顯了對能夠實現具有3D一致性的、用戶可導航虛擬世界可擴展生成的框架的需求。

最近,越來越多的研究探索了使用新穎視圖合成NVS和視頻生成作為世界建模的替代范式。這些方法雖然在生成視覺吸引人且語義豐富的內容方面展示了令人印象深刻的能力,但依然面臨幾個挑戰:

1) 長距離空間不一致性:由于缺乏顯式的3D結構基礎,它們在生成過程中往往難以保持空間一致性和連貫的視點轉換,尤其是在生成具有長距離camera軌跡的視頻時。

2) 視覺幻象:盡管有的研究嘗試利用3D條件來增強幾何一致性,但它們通常依賴部分RGB圖像作為指導,即從輸入視圖重建的點云渲染出的新視角圖像。然而,這種表示可能在復雜場景中引入顯著的視覺幻象,例如圖2中不正確的遮擋,這可能會在訓練期間引入不準確的監督。

3) 事后3D重建:雖然這些方法可以合成視覺上令人滿意的內容,但仍需要進行事后3D重建以獲得可用的3D內容。這個過程耗時且不可避免地會引入幾何偽影。

為了應對上述挑戰,哈爾濱工業大學,東南大學,騰訊和香港城市大學團隊提出提出了Voyager,一個旨在從單張圖像和用戶指定的相機軌跡合成長距離、世界一致的RGB-D(深度)視頻的框架。Voyager的核心是一個新穎的世界一致視頻擴散模型,它利用可擴展的世界緩存機制來確保空間一致性并避免視覺幻象。

從一張圖像開始,通過使用深度圖將其反投影到3D空間來構建初始世界緩存。然后,將這個3D緩存投影到目標camera視圖中以獲得部分RGB-D觀測,這可以指導擴散模型保持與累積世界狀態的一致性。關鍵的是,生成的幀會反饋回來更新和擴展世界緩存,創建一個閉環系統,支持任意camera軌跡,同時保持幾何連貫性。

與僅依賴RGB條件的方法不同,Voyager顯式地利用深度信息作為空間先驗,從而在視頻生成過程中實現更準確的3D一致性。通過同時生成對齊的RGB和深度序列,框架支持直接的3D場景重建,無需額外的3D重建步驟(如運動恢復結構)。

盡管性能前景看好,擴散模型難以單次生成長視頻。為了實現長距離世界探索,研究人員提出了世界緩存方案和平滑視頻采樣用于自回歸場景擴展。世界緩存累積并維護所有先前生成幀的點云,隨著視頻序列的增長而擴展。為了優化計算效率,他們設計了一種點剔除方法,通過實時渲染檢測并移除冗余點,從而最小化內存開銷。利用緩存的點云作為代理,團隊開發了一種平滑采樣策略,可以自回歸地擴展視頻長度,同時確保片段之間的平滑過渡。

訓練這樣的模型需要具有準確camera姿態和深度的大規模視頻,但現有數據集通常缺乏這些標注。為了解決這個問題,引入一個用于可擴展視頻重建的數據引擎,而它可自動估計任意場景視頻的camera姿態和度量深度。通過度量深度估計,數據引擎確保了不同來源的深度尺度一致,從而能夠生成高質量的訓練數據。使用這個流程,團隊編譯了一個包含超過100,000個視頻片段的數據集,結合了真實世界捕獲和合成的Unreal Engine渲染內容。

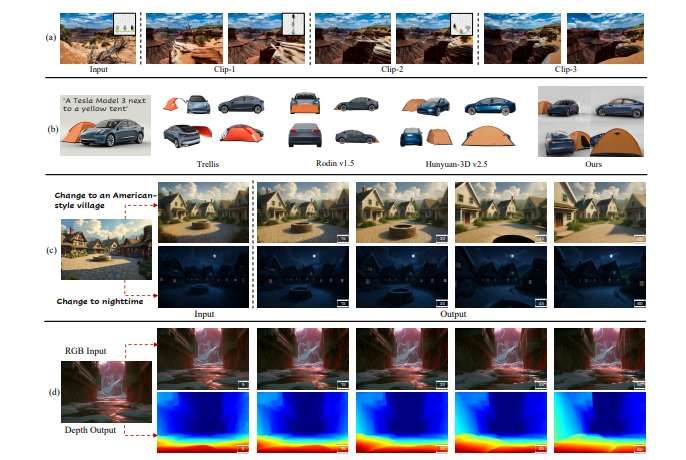

大量實驗證明了Voyager在場景視頻生成和3D世界重建方面的有效性。受益于聯合深度建模,圖1中的結果展示了更連貫的幾何結構,這不僅支持直接的3D重建,而且支持無限的世界擴展,同時保留原始空間布局。另外,團隊探索了3D生成、視頻風格遷移和深度估計等應用,進一步展示了Voyager在推進空間智能方面的潛力。

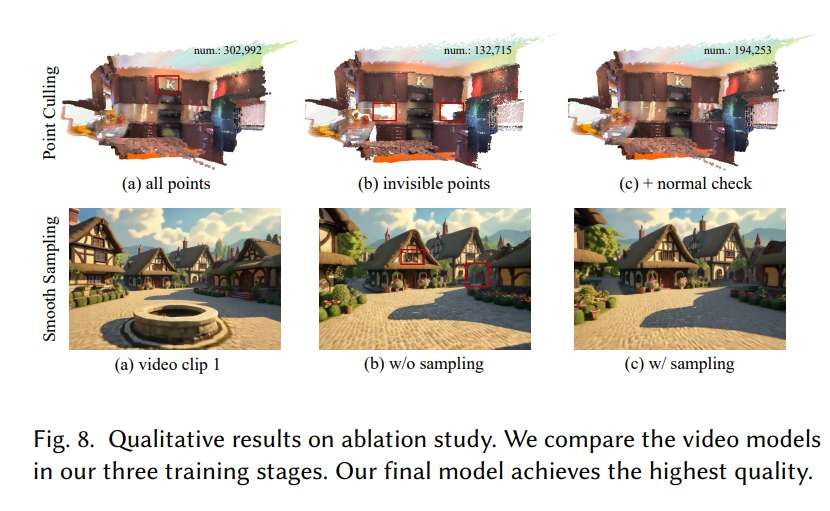

為了驗證所提出的設計的有效性,對世界一致視頻擴散和長距離世界探索進行了消融研究。

他們在Worldscore基準上分別評估了分三個階段訓練的視頻模型,即 (a) 僅在RGB條件下訓練的模型,(b) 在RGB-D條件下訓練的模型,以及 (c) 附加了額外控制塊的模型。如表4所示,在訓練中融合深度條件可以顯著增強camera控制能力。控制塊可以進一步提高生成結果的空間一致性。團隊同時在圖7中提供了定性結果。僅使用RGB的模型在camera移動到未見過區域時可能會生成不一致的內容。RGB-D模型的結果與輸入圖像更加一致,但仍可能產生一些微小的偽影。作為對比,最終模型生成了最合理的結果。

圖8中評估了點剔除和平滑采樣的質量。對于點剔除,存儲所有點會引入噪點,而存儲不可見區域中的點則不足。帶有額外法線檢查的結果與存儲所有點具有相當的視覺性能,但節省了近40%的存儲空間。對于平滑采樣,與第一個片段相比,未經采樣的視頻片段可能會出現不一致。平滑采樣確保了連續兩個片段之間的無縫過渡。

受益于融合深度的視頻生成,Voyager支持各種3D相關應用:

長視頻生成 :所提出方法通過高效的世界緩存和平滑視頻采樣實現長距離視頻生成。圖6(a)提供了一個由三個視頻片段組成的示例,各片段間的camera軌跡完全不同。結果展示了生成視頻的相機可控性和空間一致性,證明了方法能夠進行長距離世界探索。

圖像到3D生成:原生的3D生成模型很難處理多個對象的生成。在圖6(b)中,使用三種最先進的3D生成方法Trellis,Rodin v1.5和Hunyuan-3D v2.5來生成一個汽車靠在帳篷上的簡單組合。Rodin未能生成帳篷,而Trellis生成了一個有缺失部分的帳篷。Hunyuan成功生成了兩個完整的對象,但空間關系不準確,帳篷離汽車太遠。團隊提出的方法不僅生成了正確的內容,而且產生了更逼真的視覺效果。在側視圖中,帳篷甚至透過車窗可見。

深度一致視頻風格遷移:生成具有不同風格且空間一致的視頻通常需要訓練風格化視頻模型。然而,要使用模型達到預期效果,只需替換參考圖像,同時保留原始深度條件。如圖6(c)所示,可以將原始視頻更改為美式風格或夜間風格。

視頻深度估計:視頻模型天然具備估計視頻深度的能力。在圖6(d)中,預測的深度可以保留建筑上的細節。

相關論文:Voyager: Long-Range and World-Consistent Video Diffusion for Explorable 3D Scene Generation

https://arxiv.org/pdf/2506.04225

總的來說,團隊提出的Voyager是一個用于長距離世界探索的世界一致視頻生成框架。所提出的RGB-D視頻擴散模型能夠生成與輸入camera軌跡對齊的空間一致視頻序列,允許直接的3D場景重建。這支持自回歸且一致的世界擴展。實驗證明在生成的視頻和點云中都具有高視覺保真度和強空間連貫性。