查看引用/信息源請(qǐng)點(diǎn)擊:中國AI網(wǎng)

語義感知場(chǎng)景重建

(中國AI網(wǎng) 2025年10月16日)基于虛擬現(xiàn)實(shí)等新興應(yīng)用的需求,從稀疏視圖重建語義感知的3D場(chǎng)景成為一個(gè)具有挑戰(zhàn)性但至關(guān)重要的研究方向。現(xiàn)有的逐場(chǎng)景優(yōu)化方法需要密集的輸入視圖且計(jì)算成本高昂,而通用化方法往往難以重建輸入視錐范圍之外的區(qū)域。在一向研究中,清華大學(xué)團(tuán)隊(duì)提出了OGGSplat,一種通過開放高斯生長實(shí)現(xiàn)通用化3D重建視場(chǎng)擴(kuò)展的方法。

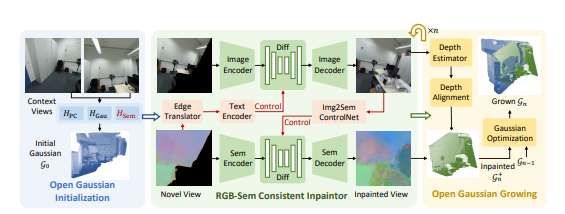

研究人員的核心洞察是:開放高斯的語義屬性為圖像外推提供了強(qiáng)先驗(yàn),既能保證語義一致性又能保持視覺合理性。具體而言,在從稀疏視圖初始化開放高斯后,引入應(yīng)用于選定渲染視圖的RGB-語義一致性修復(fù)模塊。

所述模塊通過圖像擴(kuò)散模型與語義擴(kuò)散模型實(shí)現(xiàn)雙向控制,隨后將修復(fù)區(qū)域投影回3D空間進(jìn)行高效漸進(jìn)的高斯參數(shù)優(yōu)化。為評(píng)估方法性能,團(tuán)隊(duì)建立了高斯外推基準(zhǔn)測(cè)試,從語義質(zhì)量和生成質(zhì)量兩個(gè)維度評(píng)估重建的開放詞匯場(chǎng)景。即使直接使用智能手機(jī)拍攝的兩張視圖圖像,OGGSplat都展現(xiàn)出優(yōu)秀的語義感知場(chǎng)景重建能力。

構(gòu)建具有現(xiàn)實(shí)意義且蘊(yùn)含語義信息的3D世界表征已成為計(jì)算機(jī)視覺領(lǐng)域的重要目標(biāo),這受到虛擬現(xiàn)實(shí)等應(yīng)用的驅(qū)動(dòng)。除重建生動(dòng)紋理和精確幾何結(jié)構(gòu)外,現(xiàn)代系統(tǒng)日益需要語義感知能力以支持對(duì)3D環(huán)境的高級(jí)理解與交互。這種對(duì)幾何保真度與語義可解釋性的雙重需求為場(chǎng)景表征帶來了新挑戰(zhàn)。

近期研究通常通過將開放詞匯特征與3D高斯等重建表征相結(jié)合來解決問題。基于逐場(chǎng)景優(yōu)化的方法利用密集多視圖輸入,可實(shí)現(xiàn)具有細(xì)粒度語義對(duì)齊的結(jié)構(gòu)化3D幾何。相比之下,新興的前饋方法通過訓(xùn)練好的神經(jīng)網(wǎng)絡(luò)直接從稀疏輸入視圖預(yù)測(cè)語義感知的3D表征,提升了跨場(chǎng)景的可擴(kuò)展性和泛化能力。

盡管取得顯著進(jìn)展,現(xiàn)有方法依然存在明顯局限。逐場(chǎng)景優(yōu)化方法通常需要數(shù)百張輸入視圖且計(jì)算耗時(shí)高昂(每場(chǎng)景常需25-50分鐘)。通用化方法雖能快速推理并高效處理稀疏輸入,但其性能受限于輸入視圖的有限范圍。當(dāng)處理外推視角時(shí),相關(guān)模型往往產(chǎn)生扭曲幾何和語義不合理的內(nèi)容。

這迫切需要一個(gè)能可靠擴(kuò)展視場(chǎng)、同時(shí)保持幾何連貫性與語義一致性的通用化3D重建框架。清華大學(xué)團(tuán)隊(duì)認(rèn)為,利用開放詞匯特征中的語義線索可為想象未知區(qū)域的合理內(nèi)容提供寶貴指導(dǎo),從而擴(kuò)展通用化重建的應(yīng)用邊界。

研究人員通過OGGSplat解決上述挑戰(zhàn),這是一個(gè)專為在輸入視圖覆蓋范圍外推語義化3D高斯的開放高斯生長框架。他們的目標(biāo)是增強(qiáng)開放詞匯高斯表征的能力,使其能生長出新的語義感知高斯,從而擴(kuò)展從稀疏輸入重建場(chǎng)景的視場(chǎng)。方法的關(guān)鍵在于:開放高斯固有的語義屬性為語義合理的外推提供了強(qiáng)先驗(yàn)。

為此,OGGSplat采用漸進(jìn)式高斯生長策略,基于稀疏視圖的初始重建。其核心是新穎的RGB-語義一致性修復(fù)模塊,它可以實(shí)現(xiàn)圖像與語義修復(fù)的雙向交互:語義圖指導(dǎo)圖像補(bǔ)全,而修復(fù)后的圖像反過來優(yōu)化語義特征,確保像素級(jí)對(duì)齊。合成的RGB圖像與語義圖隨后用于高效優(yōu)化新增高斯。這一策略使得OGGSplat能在計(jì)算效率與重建質(zhì)量間取得平衡,即便在輸入覆蓋極度有限的情況下也是。

研究人員在ScanNet++進(jìn)行了大量實(shí)驗(yàn),并建立了新高斯外推基準(zhǔn)測(cè)試。高斯外推基準(zhǔn)旨在評(píng)估外推區(qū)域的視覺保真度與語義合理性,采用多個(gè)先進(jìn)2D開放詞匯語義分割模型生成真值,從而在生成指標(biāo)FID之外支持分割平均交并比的量化評(píng)估。他們將OGGSplat部署于手機(jī)直接拍攝的圖像,其優(yōu)異效果凸顯了在便攜設(shè)備的應(yīng)用潛力。

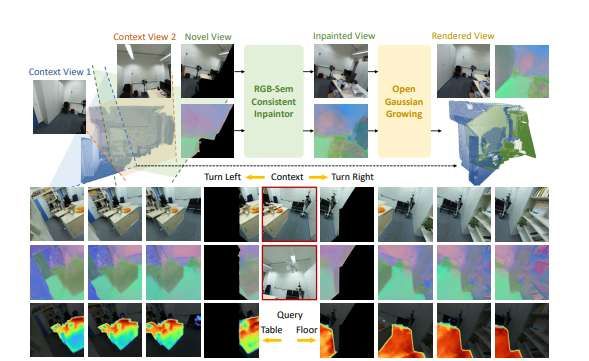

如圖2所示,OGGSplat包含三個(gè)階段:首先從稀疏輸入初始化3D高斯重建并向高斯參數(shù)注入開放詞匯語義表征;隨后引入RGB-語義一致性修復(fù)器,通過雙向控制機(jī)制確保語義與外觀的像素級(jí)對(duì)齊——語義圖指導(dǎo)圖像補(bǔ)全,修復(fù)圖像反哺語義特征優(yōu)化;最后設(shè)計(jì)漸進(jìn)式高斯生長策略使3D高斯結(jié)構(gòu)與生成內(nèi)容協(xié)同擴(kuò)展。

第二三階段迭代執(zhí)行以逐步擴(kuò)展初始視場(chǎng)外的高斯表征。實(shí)際應(yīng)用中,OGGSplat僅需兩張未標(biāo)定圖像即可通過三階段處理生成富含開放詞匯語義的擴(kuò)展3D高斯場(chǎng)景,支持從任意視角實(shí)時(shí)渲染RGB圖像及其語義特征圖。

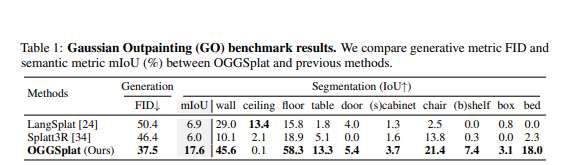

對(duì)比基線方法:選擇LangSplat(逐場(chǎng)景優(yōu)化模型)和Splatt3R(通用化模型)作為基線。LangSplat嚴(yán)重依賴COLMAP初始化,在僅有兩張輸入圖像時(shí)不可靠。為公平對(duì)比,使用Splatt3R預(yù)測(cè)的點(diǎn)云位置初始化LangSplat,使其更專注于學(xué)習(xí)語義表征。由于Splatt3R原版不支持開放詞匯語義預(yù)測(cè),為其添加訓(xùn)練的語義頭。評(píng)估時(shí),所有模型僅累計(jì)不透明度>0.01的高斯渲染區(qū)域參與IoU計(jì)算,以過濾低置信區(qū)并保證一致性。

量化對(duì)比(表1):在GO基準(zhǔn)上,OGGSplat在視覺保真度(FID)和語義合理性(mIoU)均顯著優(yōu)于基線。值得注意的是,所有方法的FID均較高,主因是驗(yàn)證集語境對(duì)數(shù)量有限(為保持掃描場(chǎng)景采樣一致性限定每場(chǎng)景10對(duì))。語義方面,OGGSplat在椅子、桌子、床等常見大物體上表現(xiàn)優(yōu)異,但在天花板類別稍弱。團(tuán)隊(duì)歸因于APE編碼局限及Splatt3R主干網(wǎng)區(qū)分顏色紋理相似的頂墻的困難,未來可通過更強(qiáng)視覺語言模型和優(yōu)越高斯重建方法解決。

定性對(duì)比(圖3):OGGSplat在新視角渲染和開放詞匯查詢均更優(yōu)。LangSplat易過擬合語境視圖導(dǎo)致新視角渲染模糊;Splatt3R在輸入視場(chǎng)外呈現(xiàn)大面積黑色;而OGGSplat借助語義信息合理外推未知區(qū)域。開放詞匯查詢中,OGGSplat能準(zhǔn)確識(shí)別并查詢未見區(qū)域物體,展現(xiàn)更強(qiáng)泛化與語義理解能力。

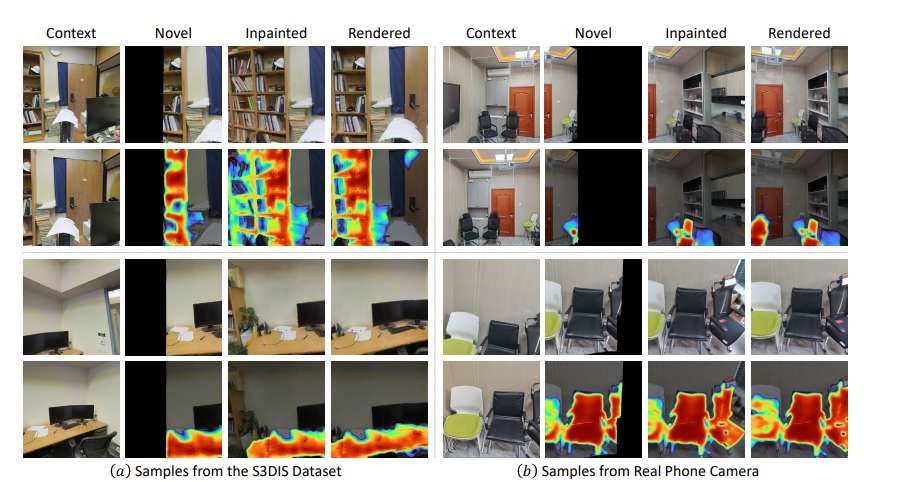

模型泛化能力:除訓(xùn)練集ScanNet++外,團(tuán)隊(duì)同時(shí)在不同分布數(shù)據(jù)上測(cè)試了OGGSplat(圖4)。使用S3DIS樣本成功重建具有擴(kuò)展視場(chǎng)的語義感知場(chǎng)景。圖4(b)列展示了手機(jī)拍攝圖像的實(shí)際應(yīng)用,椅子區(qū)域的修復(fù)圖像與語義查詢結(jié)果良好,凸顯了日常應(yīng)用潛力。

為獲取修復(fù)區(qū)域的可靠語義,研究人員訓(xùn)練了語義擴(kuò)散模塊。若直接采用離線開放詞匯分割模型(,會(huì)導(dǎo)致與原始高斯語義不一致(圖5),甚至在原正確預(yù)測(cè)區(qū)域產(chǎn)生錯(cuò)誤,進(jìn)而影響高斯生長。而團(tuán)隊(duì)提出的語義擴(kuò)散模型保持未修復(fù)區(qū)域語義一致性,并利用可見語境語義先驗(yàn)顯著提升修復(fù)區(qū)域語義準(zhǔn)確性。

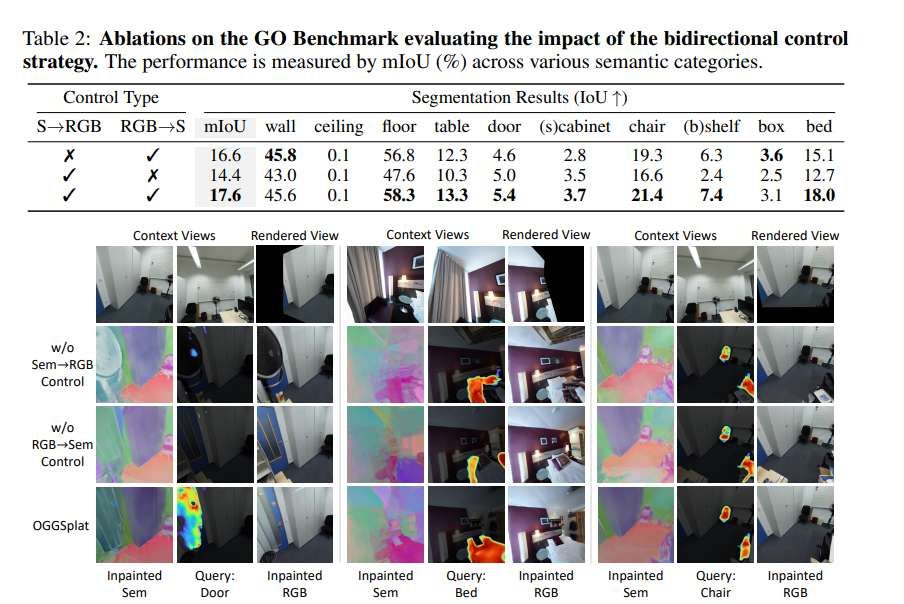

通過開放詞匯語義,設(shè)計(jì)邊緣轉(zhuǎn)換器從高斯邊界提取語義線索以指導(dǎo)圖像/特征補(bǔ)全。表2首行移除邊緣轉(zhuǎn)換器而改用通用文本提示(”a room”)后,多數(shù)類別分割性能下降。圖6定性對(duì)比顯示生成內(nèi)容更模糊且語義基礎(chǔ)更弱,驗(yàn)證了語義→RGB控制對(duì)高保真語義一致高斯生長的有效性。

OGGSplat中語義修復(fù)模型顯式受修復(fù)圖像控制。表2次行及圖6第三行移除該控制后,生成RGB圖像與語義圖空間對(duì)齊差,導(dǎo)致分割精度顯著下降。引入RGB→語義控制后明顯改善空間一致性并提升性能。

相關(guān)論文:OGGSplat: Open Gaussian Growing for Generalizable Reconstruction with Expanded Field-of-View

https://arxiv.org/pdf/2506.05204

總的來說,團(tuán)隊(duì)設(shè)計(jì)了用于擴(kuò)展視場(chǎng)的通用化重建方法OGGSplat。通過利用開放高斯的語義線索和雙向控制下的RGB-語義一致性修復(fù),所提出方法有效擴(kuò)展視場(chǎng)并確保視覺保真度與語義連貫性。通過高效高斯優(yōu)化過程漸進(jìn)細(xì)化視場(chǎng)外區(qū)域。為促進(jìn)評(píng)估,提出了高斯外推基準(zhǔn)測(cè)試以量化評(píng)估開放詞匯場(chǎng)景重建的生成與語義質(zhì)量。

大量實(shí)驗(yàn)證明OGGSplat在輸入視錐外推方面性能優(yōu)越,是通用化靈活3D重建的重要進(jìn)展。當(dāng)前OGGSplat僅適用于室內(nèi)場(chǎng)景,因室外深度估計(jì)更困難會(huì)導(dǎo)致基線模型Splatt3R性能下降。但研究人員相信,未來結(jié)合更強(qiáng)大通用化的高斯重建模型,所述方法在室外場(chǎng)景都能取得良好性能。