查看引用/信息源請點擊:中國AI網

旨在從單目視頻中進行快速且高保真的化身重建

(中國AI網 2025年10月20日)逼真且可動畫化的人體化身是虛擬現實/增強現實的關鍵使能技術。盡管3DGS的最新進展極大地提升了渲染質量和效率,現有方法依然面臨根本性挑戰,包括耗時的逐主體優化以及在稀疏單目輸入下的泛化能力差。

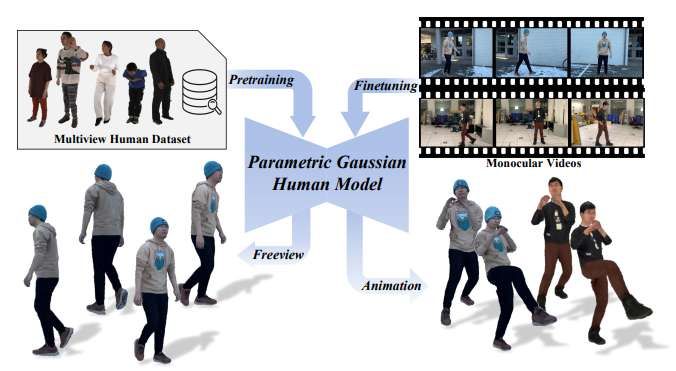

在一項研究中,清華大學和字節跳動團隊提出了參數化高斯人體模型PGHM。這是一個可泛化且高效的框架,它將人體先驗知識整合到3DGS中,旨在從單目視頻中進行快速且高保真的化身重建。

PGHM引入了兩個核心組件:

(1) 一個UV-Aligned Latent Identity Map,它將特定主體的幾何和外觀緊湊地編碼到一個可學習的特征張量中;

(2) 一個Disentangled Multi-Head U-Net,它通過條件解碼器分解靜態、姿態相關和視角相關的成分來預測高斯屬性。

這種設計能夠在具有挑戰性的姿態和視角下實現魯棒的渲染質量,同時允許高效的主體適應,而無需多視圖捕獲或漫長的優化時間。實驗表明,PGHM比從零開始的優化方法效率顯著更高,每個主體僅需約20分鐘即可產生視覺質量相當的化身,從而證明了其在實際單目化身創建中的應用潛力。

逼真且可動畫化的人體化身是2D和3D視覺中的一個關鍵研究方向,賦能虛擬現實/增強現實等應用。傳統的基于網格或基于點的人體化身分別存在根本局限性——預定義的拓撲結構和非結構化的表示——這阻礙了逼真化身的創建。近年來,盡管NeRF的出現顯著提升了人體化身的質量,但其固有的渲染速度慢和優化成本高仍然是根本性瓶頸。

最近,顯式的3DGS表示已成為一項突破性技術,它結合了加速的渲染速度和卓越的視覺質量,從而極大地促進了逼真人體化身的創建。

然而,當前的高斯化身方法依然面臨根本性挑戰。一方面,基于多視圖視頻輸入的人體化身(例如Animatable Gaussians)通過引入姿態相關的高斯圖,實現了高質量的渲染結果和姿態相關的動態效果,但每個主體需要1-2天的訓練時間。同時,多視圖輸入需要復雜的數據捕獲設備。

另一方面,基于單目輸入的化身將3DGS與SMPL-UV或SMPL-X幾何模型結合來學習姿態相關效應,但存在模糊和缺乏外觀細節的問題,因為單目輸入由于觀測不完整和訓練數據固有的局限性,往往難以泛化到多樣或未見過的姿態。

因此,要實現從單目輸入高效且高質量的人體化身,關鍵在于開發一個可泛化的參數化模型,能夠從大規模數據中學習人體先驗,同時保持3D高斯的表示優勢。清華大學和字節跳動團隊認為,將參數化人體先驗融入基于高斯的人體化身至關重要,因為它能夠通過學得的先驗實現快速的主體特定適應,并在具有挑戰性的輸入條件下實現更魯棒的性能。

在研究中,他們提出了參數化高斯人體模型Parametric Gaussian Human Model/PGHM,它從大規模數據中學習可泛化的化身先驗,同時能夠快速適應新主體。模型通過兩個關鍵設計實現這一點:

首先,引入了UV-Aligned Latent Identity Map,它將身份特定屬性(如面部特征和衣物幾何)編碼到一個緊湊的、可學習的特征張量中。這種方法不同于GaussianAvata僅依賴UV位置圖獲取姿態信息。這一設計通過利用UV-Aligned Latent Identity Map作為身份的控制信號來增強原始框架。在微調階段,可以僅優化此圖來有效捕獲個性化特征。這一方法有助于快速微調和改進的身份控制。

其次,為了更好地學習高斯屬性,提出了Disentangled Multi-Head U-Net,它通過姿態/視角條件解碼器顯式地建模靜態、動態和視角相關效應,從而在未見過的身份、多樣姿態和具有挑戰性的視角下實現一致的性能。

綜合起來,通過從結合了精選的MVHumanNet和DNA-Rendering 數據集的大型人體數據集中學習到的參數化高斯先驗,實現了魯棒且高保真的人體化身,使得能夠從單目視頻快速適應個性化化身。與同期工作Vid2Avatar-Pro 相比,所提出方法在單目輸入個性化化身的優化時間上達到了相當的水平,而Vid2Avatar-Pro每個身份還需要額外36-48小時進行網格模板重建。實驗證明,所以出方法實現了SOTA 化身渲染質量和化身訓練效率。

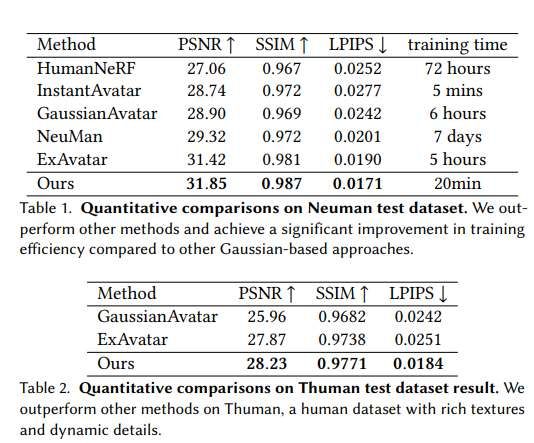

研究人員主要將所述方法與GaussianAvatar和ExAvatar進行了比較,后兩者都是基于3DGS構建人體化身的方法。為定量評估性能,采用了成熟的圖像質量指標,包括峰值信噪比(PSNR)、結構相似性指數(SSIM)和學習感知圖像塊相似度(LPIPS)。所有指標均在整張圖像上計算,背景設置為白色。在兩個基準數據集展示了定量評估結果。

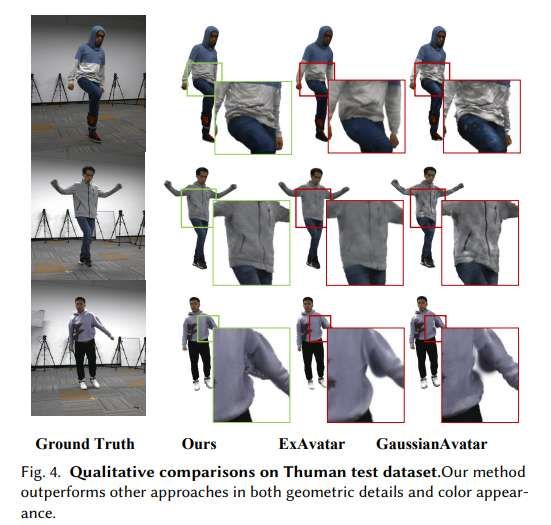

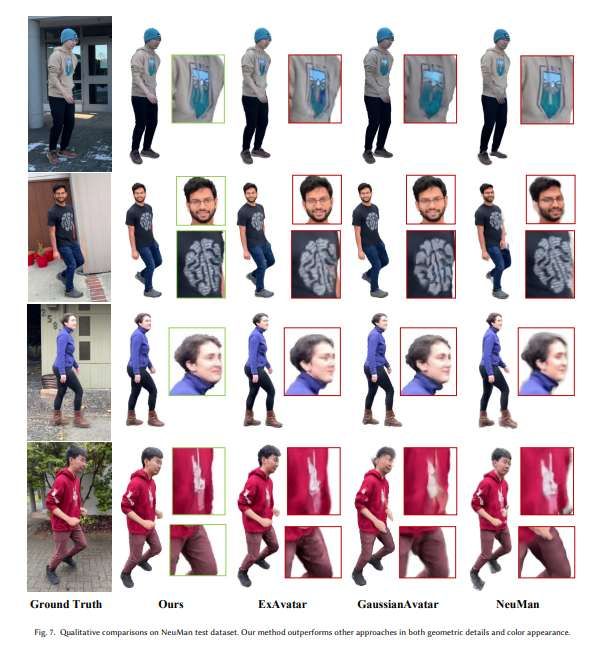

如表1和表2總結所示,所提出方法在一系列綜合指標上超越所有現有基線,展示了在恢復細粒度動態外觀細節和更合理的衣物運動方面具有卓越能力。圖7和圖4所示的定性比較證明了所述方法相對于基線方法的優勢,產生的重建結果具有顯著增強的細節保真度和準確的姿態相關動態紋理信息。

在NeuMan數據集上,ExAvatar保持了合理的細節水平,但在THuman4.0數據集上表現不佳,其性能受到復雜的正則化約束限制,導致結果過度平滑和細節模糊。相比之下,GaussianAvatar方法未能有效解耦光照和運動,導致不真實的光照偽影。所提出方法通過兩個關鍵創新解決了這些局限性:引入學習到的先驗以減少對重度正則化的依賴,有效解耦姿態和光照信息,從而產生更準確和富有表現力的重建結果。

為了進一步驗證提出的先驗和架構有效性,團隊進行了一系列消融實驗,以系統分析每個組件對我們框架整體性能的貢獻。

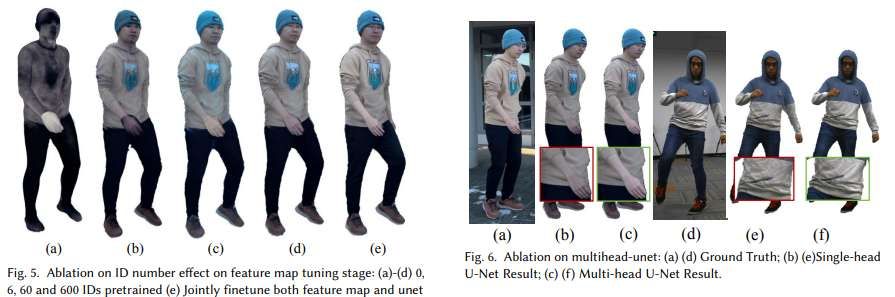

學習先驗的有效性:圖5全面分析了學習先驗的影響。子圖(a)-(d)對應于在預訓練了不同數量身份(具體為0、6、60和600個ID)的身份圖上進行微調的模型。子圖(e)展示了聯合微調身份圖和多頭U-Net后的結果。結果清楚地表明,擴大先驗訓練中使用的身份數量顯著增強了身份圖的表示能力。隨著預訓練身份數量的增加,身份圖對未見個體表現出更強的泛化能力,并在微調期間實現更快的收斂。

另外,即使只微調身份圖,重建的幾何和紋理細節也明顯更豐富、更合理,突顯了我們先驗學習策略的好處。然而,由于可用訓練數據多樣性和規模的固有局限性,需要進一步聯合微調身份圖和多頭U-Net以實現紋理和幾何的更高保真度。重要的是,可以觀察到兩階段微調方法極大地提高了訓練效率:與從頭開始訓練模型相比,所述方法使用少一個數量級的優化步數(例如,2,000步 vs 20,000步)即可獲得優異結果。

Multi-Head U-Net架構的有效性:圖6評估了Multi-Head U-Net設計在解耦姿態和光照效應方面的功效。在每組結果中,子圖(a)和(d)描繪了真ground truth;(b)和(e)顯示了單頭U-Net的輸出;而(c)和(f)展示了我們Multi-Head U-Net模型的結果。比較表明,Multi-Head U-Net顯著增強了合成輸出的真實感和準確性。具體來說,解耦外觀和光照在(c)中產生了更合理的光照,而(f)中更好地保留了更精細的動態細節(如衣物褶皺),與真實圖像非常接近。相比之下,單頭U-Net的結果(b, e)明顯更暗且缺乏關鍵的動態紋理細節,突顯了其在建模光照和精細外觀方面的局限性。這些結果強調了Multi-Head U-Net架構在生成詳細、物理一致的重建方面的優越性。

總體而言,消融研究表明,學習到的先驗和Multi-Head U-Net架構都在我們方法的成功中扮演著關鍵角色。學習到的先驗增強了身份泛化并加速了收斂,而Multi-Head U-Net則實現了姿態和光照的有效解耦,從而產生更真實、更詳細的人體重建。

相關論文:Parametric Gaussian Human Model: Generalizable Prior for Efficient and Realistic Human Avatar Modeling

https://arxiv.org/pdf/2506.06645

總的來說,PGHM是一個新穎的框架,它將參數化人體先驗集成到3D高斯飛濺中,以實現高效且高保真的單目人體化身重建。通過引UV-Aligned Latent Identity Map和Disentangled Multi-Head U-Net,PGHM能夠在具有挑戰性的姿態和視角下實現快速的主體特定適應和魯棒的渲染。與現有方法相比,所提出方法實現了高效訓練,每個主體僅需約20分鐘,同時保持有競爭力的視覺質量。

當然,所述方法目前存在兩個主要局限性。首先,它依賴于輸入視頻序列來優化身份圖,這限制了其在主體數據有限的情況下的使用。未來的工作將探索端到端的前饋架構,能夠直接從更少的圖像推斷身份特征,減少逐主體優化的需求。其次,所述方法對于穿著寬松或飄逸衣物(如裙子或長袍)的主體效果較差,這是由于建模大的非剛性變形存在挑戰。解決所述問題將使系統更加魯棒和廣泛適用。