查看引用/信息源請點擊:中國AI網(wǎng)

處理速度提升了1.5至14.48倍

(中國AI網(wǎng) 2025年10月21日)在一項研究中,印度科學(xué)學(xué)院團隊介紹了一種用于加速基于SfM的位姿估計的預(yù)處理技術(shù),并可支持增強現(xiàn)實和虛擬現(xiàn)實等實時應(yīng)用。所提出方法利用圖論中的支配集概念對SfM模型進行預(yù)處理,在保持較高精度的同時顯著提升了位姿估計的速度。

基于OnePose數(shù)據(jù)集,研究人員在多種SfM位姿估計技術(shù)上評估了本方法。實驗結(jié)果表明:處理速度提升了1.5至14.48倍,參考圖像數(shù)量和點云規(guī)模分別減少了17-23倍和2.27-4倍。這項研究為高效精準(zhǔn)的3D位姿估計提供了創(chuàng)新解決方案,實現(xiàn)了實時應(yīng)用中速度與精度的平衡。

新穎物體的精準(zhǔn)位姿估計是計算機視覺領(lǐng)域的核心任務(wù)。這項任務(wù)需要精確識別物體的位置與朝向,對于準(zhǔn)確操控物體或在增強現(xiàn)實的視頻流中疊加虛擬對象至關(guān)重要。其核心挑戰(zhàn)可簡化為:給定物體的完整3D表征,如何精準(zhǔn)定位其在圖像中的位姿?

完整的3D表征無需依賴局部模型或單張2D圖像即可實現(xiàn)精確位姿估計,從而提供更可靠的結(jié)果。物體表征方法包括RGB圖像集、RGB-D圖像集、3D模型以及SfM等。其中,基于單目攝像頭圖像重建3D結(jié)構(gòu)的SfM方法以其高精度著稱,但相比其他方法處理速度較慢,所以在需要快速決策的應(yīng)用中成為瓶頸。鑒于SfM方法的高精度特性,探索其加速策略具有迫切需求。

印度科學(xué)學(xué)院團隊提出了一種創(chuàng)新方法,利用圖論中的”支配集”概念優(yōu)化SfM表征。支配集概念常用于網(wǎng)絡(luò)理論中的資源分配與通信優(yōu)化,而他們將其應(yīng)用于SfM以提升位姿估計速度。

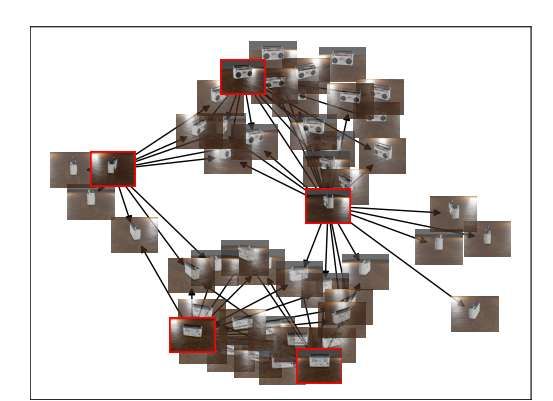

為有效應(yīng)用支配集概念(即圖論中指代節(jié)點的子集,使得圖中每個節(jié)點要么屬于該子集,要么至少與該子集中的一個節(jié)點相鄰),首先將SfM建模為圖結(jié)構(gòu)。圖中每個節(jié)點代表一張參考圖像,從參考圖像??到??的有向邊表示:在將??視為查詢圖像時,??可用于在特定定位誤差閾值內(nèi)精確估計??的位姿。圖4通過合成數(shù)據(jù)對此概念進行了可視化展示,呈現(xiàn)了支配集在SfM圖表征中的形成方式,突出顯示了支配集中的節(jié)點及展示位姿估計能力的有向邊。

如圖4所示,SfM表征的支配集可視化中:每個節(jié)點代表SfM表征中的參考圖像,紅框節(jié)點標(biāo)識支配集。有向箭頭表示一個參考節(jié)點能精準(zhǔn)檢測另一個節(jié)點位姿的能力。為清晰起見,僅顯示源自支配集的邊。采用力導(dǎo)向布局算法使參考圖像基于定位精度聚集到最近支配圖像周圍,可見每個簇中的圖像存在顯著相似性。

OnePose將查詢圖像中的2D特征描述符與SfM表征中3D點對應(yīng)的3D特征描述符匹配。使用SuperPoint特征提取器獲取SfM構(gòu)建和查詢圖像的特征描述符,3D描述符通過平均觀測同一點的各參考SfM圖像中的2D描述符計算得到。特征匹配采用提出的圖注意力網(wǎng)絡(luò)(GATs)實現(xiàn),輸出查詢圖像2D特征點與SfM表征3D點之間的2D-3D對應(yīng)關(guān)系,再通過PnP算法計算查詢圖像中的物體位姿。

對于OnePose++,類似的2D-3D匹配方法,使用無檢測器局部特征匹配器LoFTR尋找密集對應(yīng)關(guān)系,據(jù)此構(gòu)建粗糙SfM表征并細化生成用于2D點匹配的密集SfM表征。匹配器接收SfM點云和查詢圖像,輸出2D-3D匹配對,再通過PnP算法計算位姿。

窮舉匹配將每張參考圖像的特征描述符與查詢圖像進行比對,雖全面但計算密集。使用參考圖像匹配點對應(yīng)的SfM 3D點作為PnP算法的物體點,查詢圖像中的對應(yīng)2D點作為圖像點。實驗采用SuperPoint搭配SuperGlue或LightGlue作為匹配器。

支配集預(yù)處理通過最重要參考圖像減少點云中的參考圖像或點數(shù)。隨機采樣則是為驗證支配集觀測到的SfM點性能優(yōu)于隨機采樣參考圖像,對每個物體采樣與支配集相同數(shù)量的參考圖像,然后過濾SfM點和參考圖像。結(jié)果明確顯示:在相同參考圖像數(shù)量下,支配集效果優(yōu)于隨機采樣。

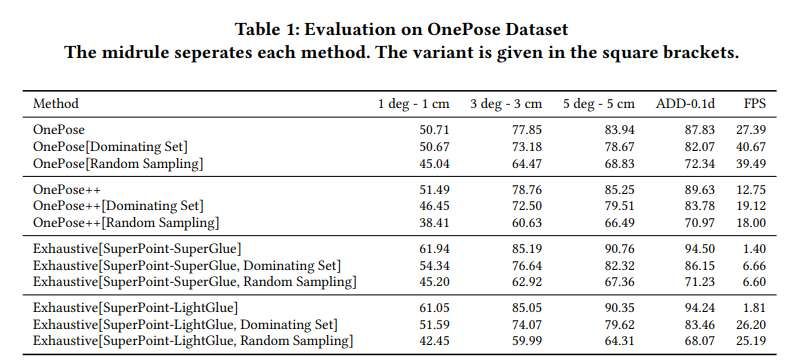

研究人員使用OnePose數(shù)據(jù)集的測試集(包含80個不同物體和301個驗證視頻)評估支配集方法及其他基線位姿估計方法。他們通過算法構(gòu)建參考圖像圖,圖中每條邊通過閾值化參考圖像對之間的位姿估計確定(通過將圖像????的2D關(guān)鍵點與圖像????的2D關(guān)鍵點對應(yīng)的3D點匹配實現(xiàn))。使用SuperPoint作為2D特征提取器,SuperGlue作為2D特征匹配器。為尋找最小支配集,迭代運行算法一千次以獲得最優(yōu)結(jié)果。確定最重要參考圖像(支配集)后,將其應(yīng)用于所有位姿估計方法進行評估。OnePose完整測試集的評估結(jié)果如表1所示,檢測位姿的邊界框可視化如圖5所示。

在所有案例中,支配集方法以微小精度代價提升了幀率。盡管隨機采樣參考圖像也提高了幀率,但未能達到支配集的性能。實驗表明:支配集方法雖未獲得最高精度,但其顯著提升的幀率表明處理速度的大幅改善。這種精度與速度的平衡對需要基于位姿估計進行快速決策的實時應(yīng)用至關(guān)重要。

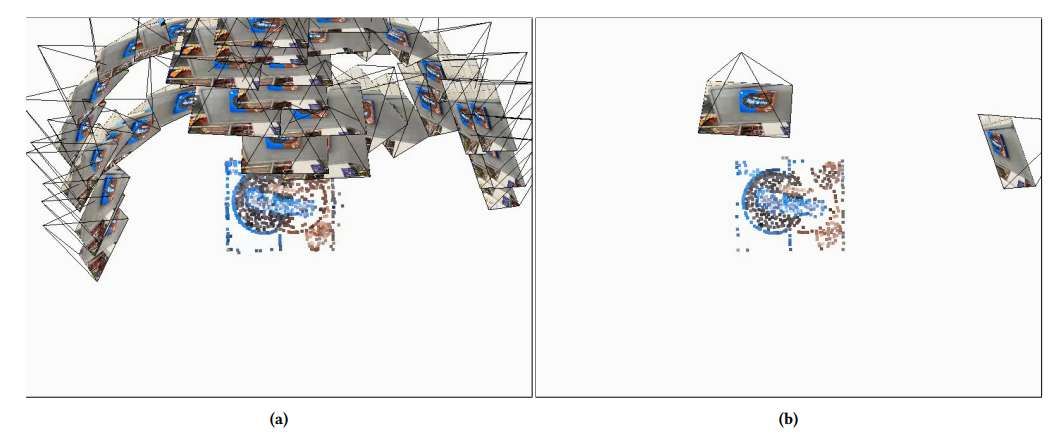

研究中間像序列的支配集規(guī)模為1到35張圖像,平均大小為3.9125。較大支配集主要源于某些序列的真值標(biāo)注誤差,因此提升真值標(biāo)注精度有望改善結(jié)果。支配集與未過濾SfM模型中參考圖像數(shù)量的平均比值為0.057(中位數(shù)0.043),相當(dāng)于減少17至23倍參考圖像。團隊檢測了經(jīng)支配集過濾的SfM點與未過濾點的比率:OnePose的平均比率為0.44(中位數(shù)0.44),縮減倍數(shù)為2.27;OnePose++的平均比率為0.26(中位數(shù)0.25),實現(xiàn)四倍縮減。

當(dāng)然,為獲得更好效果,SfM構(gòu)建的訓(xùn)練圖像應(yīng)覆蓋物體所有區(qū)域。若訓(xùn)練圖像僅覆蓋物體半球面,支配集可能移除該半球邊界圖像(示例如圖1)。當(dāng)查詢圖像僅與已移除圖像區(qū)域重疊時,精度會下降。

相關(guān)論文:Accelerating SfM-based Pose Estimation with Dominating Set

https://arxiv.org/pdf/2506.03667

總的來說,團隊探討了借助支配集提升基于SfM的物體位姿估計速度。研究表明消除冗余圖像可加速推理過程。通過將SfM表示為圖并尋找近似最小參考圖像支配集,他們實現(xiàn)了速度-精度權(quán)衡的優(yōu)化。所提出方法將所需參考圖像數(shù)量減少17-23倍,并將OnePose和OnePose++所需的點數(shù)減少2.27-4倍。未來的工作可將支配集應(yīng)用擴展至更多基于SfM的位姿估計技術(shù)。盡管減少參考圖像會輕微降低精度,但集成利用位姿估計歷史和相關(guān)狀態(tài)變化的跟蹤模塊可在保持實時性的前提下提升精度。