查看引用/信息源請點擊:中國AI網

在混合現實中實現個性化和優化的用戶界面及內容放置

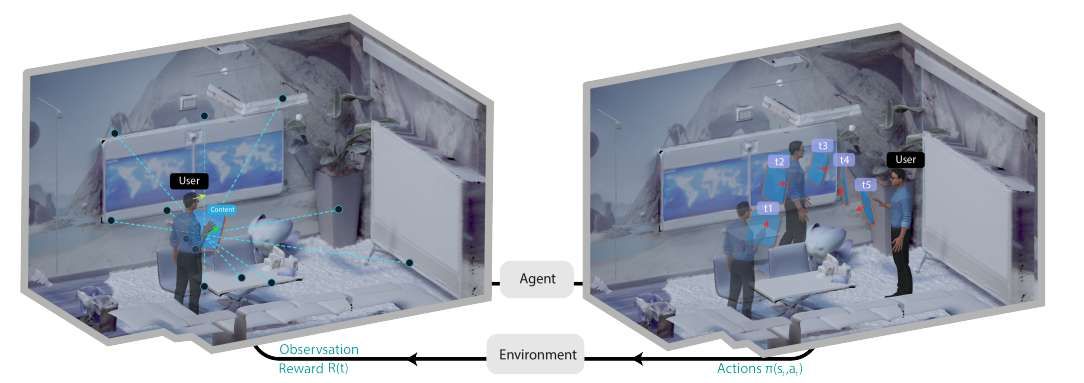

(中國AI網 2025年10月21日)混合現實能夠通過將虛擬內容持續集成到用戶對物理環境的視野中來輔助用戶完成任務。然而,由于混合現實體驗的動態特性,在何處以及如何放置這些內容以最好地支持用戶一直是一個具有挑戰性的問題。與之前基于優化方法的研究不同,摩根大通團隊正在探索強化學習(RL) 如何能夠輔助進行連續的、感知用戶姿態及其周圍環境的三維內容放置。

通過初步探索和評估,實驗的結果展示了強化學習在為用戶動態定位內容以最大化獎勵方面的潛力。研究人員進一步指出了未來研究的方向,借助強化學習的力量,在混合現實中實現個性化和優化的用戶界面及內容放置。

混合現實技術有潛力通過將數字內容普遍集成到用戶對物理環境的視野中來輔助用戶完成任務。用戶得以在各種日常任務中移動過程中持續依賴這些數字信息。然而,由于混合現實用例自由度增加和動態變化的特性,確定三維用戶界面在物理空間中的最佳位置提出了一個不小的挑戰。

由于虛擬信息可以在三維空間中的任何地方、任何時間顯示,如果設計不謹慎且未持續更新,它可能通過要求用戶不必要的注意力和手動交互(例如移動或隱藏數字內容)來妨礙現實世界的活動。當用戶處于移動狀態時,這類問題尤為突出,因為最初有用的放置位置可能在用戶改變姿勢或空間位置后失去其效用。

為了使混合現實用戶界面更好地支持用戶,存在兩個未解決的挑戰:

它們必須無縫適應動態的上下文變化,例如用戶的位置、姿勢和周圍環境,而傳統的基于規則的適應方法無法做到這一點

它們必須實時考慮多個適應目標,例如可見性、可達性和舒適性。

為了實現這種自適應的混合現實用戶界面行為,最近的研究將問題表述為多目標優化。用戶的目標表述為一組目標函數,并選擇能最大化/最小化這些目標的位置。然而,基于優化的解決方案存在兩個理論上的挑戰:

每次用戶在空間中移動時都需要重新進行優化,這可能導致較高的計算成本且效率低下;

這些解決方案可能難以泛化到其他環境或用戶移動模式,需要重新配置或修改目標和約束。

在這項研究中,摩根大通團隊采用了一個新穎的視角來解決混合現實中的三維用戶界面放置挑戰。受強化學習在機器人學和自動駕駛汽車等動態現實世界環境中成功應用的啟發,研究人員采用深度強化學習(RL) 來在動態場景中做出三維用戶界面的放置決策。

與基于優化的方法(其目標定義和觀察更為直觀)相比,強化學習需要仔細設計獎勵函數以及在訓練過程中進行大量的試錯。然而,在處理復雜動態場景并有機會納入用戶偏好方面,尤其是當需要順序做出決策時,強化學習可能更具優勢。通過觀察環境和用戶狀態,所提出的強化學習代理學習采取行動、觀察結果,并通過自身的交互經驗制定策略,以最大化用戶的長期獎勵。

團隊指出:“據我們所知,這項研究是首次在用戶移動時使用強化學習在三維混合現實空間中放置虛擬信息。”

為了評估基于強化學習的用戶界面放置方法在混合現實中的潛力,團隊通過初步評估驗證了訓練模型的性能和泛化能力。實驗結果證明了強化學習在解決混合現實環境中的三維用戶界面放置挑戰方面的潛力。它可以幫助用戶決定最佳放置位置,以在移動過程中最大化累積獎勵。另外,研究人員強調了利用最先進的強化學習方法來進一步改進我們提出的方法的未來可能性。

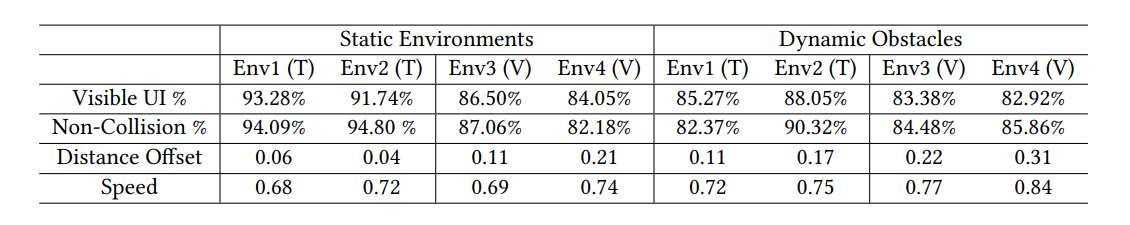

如表1所示,結果證明了基于強化學習的方法在自適應三維用戶界面放置方面的潛力。在更靜態的環境中,即在代理訓練過的環境中,超過91%的用戶界面是持續可見的。超過94%的時間它未與環境網格發生碰撞。它同時保持了用戶手臂可及的距離。

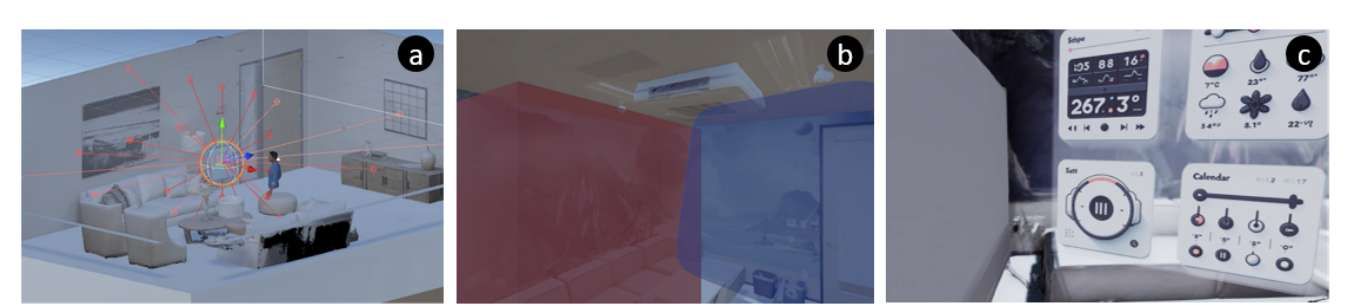

在代理未曾經歷過的兩個驗證環境中,結果表明用戶界面依然能保持在合理的位置,每個時間步中大約85%的部分持續對用戶可見。它保持了與用戶稍遠的距離,但依然在可觸及范圍內。同樣,在環境中引入移動障礙物的動態設置中,模型在訓練環境和驗證環境中都實現了良好的放置效果,性能下降可以忽略不計,特別是在驗證環境中,可見性/物理性(指避免碰撞)的下降被限制在3.12%以內。即使障礙物滑入視場(見圖3(b)),用戶界面都能保持其可達性水平,并避免大多數即將發生的碰撞以保持其對用戶的可見性。

因此,用戶界面到用戶的平均距離略有增加以補償這種權衡。這證明了強化學習代理能夠適應并泛化到它以前未曾經歷過的環境和一定程度的意外變化。然而,團隊注意到在兩個帶有動態障礙物的訓練環境中出現的較高性能下降可能是過擬合的跡象。未來的研究需要在更多樣化的環境中進一步驗證我們的模型。

圖3(c) 展示了模型實時輸出的示例,其中強化學習放置用戶界面,同時避免與白板碰撞,并確保用戶的可達性和可見性。研究人員觀察到的一個限制是用戶界面移動速度仍然相對較高,平均值超過了在獎勵函數中設定的水平。其中一個原因可能是模擬象征了一個用戶頻繁重新定位的繁忙場景,因此強化學習代理體驗靜態獎勵的機會較少。未來需要在如何進一步提高用戶界面的穩定性方面開展工作。

摩根大通團隊對初步探索的積極成果感到興奮。在此,研究人員強調在動態三維混合現實環境中利用強化學習進行內容放置的未來機遇與挑戰:

更多關于獎勵公式的考量: 作為初步探索,當前的強化學習設置在制定獎勵時未考慮其他方面,例如物理對象的語義和可供性、內容類型(例如2D與3D、文本密集型與圖像)、空間一致性以及用戶人體工程學。最近的研究強調了這些考量的好處。未來的研究應考慮這些方面,探索如何將它們納入當前的獎勵設計,以及如何進一步提高用戶界面內容的穩定性。

VR模擬與實際AR/MR環境: 訓練通過在虛擬現實中模擬增強現實/混合現實環境,假設了對環境和用戶狀態的充分理解。在真實的增強現實/混合現實空間中進行訓練可能會面臨更多挑戰,因為強化學習需要大量的試錯,并且對物理世界的理解并不完美。未來的工作需要彌合模擬用戶行為與實際用戶行為之間的差距。例如,利用生成式人工智能模型,可以從用戶的實際移動軌跡生成合成數據來訓練強化學習代理。這樣,代理就可以從常見的用戶行為模式中學習,以進一步優化下游性能。

多用戶與多用戶界面: 團隊的探索證明了強化學習控制單個三維用戶界面內容放置的初步可行性。然而,用戶經常需要訪問多個與其任務具有不同相關性的應用程序。為了支持多個內容元素,可以利用多智能體強化學習框架來訓練多個智能體之間的協作行為,使它們做出最佳權衡。同樣的策略也可能適用于多用戶協作場景。未來的研究可以探索這些方向的可行性。

結合人類反饋的強化學習(RLHF)用于偏好學習: 研究表明,性能更好的人工智能模型可能不會被用戶認為更有用。同樣,從用戶角度來看,混合現實中三維用戶界面放置的質量通常具有高度主觀性。因此,關鍵在于推導出符合用戶期望、偏好和能動性的放置位置。最近的研究揭示了強化學習通過少量查詢納入人機協作偏好學習的潛力,這種方法能夠很好地泛化到新任務,無需重新訓練模型。這使得偏好可以在移動過程中被獲取,與優化中基于約束的方法相比可能更靈活。未來的研究可以進一步探索利用結合人類反饋的強化學習(RLHF)在混合現實空間中推導個性化和更優的用戶界面放置的潛力。

基于模型的強化學習: 團隊的探索利用了無模型強化學習,這是一種處理環境嘈雜、復雜且不可預測的現實情況的有力技術。其缺點是無模型強化學習需要大量的試錯才能使代理學習到一個好的策略。在人機交互領域,已經開發了多種模型來預測人類的運動和認知表現。這使得基于模型的強化學習成為一種可行的替代方案,其中強化學習代理模擬其行動的后果而無需實際執行它們,從而進行前瞻性規劃。這樣,訓練可以更高效地進行。

與基于優化方法的比較: 由于本研究的范圍,團隊沒有將強化學習與其他基于優化的方法進行比較。未來的研究需要在實驗控制和生態效度兼備的混合現實用戶界面場景設置下,探索不同方法之間的權衡。

關于泛化能力的更多探索: 盡管結果初步證明了基于強化學習方法的泛化能力,但訓練是在多樣性較低的環境中進行的。引入更高程度的可變性和復雜性可能有助于更穩健的學習過程(例如帶有移動旁觀者的多層環境),使模型能夠更有效地適應多樣化的用戶界面場景。團隊的目標是模擬更逼真的現實世界場景,從而使模型能夠獲得更廣泛的行為。

相關論文:Adaptive 3D UI Placement in Mixed Reality Using Deep Reinforcement Learning

https://arxiv.org/pdf/2504.21731

總的來說,摩根大通團隊探索了強化學習在混合現實環境中進行三維用戶界面放置的潛力。通過讓強化學習代理在模擬的物理環境中通過試錯進行交互,它可以學習一種策略來輔助三維用戶界面的放置,以最大化用戶的效用。研究人員訓練了一個能夠持續輔助三維用戶界面放置的強化學習代理,通過初步的模擬評估(探索了模型在新環境和動態環境中的泛化能力)展示了所提出方法的潛力,并指出了用戶界面穩定性和過擬合等挑戰。

基于結果,團隊進一步強調了未來研究的機遇,亦即探索利用強化學習在混合現實環境中實現個性化和自適應的信息顯示。