查看引用/信息源請點擊:中國AI網

相比現有量化方法,PTQ4VM在不同位寬下均實現了最先進的精度性能

(中國AI網 2025年10月23日)視頻摳像技術在影視制作和虛擬現實等應用中至關重要,然而在計算資源受限的設備部署其計算密集型模型仍存在挑戰。量化作為模型壓縮與加速的核心技術,其中后訓練量化(PTQ)作為一種高效方法,在視頻摳像領域仍處于起步階段,并面臨保持精度和時間一致性的重大難題。

為解決這些問題,南京大學,商湯科技,蘇黎世聯邦理工學院團隊提出了一種新穎且通用的后訓練量化框架PTQ4VM,專門針對視頻摳像模型設計。團隊的貢獻包括:

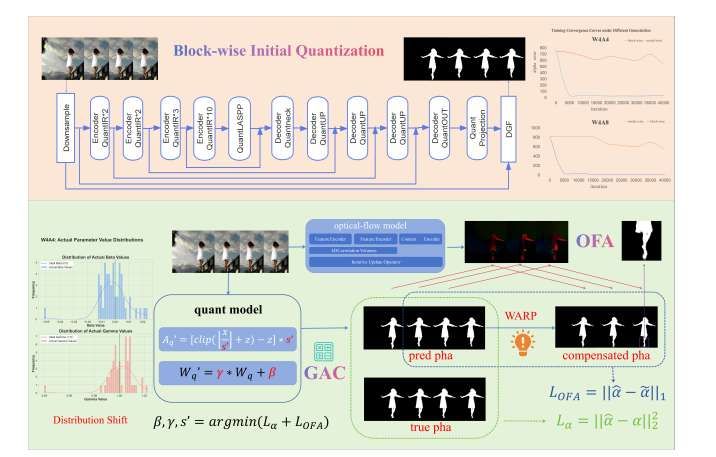

采用兩階段量化策略:首先通過基于塊重建的優化實現快速穩定的初始量化與局部依賴捕獲,隨后通過量化參數的全局校準最小化精度損失;

提出統計驅動的全局仿射校準(GAC)方法,使網絡能夠補償因忽略BN層效應等因素引起的累積統計失真,甚至將現有PTQ方法在視頻摳像任務中的誤差降低達20%;

設計光流輔助(OFA)組件,利用幀間時空先驗信息指導量化過程,增強模型在復雜場景中區分運動前景的能力,最終在超低位量化下仍能接近全精度模型性能。

綜合定量與可視化結果表明,相比現有量化方法,PTQ4VM在不同位寬下均實現了最先進的精度性能。團隊特別強調:4位PTQ4VM在獲得8倍浮點運算節省的同時,實現了與全精度模型相當的性能。

視頻摳像技術旨在精確估計視頻序列中每幀前景物體的Alpha遮罩(α∈[0,1])。Alpha遮罩通過合成方程I = αF + (1?α)B定義每個像素的前景不透明度(I為觀測像素,F為前景,B為背景)。這一具有挑戰性的計算機視覺任務在虛擬現實等領域具有廣泛應用。為在資源受限平臺上實現實時性能部署,高效的模型表示至關重要,這需要采用先進的模型壓縮技術來減少視頻摳像模型的計算和內存占用。

模型壓縮技術尤其是量化,通過將高精度浮點數轉換為低位整數來減小模型規模并加速計算,對于在資源受限設備上部署先進視頻摳像模型至關重要。雖然量化感知訓練(QAT)通過在訓練中模擬量化來獲得良好性能,但其需要大量標注數據和計算資源,這對視頻摳像任務往往難以滿足。

相比之下,后訓練量化(PTQ)僅需少量校準數據且無需重新訓練即可直接量化預訓練模型,在部署效率方面具有顯著優勢。然而,針對視頻摳像模型的專用PTQ研究仍處于萌芽階段。南京大學,商湯科技,蘇黎世聯邦理工學院團隊致力于系統性地探索將PTQ應用于視頻摳像任務的挑戰與機遇。

應用PTQ于復雜視頻摳像模型主要面臨三大挑戰:首先,其深層拓撲結構對有限校準數據的依賴常導致PTQ校準過程收斂不穩定;其次,低位寬下量化誤差會在網絡中傳播,導致輸出偽影和不確定性增加;另外,用于捕獲時間依賴的循環結構對量化噪點特別敏感,可能破壞已學習的時間動態特性,表現為閃爍或抖動現象。為解決所述挑戰,研究人員提出了首個專為視頻摳像模型設計的PTQ框架。

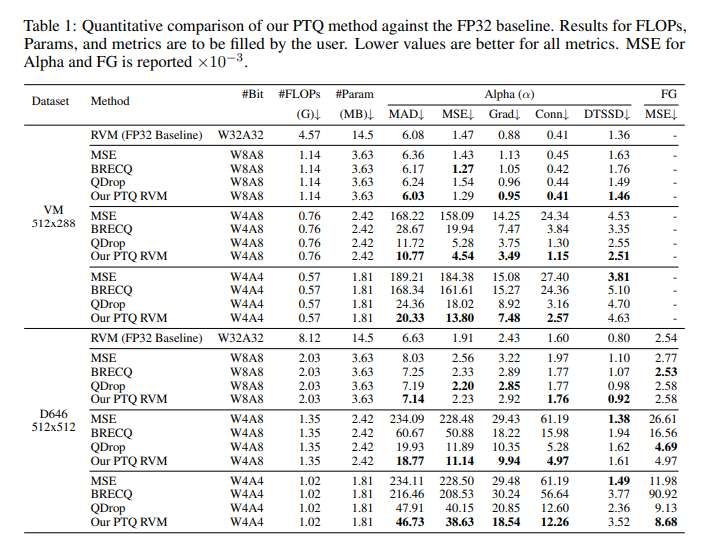

如表1所示,所提出的PTQ方法在VM和D646數據集的所有評估指標上均展現出顯著優勢。在8位量化(W8A8)設置下,所提出方法達到了與FP32全精度模型相當甚至部分指標更優的性能;

在更具挑戰性的4位量化場景中,當主流PTQ方法出現顯著性能下降甚至失效時,所提出方法仍能保持滿意的摳像質量和時間一致性,顯著優于其他對比方法。例如在VM數據集的W4A4設置下,所提出方法各項Alpha誤差指標較次優方法降低約20%。這種在極低位寬下的魯棒性凸顯了團隊提出的整體量化框架處理復雜模型和誤差累積的優勢。

特別值得注意的是在D646數據集上的表現:由于校準集完全源自VM視頻數據集,D646對模型而言代表未校準的圖像摳像數據。所提出方法在該數據集上仍保持領先的量化性能,這有力證明了所提出方法具有良好的泛化能力,其核心校準策略可有效遷移到不同數據分布和任務特性。總體而言,所提出方法在顯著壓縮模型規模和降低計算復雜度的同時,保持了視頻摳像的精度和時間質量,為PTQ技術在復雜視頻處理任務中的實際應用提供了有力支撐。

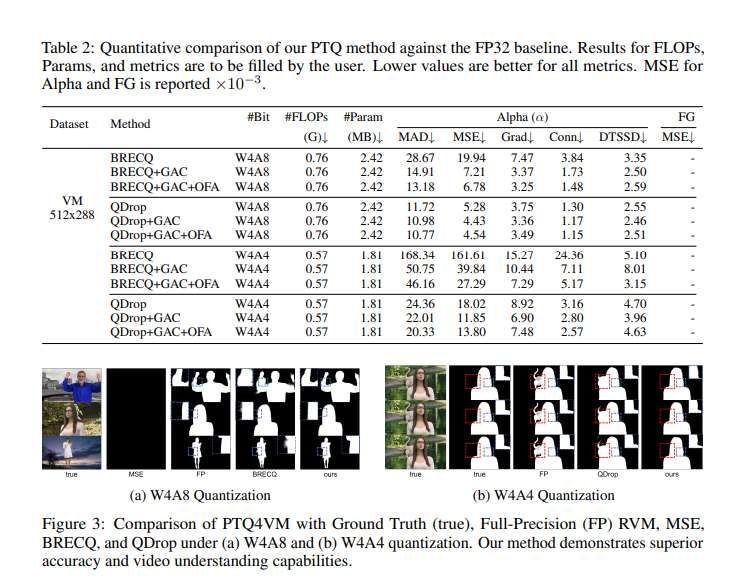

可視化對比結果(圖3a)表明訓練框架提升了摳像精度,在復雜曲線和運動細節上表現更優;圖3b展示了框架對視頻語義理解能力的提升——即使全精度模型有時也難以區分相似的靜態背景干擾,但所提出模型能準確識別運動前景,這同樣印證了OFA組件的指導作用。

研究人員將GAC模塊獨立應用于兩種先進PTQ算法BRECQ和QDrop。具體而言,先獲取BRECQ和QDrop在不同位寬下生成的量化模型,再應用GAC進行微調(優化目標與完整框架第二階段一致)。

如表2所示,GAC顯著增強了BRECQ和QDrop在低位寬(尤其是W4A4)下的各項指標性能。值得注意的是,GAC對BRECQ的性能提升尤為顯著,應用后其所有指標均大幅改善,達到與未使用GAC的QDrop相當的水平。這一現象為理解QDrop等通過模擬量化噪點進行優化的方法提供了新視角:QDrop通過訓練中的隨機擾動學習對統計偏差魯棒的權重和量化參數,而GAC則通過全局線性變換直接補償量化引入的統計偏差。

如表2所示,當OFA組件集成到BRECQ和QDrop的第二階段校準過程時,兩種方法的精度均獲得進一步提升,這表明OFA提供的時間先驗能有效指導框架內的優化過程。

當然,團隊坦誠當前方案存在局限性:所提出方法無法完全實現全精度模型的細節捕獲能力,且在極低位寬(如1-2位)下模型表征能力的退化仍是挑戰。

相關論文:Post-Training Quantization for Video Matting

https://arxiv.org/pdf/2506.10840

總的來說,團隊提出了首個針對視頻摳像任務的有效后訓練量化(PTQ)框架。他們提出通用的多階段量化策略:先通過分塊優化實現初始量化,再通過分層線性權重校準優化參數;創新性地引入光流輔助(OFA)組件,不僅顯著增強量化模型在長視頻序列中的時間一致性,還提升了其視頻語義理解能力。

實驗表明所提出方法在大幅降低模型計算和存儲需求的同時,能保持與全精度模型相當的摳像質量,即使在極低位寬下也展現出卓越的魯棒性和泛化能力。這項研究為視頻摳像模型在資源受限設備上的實際部署提供了可行方案,為復雜視頻處理任務的PTQ研究提供了新思路。所述方法同時展示了光流在規范化量化模型微調以實現時間相干視頻處理中的有效應用。