查看引用/信息源請點擊:中國AI網

從單張彩色圖像估計3D手部關節

(中國AI網 2025年10月27日)從單張彩色圖像估計3D手部關節是一個重要的問題,在增強現實和虛擬現實等技術中都有應用。除了缺乏深度信息外,遮擋、關節活動的復雜性以及需要知曉camera參數都帶來了額外的挑戰。在一項研究中,希臘色薩利大學和Moverse團隊提出了一個從2D關鍵點輸入估計3D手部關節的優化流程,其中包括一個關鍵點對齊步驟和一個指尖損失,以克服需要知曉或估計camera參數的需求。

研究人員在EgoDexter和Dexter+Object基準上評估了所提出方法,結果表明其性能與最先進技術相比具有競爭力,同時在處理沒有任何先驗camera知識的in-the-wild圖像時同樣展現了其魯棒性。盡管使用了手部先驗知識,但定量分析凸顯了2D關鍵點估計精度的重要性。

從單個RGB圖像重建關節化的3D手部是計算機視覺中一個具有廣泛應用,包括增強現實和虛擬現實。然而,由于缺乏深度信息、頻繁的物體相關遮擋和自遮擋、未知的camera內參以及手部復雜的關節結構,這是一項艱巨的任務。在研究中,希臘色薩利大學和Moverse團隊提出了一種無需先驗camera參數知識的單目3D手部姿態估計的替代方法。

所提出方法利用了MediaPipe強大的2D關鍵點檢測能力,結合一個兩階段優化流程,將MANO手部模型擬合到檢測到的2D關鍵點。第一階段執行剛性變換,將初始的MANO手部模型與2D檢測結果對齊,建立粗略的3D姿態估計。第二階段使用指尖對齊損失和解剖學約束來細化此估計,以確保物理上合理的手部配置。

通過避免依賴已知的camera參數,所提出方法能夠在保持精度的同時在in-the-wild環境中執行。解剖學約束充當正則化器,防止不真實的手部姿態,而指尖對齊損失則提高了關鍵區域的精度。實驗證明,即使不知道camera內參,所提出方法與最先進方法相比都能達到有競爭力的性能,這使其成為現實世界應用中的一個實用解決方案。

為了解決從單個RGB圖像擬合關節化3D手部的問題,研究人員設計了如圖2所示的流程。輸入是包含人手的標準RGB圖像,輸出是具有完全相同姿態和方向的3D手部。流程的第一步是將輸入圖像通過MediaPipe Hand模型估計器以提取21個手部關鍵點以及左右手信息(手是左手還是右手)。此過程生成一個對應于輸入圖像中像素位置的關鍵點列表,隨后將其用作擬合MANO手部模型的ground truth參數。

對于優化步驟,目標是將MANO模型的關鍵點擬合到從MediaPipe提取的“真實值”關鍵點。給定MANO的姿態和形狀參數,可以通過線性插值獲得21個手部關節點位置。MANO將45個姿態參數、10個形狀參數和3個全局旋轉參數作為輸入,生成代表獨特手部配置的3D網格。

擬合過程從一個中性的“零”姿態和形狀開始。通過一系列變換和迭代優化,調整MANO參數,通過最小化損失函數使其21個關鍵點與估計的MediaPipe關鍵點對齊。

一個關鍵的挑戰是當輸入手部處于與MANO默認姿態不同的全局旋轉時。問題的根源在于初始化:由于沒有關于輸入手部方向的先驗信息,MANO以中性姿態、形狀和旋轉開始,并且將每個參數初始化為零。然而,如果輸入圖像中的手部具有顯著不同的旋轉,例如處于“握手”位置,優化過程會失敗,導致完全不合理的手部網格。

為了解決這一挑戰,計算一個剛性變換,將中性的MANO關鍵點與MediaPipe關鍵點對齊。另外,在開始優化過程之前,應用縮放以確保兩組關鍵點正確對齊。完整的優化流程如圖3所示。

使用六個穩定的手掌關節點(即圖1中所示的關鍵點[0,1,5,9,13,17])計算剛性變換,以最小化手指關節活動的影響。為了計算該變換,實現一個自定義函數。其中,所述函數返回一個4×4的變換矩陣,其中左上角的3×3塊代表旋轉,右上角的3×1列是平移向量,底行用于齊次坐標。

對于縮放,使用目標關鍵點和MANO關鍵點中關鍵點0和5(手腕到食指掌指關節)之間的距離來計算一個比例因子,以確保解剖學上成比例的對齊。在初始對齊之后,使用scipy.minimize來優化MANO參數,特別利用BFGS或L-BFGS方法。

為了提高指尖對齊的準確性,團隊探索了加權損失函數,因為他們觀察到大多數關鍵點密集集中在手掌周圍。由于損失函數的性質,優化過程主要側重于最小化這些密集區域的誤差,通常導致指尖對齊精度較低。然而,在現實世界的手部運動中,指尖在定義手勢和姿態方面起著關鍵作用,因此其精確定位至關重要。

為了解決這個問題,在所有三種損失函數變體應用了加權損失函數,賦予指尖關鍵點更高的重要性以確保它們的正確對齊。另外,他們嘗試將解剖學關節約束整合到損失函數中,以強制執行物理上合理的手部姿態。然而,這種方法被證明效果不佳,因為它過于嚴格地限制了優化過程。盡管嘗試了各種加權方案,結果并未改善。

相反,團隊采用了兩階段優化策略:

階段1: 使用標準的MSE損失函數來獲得手部姿態的初始估計。

階段2: 使用解剖學損失約束結合僅應用于2D關鍵點的MSE損失來細化階段1的輸出。這確保了估計的手部保持在現實的解剖學界限內。

優化后,反轉剛性變換,以恢復原始比例、方向和位置的MANO關鍵點和網格。將用于初始化的旋轉矩陣、平移向量和比例因子進行逆變換,以將優化后的MANO結果映射回目標坐標系,以便可以直觀地檢查結果。

為了確定根部姿態,計算從剛性變換導出的旋轉矩陣的軸角表示,并將其納入MANO模型參數中。這確保了全局旋轉在最終輸出中得到準確表示。這意味著現在得到了一個具有正確全局方向和姿態的3D手部,但形狀為零。

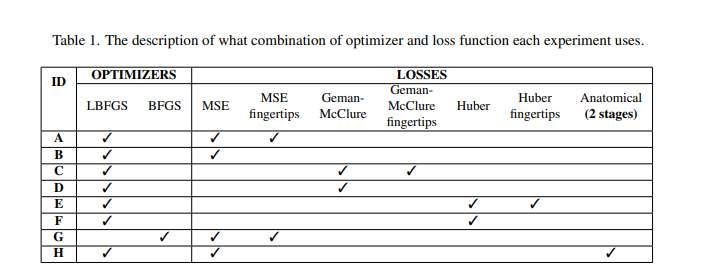

表1展示了在兩個數據集為評估方法而測試的不同實驗配置。每個實驗由一個字母(ID)標識,并對應特定的優化器和損失函數組合。雖然使用LBFGS優化器測試了所有損失函數組合,但選擇性地使用BFGS優化器測試了他們認為最有希望的損失函數設置。

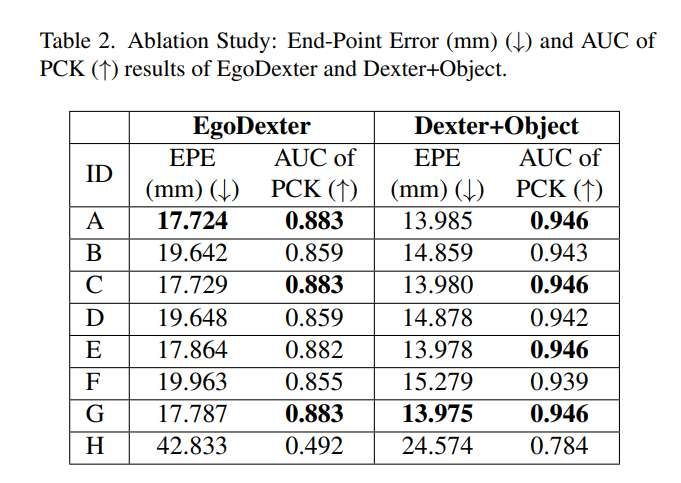

表2展示了實驗的定量結果,并報告了兩個數據集的端點誤差(以毫米為單位)和PCK的AUC。發現表明,大多數實驗表現良好,結果彼此相當。這種一致性符合預期,因為不同的損失函數都是MSE損失的變體,目標是提高對異常值的魯棒性。每個指標上表現最好的結果以粗體突出顯示,盡管在許多情況下,多種配置實現了相似的結果。

觀察表明,加權指尖損失函數傾向于在所有指標上產生稍好的性能。然而,標準損失函數也取得了有競爭力的結果,而加權指尖損失函數的更好結果可能歸因于評估數據集主要關注指尖關鍵點。另外在實驗H中,這種集成解剖學約束的兩階段方法導致整體性能更差,盡管它成功糾正了特定情況下由MediaPipe的3D預測引起的深度相關錯誤。

總體而言,結果表明,最有效的優化器-損失組合是實驗A和實驗G。這一結果符合預期,因為LBFGS和BFGS密切相關,L-BFGS是內存高效的變體。如果考慮計算效率和準確性,使用帶有加權MSE損失組合的L-BFGS的實驗A成為最佳選擇。

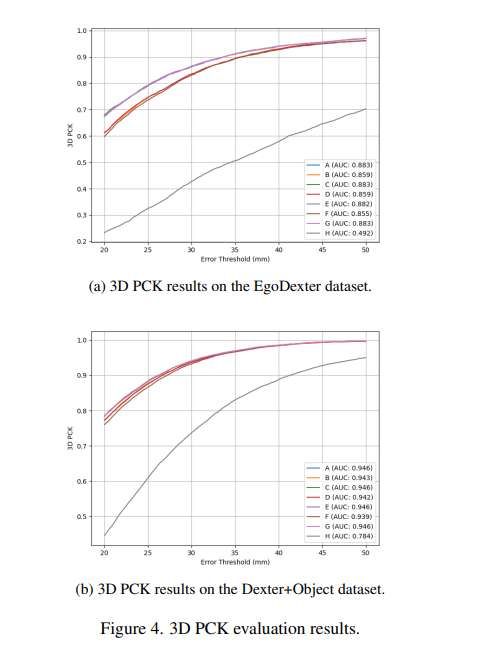

圖4a和圖4b分別比較了上述方法在EgoDexter和Dexter+Object數據集上的性能。在兩種情況下,包含解剖學約束的方法表現最差。對于EgoDexter數據集,團隊觀察到使用加權指尖損失函數的方法優于使用標準損失函數的方法,形成了一個明顯的高性能模型簇。但在Dexter+Object數據集上,這種區別不太明顯。

表3展示了所提出方法與SotA方法的比較,報告了在Dexter+Object和EgoDexter數據集上的PCK AUC。該表包括基于優化和基于學習的方法。所提出方法在EgoDexter數據集上取得了最高的AUC,優于所有其他方法。對于Dexter+Object數據集,所提出方法與性能最佳的方法幾乎不相上下,僅有0.002的微小差異。值得注意的是,所提出方法不僅超越了其他基于優化的方法,而且還優于幾種基于學習的方法。這一點尤其重要,因為基于學習的方法通常需要大量的計算資源進行訓練。

另外,通過比較表3和表2,團隊觀察到不僅性能最佳的配置達到了SotA結果,甚至數個替代設置都與該領域的頂級方法保持競爭力。需要強調的是,用于評估的數據集未包含在任何基于學習的方法的訓練階段中,確保了與SotA方法的公平比較。

為了進一步評估所提出方法的性能,圖5a–5f中展示了各種場景下的定性結果。圖5a和圖5b展示了來自EgoDexter數據集的示例。在較簡單的情況下(圖5a),所提出方法準確預測了手部關鍵點。然而,在更具挑戰性的場景中(圖5b),即發生物體交互導致的遮擋時,所提出方法仍然表現得相當好,盡管出現了一些微小的不準確之處。

圖5c和圖5d比較了不同損失函數對Dexter+Object數據集的影響。簡單的MSE損失(圖5c)導致預測準確性較低,尤其是在指尖位置。相比之下,使用強調指尖的加權MSE損失(圖5d)改善了預測。

圖5e展示了一個由極端遮擋引起的失敗案例。EgoDexter數據集未為此類情況提供真實值關鍵點,使得評估變得困難。另外,MediaPipe在此場景中未能檢測到手部,這直接影響了所提出方法,因為它依賴其初始關鍵點預測,而不是數據集中的真實值標注。然而,在MediaPipe成功檢測到手部的挑戰性較小的情況下,所提出方法仍然有效。

最后,圖5f通過估計蒙娜麗莎繪畫圖像中的手部姿態,證明了所提出方法能夠泛化到結構化數據集之外。這表明所提出方法不依賴camera參數,并且可以在in-the-wild RGB圖像上運行,使其適用于多樣化的現實世界場景。

相關論文:Monocular 3D Hand Pose Estimation with Implicit Camera Alignment

https://arxiv.org/pdf/2506.11133

總的來說,團隊提出了一種基于優化的解決方案,用于在不知道camera內參的情況下,從單個RGB圖像估計人手的3D關節活動。所提出方法利用MediaPipe關鍵點檢測器獲得手部關節在2D空間的初始估計,并執行一個使用MANO參數模型的擬合階段以獲得3D關節旋轉。對于擬合階段,結合指尖對齊損失和解剖學約束。廣泛的評估表明,所提出方法能夠魯棒地在in-the-wild環境中運行,無需先驗的camera參數信息,同時與SotA數據驅動模型相比具有競爭力。