查看引用/信息源請點擊:中國AI網(wǎng)

基于Transformer的實時端到端姿態(tài)估計方法

(中國AI網(wǎng) 2025年10月30日)多人姿態(tài)估計(MPPE)任務(wù)旨在檢測圖像中所有人體關(guān)鍵點。作為計算機視覺與虛擬現(xiàn)實領(lǐng)域多項應(yīng)用的基礎(chǔ)任務(wù),目前尚未出現(xiàn)能夠?qū)崟r運行的基于Transformer架構(gòu)的MPPE模型。在一項研究中,美國新墨西哥大學(xué)團隊提出了一個基于Transformer的模型家族,以實現(xiàn)實時多人二維姿態(tài)估計。

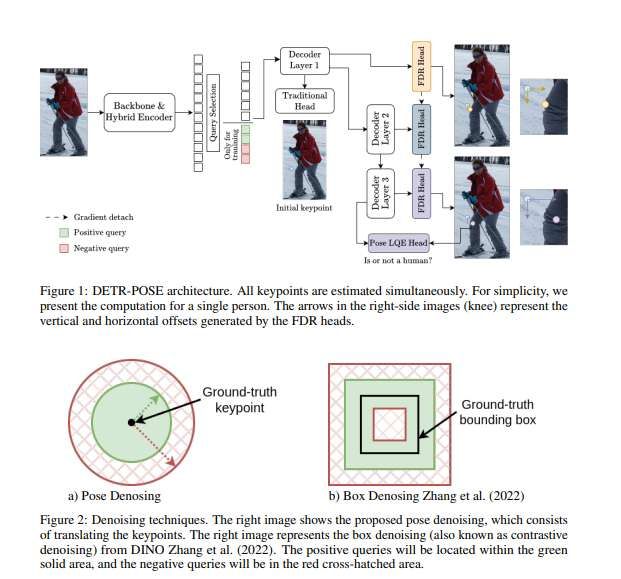

研究人員通過改進解碼器架構(gòu)并采用關(guān)鍵點相似度度量,能夠同時生成正向與反向查詢,從而提升架構(gòu)內(nèi)查詢選擇的質(zhì)量。與現(xiàn)有最優(yōu)模型相比,所提出模型的訓(xùn)練效率大幅提升——訓(xùn)練周期縮短5至10倍,在保持相當(dāng)推理速度的同時無需借助量化庫加速。另外,模型在參數(shù)量顯著減少的情況下仍能取得具有競爭力的結(jié)果,甚至表現(xiàn)更優(yōu)。

多人姿態(tài)估計(MPPE)旨在從圖像中所有人體實例中檢測關(guān)鍵點。作為虛擬現(xiàn)實等大型系統(tǒng)的核心組件,MPPE是計算機視覺領(lǐng)域的基礎(chǔ)性問題,其快速計算能力對所有實時應(yīng)用至關(guān)重要。盡管姿態(tài)估計模型的精度已顯著提升,但現(xiàn)有模型依然存在高延遲問題,制約了實時應(yīng)用發(fā)展。

當(dāng)前快速MPPE方法主要分為自上而下與自下而上兩類:自上而下模型先通過預(yù)訓(xùn)練目標(biāo)檢測器定位人體實例邊界框,再對每個個體進行姿態(tài)估計,雖精度較高但推理速度隨圖像中人數(shù)增加而線性下降;自下而上方法先檢測所有人體關(guān)鍵點再進行分組,速度更快但精度較低,因為網(wǎng)絡(luò)需同時學(xué)習(xí)檢測與姿態(tài)估計。

近年來,學(xué)界嘗試將YOLO、DETR等目標(biāo)檢測框架適配于姿態(tài)估計任務(wù)。基于YOLO的RTMO與YOLO11-pose模型在推理速度與系統(tǒng)精度間取得了良好平衡,而基于Transformer的DETR類模型雖精度較高但速度顯著緩慢。盡管DETR框架在實時目標(biāo)檢測領(lǐng)域已有改進,但其姿態(tài)估計任務(wù)仍缺乏實時適配方案。

采用輕量化編碼器可加速推理,但DETR姿態(tài)估計的延遲主要源于解碼器而非編碼器。與目標(biāo)檢測中查詢用于估計物體邊界框不同,姿態(tài)估計中每個查詢需預(yù)測單個人體的單個關(guān)鍵點,因此針對目標(biāo)檢測設(shè)計的解碼器加速、損失函數(shù)優(yōu)化或去噪訓(xùn)練等方法難以直接適用。

美國新墨西哥大學(xué)團隊首次設(shè)計了基于Transformer的實時端到端姿態(tài)估計方法DETRPose,通過改進解碼器與訓(xùn)練損失函數(shù),實現(xiàn)了DETR框架在實時姿態(tài)估計中的適配。團隊將變焦損失函數(shù)與定位質(zhì)量估計層改進適用于姿態(tài)估計任務(wù),在保持低恒定延遲的同時取得了具有競爭力的精度。

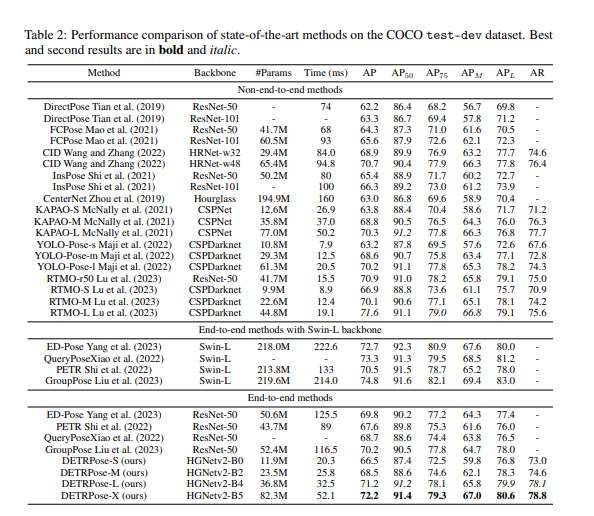

DETRPose-L在COCO val2017數(shù)據(jù)集上達到72.5%的平均精度(mAP),延遲僅為32.5毫秒(未使用tensorrt等量化庫),相比其他端到端方法達到最優(yōu)水平。相較于當(dāng)前最先進的實時MPPE模型RTMO(需700訓(xùn)練周期),DETRPose-L僅需48周期即可收斂,加速比達12.5倍。

實驗采用COCO關(guān)鍵點檢測數(shù)據(jù)集和CrowdPose數(shù)據(jù)集。COCO包含超過15萬張圖像和25萬個人體實例,標(biāo)注17個關(guān)鍵點;CrowdPose作為更具挑戰(zhàn)性的擁擠場景數(shù)據(jù)集,包含2萬張圖像和8萬個人體實例。DETRPose使用COCO訓(xùn)練集訓(xùn)練并在test-dev集測試,CrowdPose使用trainval集訓(xùn)練并在測試集評估。實驗采用4塊Tesla V100,延遲測試使用單塊V100配合TensorRTv8.6.4 FP16。通過調(diào)整可訓(xùn)練參數(shù)量,團隊構(gòu)建了DETRPose-S/M/L/X四個模型,均采用AdamW優(yōu)化器(學(xué)習(xí)率0.0001),數(shù)據(jù)增強包括水平翻轉(zhuǎn)、顏色抖動、馬賽克組合和多尺度采樣。

為公平對比,遵循RTMO協(xié)議對主干網(wǎng)絡(luò)和編碼器實施遷移學(xué)習(xí)(基于Object365數(shù)據(jù)集預(yù)訓(xùn)練的D-FINE模型),批量大小設(shè)置為16,驗證與測試時圖像縮放至640×640。

如表2所示,在不使用Swin-L主干網(wǎng)的端到端模型中,DETRPose-L以最少參數(shù)量取得最佳結(jié)果。與非端到端模型相比,DETRPose-L在APL(79.9)和AR(78.1)指標(biāo)上以0.5優(yōu)勢超越所有對手,僅次于參數(shù)量更大的RTMO-L。最大模型DETRPose-X與基于Swin-L大主干網(wǎng)的模型相比具有競爭力,其推理速度創(chuàng)下實時姿態(tài)估計新紀(jì)錄。

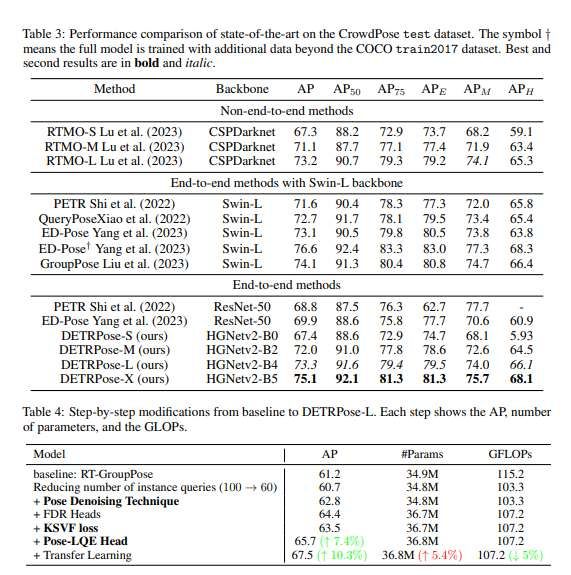

如表3所示,DETRPose-M/L/X以顯著優(yōu)勢超越PETR和ED-Pose。值得注意的是,DETRPose-M僅使用2400萬參數(shù)(比Swin-L模型少8倍),且所有DETRPose模型均優(yōu)于同規(guī)格RTMO模型。訓(xùn)練效率方面:DETRPose-S僅需150周期即可達到競爭性結(jié)果,DETRPose-X僅需80周期,而RTMO需800周期(分別是DETRPose-S的5.3倍和X的10倍)。DETRPose-X以75.1的AP指標(biāo)創(chuàng)下實時MPPE模型新紀(jì)錄,除ED-Pose?外超越所有模型(ED-Pose參數(shù)量2.18億 vs DETRPose-X的8230萬,且無法實時運行)。這表明基于Transformer的方法在多人姿態(tài)估計領(lǐng)域具有巨大潛力。

團隊逐步分析DETRPose各組件的貢獻(基于COCO val數(shù)據(jù)集)。以添加D-FINE主干網(wǎng)的RT-GroupPose為基線,將實例查詢數(shù)從100減至60導(dǎo)致AP下降0.5但降低計算量;加入姿態(tài)去噪訓(xùn)練策略使AP提升至62.8(該策略不影響推理);添加FDR頭使AP再增1.6點(計算量增加4單位);KSVF損失函數(shù)因關(guān)鍵點預(yù)測與置信度來源不一致導(dǎo)致AP下降,通過新增Pose-LQE分類頭促進不同查詢間交互,使AP顯著提升至65.7;最后對編碼器與主干網(wǎng)實施遷移學(xué)習(xí)進一步優(yōu)化。所有改進最終使AP提升10.3%,參數(shù)量僅增加5%,計算量反而降低10%。

相關(guān)論文:DETRPose: Real-time end-to-end transformer model for multi-person pose estimation

https://arxiv.org/pdf/2506.13027

總的來說,團隊提出的實時端到端姿態(tài)估計器DETRPose不僅實現(xiàn)了最新技術(shù)水平,更具備快速收斂特性。多數(shù)據(jù)集實驗表明,基于DETR的模型可通過適配有效應(yīng)用于姿態(tài)估計任務(wù),為MPPE領(lǐng)域的發(fā)展開辟了新方向。