查看引用/信息源請點(diǎn)擊:中國AI網(wǎng)

以感知為導(dǎo)向的光流調(diào)制為創(chuàng)建更用戶友好的沉浸式體驗(yàn)提供了一種有效且可擴(kuò)展的方法

(中國AI網(wǎng) 2025年11月06日)暈動(dòng)癥依然是虛擬現(xiàn)實(shí)技術(shù)廣泛普及的關(guān)鍵障礙,尤其是在涉及強(qiáng)烈或人工運(yùn)動(dòng)提示的場景中。其主要誘因之一是過度的光流——即感知到的視覺運(yùn)動(dòng)與前庭輸入不匹配時(shí),會導(dǎo)致感官沖突和不適。雖然以往研究探索了基于幾何或硬件的緩解策略,但所述方法通常依賴于預(yù)定義的場景結(jié)構(gòu)、手動(dòng)調(diào)整或侵入式設(shè)備。

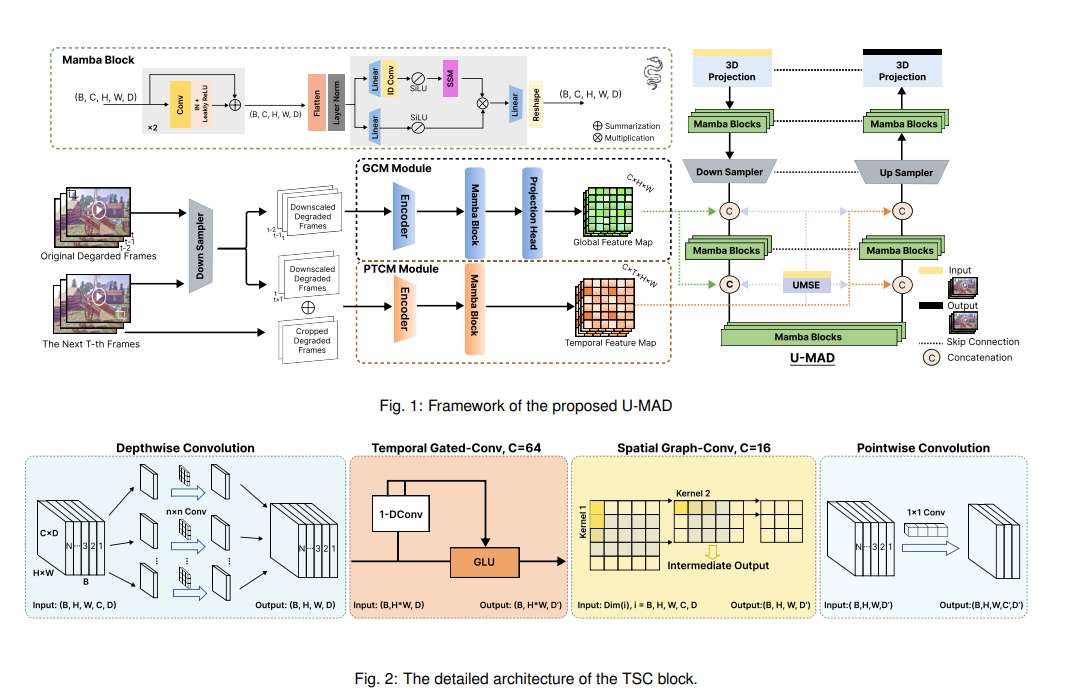

在一項(xiàng)研究中,香港科技大學(xué)(廣州)團(tuán)隊(duì)提出了U-MAD,一種輕量級、實(shí)時(shí)、基于人工智能的解決方案,直接在圖像層面抑制感知上具有破壞性的光流。與先前手工設(shè)計(jì)的方法不同,所述方案通過學(xué)習(xí)從渲染幀中衰減高強(qiáng)度運(yùn)動(dòng)模式,無需網(wǎng)格級編輯或場景特定適配。U-MAD設(shè)計(jì)為即插即用模塊,可無縫集成到現(xiàn)有VR流程中,并能很好地泛化到程序化生成的環(huán)境中。

實(shí)驗(yàn)表明,U-MAD能持續(xù)降低平均光流并增強(qiáng)不同場景的時(shí)間穩(wěn)定性。用戶研究進(jìn)一步證實(shí),減少視覺運(yùn)動(dòng)可提高感知舒適度并緩解暈動(dòng)癥狀。相關(guān)發(fā)現(xiàn)表明,以感知為導(dǎo)向的光流調(diào)制為創(chuàng)建更用戶友好的沉浸式體驗(yàn)提供了一種有效且可擴(kuò)展的方法。

虛擬現(xiàn)實(shí)技術(shù)已在教育、醫(yī)療、工業(yè)設(shè)計(jì)和娛樂等領(lǐng)域得到廣泛應(yīng)用。然而,一個(gè)持續(xù)存在的挑戰(zhàn)阻礙了其更廣泛的普及:暈動(dòng)癥。這種現(xiàn)象通常表現(xiàn)為惡心、頭暈或迷失方向,仍然是完全沉浸式體驗(yàn)的關(guān)鍵障礙。其主要原因中,視覺與前庭提示不匹配已得到廣泛認(rèn)可。這種不匹配在視覺豐富的環(huán)境中尤為明顯,其中人工運(yùn)動(dòng)提示主導(dǎo)用戶的視野。

在這種情況下,即使沒有物理運(yùn)動(dòng),僅視覺運(yùn)動(dòng)都能引發(fā)強(qiáng)烈的自運(yùn)動(dòng)錯(cuò)覺。這種感官不匹配的主要來源是不自然或過度的視覺運(yùn)動(dòng),即使用戶身體靜止,都可能引起不適。特別是光流(指觀察者感知到的視覺場景相對運(yùn)動(dòng))已確定為關(guān)鍵視覺觸發(fā)因素。高強(qiáng)度光流會產(chǎn)生自運(yùn)動(dòng)錯(cuò)覺;當(dāng)沒有相應(yīng)的前庭輸入時(shí),它會放大感知不一致并導(dǎo)致暈動(dòng)癥。這種效應(yīng)在視場外圍區(qū)域尤為明顯,因?yàn)樗鰠^(qū)域運(yùn)動(dòng)敏感性更高。因此,調(diào)制渲染內(nèi)容中的光流結(jié)構(gòu)和幅度已成為提高各種沉浸式應(yīng)用舒適度的關(guān)鍵策略。

業(yè)界已提出多種硬件和軟件策略來緩解暈動(dòng)癥,包括前庭刺激和視覺內(nèi)容適配。基于硬件的方法旨在對齊物理和視覺提示,但通常具有侵入性且不適合消費(fèi)者使用。軟件方法旨在通過修改渲染內(nèi)容來減少感知運(yùn)動(dòng),但可能會影響沉浸感或視覺質(zhì)量。值得注意的是,有研究人員引入了一種幾何簡化框架,通過手動(dòng)編輯虛擬場景的高運(yùn)動(dòng)區(qū)域來減少外圍光流。他們的方法基于離線光流分析分割場景幾何,并用簡化形狀替換復(fù)雜元素。雖然有效,但該方法嚴(yán)重依賴預(yù)定義網(wǎng)格、手動(dòng)調(diào)整以及離線異步預(yù)處理,限制了其在動(dòng)態(tài)或程序化生成環(huán)境中的可擴(kuò)展性。

為了克服所述限制,香港科技大學(xué)(廣州)團(tuán)隊(duì)提出了一種輕量級、實(shí)時(shí)、基于人工智能的方法在圖像層面自動(dòng)衰減破壞性運(yùn)動(dòng)模式——無需網(wǎng)格編輯、場景特定調(diào)整或額外硬件。所述解決方案設(shè)計(jì)為即插即用模塊,可無縫集成到現(xiàn)有VR流程中,實(shí)現(xiàn)端到端的暈動(dòng)癥緩解,且計(jì)算開銷低、場景兼容性高。與傳統(tǒng)手工方法不同,算法學(xué)習(xí)直接從渲染圖像中識別和抑制感知上顯著的光流特征。這種數(shù)據(jù)驅(qū)動(dòng)策略消除了場景特定預(yù)處理的需求,確保了對程序化生成或復(fù)雜環(huán)境的廣泛泛化。關(guān)鍵的是,所述方法保留了視覺保真度和用戶能動(dòng)性,避免了常見的權(quán)衡,如圖像質(zhì)量下降或交互受限。

除了展示平均光流的持續(xù)減少外,研究人員同時(shí)進(jìn)行了一項(xiàng)用戶研究以評估主觀有效性。參與者報(bào)告視覺舒適度顯著改善,暈動(dòng)癥狀減輕,證實(shí)系統(tǒng)提供了可測量和體驗(yàn)上的益處。這些結(jié)果共同將所提出方法定位為適用于下一代沉浸式系統(tǒng)的可擴(kuò)展且具有感知意識的解決方案。

在用戶研究中,團(tuán)隊(duì)通過社交媒體招募了18名參與者(7名男性,11名女性;年齡范圍:19-29歲,平均年齡=23.17,標(biāo)準(zhǔn)差=1.95)。納入標(biāo)準(zhǔn)包括正常或矯正至正常的視力,無嚴(yán)重暈動(dòng)癥或前庭疾病史。50%的參與者報(bào)告無先前VR經(jīng)驗(yàn)。所有參與者在收到關(guān)于實(shí)驗(yàn)程序和目標(biāo)的完整信息后提供了知情同意,包括他們隨時(shí)退出的權(quán)利。

采用了平衡設(shè)計(jì)。參與者被隨機(jī)分配到兩種觀看順序之一:一半(n=9)先觀看修復(fù)視頻,然后觀看原始版本;另一半(n=9)以相反順序觀看。從VR兼容游戲環(huán)境(過山車游戲片段)中選擇了兩段視頻剪輯(原始和處理后),每段時(shí)長2分鐘,渲染分辨率為4K(3840×2160)以匹配典型VR頭顯性能標(biāo)準(zhǔn)。視頻在Quest Pro頭顯上播放,并為每位參與者單獨(dú)校準(zhǔn)以確保最佳視覺質(zhì)量。

測試環(huán)境包括一個(gè)安靜、光線昏暗的房間,參與者坐在可調(diào)節(jié)椅子上以最小化外部干擾。在不同視頻觀看會話之間,所有參與者有約一小時(shí)的休息時(shí)間,以確保他們從視覺刺激引起的任何癥狀中恢復(fù)。每次視頻觀看后,所有參與者被要求完成標(biāo)準(zhǔn)的暈動(dòng)癥問卷。

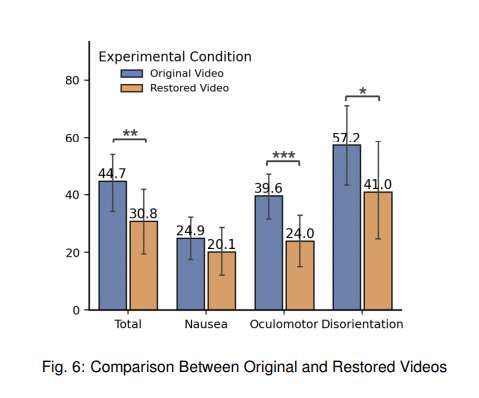

在驗(yàn)證數(shù)據(jù)滿足正態(tài)分布假設(shè)后,團(tuán)隊(duì)對問卷得出的指標(biāo)進(jìn)行了配對樣本t檢驗(yàn)和效應(yīng)量計(jì)算。如圖6所示,結(jié)果分析顯示,參與者觀看修復(fù)視頻后(平均=30.75,標(biāo)準(zhǔn)差=25.61)報(bào)告的總體SSQ得分顯著低于(t=3.7999,p<.01,Cohen’s d=.591)觀看原始視頻(平均=44.67,標(biāo)準(zhǔn)差=21.29)。參與者觀看修復(fù)視頻后(平均=24.00,標(biāo)準(zhǔn)差=19.84)報(bào)告的眼動(dòng)不適顯著低于(t=5.1397,p<.01,Cohen’s d=.840)觀看原始視頻(平均=39.58,標(biāo)準(zhǔn)差=17.16)。參與者觀看修復(fù)視頻后(平均=40.99,標(biāo)準(zhǔn)差=37.74)報(bào)告的迷失方向困難顯著低于(t=2.4658,p=.0246,Cohen’s d=.471)觀看原始視頻(平均=57.23,標(biāo)準(zhǔn)差=30.90)。

研究旨在通過抑制對人類感知具有破壞性的光流模式來減輕沉浸式VR環(huán)境中的暈動(dòng)癥。通過將輕量級、即插即用的人工智能模塊集成到標(biāo)準(zhǔn)VR流程中,所提出的方法表明,運(yùn)動(dòng)感知視頻處理可以有效減少感官沖突——而無需依賴網(wǎng)格級場景數(shù)據(jù)、手動(dòng)幾何編輯或?qū)S糜布:诵囊娊馐牵?dāng)將光流重新定義為感知控制信號而非場景幾何的副產(chǎn)品時(shí),它為增強(qiáng)實(shí)時(shí)沉浸式體驗(yàn)中的時(shí)間相干性和視覺舒適度提供了強(qiáng)大手段。

在算法層面,提出的U-MAD模型將運(yùn)動(dòng)感知架構(gòu)設(shè)計(jì)與基于擴(kuò)散的生成框架相結(jié)合,相比U-Net Diffusion和DIT等傳統(tǒng)基線表現(xiàn)出顯著改進(jìn)。這種性能提升主要?dú)w因于在生成過程中引入光流信號作為顯式指導(dǎo),這為幀間運(yùn)動(dòng)估計(jì)提供了強(qiáng)先驗(yàn)。先前研究強(qiáng)調(diào)了光流在保持運(yùn)動(dòng)連續(xù)性中的作用,結(jié)果進(jìn)一步驗(yàn)證了這一原則。特別是,U-MAD持續(xù)提高了時(shí)間相干性并抑制了閃爍和重影偽影,尤其是在視覺復(fù)雜或快速移動(dòng)的場景中。相關(guān)改進(jìn)在量化指標(biāo)和用戶反饋中都很明顯。用戶研究中的參與者報(bào)告頭暈、惡心和迷失方向癥狀顯著減少,表明U-MAD實(shí)現(xiàn)的運(yùn)動(dòng)一致性不僅在算法上有效,而且增強(qiáng)了真實(shí)世界的感知舒適度。

與傳統(tǒng)方法相比,所提出的方法保留了視覺保真度、交互自由度和場景細(xì)節(jié),從而避免了與不適緩解技術(shù)相關(guān)的常見權(quán)衡。另外,它在程序化生成和動(dòng)態(tài)環(huán)境中有效泛化,增強(qiáng)了其在實(shí)際部署中的實(shí)用性。

盡管所提出的方法顯示出明顯優(yōu)勢,但它同時(shí)面臨一些實(shí)際挑戰(zhàn),并需要進(jìn)一步討論。訓(xùn)練過程雖然是離線進(jìn)行的,但由于結(jié)合了基于擴(kuò)散的生成和密集光流估計(jì),它產(chǎn)生了顯著的計(jì)算成本。這種資源需求與在邊緣AI部署深度生成模型的已知挑戰(zhàn)一致。為解決這一問題,團(tuán)隊(duì)推薦采用云輔助流程,其中大規(guī)模訓(xùn)練后采用知識蒸餾、量化或結(jié)構(gòu)化剪枝等壓縮技術(shù),以便在資源受限設(shè)備上高效部署。

另一個(gè)實(shí)際考慮是推理延遲,這深受光流估計(jì)器復(fù)雜性的影響。雖然高保真光流模型增強(qiáng)了視覺質(zhì)量,但它們引入了相當(dāng)?shù)挠?jì)算開銷,呈現(xiàn)了性能與響應(yīng)性之間的權(quán)衡。另外,僅光流可能不足以建模復(fù)雜場景動(dòng)態(tài),如物體變形、快速camera運(yùn)動(dòng)和遮擋。未來研究的一個(gè)潛在方向是改進(jìn)評估協(xié)議,以更好地捕獲對運(yùn)動(dòng)的感知響應(yīng)。

盡管現(xiàn)有指標(biāo)在評估低級圖像保真度方面有效,但它們往往在測量時(shí)間連續(xù)性和穩(wěn)定性方面不足——這些因素對沉浸式體驗(yàn)中的用戶舒適度至關(guān)重要。為了推動(dòng)領(lǐng)域發(fā)展,團(tuán)隊(duì)倡導(dǎo)開發(fā)時(shí)間感知和感知驅(qū)動(dòng)的基準(zhǔn),更緊密地結(jié)合人類對運(yùn)動(dòng)偽影的敏感性,尤其是在實(shí)時(shí)和交互式VR條件下。這種方法可以通過納入光流之外的額外運(yùn)動(dòng)線索來進(jìn)一步改進(jìn)。結(jié)合camera姿態(tài)估計(jì)、物體追蹤和語義運(yùn)動(dòng)分割等信號可能幫助模型更好地捕獲復(fù)雜場景動(dòng)態(tài)。多模態(tài)融合和跨注意力架構(gòu)的進(jìn)步為結(jié)合視覺、空間和語義輸入到統(tǒng)一運(yùn)動(dòng)表示提供了有希望的途徑,從而支持跨多樣視頻域的更廣泛泛化。

不過,U-MAD展示了在沉浸式環(huán)境中進(jìn)行感知引導(dǎo)視頻生成的有希望方向。所述方法不是強(qiáng)迫用戶適應(yīng)系統(tǒng)約束,而是靈活、自適應(yīng)且實(shí)時(shí)地使視覺內(nèi)容適應(yīng)人類感知需求。通過將算法生成與感知原則橋接,這項(xiàng)工作為有效且以用戶為中心的暈動(dòng)癥緩解開辟了新機(jī)遇。

相關(guān)論文:Flow-Aware Diffusion for Real-Time VR Restoration: Enhancing Spatiotemporal Coherence and Efficiency

https://arxiv.org/pdf/2506.18786

總的來說,U-MAD是一種基于運(yùn)動(dòng)感知擴(kuò)散的框架,通過感知引導(dǎo)的光流抑制來緩解沉浸式視頻應(yīng)用中的暈動(dòng)癥。不同于以硬件為中心或依賴幾何的解決方案,所提出方法完全在圖像層面操作,并在不妥協(xié)視覺保真度或用戶能動(dòng)性的情況下跨多樣環(huán)境泛化。通過光流引導(dǎo)監(jiān)督和即插即用架構(gòu)設(shè)計(jì)的結(jié)合,U-MAD在客觀時(shí)間一致性和主觀視覺舒適度方面均實(shí)現(xiàn)了顯著改進(jìn)。這些結(jié)果凸顯了將視頻生成模型與感知原則對齊以解決VR系統(tǒng)中長期存在挑戰(zhàn)的潛力。

盡管有其優(yōu)勢,U-MAD在計(jì)算效率和表達(dá)能力方面面臨限制。未來工作將探索輕量級、域自適應(yīng)光流網(wǎng)絡(luò)以減少推理開銷,以及多模態(tài)運(yùn)動(dòng)線索以增強(qiáng)場景理解。另外,團(tuán)隊(duì)倡導(dǎo)開發(fā)時(shí)間感知、感知驅(qū)動(dòng)的評估指標(biāo),以更好地將模型評估與人類對運(yùn)動(dòng)偽影的敏感性對齊。