查看引用/信息源請點擊:中國AI網

成功生成了語義準確、布局連貫且物理合理的三維場景

(中國AI網 2025年11月14日)長期以來,自動化生成高質量、布局合理的三維場景一直是計算機視覺和圖形學領域追求的目標。傳統的三維場景創建高度依賴專業人士的手工建模,費時費力。盡管近年來基于大型語言模型或圖像生成模型的方法取得了一定進展,但在空間合理性和多視角一致性方面仍存在明顯短板。

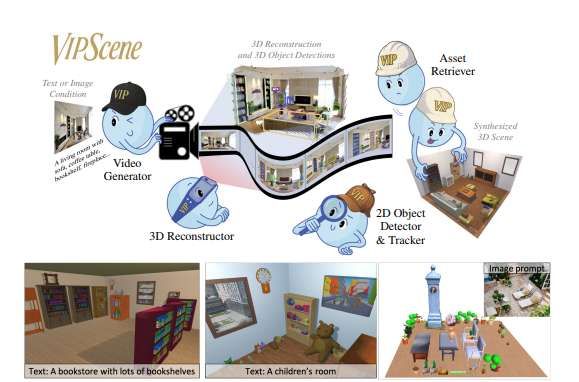

針對這個問題,清華大學,慕尼黑工業大學,蘇黎世聯邦理工學院,慕尼黑機器學習中心,微軟和斯坦福大學團隊發布了一項名為VIPScene的創新研究,并提出了一種全新的解決方案。通過巧妙利用視頻生成模型中蘊含的物理世界常識,他們成功生成了語義準確、布局連貫且物理合理的三維場景,為虛擬現實等領域帶來了新的可能性。

現有的自動化三維場景生成方法主要依賴于兩類技術:

基于大型語言模型的方法:這類方法利用LLM的文本理解和常識推理能力來規劃場景布局。然而,LLM本質上缺乏對三維空間的直觀理解,其生成的布局描述往往不夠完整或精確,導致最終場景中出現物體擺放不合理、空間利用率低下等問題。

基于圖像生成模型的方法:這類方法通過從單一或少量圖像視角進行擴散和修復來構建場景。雖然能利用強大的視覺先驗,但極易受限于固定視角,難以保證不同視角下場景布局的一致性,常出現物體“幻覺”和空間錯位。

另外,評估體系的不完善也阻礙了技術的發展。現有評估指標(如CLIPScore, VQAScore)大多依賴單一的俯視圖來進行場景與文本的匹配度判斷。俯視圖不僅會丟失大量物體細節和語義信息,而且其本身在視覺語言模型的訓練數據中可能占比不足,導致評估結果不可靠,難以真實反映場景質量。

VIPScene:基于視頻感知的創新框架

面對上述挑戰,研究團隊提出了VIPScene框架,其核心思想是:利用在海量視頻數據上訓練出來的視頻生成模型所內嵌的、關于三維物理世界的強大常識知識。視頻模型在生成連續幀的過程中,天然地需要維持時空一致性,這使其對物體間的空間關系和場景的合理布局有著比圖像模型或純語言模型更深刻的理解。

VIPScene的工作流程清晰劃分為兩大階段:場景理解與場景組裝,技術細節豐富且環環相扣。

階段一:場景理解——從提示到三維結構

視頻生成:給定一個文本描述(如“一個配有沙發、茶幾和電視的現代客廳”)或一張場景圖片,VIPScene首先使用條件視頻生成模型(如Cosmos)生成一段第一人稱視角的探索式視頻。這段視頻連續且連貫地展現了場景的不同部分,為后續處理提供了豐富的多視角信息。

三維重建:從生成的視頻中以固定幀率采樣多幀圖像,然后使用先進的多視圖三維重建方法(如Fast3R)快速生成整個場景的三維點云。為了獲得具有真實世界尺度的場景,研究團隊還采用單目深度估計模型(如UniDepth)對重建結果進行度量尺度的校正。

物體檢測與分解:直接在三噪點點云上進行3D物體檢測效果不佳。VIPScene另辟蹊徑,采用2D-3D聯合策略:

在每一幀視頻圖像上,使用開放詞匯的2D檢測與分割模型(如Grounded-SAM)識別并分割出各個物體。

利用多視圖匹配模型(如MASt3R)強大的像素級對應關系估計能力,將不同幀中檢測到的同一物體進行關聯和跟蹤,為每個物體賦予唯一ID。

根據跟蹤結果,從重建的3D點云中提取出每個物體對應的點集。為了應對點云噪點,團隊設計了一種自適應形態學腐蝕算法,根據物體大小動態調整去噪強度,有效濾除邊緣噪點,得到干凈的物體點云。

階段二:場景組裝——從結構到可渲染場景

3D資產檢索:目標是用高質量的三維模型替換掉提取出的粗糙物體點云。檢索過程綜合考慮多種因素:

幾何對齊:這是VIPScene的亮點之一。對于每個物體點云,先通過主成分分析估計其大致朝向,然后使用迭代最近點算法,在大型3D資產庫(如Objaverse的子集)中為每個物體尋找能夠最優匹配其點云形狀的候選模型。這確保了替換后的資產在幾何形態上與原始布局高度吻合。

物體姿態優化:檢索到的資產尺寸可能與原布局不完全匹配,導致物體間發生穿插或碰撞。為此,VIPScene引入了一個輕量級的優化步驟,通過最小化一個損失函數來微調物體的位置:

位置損失:確保物體不會偏離其初始合理位置太遠。

重疊損失:懲罰物體之間邊界框的交疊面積,有效消除碰撞。

邊界損失(可選):確保物體保持在房間邊界內部。

通過梯度下降迭代優化,最終得到一個既保持原始布局意圖,又無碰撞、符合物理規律的場景。

FPVScore:更可靠的評估新標準

為了解決評估難題,團隊同時提出了第一人稱視角評分。該方法摒棄了單一的俯視圖,轉而在生成場景的中心放置一個虛擬相機,渲染出一系列環繞的第一人稱視圖,并將它們拼接成一個全景視覺摘要。然后,將這個摘要輸入到先進的多模態大語言模型(如GPT-4o、Gemini)中,并輔以精心設計的結構化提示詞,要求模型根據語義正確性、布局合理性和整體偏好等維度對場景進行評分和排名。

實驗表明,FPVScore與人類評價者的判斷結果具有更高的相關性(Kendall’s Tau = 0.39),遠優于基于俯視圖的傳統指標,為未來研究提供了一個更可靠、更人性化的自動化評估工具。

在詳盡的實驗對比中,VIPScene在定量和定性評估上均顯著優于當前最先進的基線方法(Holodeck和Architect)。用戶研究顯示,在提示遵循度、布局正確性和整體偏好三個關鍵指標上,VIPScene生成的場景獲得了最高分。

另外,定性結果表明,相較于Holodeck常出現的空間浪費或布局稀疏,以及Architect產生的違反常識的物體擺放,VIPScene生成的場景布局更加飽滿、合理且逼真,物體間的空間關系處理得當。同時,消融研究進一步證實了2D感知模型、點云去噪和姿態優化等核心組件的有效性。

相關論文:Video Perception Models for 3D Scene Synthesis

https://arxiv.org/pdf/2506.20601

團隊成員指出:“VIPScene的核心優勢在于它解鎖了視頻生成模型中蘊藏的豐富空間常識,這使我們能夠生成不僅在語義上符合描述,而且在物理上和功能上都高度可信的3D環境。”

這項技術有望在多個領域產生即時影響,包括虛擬現實,因為它可以快速生成大量多樣且逼真的虛擬場景,從而提升開發效率。