查看引用/信息源請點擊:中國AI網

AIGODIS的多維度質量度量、局部失真區域的精準定位,以及基于反饋的自動化圖像優化

(中國AI網 2025年11月17日)隨著生成式AI在圖像創建領域的快速發展,AI生成全景圖像因其在虛擬現實和增強現實應用中的潛力而備受關注。然而,這類圖像存在的獨特質量問題,如幾何扭曲、語義不合理性以及文本-圖像對應性差,嚴重影響了沉浸式用戶體驗。當前,缺乏專門用于系統評估和優化AI生成全景圖像(AIGODIS)質量的數據集和計算方法。

為解決這一問題,海交通大學,天津大學,華東師范大學,法國南特大學團隊構建了首個綜合性人類反饋數據庫OHF2024,并基于此提出了兩個新型計算模型:BLIP2OIQA(用于圖像質量評估)和BLIP2OISal(用于失真感知顯著性預測)。這項研究首次實現了對AIGODIS的多維度質量度量、局部失真區域的精準定位,以及基于反饋的自動化圖像優化。

研究團隊系統地構建了OHF2024數據庫,其流程如下:

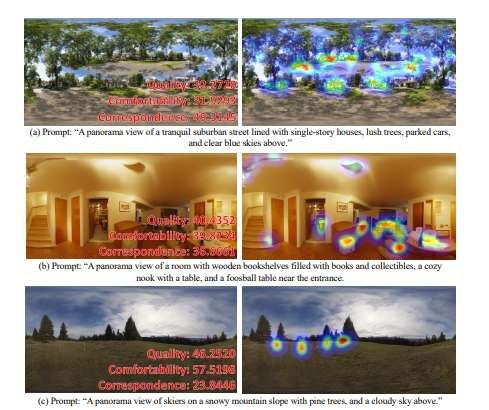

數據生成:研究從50個涵蓋室內外場景的文本提示詞出發,采用了五種代表性的生成模型(MVDiffusion, Text2Light, DALLE, omni-inpainting, 及一個微調的Stable Diffusion模型)進行圖像生成,最終獲得600張AIGODIS,確保了數據源的多樣性。

主觀實驗設計:在嚴格控制的實驗環境下,20名具有正常或矯正視力的受試者使用HTC VIVE Pro Eye頭戴式顯示器,對每張圖像從三個預定義的維度進行評分:

質量:評估顏色、光照、清晰度等低層視覺屬性。

舒適度:評估由圖像失真、結構變形等引起的視覺不適感,該維度對VR/AR應用至關重要。

對應性:評估生成圖像與輸入文本提示詞的語義一致性。

失真感知標注:除了評分,受試者還通過手柄點擊提供了圖像中嚴重失真區域的坐標數據。這些數據經處理后生成了600張連續的失真感知顯著圖,為模型訓練提供了像素級的監督信號。

數據處理與統計分析:主觀評分遵循ITU-R BT.500標準進行異常值剔除和Z-score歸一化,最終計算得到每個圖像的三個平均意見得分(MOS)。統計分析表明,三個評估維度間的斯皮爾曼秩相關系數僅為中等或弱相關(0.4-0.61),證實了多維度評估框架的必要性。

BLIP2OIQA模型旨在精確預測人類在三個維度上的視覺體驗分數。其技術架構包含以下核心組件:

視口分割與特征提取:模型首先將輸入的等距柱狀投影全景圖渲染為六個視口圖像(上、下、前、后、左、右,FOV=110°)。每個視口圖像與文本提示詞一同輸入一個基于BLIP-2構建的共享編碼器。該編碼器利用其Q-Former模塊,通過交叉注意力機制,生成每個視口的文本-圖像融合特征。

注意力特征聚合模塊:該模塊模擬人類瀏覽全景圖時的認知過程。首先,自注意力層捕捉每個視口內部的質量信息。隨后,三個獨立的交叉注意力層(權重不共享)分別處理視口間特征,專門用于提取與“質量”、“舒適度”和“對應性”相關的全局一致性信息。例如,舒適度交叉注意力層會重點關注視口間的幾何連貫性和風格一致性。

分數回歸:聚合后的三個視角感知特征向量,分別通過三個獨立的多層感知機(MLP)回歸頭,映射為最終的維度分數。訓練中使用L1損失函數直接優化預測分數與MOS之間的差異。

BLIP2OISal模型的任務是輸出一張與輸入全景圖分辨率相同的顯著圖,高亮顯示存在嚴重失真的視覺顯著區域。與BLIP2OIQA不同,該模型將整張全景圖(不進行視口分割)與文本提示詞輸入共享編碼器,以獲得全局的文本-圖像融合特征,并保留編碼過程中產生的多層圖像特征以提供空間細節。

團隊進行了廣泛的實驗以驗證模型性能。對于IQA性能,在OHF2024測試集上,BLIP2OIQA在質量、舒適度、對應性三個維度的評估中,其斯皮爾曼秩相關系數(SRCC)和皮爾遜線性相關系數(PLCC)均顯著優于包括MANIQA、HyperIQA等在內的21種先進無參考IQA模型。交叉生成模型測試進一步證明了其良好的泛化能力。

對于顯著性預測性能,BLIP2OISal在失真感知任務上,在CC、NSS、KLD等多個關鍵指標上全面超越了20種傳統及深度學習顯著性預測模型,表明其能更有效地定位與失真相關的視覺注意力區域。

另外,消融研究顯示,通過系統性移除模型組件(如視口分割、注意力模塊、特征融合模塊等)的實驗,證實了所提出架構中每個核心組件的有效性,尤其是交叉注意力機制和文本-圖像特征融合對性能提升貢獻顯著。

同時,研究團隊演示了一個完整的自動化優化閉環。所述流程首先利用BLIP2OIQA篩選出低質量圖像,隨后使用BLIP2OISal預測其失真區域并生成二值掩碼。將該掩碼與原始圖像輸入至MVDiffusion的修復模塊中,對指定區域進行內容重生成。定量與定性結果均顯示,優化后的圖像在BLIP2OIQA預測分數和后續人工評分上均有顯著提升,驗證了該優化流程的有效性。

相關論文:Quality Assessment and Distortion-aware Saliency Prediction for AI-Generated Omnidirectional Images

https://arxiv.org/pdf/2506.21925

這項研究通過構建高質量的OHF2024數據庫和提出性能卓越的BLIP2系列模型,為解決AI生成全景圖像的質量評估與優化問題提供了首個端到端的解決方案。它不僅推動了沉浸式媒體內容質量評估領域的研究進展,同時為AIGC在VR/AR產業中的實際應用提供了關鍵的工具和方法。