查看引用/信息源請點擊:中國AI網

讓數字面孔的細微表情、鏡面高光乃至發絲眼鏡都變得前所未有的清晰與生動

(中國AI網 2025年11月20日)在追求元宇宙與數字交互極致體驗的今天,如何創造一個既真實又靈活的數字人面部Avatar,一直是計算機視覺領域的核心挑戰。針對這個問題,瑞士蘇黎世聯邦理工學院的研究團隊帶來了一個名為HyperGaussians的技術,它如同給當前最流行的3D建模技術“3D高斯飛濺”進行了一次“高維進化”,讓數字面孔的細微表情、鏡面高光乃至發絲眼鏡都變得前所未有的清晰與生動。

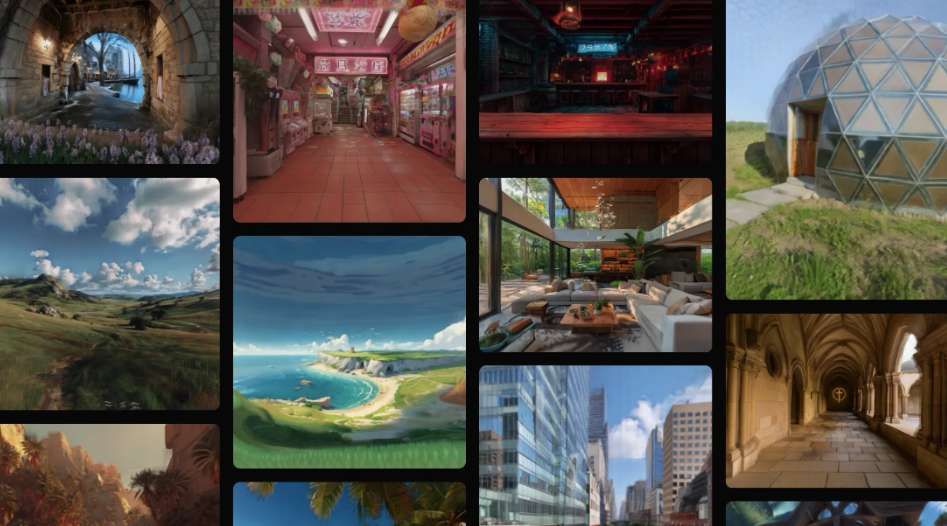

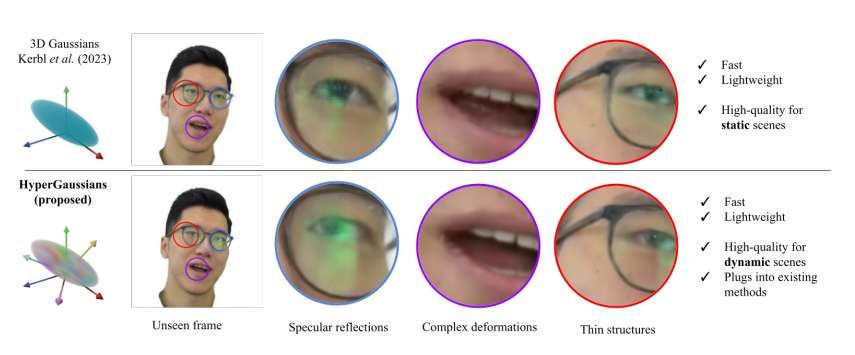

3D高斯飛濺自誕生以來,以其驚艷的渲染速度和渲染質量,迅速成為三維場景表示的新標準。其核心在于用數以萬計、帶有顏色、透明度和三維方向的小橢球來“潑濺”出一整個場景,從而實現實時、逼真的渲染。

然而,當這項技術應用于從單目視頻創建可驅動、可動畫的面部Avatar時,瓶頸出現了。現有的頂尖方法,如FlashAvatar、MonoGaussianAvatar等,通常將高斯點綁定在參數化人臉模型上,并利用神經網絡根據表情參數來預測每個高斯點的位置、旋轉和尺度的偏移量。

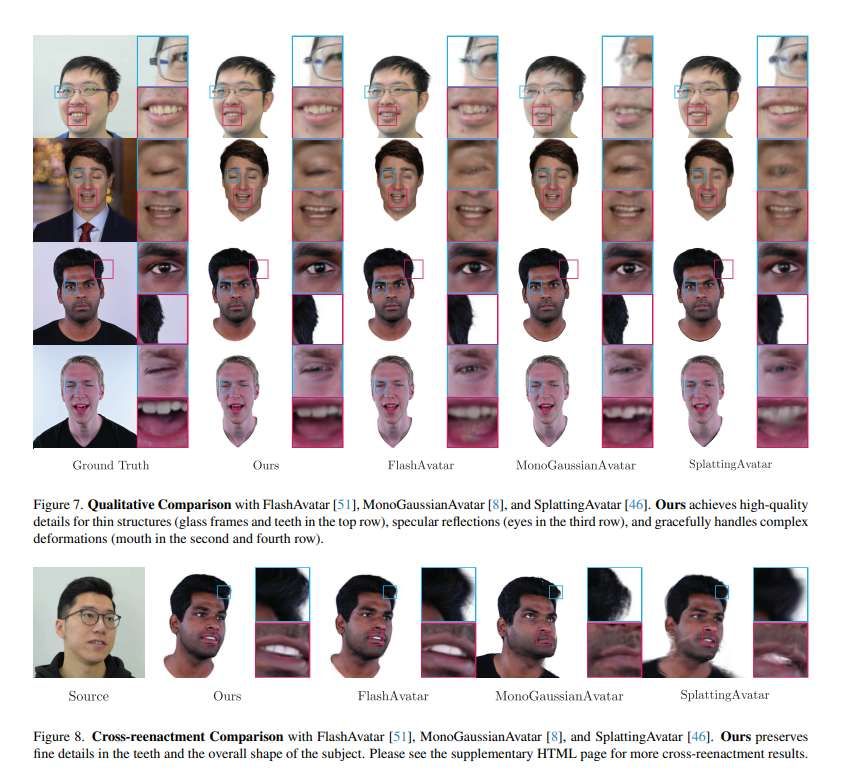

團隊解釋道:“這就像給一個基礎骨架蒙上皮膚,再通過神經網絡讓皮膚微微變形。但這種方法在應對極度局部和非線性的變化時,顯得力不從心。” 圖7清晰地展示了這種窘境:現有方法渲染的眼鏡框粗大模糊,牙齒粘連在一起,眼球的高光反射呆板且錯誤,閉眼動作也產生了不自然的變形。

瑞士蘇黎世聯邦理工學院團隊意識到,問題或許不在于預測網絡的復雜度,而在于高斯表示本身的“表達能力”上限。他們提出了一個根本性的問題:如果我們不讓高斯點停留在3D空間,而是將它們提升到更高維度的空間,會發生什么?

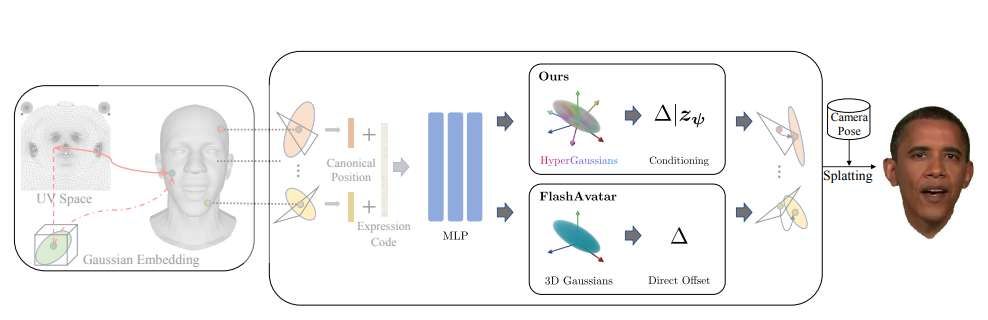

這就是HyperGaussians的核心理念。它將每個傳統的高斯點,從一個3D的橢球,擴展為一個在 (m+n) 維空間中的高維高斯分布。

你可以想象一下,傳統的3D高斯就像一個只有長、寬、高三個屬性的點。而HyperGaussians則將這個點放置在一個更高維度的空間中,比如一個(3+8)維的空間。其中,3維是我們熟悉的位置、旋轉和縮放(稱為屬性維度),而新增的8維(稱為潛在維度)則是一個可學習的、包含豐富局部上下文信息的“嵌入編碼”。

這個高維空間中的點,是一個完整的、具有高維均值和協方差的多元高斯分布。在渲染每一幀時,系統會根據當前的表情參數,為每個高斯點計算出一個具體的8維“潛在狀態”。然后,通過一個稱為 “條件化” 的數學過程,從這個高維高斯分布中,精準地“切片”出一個標準的3D高斯。這個被切片出來的3D高斯,其位置、形狀和方向已經根據當前的“潛在狀態”進行了動態且精細的調整。

這就好比一個變形金剛,它在高維空間里擁有無數種形態可能性(由潛在維度定義),而根據不同的指令(表情參數),它能即時變形成最適合當前狀態的那個精確的3D形態。

然而,高維計算通常伴隨著巨大的計算成本。在“條件化”過程中,需要反復計算高維協方差矩陣的逆矩陣,這在實時渲染中幾乎是不可行的。

研究團隊最大的工程貢獻在于提出了 “逆協方差技巧”。他們巧妙地轉換了數學思路,不去直接操作協方差矩陣,而是轉而操作其逆矩陣——精度矩陣。這一轉換將計算瓶頸從需要處理龐大的潛在維度矩陣,轉化為只處理微小的屬性維度矩陣。

具體來說,無論潛在維度是8維還是128維,系統都只需要對一個固定的3x3或4x4的小矩陣進行求逆。這一技巧使得高維高斯的渲染效率提升了上百倍,甚至更高,從而讓HyperGaussians的實時應用從理論走向了現實。

為了證明其通用性和強大能力,研究團隊將HyperGaussians直接“嫁接” 到了當前最快的單目視頻Avatar系統——FlashAvatar。

整個集成過程十分優雅:他們唯一所做的改動,就是將FlashAvatar中預測高斯點位置、旋轉、縮放偏移量的網絡輸出,替換為一個預測“潛在狀態”編碼的輸出。然后,這個編碼被送入HyperGaussians模塊,由后者來生成最終的條件化偏移量。模型的其余部分,包括網絡結構、損失函數、所有超參數,均原封不動。

為了證明HyperGaussians的普適性和強大,團隊進行了一項極為“克制”的驗證:他們選擇了當前最快的單目Avatar系統之一FlashAvatar,然后只做了一個改動:將其輸出端預測的偏移量,替換為預測潛在編碼,并接入HyperGaussian模塊來生成最終的偏移量。模型的架構、損失函數、所有超參數,甚至訓練幀數和迭代次數都保持原封不動。

實驗結果令人震驚。在包含19個不同人物的5個公開數據集上的定量分析顯示,這個“微創手術”后的系統,在PSNR、SSIM和LPIPS所有關鍵指標上均實現了最佳表現。

更令人信服的是視覺效果的飛躍,如圖7和8所示:

薄結構:眼鏡框不再是模糊的色塊,而是呈現出清晰的幾何結構;牙齒顆顆分明,間隙可見。

鏡面反射:眼球上的高光能隨視角和表情自然移動,眼鏡片上的反射也更加真實。

復雜變形:閉眼動作自然流暢,嘴角的拉扯等非線性變形更加符合生理規律。

收斂速度:在訓練的早期階段,使用HyperGaussians的模型就呈現出更銳利的細節,表明其優化過程更為高效。

由于HyperGaussians的本質是概率分布,其條件協方差矩陣自然地蘊含了每個高斯點在各種表情下的變化程度。研究團隊將其解釋為一種 “不確定性” 。當他們將這些不確定性可視化時,發現高不確定性區域(顯示為紅色)恰好集中在語義上復雜、易變的部位,如嘴角、眼周和眉毛。這一涌現出的特性,無需任何額外監督,就為理解模型的“認知焦點”提供了一個直觀的窗口。

團隊同時將HyperGaussians成功集成到了另一個名為GaussianHeadAvatar的系統,僅增加了5.6%的訓練時間就獲得了視覺質量的顯著提升,這進一步證明了其強大的通用性。

相關論文:HyperGaussians: High-Dimensional Gaussian Splatting for High-Fidelity Animatable Face Avatars

https://arxiv.org/pdf/2507.02803

HyperGaussians的成功揭示了一個重要方向:提升基礎表示單元的表達能力,往往能帶來比單純堆疊網絡復雜度更顯著的收益。這種“即插即用”的特性,使得它有望成為未來許多基于高斯飛濺的動態場景建模系統的標準組件。

研究人員同時表示,未來將探索HyperGaussians在全身數字人、動態服裝模擬以及更廣泛的通用動態場景中的應用。當然,團隊強調了所述技術可能被濫用于制作深度偽造的風險,并呼吁業界共同建立負責任的使用規范與倫理準則。