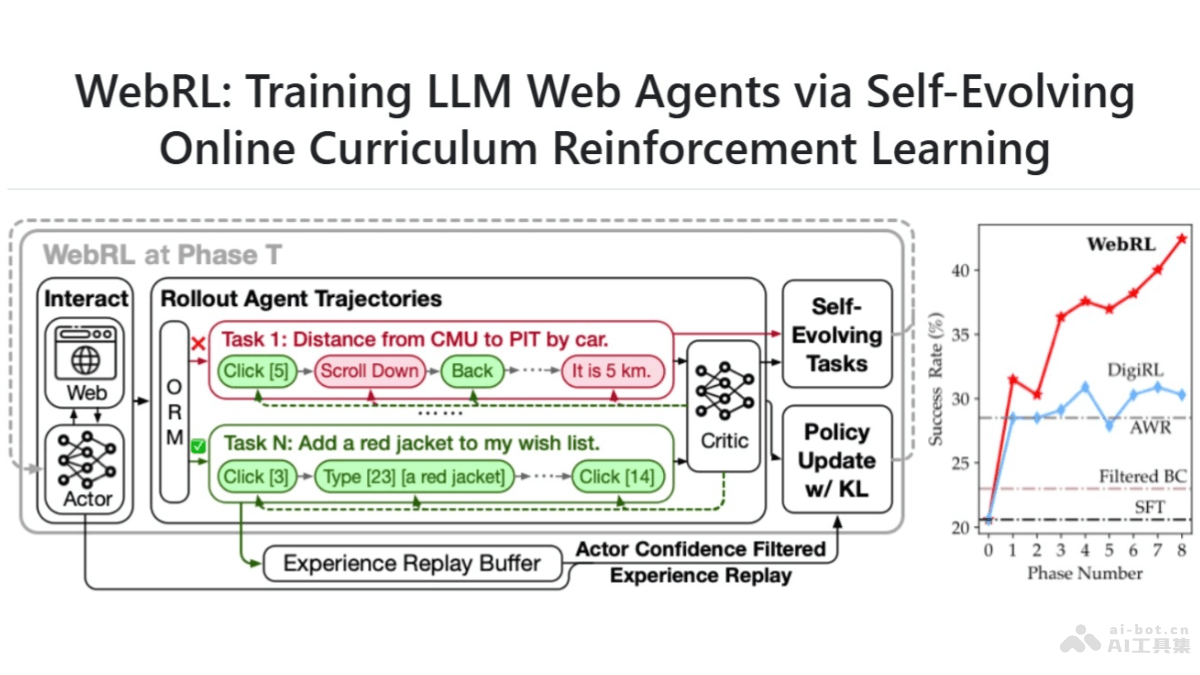

WebRL是清華大學、智譜AI聯合推出的自我進化的在線課程強化學習框架,訓練使用開放大型語言模型(LLMs)的高性能網絡代理。WebRL動態生成任務、結果監督獎勵模型(ORM)評估任務成功與否,及自適應強化學習策略,解決訓練任務稀缺、反饋信號稀疏和在線學習中的策略分布漂移等挑戰。WebRL顯著提升了Llama-3.1和GLM-4等模型在WebArena-Lite基準測試中的成功率,超越專有LLM API和之前訓練的網絡代理,證明在提升開源LLMs網絡任務能力方面的有效性。

WebRL的主要功能自我進化課程學習:WebRL能從失敗的嘗試中生成新任務,動態調整任務的難度和復雜性,適應智能體當前的技能水平。結果監督獎勵模型(ORM):WebRL訓練一個ORM評估任務的成功與否,提供二進制獎勵信號(成功為1,失敗為0),指導智能體的學習過程。自適應強化學習策略:基于KL散度約束的策略更新算法,WebRL限制策略更新過程中的分布漂移,確保智能體在新任務學習中不會偏離已有知識太遠。經驗回放緩沖區:WebRL用經驗回放緩沖區保留先前的成功經驗,減輕災難性遺忘的風險,在訓練中重用經驗。持續性能提升:WebRL基于迭代自我進化,讓智能體在在線環境中持續、一致地提高性能。WebRL的技術原理問題表述:WebRL將網絡任務建模為有限視界的馬爾可夫決策過程(MDP),定義狀態、動作、獎勵和轉移概率。ORM訓練:基于訓練LLM作為ORM,自動化評估代理的執行軌跡是否成功完成任務,提供反饋信號。強化學習:在在線網絡環境中,WebRL用自我進化的課程學習策略動態生成任務,用KL約束策略更新算法防止策略分布的大幅漂移。經驗回放:基于經驗回放緩沖區來保留先前的知識,減輕災難性遺忘的風險,用存儲成功軌跡避免對錯誤軌跡的中間狀態進行準確估計的挑戰。自我進化的課程學習策略:WebRL實施生成和過濾的兩步流程,生成逐漸更具挑戰性的任務,且仍然適合代理當前的能力,基于In-breadth evolving技術創建新指令。策略更新:WebRL在策略更新時考慮新舊策略之間的KL散度,確保策略的平滑過渡,避免因策略更新導致的性能下降。WebRL的項目地址GitHub倉庫:https://github.com/THUDM/WebRLarXiv技術論文:https://arxiv.org/pdf/2411.02337v1WebRL的應用場景網頁瀏覽自動化:WebRL基于訓練智能體自動完成網頁瀏覽任務,如信息檢索、填寫表單、網上購物等。網絡數據提取:在需要從網頁中提取特定數據(如價格、評論、新聞文章)的場景中,WebRL幫助自動化數據提取過程。客戶服務自動化:在客戶服務領域,作為聊天機器人,用網頁交互解決用戶問題或完成交易。網絡內容管理:對于需要管理大量網絡內容的網站管理員,WebRL自動化內容更新、發布和維護任務。電子商務:在電子商務平臺,幫助自動化訂單處理、庫存管理和客戶交互。

WebRL的主要功能自我進化課程學習:WebRL能從失敗的嘗試中生成新任務,動態調整任務的難度和復雜性,適應智能體當前的技能水平。結果監督獎勵模型(ORM):WebRL訓練一個ORM評估任務的成功與否,提供二進制獎勵信號(成功為1,失敗為0),指導智能體的學習過程。自適應強化學習策略:基于KL散度約束的策略更新算法,WebRL限制策略更新過程中的分布漂移,確保智能體在新任務學習中不會偏離已有知識太遠。經驗回放緩沖區:WebRL用經驗回放緩沖區保留先前的成功經驗,減輕災難性遺忘的風險,在訓練中重用經驗。持續性能提升:WebRL基于迭代自我進化,讓智能體在在線環境中持續、一致地提高性能。WebRL的技術原理問題表述:WebRL將網絡任務建模為有限視界的馬爾可夫決策過程(MDP),定義狀態、動作、獎勵和轉移概率。ORM訓練:基于訓練LLM作為ORM,自動化評估代理的執行軌跡是否成功完成任務,提供反饋信號。強化學習:在在線網絡環境中,WebRL用自我進化的課程學習策略動態生成任務,用KL約束策略更新算法防止策略分布的大幅漂移。經驗回放:基于經驗回放緩沖區來保留先前的知識,減輕災難性遺忘的風險,用存儲成功軌跡避免對錯誤軌跡的中間狀態進行準確估計的挑戰。自我進化的課程學習策略:WebRL實施生成和過濾的兩步流程,生成逐漸更具挑戰性的任務,且仍然適合代理當前的能力,基于In-breadth evolving技術創建新指令。策略更新:WebRL在策略更新時考慮新舊策略之間的KL散度,確保策略的平滑過渡,避免因策略更新導致的性能下降。WebRL的項目地址GitHub倉庫:https://github.com/THUDM/WebRLarXiv技術論文:https://arxiv.org/pdf/2411.02337v1WebRL的應用場景網頁瀏覽自動化:WebRL基于訓練智能體自動完成網頁瀏覽任務,如信息檢索、填寫表單、網上購物等。網絡數據提取:在需要從網頁中提取特定數據(如價格、評論、新聞文章)的場景中,WebRL幫助自動化數據提取過程。客戶服務自動化:在客戶服務領域,作為聊天機器人,用網頁交互解決用戶問題或完成交易。網絡內容管理:對于需要管理大量網絡內容的網站管理員,WebRL自動化內容更新、發布和維護任務。電子商務:在電子商務平臺,幫助自動化訂單處理、庫存管理和客戶交互。