MiLoRA是參數高效的大型語言模型(LLMs)微調方法,通過更新權重分量來矩陣的次要奇異減少計算和內存成本。方法基于奇異值分解(SVD)將權重矩陣分為主要和次要兩部分,主要部分包含重要知識,次要部分包含噪聲或長尾信息。在微調過程中,MiLoRA保持主要部分不變,只優化次要部分,在適應新任務的同時保留預訓練模型的知識。實驗表明,MiLoRA在多個基準測試中性能優于傳統方法,訓練和推理效率更高。

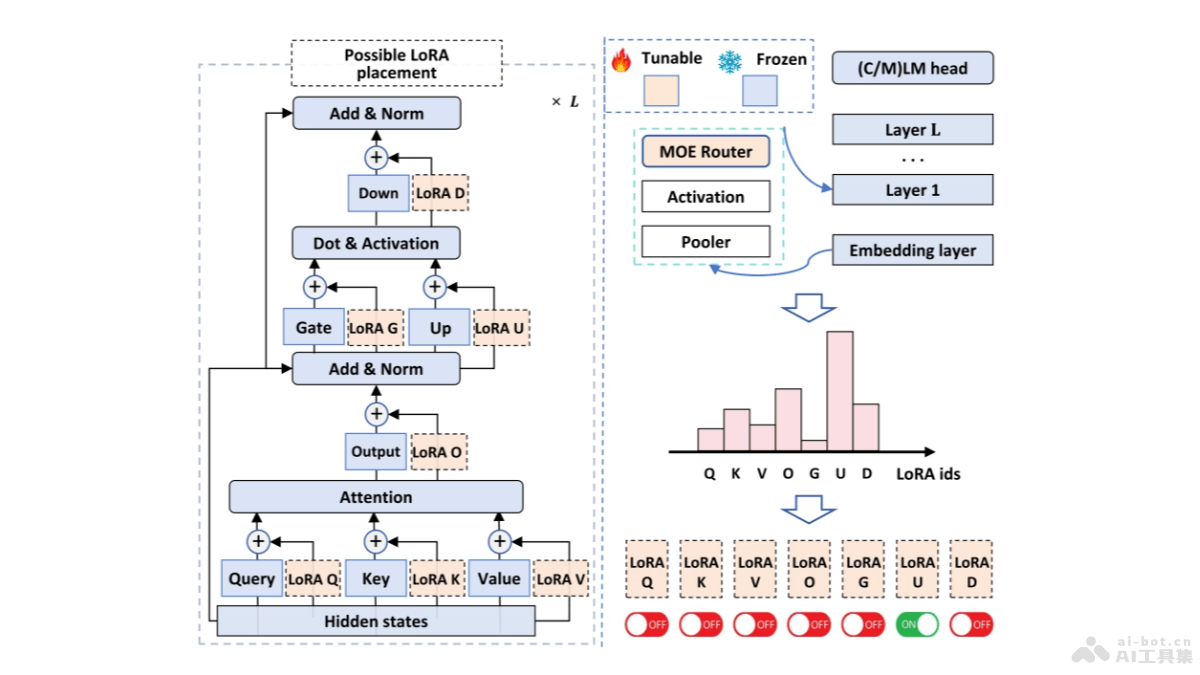

MiLoRA的主要功能參數高效微調:MiLoRA用更少的參數調整來微調大型語言模型,減少計算資源的需求。減少延遲:基于提示的路由機制,MiLoRA減少在多租戶環境中生成新標記時的延遲。性能提升:在各種自然語言處理任務中,MiLoRA顯示出比傳統LoRA方法更好的性能。專家系統:將每個LoRA模塊視為一個專家,基于路由機制動態選擇最合適的專家進行處理。適應性:根據輸入提示動態決定激活哪些LoRA專家,提高模型的適應性和靈活性。MiLoRA的技術原理LoRA模塊作為專家:在MiLoRA中,每個LoRA模塊被視為一個專家,負責處理特定的任務或數據子集。基于提示的路由機制:MiLoRA引入一個基于輸入提示的路由機制,路由機制在生成第一個新標記之前計算專家路由結果,并在后續標記生成中重用結果,避免對每個新標記都進行路由計算的需要。低秩適應(LoRA):基于低秩矩陣對Transformer層的權重進行重新參數化,實現參數的高效調整。動態專家選擇:在Transformer層級上,MiLoRA動態選擇哪個LoRA專家(即哪個Transformer模塊的LoRA)被激活。負載均衡損失:為平衡不同LoRA專家的使用,MiLoRA在訓練過程中加入負載均衡損失,確保模型不會過度依賴某些專家。MiLoRA的項目地址arXiv技術論文:https://arxiv.org/pdf/2410.18035MiLoRA的應用場景自然語言處理任務:MiLoRA應用在各種NLP任務中,如文本分類、情感分析、問答系統、機器翻譯等,提高模型在特定任務上的性能。多租戶環境:在云計算或服務平臺中,用在優化資源利用率,減少延遲提升用戶體驗。在線內容生成:在需要實時生成內容的應用中,如聊天機器人、內容推薦系統等,提高響應速度和處理效率。教育和培訓:用在個性化教育平臺,基于微調模型適應不同學生的學習習慣和需求。醫療咨詢和診斷:在醫療領域,微調模型提供更準確的醫療咨詢和診斷建議。

MiLoRA的主要功能參數高效微調:MiLoRA用更少的參數調整來微調大型語言模型,減少計算資源的需求。減少延遲:基于提示的路由機制,MiLoRA減少在多租戶環境中生成新標記時的延遲。性能提升:在各種自然語言處理任務中,MiLoRA顯示出比傳統LoRA方法更好的性能。專家系統:將每個LoRA模塊視為一個專家,基于路由機制動態選擇最合適的專家進行處理。適應性:根據輸入提示動態決定激活哪些LoRA專家,提高模型的適應性和靈活性。MiLoRA的技術原理LoRA模塊作為專家:在MiLoRA中,每個LoRA模塊被視為一個專家,負責處理特定的任務或數據子集。基于提示的路由機制:MiLoRA引入一個基于輸入提示的路由機制,路由機制在生成第一個新標記之前計算專家路由結果,并在后續標記生成中重用結果,避免對每個新標記都進行路由計算的需要。低秩適應(LoRA):基于低秩矩陣對Transformer層的權重進行重新參數化,實現參數的高效調整。動態專家選擇:在Transformer層級上,MiLoRA動態選擇哪個LoRA專家(即哪個Transformer模塊的LoRA)被激活。負載均衡損失:為平衡不同LoRA專家的使用,MiLoRA在訓練過程中加入負載均衡損失,確保模型不會過度依賴某些專家。MiLoRA的項目地址arXiv技術論文:https://arxiv.org/pdf/2410.18035MiLoRA的應用場景自然語言處理任務:MiLoRA應用在各種NLP任務中,如文本分類、情感分析、問答系統、機器翻譯等,提高模型在特定任務上的性能。多租戶環境:在云計算或服務平臺中,用在優化資源利用率,減少延遲提升用戶體驗。在線內容生成:在需要實時生成內容的應用中,如聊天機器人、內容推薦系統等,提高響應速度和處理效率。教育和培訓:用在個性化教育平臺,基于微調模型適應不同學生的學習習慣和需求。醫療咨詢和診斷:在醫療領域,微調模型提供更準確的醫療咨詢和診斷建議。