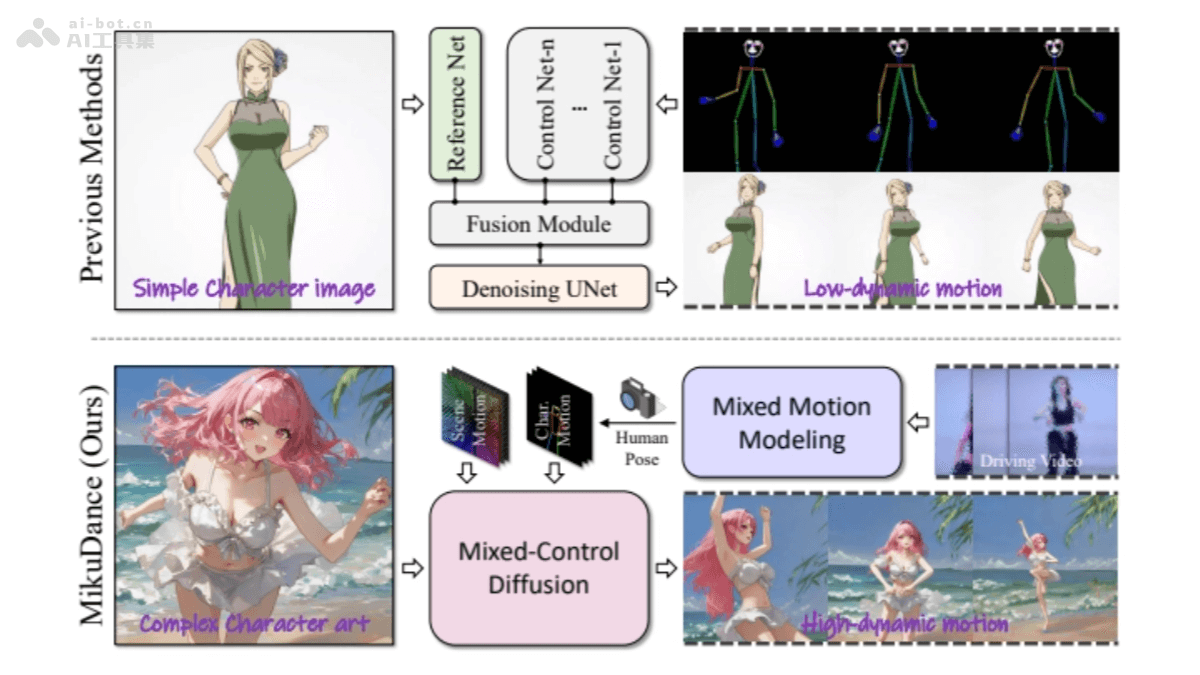

MikuDance是基于擴散模型的動畫生成技術,整合混合運動動力學來動畫化風格化的角色藝術。MikuDance基于混合運動建模和混合控制擴散技術,解決高動態運動和參考引導錯位問題,能顯式建模動態相機和角色運動,隱式對齊角色形狀、姿勢和比例,實現連貫的運動控制。MikuDance在多種角色藝術和運動引導下展現出有效性和泛化能力,生成具有顯著運動動態的高質量動畫。

MikuDance的主要功能動畫化風格化角色藝術:MikuDance能將靜態的角色圖像轉化為動態的動畫,適于風格化的角色藝術,如動漫風格。處理高動態運動:能處理復雜的前景和背景中的高動態運動,包括角色的大幅度動作和相機的快速移動。參考引導對齊:基于隱式對齊技術,處理角色形狀、姿勢和比例與運動引導之間的錯位問題。全局與局部運動控制:結合場景運動跟蹤和運動自適應歸一化模塊,同時控制全局場景運動和局部角色運動。多風格適應性:MikuDance適應多種藝術風格,包括賽璐璐、古典風格和線條素描,顯示出強大的泛化能力。MikuDance的技術原理混合運動建模:將3D相機姿態轉換為像素級場景運動表示,MikuDance顯式建模動態相機和角色運動,實現角色與場景的統一運動建模。混合控制擴散:將參考角色藝術、參考姿勢和所有角色姿勢引導整合到統一的潛在空間中,實現對動畫的對齊運動控制。運動自適應歸一化模塊:將全局場景運動有效地注入到角色動畫中,支持全面的人物造型動畫生成。混合源訓練方法:采用兩階段訓練方法,第一階段用成對視頻幀進行訓練,第二階段加入MAN模塊和時間模塊,用混合MMD視頻剪輯和不含角色的相機運動視頻進行訓練,增強模型的魯棒性和泛化能力。Stable Diffusion的預備知識:MikuDance基于Stable Diffusion(SD)模型,模型包含一個VAE進行圖像的自動編碼,以及一個UNet進行噪聲估計,基于反向擴散過程將噪聲圖像逐步轉化為潛在圖像。MikuDance的項目地址項目官網:kebii.github.io/MikuDanceGitHub倉庫:https://github.com/Kebii/MikuDance(即將開源)arXiv技術論文:https://arxiv.org/pdf/2411.08656MikuDance的應用場景游戲開發:在游戲制作中,快速生成角色動畫,減少傳統動畫制作的成本和時間。電影和電視制作:在電影和電視劇的后期制作中,創造復雜的動態場景和特效,增強視覺沖擊力。虛擬現實(VR)和增強現實(AR):在VR和AR應用中,生成與用戶互動的動態角色,提升沉浸感。動畫制作:對于傳統2D或3D動畫,提供一種新的動畫生成方式,特別是對于風格化的角色動畫。社交媒體內容創作:內容創作者生成具有吸引力的動態圖像和視頻,用在社交媒體平臺。

MikuDance的主要功能動畫化風格化角色藝術:MikuDance能將靜態的角色圖像轉化為動態的動畫,適于風格化的角色藝術,如動漫風格。處理高動態運動:能處理復雜的前景和背景中的高動態運動,包括角色的大幅度動作和相機的快速移動。參考引導對齊:基于隱式對齊技術,處理角色形狀、姿勢和比例與運動引導之間的錯位問題。全局與局部運動控制:結合場景運動跟蹤和運動自適應歸一化模塊,同時控制全局場景運動和局部角色運動。多風格適應性:MikuDance適應多種藝術風格,包括賽璐璐、古典風格和線條素描,顯示出強大的泛化能力。MikuDance的技術原理混合運動建模:將3D相機姿態轉換為像素級場景運動表示,MikuDance顯式建模動態相機和角色運動,實現角色與場景的統一運動建模。混合控制擴散:將參考角色藝術、參考姿勢和所有角色姿勢引導整合到統一的潛在空間中,實現對動畫的對齊運動控制。運動自適應歸一化模塊:將全局場景運動有效地注入到角色動畫中,支持全面的人物造型動畫生成。混合源訓練方法:采用兩階段訓練方法,第一階段用成對視頻幀進行訓練,第二階段加入MAN模塊和時間模塊,用混合MMD視頻剪輯和不含角色的相機運動視頻進行訓練,增強模型的魯棒性和泛化能力。Stable Diffusion的預備知識:MikuDance基于Stable Diffusion(SD)模型,模型包含一個VAE進行圖像的自動編碼,以及一個UNet進行噪聲估計,基于反向擴散過程將噪聲圖像逐步轉化為潛在圖像。MikuDance的項目地址項目官網:kebii.github.io/MikuDanceGitHub倉庫:https://github.com/Kebii/MikuDance(即將開源)arXiv技術論文:https://arxiv.org/pdf/2411.08656MikuDance的應用場景游戲開發:在游戲制作中,快速生成角色動畫,減少傳統動畫制作的成本和時間。電影和電視制作:在電影和電視劇的后期制作中,創造復雜的動態場景和特效,增強視覺沖擊力。虛擬現實(VR)和增強現實(AR):在VR和AR應用中,生成與用戶互動的動態角色,提升沉浸感。動畫制作:對于傳統2D或3D動畫,提供一種新的動畫生成方式,特別是對于風格化的角色動畫。社交媒體內容創作:內容創作者生成具有吸引力的動態圖像和視頻,用在社交媒體平臺。