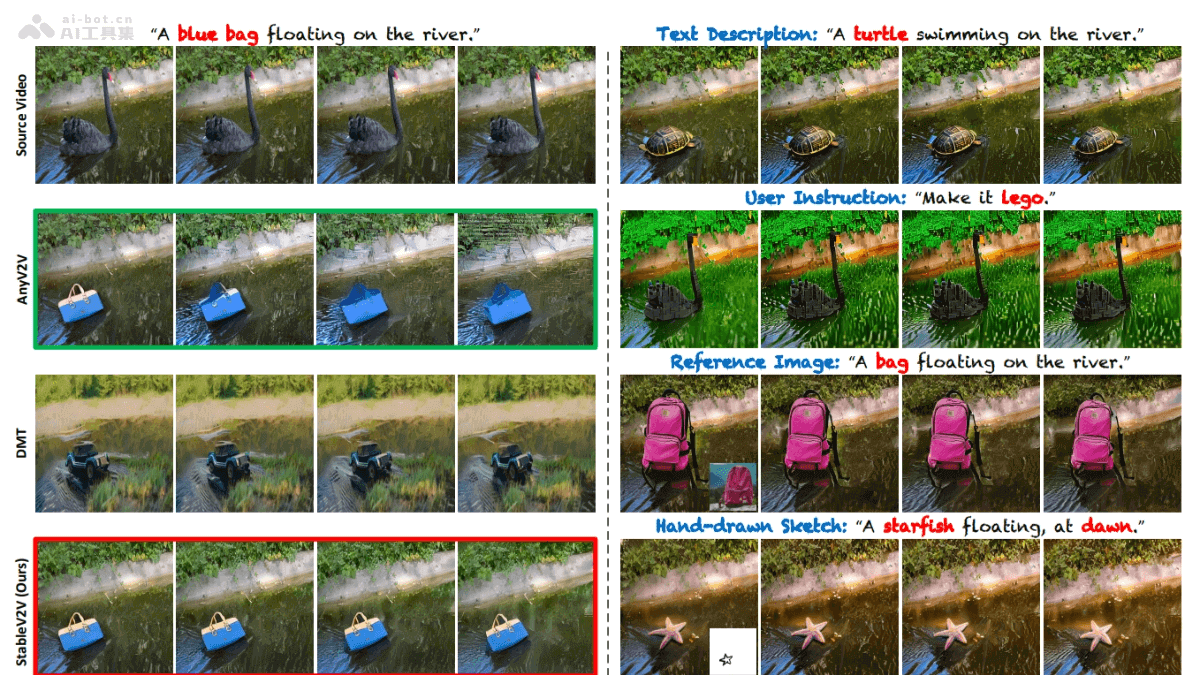

StableV2V是中國科技大學推出的開源視頻編輯項目,基于文本、草圖、圖片等輸入實現視頻中物體的精準編輯和替換。項目用形狀一致的編輯范式,基于三個主要組件:Prompted First-frame Editor(PFE)、Iterative Shape Aligner(ISA)和Conditional Image-to-video Generator(CIG),確保編輯內容與原始視頻動作和深度信息一致,生成自然流暢的編輯視頻。

StableV2V的主要功能基于多種輸入的視頻編輯:支持文本、草圖、圖片等多種輸入方式,實現視頻中物體的編輯和替換。形狀一致性保持:確保編輯后的視頻內容在形狀和運動上與原始視頻保持一致性,即使在物體形狀發生顯著變化時。靈活的用戶提示處理:靈活處理不同類型的用戶提示,提供更廣泛的創意空間。高質量的視頻輸出:生成高質量的編輯視頻,具備出色的視覺效果。StableV2V的技術原理Prompted First-frame Editor (PFE):作為編輯流程的起點,PFE負責將用戶的提示(文本、圖像、草圖等)轉化為視頻的第一幀編輯內容。Iterative Shape Aligner (ISA):ISA基于假設編輯內容與原始內容共享相同的運動和深度信息,用深度圖作為傳遞運動的橋梁。基于運動模擬和深度模擬過程,ISA能計算和傳播平均運動、形狀和深度信息。用形狀引導的深度細化網絡對深度圖進行優化,確保物體與周圍環境的交互看起來自然合理。Conditional Image-to-video Generator (CIG):CIG負責將編輯后的第一幀和優化后的深度圖轉化為完整的編輯視頻。用Ctrl-Adapter作為控制器,將深度圖信息注入生成過程。借助I2VGen-XL將編輯內容從首幀擴展到整個視頻序列,生成高質量的編輯視頻。深度信息的運用:深度圖扮演著關鍵角色,傳遞運動信息和指導視頻生成,確保編輯內容的深度和運動與原始視頻一致。組件協同工作:PFE、ISA和CIG三個組件協同工作,確保從第一幀編輯到視頻生成的整個過程都保持高度的一致性和自然性。StableV2V的項目地址項目官網:alonzoleeeooo.github.io/StableV2VGitHub倉庫:https://github.com/AlonzoLeeeooo/StableV2VHuggingFace模型庫:https://huggingface.co/AlonzoLeeeooo/StableV2VarXiv技術論文:https://arxiv.org/pdf/2411.11045StableV2V的應用場景電影和視頻制作:用在特效制作、場景變換和角色替換,無需重新拍攝即可實現創意視覺效果。社交媒體內容創作:內容創作者快速編輯視頻內容,增加視頻的吸引力和創意,如將普通場景變成藝術風格的作品。教育和培訓:制作教學視頻,將抽象概念形象化,如歷史場景重現或科學現象模擬,及安全演練和技術操作示范。新聞和報道:對現場視頻進行編輯和增強,提供更清晰、更具體的視覺報道,如模擬自然災害發生過程。廣告和營銷:創造更具吸引力的廣告視頻,將產品融入創意場景中,提高廣告的吸引力和記憶度。

StableV2V的主要功能基于多種輸入的視頻編輯:支持文本、草圖、圖片等多種輸入方式,實現視頻中物體的編輯和替換。形狀一致性保持:確保編輯后的視頻內容在形狀和運動上與原始視頻保持一致性,即使在物體形狀發生顯著變化時。靈活的用戶提示處理:靈活處理不同類型的用戶提示,提供更廣泛的創意空間。高質量的視頻輸出:生成高質量的編輯視頻,具備出色的視覺效果。StableV2V的技術原理Prompted First-frame Editor (PFE):作為編輯流程的起點,PFE負責將用戶的提示(文本、圖像、草圖等)轉化為視頻的第一幀編輯內容。Iterative Shape Aligner (ISA):ISA基于假設編輯內容與原始內容共享相同的運動和深度信息,用深度圖作為傳遞運動的橋梁。基于運動模擬和深度模擬過程,ISA能計算和傳播平均運動、形狀和深度信息。用形狀引導的深度細化網絡對深度圖進行優化,確保物體與周圍環境的交互看起來自然合理。Conditional Image-to-video Generator (CIG):CIG負責將編輯后的第一幀和優化后的深度圖轉化為完整的編輯視頻。用Ctrl-Adapter作為控制器,將深度圖信息注入生成過程。借助I2VGen-XL將編輯內容從首幀擴展到整個視頻序列,生成高質量的編輯視頻。深度信息的運用:深度圖扮演著關鍵角色,傳遞運動信息和指導視頻生成,確保編輯內容的深度和運動與原始視頻一致。組件協同工作:PFE、ISA和CIG三個組件協同工作,確保從第一幀編輯到視頻生成的整個過程都保持高度的一致性和自然性。StableV2V的項目地址項目官網:alonzoleeeooo.github.io/StableV2VGitHub倉庫:https://github.com/AlonzoLeeeooo/StableV2VHuggingFace模型庫:https://huggingface.co/AlonzoLeeeooo/StableV2VarXiv技術論文:https://arxiv.org/pdf/2411.11045StableV2V的應用場景電影和視頻制作:用在特效制作、場景變換和角色替換,無需重新拍攝即可實現創意視覺效果。社交媒體內容創作:內容創作者快速編輯視頻內容,增加視頻的吸引力和創意,如將普通場景變成藝術風格的作品。教育和培訓:制作教學視頻,將抽象概念形象化,如歷史場景重現或科學現象模擬,及安全演練和技術操作示范。新聞和報道:對現場視頻進行編輯和增強,提供更清晰、更具體的視覺報道,如模擬自然災害發生過程。廣告和營銷:創造更具吸引力的廣告視頻,將產品融入創意場景中,提高廣告的吸引力和記憶度。