OpenR是一個由倫敦大學學院(UCL)、上海交通大學、利物浦大學、香港科技大學(廣州)和西湖大學聯合推出的一個開源框架,結合搜索、強化學習和過程監督提升大型語言模型(LLM)的推理能力。框架受到OpenAI的o1模型的啟發,模型基于在推理過程中整合強化學習顯著提高模型的推理能力。OpenR是第一個提供集成技術開源實現的框架,支持LLM基于有效的數據獲取、訓練和推理路徑實現高級推理。OpenR支持在線強化學習訓練和多種搜索策略,遵循測試時擴展法則,支持模型在測試時通過生成或搜索方式提供精細化的輸出。OpenR提供一個自動化的數據管道,從結果標簽中提取推理步驟,減少人工標注的工作量,同時確保收集有價值的推理信息。

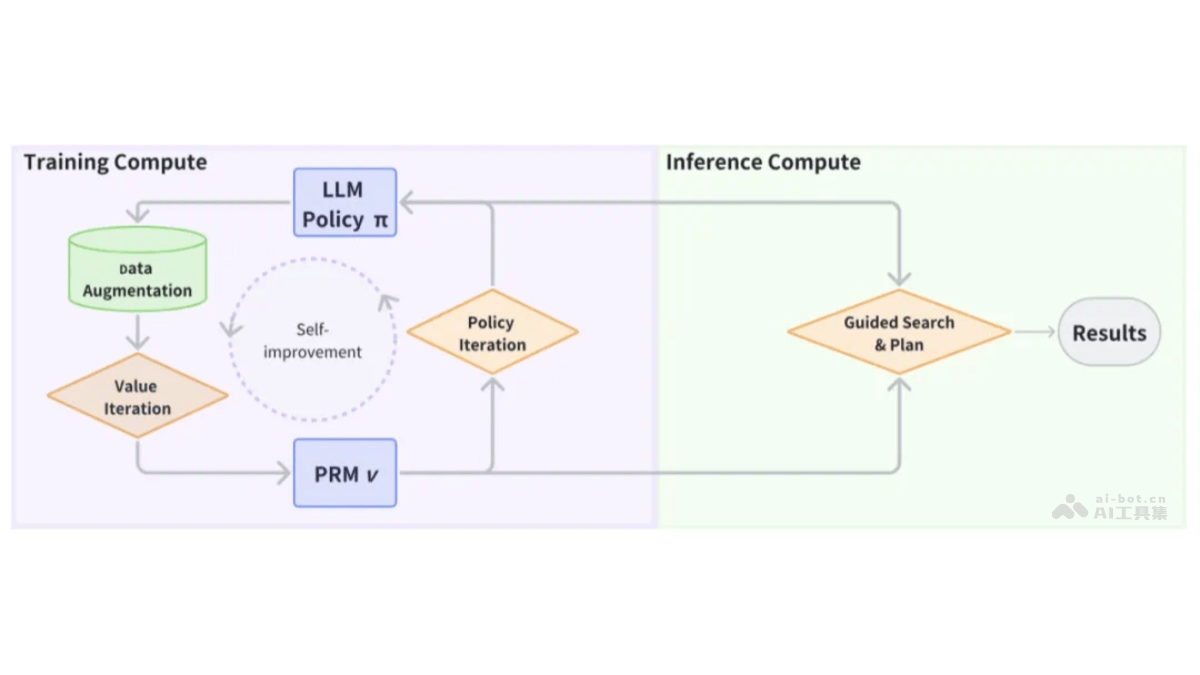

OpenR的主要功能集成訓練與推理:將數據獲取、強化學習訓練(在線和離線)及非自回歸解碼集成在一個統一平臺。過程獎勵模型(PRM):在訓練期間基于策略優化技術改進LLM策略,在解碼階段引導LLM的搜索過程。強化學習環境:將數學問題建模為馬爾可夫決策過程(MDP),基于強化學習方法優化模型策略。多策略搜索與解碼:支持多種搜索算法,如Beam Search、Best-of-N,結合PRM進行的引導搜索和評分。數據增強與自動化標注:基于自動化方法生成合成樣本,減少人工標注依賴,提高數據收集效率。OpenR的技術原理過程獎勵模型(PRM):PRM用在評估解決方案步驟的正確性,基于監督學習訓練,將正確或錯誤的判定作為分類標簽,預測每一步的后續標記。策略迭代:在訓練期間,PRM基于策略優化技術如策略迭代改進LLM策略,在解碼階段,PRM引導LLM的搜索過程,讓推理朝著更有效的結果發展。馬爾可夫決策過程(MDP):將數學問題轉換為MDP,由狀態、動作和獎勵組成,模型生成推理步驟作為動作,根據當前狀態和動作決定下一個狀態。強化學習:用近端策略優化(PPO)和群體相對策略優化(GRPO)等算法進行在線強化學習訓練,優化模型生成的語言輸出。搜索算法:在解碼階段,用PRM評估每個解決步驟的準確性,結合語言模型進行引導搜索和多次生成的評分或投票。OpenR的項目地址項目官網:openreasoner.github.ioGitHub倉庫:https://github.com/openreasoner/openr技術論文:https://github.com/openreasoner/openr/blob/main/reports/OpenR-Wang.pdfOpenR的應用場景數學問題求解:OpenR解決數學問題,基于推理步驟的生成和評估,找到正確的解答路徑。代碼生成和調試:在軟件開發中,OpenR幫助生成代碼片段,或者調試過程中查找和修正代碼中的錯誤。自然語言處理(NLP)任務:OpenR用在機器閱讀理解、問答系統、文本摘要等需要深入理解文本和邏輯推理的NLP任務。教育輔助:在教育領域,OpenR作為輔助工具,幫助學生理解復雜的概念和解題步驟,提供個性化的學習路徑。自動化客戶服務:在客戶服務領域,OpenR基于推理用戶的問題和需求,提供準確的答案和解決方案。

OpenR的主要功能集成訓練與推理:將數據獲取、強化學習訓練(在線和離線)及非自回歸解碼集成在一個統一平臺。過程獎勵模型(PRM):在訓練期間基于策略優化技術改進LLM策略,在解碼階段引導LLM的搜索過程。強化學習環境:將數學問題建模為馬爾可夫決策過程(MDP),基于強化學習方法優化模型策略。多策略搜索與解碼:支持多種搜索算法,如Beam Search、Best-of-N,結合PRM進行的引導搜索和評分。數據增強與自動化標注:基于自動化方法生成合成樣本,減少人工標注依賴,提高數據收集效率。OpenR的技術原理過程獎勵模型(PRM):PRM用在評估解決方案步驟的正確性,基于監督學習訓練,將正確或錯誤的判定作為分類標簽,預測每一步的后續標記。策略迭代:在訓練期間,PRM基于策略優化技術如策略迭代改進LLM策略,在解碼階段,PRM引導LLM的搜索過程,讓推理朝著更有效的結果發展。馬爾可夫決策過程(MDP):將數學問題轉換為MDP,由狀態、動作和獎勵組成,模型生成推理步驟作為動作,根據當前狀態和動作決定下一個狀態。強化學習:用近端策略優化(PPO)和群體相對策略優化(GRPO)等算法進行在線強化學習訓練,優化模型生成的語言輸出。搜索算法:在解碼階段,用PRM評估每個解決步驟的準確性,結合語言模型進行引導搜索和多次生成的評分或投票。OpenR的項目地址項目官網:openreasoner.github.ioGitHub倉庫:https://github.com/openreasoner/openr技術論文:https://github.com/openreasoner/openr/blob/main/reports/OpenR-Wang.pdfOpenR的應用場景數學問題求解:OpenR解決數學問題,基于推理步驟的生成和評估,找到正確的解答路徑。代碼生成和調試:在軟件開發中,OpenR幫助生成代碼片段,或者調試過程中查找和修正代碼中的錯誤。自然語言處理(NLP)任務:OpenR用在機器閱讀理解、問答系統、文本摘要等需要深入理解文本和邏輯推理的NLP任務。教育輔助:在教育領域,OpenR作為輔助工具,幫助學生理解復雜的概念和解題步驟,提供個性化的學習路徑。自動化客戶服務:在客戶服務領域,OpenR基于推理用戶的問題和需求,提供準確的答案和解決方案。