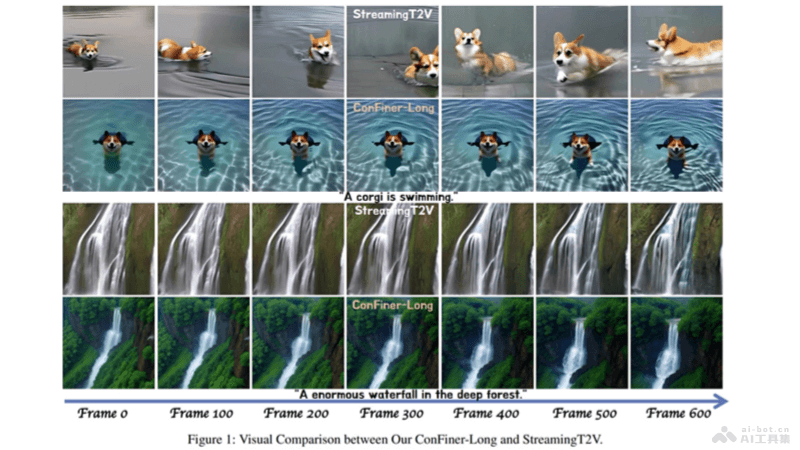

ConFiner 是一個創新的視頻生成框架,由多所大學和研究機構共同推出。結合多個現成的擴散模型專家,無需額外訓練可生成高質量且連貫的視頻內容。框架將視頻生成任務分解為結構控制、空間細化和時間細化三個子任務,每個子任務由專門的專家處理,提高生成效率和視頻質量。ConFiner 引入協調去噪技術和 ConFiner-Long 框架,支持長視頻的生成,制作長達600幀的連貫視頻,為電影制作、動畫創作和視頻編輯等領域提供新的創作可能性。

ConFiner的主要功能結構控制:負責生成視頻的整體結構和情節,為后續的空間和時間細化提供基礎。空間細化:確保每一幀具有足夠的清晰度和高審美評分,同時保持幀與幀之間的連貫性和一致性。時間細化:進一步細化視頻的時間維度,增強視頻的流暢性和動態效果。協調去噪:一種新的去噪方法,支持在單次采樣過程中同時使用空間和時間專家的知識,提高視頻生成的精細度與一致性。長視頻生成:ConFiner-Long 框架能生成長達600幀的連貫視頻,通過片段一致性初始化、一致性引導和交錯細化策略,確保視頻片段之間的平滑過渡和連貫性。ConFiner的技術原理創新性解耦策略:ConFiner 將視頻生成任務分解為三個獨立的子任務:結構控制、空間細化和時間細化。每個子任務由專門的擴散模型專家處理,專家在各自領域內具有優勢,降低模型的計算負擔,提升了生成的質量與速度。協調去噪技術:在視頻生成過程中,ConFiner 引入協作機制,使用不同噪聲調度器的空間和時間專家實現逐步協作。有效提升視頻生成的精細度與一致性。長視頻生成突破:ConFiner-Long 框架在 ConFiner 的基礎上,通過片段一致性初始化、一致性引導和交錯細化三種策略,實現高質量、連貫的長視頻生成。ConFiner-Long框架能生成長達600幀的連貫視頻,推動長視頻生成技術的發展。控制階段與細化階段:在控制階段,ConFiner 用一個高度可控的文本到視頻模型作為控制專家,生成包含粗略空間-時間信息的視頻結構。在細化階段,空間專家和時間專家基于視頻結構來細化空間和時間細節,采用協調去噪方法,使兩個專家能在不同的噪聲調度器下協同工作。ConFiner的項目地址GitHub倉庫:https://github.com/Confiner2025/Confiner2025arXiv技術論文:https://arxiv.org/pdf/2408.13423ConFiner的應用場景電影制作:ConFiner 生成電影的視覺草圖或特效場景,幫助導演和制作團隊快速預覽和迭代創意,提高前期制作的效率。視頻編輯:在視頻編輯過程中,ConFiner 快速生成視頻內容,例如添加特效或過渡,提高編輯效率并豐富最終的視頻效果。動畫生產:動畫師用 ConFiner 生成動畫序列,減少創作時間,特別是在制作動畫預覽或概念驗證時。廣告創作:廣告行業用 ConFiner 生成吸引人的廣告視頻,快速將創意轉化為視覺內容,吸引觀眾的注意力。社交媒體內容制作:社交媒體用戶和內容創作者用 ConFiner 生產高質量的視頻內容,用于平臺分享,增加互動性和觀看率。

ConFiner的主要功能結構控制:負責生成視頻的整體結構和情節,為后續的空間和時間細化提供基礎。空間細化:確保每一幀具有足夠的清晰度和高審美評分,同時保持幀與幀之間的連貫性和一致性。時間細化:進一步細化視頻的時間維度,增強視頻的流暢性和動態效果。協調去噪:一種新的去噪方法,支持在單次采樣過程中同時使用空間和時間專家的知識,提高視頻生成的精細度與一致性。長視頻生成:ConFiner-Long 框架能生成長達600幀的連貫視頻,通過片段一致性初始化、一致性引導和交錯細化策略,確保視頻片段之間的平滑過渡和連貫性。ConFiner的技術原理創新性解耦策略:ConFiner 將視頻生成任務分解為三個獨立的子任務:結構控制、空間細化和時間細化。每個子任務由專門的擴散模型專家處理,專家在各自領域內具有優勢,降低模型的計算負擔,提升了生成的質量與速度。協調去噪技術:在視頻生成過程中,ConFiner 引入協作機制,使用不同噪聲調度器的空間和時間專家實現逐步協作。有效提升視頻生成的精細度與一致性。長視頻生成突破:ConFiner-Long 框架在 ConFiner 的基礎上,通過片段一致性初始化、一致性引導和交錯細化三種策略,實現高質量、連貫的長視頻生成。ConFiner-Long框架能生成長達600幀的連貫視頻,推動長視頻生成技術的發展。控制階段與細化階段:在控制階段,ConFiner 用一個高度可控的文本到視頻模型作為控制專家,生成包含粗略空間-時間信息的視頻結構。在細化階段,空間專家和時間專家基于視頻結構來細化空間和時間細節,采用協調去噪方法,使兩個專家能在不同的噪聲調度器下協同工作。ConFiner的項目地址GitHub倉庫:https://github.com/Confiner2025/Confiner2025arXiv技術論文:https://arxiv.org/pdf/2408.13423ConFiner的應用場景電影制作:ConFiner 生成電影的視覺草圖或特效場景,幫助導演和制作團隊快速預覽和迭代創意,提高前期制作的效率。視頻編輯:在視頻編輯過程中,ConFiner 快速生成視頻內容,例如添加特效或過渡,提高編輯效率并豐富最終的視頻效果。動畫生產:動畫師用 ConFiner 生成動畫序列,減少創作時間,特別是在制作動畫預覽或概念驗證時。廣告創作:廣告行業用 ConFiner 生成吸引人的廣告視頻,快速將創意轉化為視覺內容,吸引觀眾的注意力。社交媒體內容制作:社交媒體用戶和內容創作者用 ConFiner 生產高質量的視頻內容,用于平臺分享,增加互動性和觀看率。