從單張RGB圖像重建高質(zhì)量3D場景

(中國AI網(wǎng) 2025年06月24日)在計算機(jī)圖形學(xué)中,從單個RGB圖像中恢復(fù)高質(zhì)量的3D場景是一項具有挑戰(zhàn)性的任務(wù)。在一項研究中,上海科技大學(xué)和華中科技大學(xué)團(tuán)隊提出了一種用于3D場景重建和恢復(fù)的新方法:CAST(Component-Aligned 3D Scene Reconstruction from a Single RGB Image)。

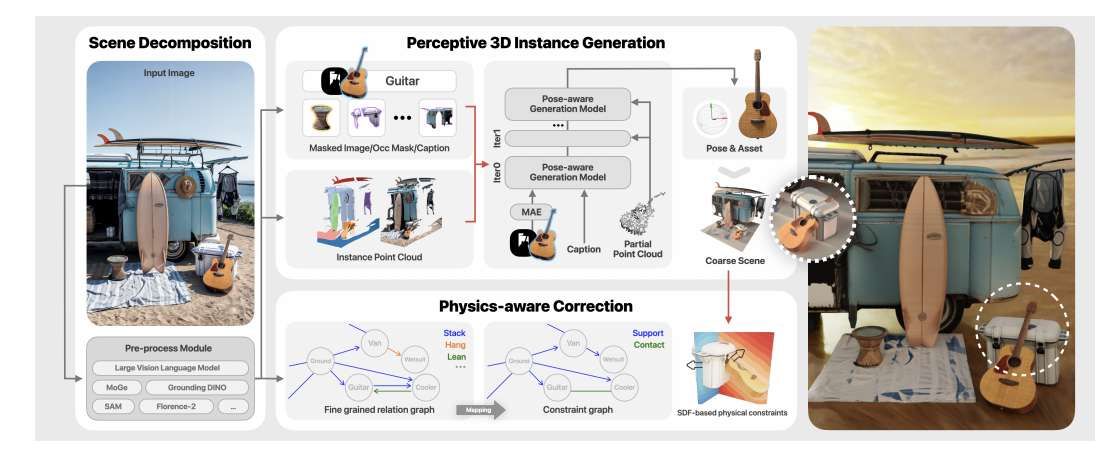

CAST首先從輸入圖像中提取物體級2D分割和相對深度信息,然后使用基于GPT的模型分析物體間的空間關(guān)系,從而確保更連貫的重建。然后,CAST采用一個能夠感知遮擋的大規(guī)模3D生成模型來獨(dú)立生成每個物體的完整幾何形狀,并使用MAE和點(diǎn)云調(diào)節(jié)來減輕遮擋和部分物體信息的影響,確保與源圖像的幾何形狀和紋理精確對齊。

為了使每個物體與場景對齊,對齊生成模型計算必要的轉(zhuǎn)換,允許生成的網(wǎng)格被精確地放置并集成到場景的點(diǎn)云中。最后,CAST集成了一個物理感知的校正步驟,利用細(xì)粒度關(guān)系圖生成約束圖。約束圖指導(dǎo)物體姿態(tài)的優(yōu)化,確保物理一致性和空間一致性。通過使用SDF,模型有效地解決了遮擋、物體穿透和漂浮等問題,確保生成的場景準(zhǔn)確反映了現(xiàn)實(shí)世界的物理交互。

空間中的物體并非孤立存在,它們的放置、設(shè)計和材料源于物理限制、功能角色和人類設(shè)計意圖,并影響著我們?nèi)绾我苿印⒒雍透兄臻g。例如,燈的光與周圍的表面相互作用,投射出陰影,塑造了整個場景。認(rèn)識到這種關(guān)系對于準(zhǔn)確的場景解析、建模、以及3D生成至關(guān)重要,從而確保虛擬環(huán)境與現(xiàn)實(shí)世界一樣逼真和連貫。

在從文本或圖像提示生成單個對象方面取得了重大進(jìn)展。神經(jīng)渲染方法優(yōu)化隱式表示,而原生3D生成器通過端到端學(xué)習(xí)直接創(chuàng)建3D形狀和紋理。盡管相關(guān)方法在單個對象方面顯示出前景,但將它們應(yīng)用于通過順序組裝對象來生成整個場景時面臨著明顯的缺點(diǎn)。

一個關(guān)鍵的挑戰(zhàn)是準(zhǔn)確的姿態(tài)估計。現(xiàn)有的方法通常假設(shè)對象可視,而這在現(xiàn)實(shí)場景中很少出現(xiàn)。物體可能出現(xiàn)在不同的方向,并受到設(shè)計、物理或部分遮擋的限制。然而,大多數(shù)現(xiàn)有方法優(yōu)先考慮幾何保真度而不是姿態(tài)對齊,這一關(guān)鍵方面尚未得到充分探索。

一個更根本的問題來自于缺乏對象間的空間關(guān)系。即便有精確的姿勢,生成的場景都經(jīng)常受到偽影的影響:物體相互穿透,漂浮或在必要時無法接觸。相關(guān)錯誤源于空間和物理約束的缺失。

有的研究人員使用編碼器-解碼器架構(gòu)隱式編碼空間關(guān)系,但它們依然局限于特定領(lǐng)域,如室內(nèi)場景。其他場景級生成器在全局坐標(biāo)系中定位對象,但忽略了它們的相對姿勢和依賴關(guān)系,進(jìn)一步損害了下游應(yīng)用的真實(shí)感和可用性。

針對這個問題,上海科技大學(xué)和華中科技大學(xué)團(tuán)隊提出了CAST,用于從單張RGB圖像重建高質(zhì)量3D場景。CAST為單個對象生成高質(zhì)量的3D網(wǎng)格,以及它們的相似轉(zhuǎn)換(旋轉(zhuǎn),平移,縮放),確保與參考圖像對齊并強(qiáng)制物理合理的相互依賴性。

CAST首先使用2D基礎(chǔ)模型處理非結(jié)構(gòu)化RGB圖像,以開放詞匯的方式識別、定位和分割對象。現(xiàn)成的單目深度估計器提供了部分3D點(diǎn)云和物體間空間關(guān)系的初始估計,包括相對變換和尺度。

CAST的第一個核心組件是感知3D實(shí)例生成器,有兩個模塊:一個遮擋感知對象生成模塊和一個姿態(tài)對齊生成模塊。對象生成模塊采用基于latent擴(kuò)散的生成模型,根據(jù)部分圖像片段和可選點(diǎn)云生成高保真目標(biāo)網(wǎng)格。模塊集成了一個能夠推斷遮擋區(qū)域的遮擋感知2D圖像編碼器,確保圖像條件下的魯棒特征提取。

為了提高對現(xiàn)實(shí)世界點(diǎn)云調(diào)節(jié)的魯棒性,在訓(xùn)練過程中模擬了具有遮擋區(qū)域的部分點(diǎn)云,使模型能夠有效地處理遮擋。姿態(tài)對齊模塊有一個對齊生成模型,可產(chǎn)生一個轉(zhuǎn)換后的部分點(diǎn)云,與隱式表示在latent空間中的完整幾何圖形對齊。將變換后的點(diǎn)云與camera估計的部分點(diǎn)云進(jìn)行相似度變換。與直接位姿回歸方法不同,團(tuán)隊提出的方法通過生成來估計變換,捕獲姿勢對齊的多模態(tài)性質(zhì)。

CAST的第二個核心組成部分處理對象間空間關(guān)系。盡管有精確的像素對齊,但如果沒有明確的物理約束建模,可能會出現(xiàn)難以置信的偽影,如穿透或漂浮。CAST引入了物理意識校正過程,以確保空間和物理一致性。另外,GPT-4v用于識別基于輸入圖像的常識性物理關(guān)系,然后基于約束優(yōu)化物體姿態(tài)。這個過程確保重建的場景表現(xiàn)出真實(shí)的物理相互依賴性,使它們適合模擬、編輯和渲染等應(yīng)用。

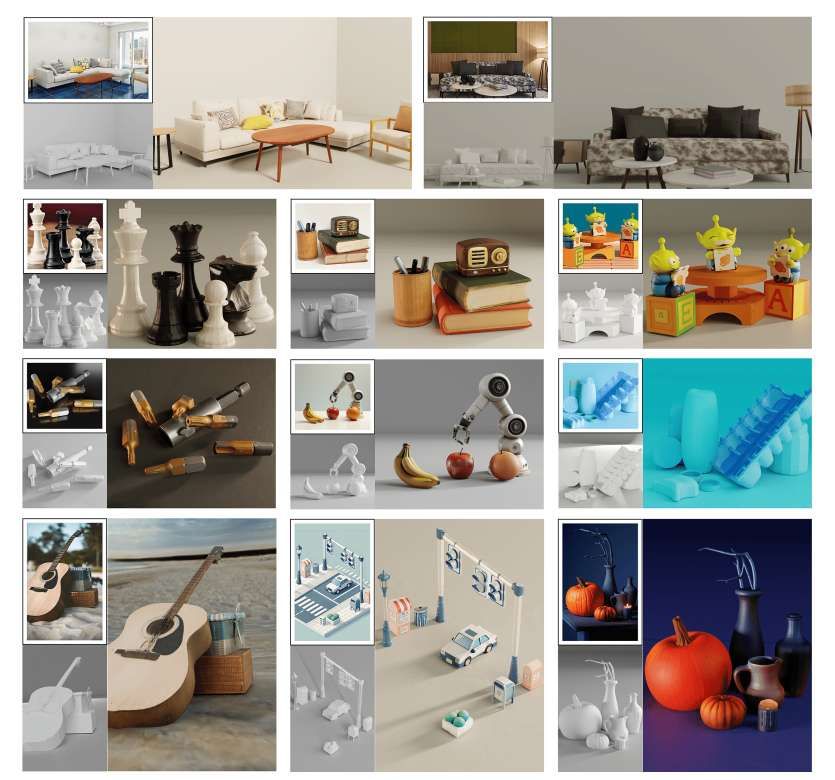

值得注意的是,CAST擅長從各種各樣的圖像中生成感知逼真的3D場景。CAST在對象和場景級幾何質(zhì)量方面優(yōu)于室內(nèi)數(shù)據(jù)集3D-Front中的強(qiáng)基線。在視覺語言模型和用戶研究的驗(yàn)證下,它在各種圖像(包括in the wild場景)的感知和物理現(xiàn)實(shí)性方面同樣表現(xiàn)出色。

CAST只需要一張圖像就可以忠實(shí)地重建具有詳細(xì)幾何形狀,物體生動紋理,以及空間和物理相互依賴關(guān)系的場景。

相關(guān)論文:CAST: Component-Aligned 3D Scene Reconstruction from an RGB Image

https://arxiv.org/pdf/2502.12894

總的來說,團(tuán)隊介紹了一種單圖像3D場景重建方法CAST。它結(jié)合了幾何保真度、像素級對齊和物理接地約束。通過集成場景分解、感知3D實(shí)例生成框架和物理校正技術(shù),CAST解決了姿勢不對齊、物體相互依賴和部分遮擋的關(guān)鍵挑戰(zhàn)。這種結(jié)構(gòu)化的管道產(chǎn)生了視覺上準(zhǔn)確和物理上一致的3D場景。廣泛的實(shí)驗(yàn)和用戶研究驗(yàn)證了CAST,證明了在視覺質(zhì)量和物理合理性方面比最先進(jìn)方法具有顯著的性能改進(jìn)。

研究人員指出:“我們預(yù)計CAST將成為未來3D生成、場景重建和沉浸式內(nèi)容創(chuàng)作發(fā)展的堅實(shí)基礎(chǔ)。”

值得一提的是,這項研究獲評為SIGGRAPH 2025最佳論文。