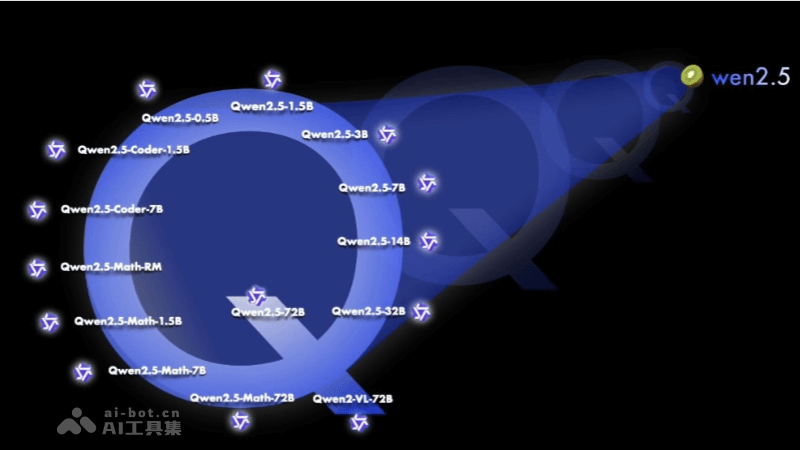

Qwen2.5 是阿里Qwen團隊研發的最新一代大型語言模型系列,具有多種參數規模的模型,包括 0.5B、1.5B、3B、7B、14B、32B 和 72B。模型在預訓練時使用了最新的大規模數據集,包含多達 18 萬億個 tokens,使Qwen2.5 在自然語言理解、文本生成、編程能力、數學能力等方面都有顯著提升。Qwen2.5 支持長文本處理,能生成長文本(超過 8K tokens),增強對系統提示的適應性,提升角色扮演和聊天機器人的背景設置能力。Qwen2.5 還支持多達 29 種語言,包括中文、英文、法文、西班牙文、葡萄牙文、德文等。Qwen2.5-Coder 和 Qwen2.5-Math 是針對編程和數學問題的專門模型,在專業領域內展現了強大的性能。

Qwen2.5的功能特色多樣化模型規模:Qwen2.5 提供了從 0.5B 到 72B 不同參數規模的模型,滿足不同應用場景的需求。預訓練數據集擴展:Qwen2.5 的預訓練數據集規模從 7T tokens 擴展到了 18T tokens,使模型在知識儲備上有了顯著提升。增強的多語言支持:Qwen2.5 支持包括中文、英文在內的超過 29 種語言,保持了對多語言的廣泛支持。提升的編程和數學能力:Qwen2.5-Coder 和 Qwen2.5-Math 分別針對編程和數學問題進行了優化,提供了更專業的性能。長文本處理能力:Qwen2.5 支持高達 128K tokens 的上下文長度,能生成最多 8K tokens 的內容,增強了長文本處理的能力。結構化數據處理:新模型在理解結構化數據(例如表格)以及生成結構化輸出(尤其是 JSON)方面取得了顯著改進。系統提示適應性:Qwen2.5 對各種 system prompt 更具適應性,增強了角色扮演實現和聊天機器人的條件設置功能。Qwen2.5模型系列的具體參數模型及性能指標

Qwen2.5的功能特色多樣化模型規模:Qwen2.5 提供了從 0.5B 到 72B 不同參數規模的模型,滿足不同應用場景的需求。預訓練數據集擴展:Qwen2.5 的預訓練數據集規模從 7T tokens 擴展到了 18T tokens,使模型在知識儲備上有了顯著提升。增強的多語言支持:Qwen2.5 支持包括中文、英文在內的超過 29 種語言,保持了對多語言的廣泛支持。提升的編程和數學能力:Qwen2.5-Coder 和 Qwen2.5-Math 分別針對編程和數學問題進行了優化,提供了更專業的性能。長文本處理能力:Qwen2.5 支持高達 128K tokens 的上下文長度,能生成最多 8K tokens 的內容,增強了長文本處理的能力。結構化數據處理:新模型在理解結構化數據(例如表格)以及生成結構化輸出(尤其是 JSON)方面取得了顯著改進。系統提示適應性:Qwen2.5 對各種 system prompt 更具適應性,增強了角色扮演實現和聊天機器人的條件設置功能。Qwen2.5模型系列的具體參數模型及性能指標Qwen2.5 模型在 MMLU-rudex 基準(考察通用知識)、MBPP 基準(考察代碼能力)和 MATH 基準(考察數學能力)上的得分分別高達 86.8、88.2、83.1。

Qwen2.5:包括 0.5B、1.5B、3B、7B、14B、32B 和 72B 參數規模的模型。包含多達 18 萬億個 tokens,相比 Qwen2,整體性能提升了 18% 以上。支持高達 128K tokens 的上下文長度,能生成最多 8K tokens 的內容。支持超過 29 種語言,包括中文、英文等。Qwen2.5-Coder:專注于編程任務的模型,包括 1.5B 和 7B 參數規模。以及即將推出的 32B 版本。在多達 5.5 萬億 tokens 的編程相關數據上進行了訓練。覆蓋 92 種編程語言、支持 128K tokens 的上下文長度,能生成最多 8K tokens 的內容。Qwen2.5-Math:專注于數學問題的模型,包括 1.5B、7B 和 72B 參數規模。支持中文和英文,整合多種推理方法,包括思維鏈(CoT)、程序化思維(PoT)和工具集成推理(TIR)。解決中英雙語的數學題方面表現出色 。Qwen2.5的項目地址項目官網:https://qwenlm.github.io/blog/qwen2.5/GitHub倉庫:https://github.com/QwenLM/Qwen2.5HuggingFace模型庫:https://huggingface.co/collections/Qwen/qwen25-66e81a666513e518adb90d9eQwen2.5的應用場景聊天機器人和虛擬助手:Qwen2.5 可以作為對話系統的核心,提供自然語言理解和文本生成,實現用戶交互。內容創作和編輯:能自動生成文章、故事、詩歌或其他文本內容,輔助編輯和寫作。教育和學習輔助:輔助學生和教師進行語言學習、作業輔導和知識測試。編程輔助:Qwen2.5-Coder 模型專門針對編程任務進行優化,能提供代碼建議和調試幫助。數學問題解決:Qwen2.5-Math 模型支持解決中英雙語的數學問題,適用于教育和研究領域。多語言翻譯:需要編碼器-解碼器架構,Qwen2.5 也能用于生成翻譯文本。