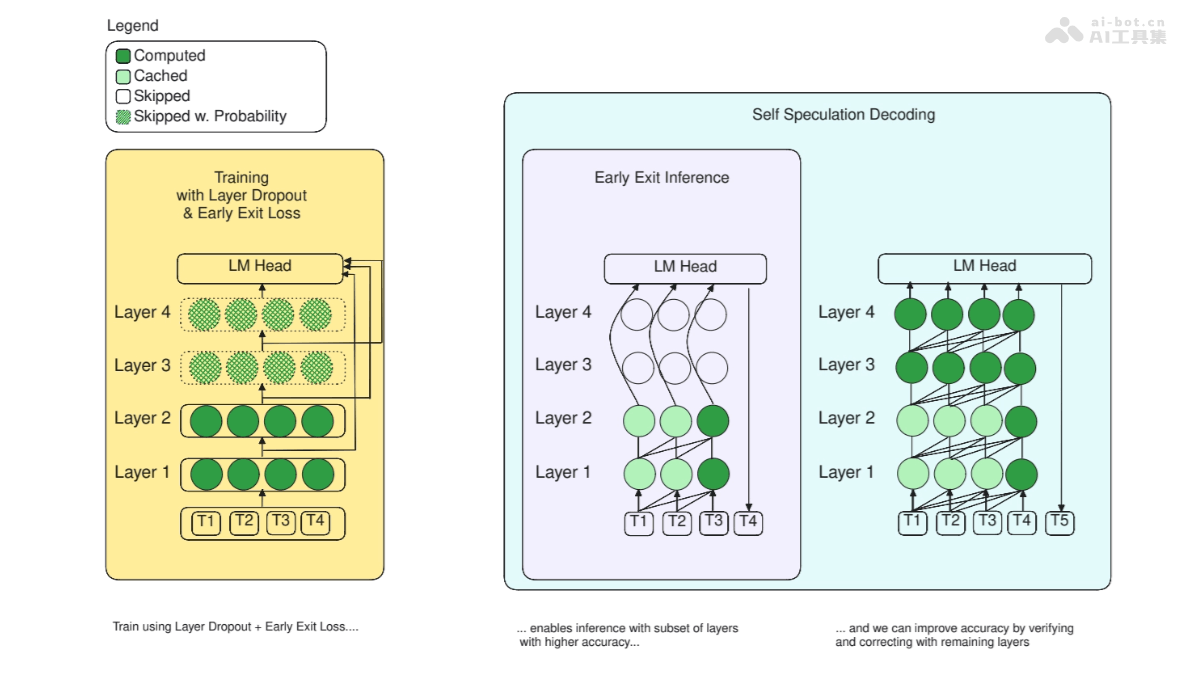

LayerSkip是一種用在加速大型語言模型(LLMs)推理過程的技術。基于在訓練階段應用層dropout和早期退出損失,讓模型在推理時從早期層開始更準確地退出,不需要遍歷所有層。提高模型的推理速度,減少計算資源的消耗。LayerSkip引入一種自我推測解碼方法,方法基于早期層退出生成令牌,用剩余層進行驗證和糾正,提高解碼的效率,內存占用更少,從共享計算和激活中獲益。LayerSkip在多種任務上顯示出顯著的速度提升,如文檔摘要、編程任務和語義解析等,保持較高的準確性。

LayerSkip的主要功能加速大型語言模型的推理:減少模型在生成輸出時需要遍歷的層數,LayerSkip能提高模型的推理速度。早期退出推理:在訓練期間應用層dropout和早期退出損失,讓模型在推理時從早期層準確退出,不必用所有層。自我推測解碼:LayerSkip提出一種自我推測解碼方法,支持模型在早期層生成預測,用剩余層進行驗證和糾正,提高解碼效率。LayerSkip的技術原理層dropout:在訓練期間,LayerSkip對不同的模型層用不同的dropout率,早期層的dropout率較低,后期層的dropout率較高。差異化的dropout策略鼓勵模型在早期層學習更多的通用特征,減少對深層的依賴。早期退出損失:為提高早期層的預測準確性,LayerSkip在訓練時引入早期退出損失,讓模型的輸出層(LM頭)更好地處理自早期層的嵌入。自我推測解碼:在推理時,LayerSkip用早期層快速生成預測(草案),用模型的剩余層驗證和糾正預測。方法基于驗證一組令牌比自回歸地生成每個令牌更快的事實,減少整體的推理時間。緩存重用:為進一步優化自我推測解碼,LayerSkip在草案和驗證階段重用激活和鍵值(KV)緩存,減少內存占用和計算量。LayerSkip的項目地址GitHub倉庫:https://github.com/facebookresearch/LayerSkipHuggingFace模型庫:https://huggingface.co/collections/facebook/layerskip-666b25c50c8ae90e1965727aarXiv技術論文:https://arxiv.org/pdf/2404.16710LayerSkip的應用場景實時應用:在需要即時反饋的場景,如在線客服、聊天機器人和語音識別系統中,LayerSkip能加快響應速度,提升用戶體驗。移動和邊緣計算:LayerSkip減少模型的計算需求,讓大型語言模型能部署在資源受限的移動設備或邊緣設備上,適于離線或低延遲的應用需求。在線翻譯:在多語言環境下,LayerSkip能加速語言模型的推理過程,提供更快速的翻譯服務。內容生成:對需要生成文章、報告或代碼等文本內容的應用,LayerSkip能提高內容生成的速度,縮短創作時間。自然語言處理(NLP)任務:Layer Skip用在各種NLP任務,如文本摘要、情感分析、問答系統等,提高任務的處理速度。

LayerSkip的主要功能加速大型語言模型的推理:減少模型在生成輸出時需要遍歷的層數,LayerSkip能提高模型的推理速度。早期退出推理:在訓練期間應用層dropout和早期退出損失,讓模型在推理時從早期層準確退出,不必用所有層。自我推測解碼:LayerSkip提出一種自我推測解碼方法,支持模型在早期層生成預測,用剩余層進行驗證和糾正,提高解碼效率。LayerSkip的技術原理層dropout:在訓練期間,LayerSkip對不同的模型層用不同的dropout率,早期層的dropout率較低,后期層的dropout率較高。差異化的dropout策略鼓勵模型在早期層學習更多的通用特征,減少對深層的依賴。早期退出損失:為提高早期層的預測準確性,LayerSkip在訓練時引入早期退出損失,讓模型的輸出層(LM頭)更好地處理自早期層的嵌入。自我推測解碼:在推理時,LayerSkip用早期層快速生成預測(草案),用模型的剩余層驗證和糾正預測。方法基于驗證一組令牌比自回歸地生成每個令牌更快的事實,減少整體的推理時間。緩存重用:為進一步優化自我推測解碼,LayerSkip在草案和驗證階段重用激活和鍵值(KV)緩存,減少內存占用和計算量。LayerSkip的項目地址GitHub倉庫:https://github.com/facebookresearch/LayerSkipHuggingFace模型庫:https://huggingface.co/collections/facebook/layerskip-666b25c50c8ae90e1965727aarXiv技術論文:https://arxiv.org/pdf/2404.16710LayerSkip的應用場景實時應用:在需要即時反饋的場景,如在線客服、聊天機器人和語音識別系統中,LayerSkip能加快響應速度,提升用戶體驗。移動和邊緣計算:LayerSkip減少模型的計算需求,讓大型語言模型能部署在資源受限的移動設備或邊緣設備上,適于離線或低延遲的應用需求。在線翻譯:在多語言環境下,LayerSkip能加速語言模型的推理過程,提供更快速的翻譯服務。內容生成:對需要生成文章、報告或代碼等文本內容的應用,LayerSkip能提高內容生成的速度,縮短創作時間。自然語言處理(NLP)任務:Layer Skip用在各種NLP任務,如文本摘要、情感分析、問答系統等,提高任務的處理速度。