阿里巴巴達(dá)摩院與中國人民大學(xué)近日聯(lián)合開源了一款名為 mPLUG-DocOwl1.5的文檔處理模型,該模型主打無需 OCR 識別即可理解文檔內(nèi)容,并在多個(gè)視覺文檔理解基準(zhǔn)測試中取得了領(lǐng)先的性能。

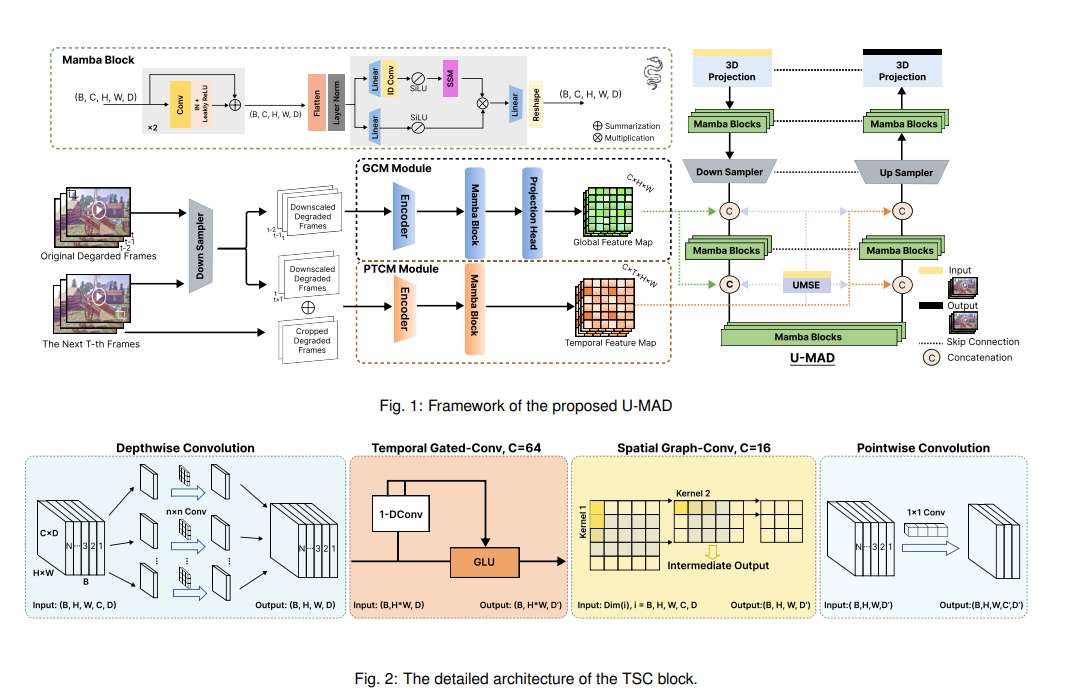

結(jié)構(gòu)信息對于理解富文本圖像(例如文檔、表格和圖表)的語義至關(guān)重要。 現(xiàn)有的多模態(tài)大型語言模型 (MLLM) 雖然具備文本識別能力,但缺乏對富文本文檔圖像的通用結(jié)構(gòu)理解能力。為了解決這一問題,mPLUG-DocOwl1.5強(qiáng)調(diào)結(jié)構(gòu)信息在視覺文檔理解中的重要性,并提出了 “統(tǒng)一結(jié)構(gòu)學(xué)習(xí)” 來提升 MLLM 的性能。

該模型的“統(tǒng)一結(jié)構(gòu)學(xué)習(xí)”涵蓋了5個(gè)領(lǐng)域:文檔、網(wǎng)頁、表格、圖表和自然圖像,包括結(jié)構(gòu)感知解析任務(wù)和多粒度文本定位任務(wù)。 為了更好地編碼結(jié)構(gòu)信息,研究人員設(shè)計(jì)了一個(gè)簡單有效的視覺到文本模塊 H-Reducer,它不僅可以保留布局信息,還可以通過卷積合并水平相鄰的圖像塊來減少視覺特征的長度,使大型語言模型能夠更有效地理解高分辨率圖像。

此外,為了支持結(jié)構(gòu)學(xué)習(xí),研究團(tuán)隊(duì)基于公開可用的數(shù)據(jù)集構(gòu)建了一個(gè)包含400萬個(gè)樣本的綜合訓(xùn)練集 DocStruct4M,其中包含結(jié)構(gòu)感知文本序列和多粒度文本邊界框?qū)Α?為了進(jìn)一步激發(fā) MLLM 在文檔領(lǐng)域的推理能力,他們還構(gòu)建了一個(gè)包含2.5萬個(gè)高質(zhì)量樣本的推理微調(diào)數(shù)據(jù)集 DocReason25K。

mPLUG-DocOwl1.5采用兩階段訓(xùn)練框架,首先進(jìn)行統(tǒng)一結(jié)構(gòu)學(xué)習(xí),然后在多個(gè)下游任務(wù)中進(jìn)行多任務(wù)微調(diào)。通過這種訓(xùn)練方式,mPLUG-DocOwl1.5在10個(gè)視覺文檔理解基準(zhǔn)測試中均取得了最先進(jìn)的性能,在5個(gè)基準(zhǔn)測試中將7B LLM 的 SOTA 性能提升了10個(gè)百分點(diǎn)以上。

目前,mPLUG-DocOwl1.5的代碼、模型和數(shù)據(jù)集已在 GitHub 上公開發(fā)布。

項(xiàng)目地址:https://github.com/X-PLUG/mPLUG-DocOwl/tree/main/DocOwl1.5

論文地址:https://arxiv.org/pdf/2403.12895