來自智源研究院的Emu3團隊發(fā)布了一套全新的多模態(tài)模型Emu3,該模型僅基于下一個token預測進行訓練,顛覆了傳統(tǒng)的擴散模型和組合模型架構(gòu),在生成和感知任務上均取得了最先進的性能。

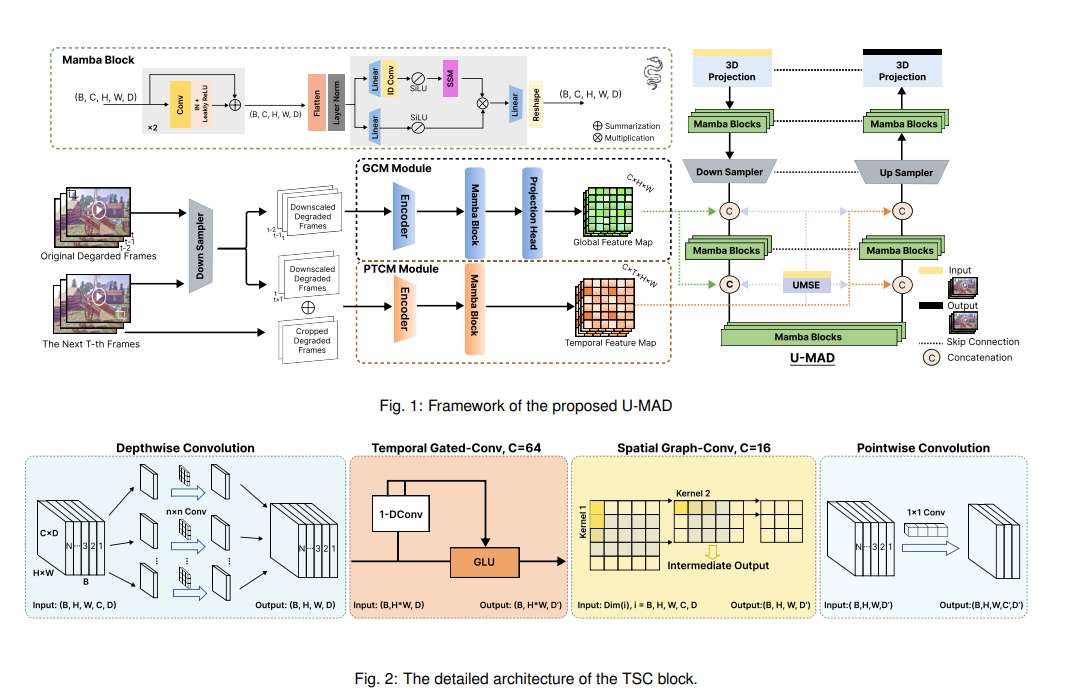

一直以來,下一個token預測被認為是通向人工智能通用智能(AGI)的希望之路,但在多模態(tài)任務上卻表現(xiàn)不佳。目前,多模態(tài)領域仍然由擴散模型(如Stable Diffusion)和組合模型(如CLIP與LLM的結(jié)合)主導。Emu3團隊將圖像、文本和視頻都標記化到離散空間中,并在混合的多模態(tài)序列上從頭開始訓練單個Transformer模型,從而實現(xiàn)了多模態(tài)任務的統(tǒng)一,無需依賴擴散或組合架構(gòu)。

Emu3在生成和感知任務上的表現(xiàn)都超越了現(xiàn)有的特定任務模型,甚至超越了SDXL和LLaVA-1.6等旗艦模型。Emu3還能夠通過預測視頻序列中的下一個token來生成高保真視頻。 不同于Sora使用視頻擴散模型從噪聲中生成視頻,Emu3通過預測視頻序列中的下一個token,以因果的方式生成視頻。該模型可以模擬現(xiàn)實世界中環(huán)境、人物和動物的某些方面,并在給定視頻上下文的情況下,預測接下來會發(fā)生什么。

Emu3簡化了復雜的多模態(tài)模型設計,將重點集中在token上,從而釋放了訓練和推理過程中的巨大擴展?jié)摿Α?研究結(jié)果表明,下一個token預測是構(gòu)建超越語言的通用多模態(tài)智能的有效途徑。為了支持該領域進一步的研究,Emu3團隊開源了關鍵技術和模型,包括一個強大的視覺標記器,可以將視頻和圖像轉(zhuǎn)換為離散token,這在以前是公開不可用的。

Emu3的成功為多模態(tài)模型的未來發(fā)展指明了方向,也為實現(xiàn)AGI帶來了新的希望。

項目地址:https://github.com/baaivision/Emu3