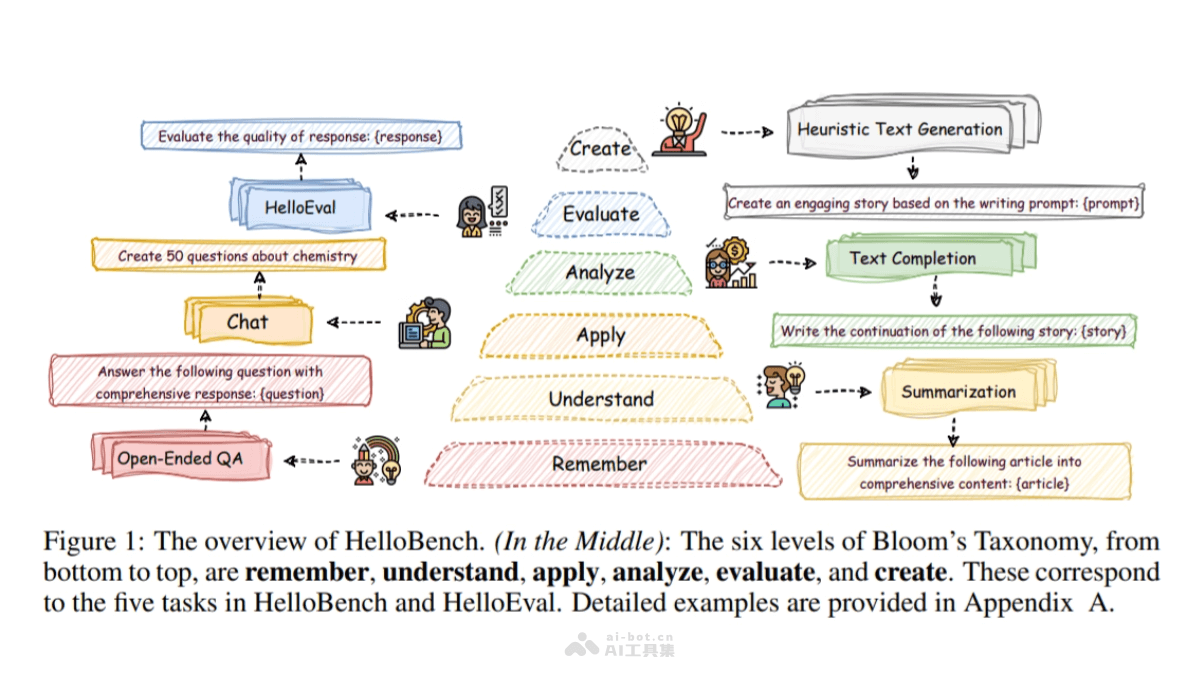

HelloBench是一個用于評估大型語言模型(LLMs)長文本生成能力的開源基準(zhǔn)測試。HelloBench包含五個基于布魯姆分類法的子任務(wù):開放式問答、摘要、聊天、文本補全和啟發(fā)式文本生成。HelloBench用真實場景數(shù)據(jù),如Quora和Reddit,確保任務(wù)的多樣性和實際性。引入HelloEval,一種高效的評估方法,減少人工評估的負(fù)擔(dān),同時保持與人類評價的高相關(guān)性。HelloBench在多個LLMs上的實驗顯示,現(xiàn)有模型在生成超過4000單詞的長文本方面存在挑戰(zhàn)。

HelloBench的主要功能分層任務(wù)設(shè)計:HelloBench根據(jù)布魯姆的分類法,將長文本生成任務(wù)分為五個子任務(wù),每個子任務(wù)針對不同的語言模型能力。真實數(shù)據(jù)集:基于來自Quora、Reddit等平臺的真實數(shù)據(jù)構(gòu)建數(shù)據(jù)集,確保評估的實用性和多樣性。自動化評估:用HelloEval方法,自動化評估LLMs的長文本生成能力,減少人工評估的時間和精力。評估方法對比:與傳統(tǒng)的評估指標(biāo)(如ROUGE、BLEU)進(jìn)行對比,展示HelloEval與人類評估的相關(guān)性。HelloBench的技術(shù)原理布魯姆分類法:基于布魯姆的分類法,將長文本生成任務(wù)分為不同的層次,對應(yīng)不同的認(rèn)知復(fù)雜度。數(shù)據(jù)集構(gòu)建:手動收集和篩選互聯(lián)網(wǎng)數(shù)據(jù),構(gòu)建高質(zhì)量、多樣化的數(shù)據(jù)集。HelloEval評估方法:設(shè)計檢查表(checklists)并收集人類標(biāo)注數(shù)據(jù),用線性回歸分析確定檢查表的加權(quán)分?jǐn)?shù)。LLM-as-a-Judge:基于語言模型作為評估者,回答檢查表問題,評估生成文本的質(zhì)量。線性回歸分析:對人工標(biāo)注數(shù)據(jù)進(jìn)行線性回歸分析,獲得與人類評估對齊的加權(quán)分?jǐn)?shù)。錯誤模式分析:分析LLMs在長文本生成中的常見錯誤,識別模型的局限性。HelloBench的項目地址GitHub倉庫:https://github.com/Quehry/HelloBenchHuggingFace模型庫:https://huggingface.co/papers/2409.16191arXiv技術(shù)論文:https://arxiv.org/pdf/2409.16191HelloBench的應(yīng)用場景語言模型開發(fā):開發(fā)者用HelloBench評估和比較不同語言模型在長文本生成任務(wù)上的性能。學(xué)術(shù)研究:研究人員用HelloBench進(jìn)行長文本生成相關(guān)的實驗,發(fā)表學(xué)術(shù)論文或進(jìn)行進(jìn)一步的研究。產(chǎn)品測試:企業(yè)在開發(fā)新的AI產(chǎn)品或服務(wù)時,用HelloBench測試和優(yōu)化產(chǎn)品的文本生成能力。教育評估:教育機構(gòu)用HelloBench評估和提高教學(xué)輔助工具的文本生成質(zhì)量。內(nèi)容創(chuàng)作:內(nèi)容創(chuàng)作者用HelloBench評估和改進(jìn)自動內(nèi)容生成工具,如自動寫作、博客文章生成等。對話系統(tǒng):評估和改進(jìn)聊天機器人或虛擬助手在長時間對話中的表現(xiàn)。

HelloBench的主要功能分層任務(wù)設(shè)計:HelloBench根據(jù)布魯姆的分類法,將長文本生成任務(wù)分為五個子任務(wù),每個子任務(wù)針對不同的語言模型能力。真實數(shù)據(jù)集:基于來自Quora、Reddit等平臺的真實數(shù)據(jù)構(gòu)建數(shù)據(jù)集,確保評估的實用性和多樣性。自動化評估:用HelloEval方法,自動化評估LLMs的長文本生成能力,減少人工評估的時間和精力。評估方法對比:與傳統(tǒng)的評估指標(biāo)(如ROUGE、BLEU)進(jìn)行對比,展示HelloEval與人類評估的相關(guān)性。HelloBench的技術(shù)原理布魯姆分類法:基于布魯姆的分類法,將長文本生成任務(wù)分為不同的層次,對應(yīng)不同的認(rèn)知復(fù)雜度。數(shù)據(jù)集構(gòu)建:手動收集和篩選互聯(lián)網(wǎng)數(shù)據(jù),構(gòu)建高質(zhì)量、多樣化的數(shù)據(jù)集。HelloEval評估方法:設(shè)計檢查表(checklists)并收集人類標(biāo)注數(shù)據(jù),用線性回歸分析確定檢查表的加權(quán)分?jǐn)?shù)。LLM-as-a-Judge:基于語言模型作為評估者,回答檢查表問題,評估生成文本的質(zhì)量。線性回歸分析:對人工標(biāo)注數(shù)據(jù)進(jìn)行線性回歸分析,獲得與人類評估對齊的加權(quán)分?jǐn)?shù)。錯誤模式分析:分析LLMs在長文本生成中的常見錯誤,識別模型的局限性。HelloBench的項目地址GitHub倉庫:https://github.com/Quehry/HelloBenchHuggingFace模型庫:https://huggingface.co/papers/2409.16191arXiv技術(shù)論文:https://arxiv.org/pdf/2409.16191HelloBench的應(yīng)用場景語言模型開發(fā):開發(fā)者用HelloBench評估和比較不同語言模型在長文本生成任務(wù)上的性能。學(xué)術(shù)研究:研究人員用HelloBench進(jìn)行長文本生成相關(guān)的實驗,發(fā)表學(xué)術(shù)論文或進(jìn)行進(jìn)一步的研究。產(chǎn)品測試:企業(yè)在開發(fā)新的AI產(chǎn)品或服務(wù)時,用HelloBench測試和優(yōu)化產(chǎn)品的文本生成能力。教育評估:教育機構(gòu)用HelloBench評估和提高教學(xué)輔助工具的文本生成質(zhì)量。內(nèi)容創(chuàng)作:內(nèi)容創(chuàng)作者用HelloBench評估和改進(jìn)自動內(nèi)容生成工具,如自動寫作、博客文章生成等。對話系統(tǒng):評估和改進(jìn)聊天機器人或虛擬助手在長時間對話中的表現(xiàn)。