在不同的照明條件下提供逼真、逼真的視覺效果

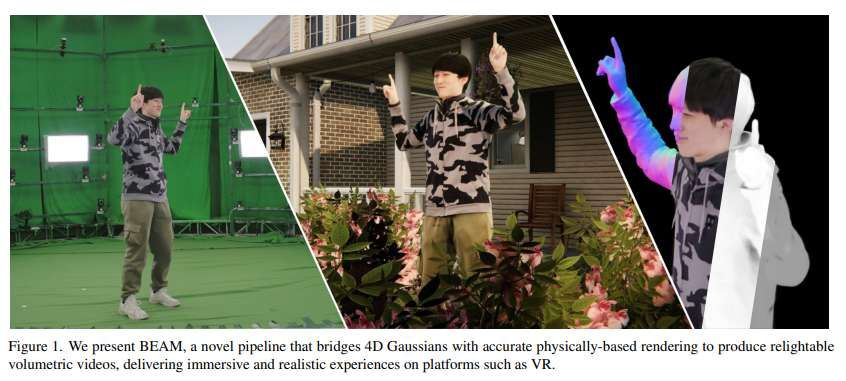

(中國AI網(wǎng) 2025年06月11日)體三維視頻通過捕獲動態(tài)3D場景實現(xiàn)身臨其境的體驗,從而支持虛擬現(xiàn)實等各種應(yīng)用。然而,傳統(tǒng)的方法在固定的照明條件下掙扎,而神經(jīng)方法在效率、質(zhì)量或可照明場景的適應(yīng)性方面面臨權(quán)衡。為了解決所述限制,上海科技大學(xué),NeuDim和DGene團(tuán)隊提出了BEAM。

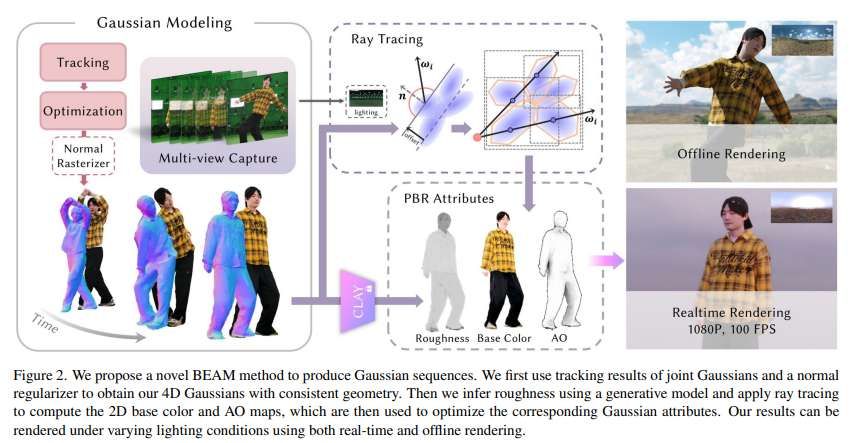

這個新穎的管道將4D高斯表示與基于物理的渲染(PBR)連接起來,從多視圖RGB素材中生成高質(zhì)量,可調(diào)光的體三維視頻。BEAM通過一系列基于高斯的技術(shù)恢復(fù)詳細(xì)的幾何形狀和PBR屬性。它首先將基于高斯的性能跟蹤與幾何感知光柵化結(jié)合在一個coarse-to-fine優(yōu)化框架中,以恢復(fù)空間和時間一致的幾何形狀。

團(tuán)隊通過逐步整合PBR屬性進(jìn)一步增強(qiáng)高斯屬性,并利用多視圖條件擴(kuò)散模型生成粗糙度,然后使用2D到3D策略導(dǎo)出AO和基色,并結(jié)合定制的基高斯光追器進(jìn)行有效的可見性計算。一旦恢復(fù),動態(tài)的,可照明的資產(chǎn)無縫集成到傳統(tǒng)的CG管道中,支持延遲著色的實時渲染和光線追蹤的離線渲染。

體三維視頻從多個角度捕獲動態(tài)3D場景,允許從任何角度進(jìn)行交互式觀看。這項技術(shù)對于在虛擬和增強(qiáng)現(xiàn)實中創(chuàng)造身臨其境的體驗,通過逼真的互動內(nèi)容增強(qiáng)故事講述、教育、文化保護(hù)和遠(yuǎn)程呈現(xiàn)至關(guān)重要。

然而,傳統(tǒng)的體三維視頻通常受到錄制期間捕獲的固定照明條件的限制,這可能與動態(tài)或虛擬環(huán)境發(fā)生沖突,降低真實感和靈活性。可重照明體三維視頻通過啟用捕獲后重照明克服了這一限制。

這允許無縫集成到動態(tài)照明環(huán)境中,并提供對視覺美學(xué)的創(chuàng)造性控制。行業(yè)中用于制作可重照明體三維視頻的主流工作流程依然依賴于追蹤的網(wǎng)格序列和紋理視頻。視頻可以無縫集成到標(biāo)準(zhǔn)CG管道中,以支持各種照明條件下的重照明。然而,復(fù)雜的重建過程經(jīng)常會引入諸如孔洞和噪點(diǎn)之類的偽影,并且重照明的質(zhì)量受到限制,經(jīng)常導(dǎo)致可見的缺陷。

神經(jīng)學(xué)方面的進(jìn)展側(cè)重于在隱式MLP表示中使用神經(jīng)分解實現(xiàn)重照明功能。然而,相關(guān)方法經(jīng)常面臨平衡訓(xùn)練效率、渲染速度和輸出質(zhì)量的挑戰(zhàn),最終無法提供令人滿意的結(jié)果。

最近,3DGS以前所未有的幀率實現(xiàn)了逼真的渲染。盡管動態(tài)變體可以生成高質(zhì)量的體三維視頻,但它們無法生成重照明等基本操作所需的詳細(xì)幾何形狀。業(yè)界已經(jīng)努力將基于物理的渲染集成到3DGS管道中,不過它們通常計算成本很高,并且僅限于靜態(tài)場景。

相關(guān)問題嚴(yán)重限制了它們在工業(yè)工作流程中的適用性,阻礙了4D內(nèi)容的高效生產(chǎn)。在一項研究中,上海科技大學(xué),NeuDim和DGene團(tuán)隊介紹了BEAM。這種新穎的管道將4D高斯函數(shù)與精確的PBR連接起來,用于從多視圖RGB素材中生成可重照明的體三維視頻。

關(guān)鍵思想是穩(wěn)健地恢復(fù)詳細(xì)的幾何形狀和解耦PBR屬性(例如環(huán)境遮擋,粗糙度和基色),并使用一套精心選擇的技術(shù),即,柵格化,性能跟蹤和光追,而所有這一切都在基于高斯的范式中。

所以,BEAM實現(xiàn)了逼真的動態(tài)場景,可以在不同的照明下無縫地、CG友好地集成到各種平臺中。他們首先從多視點(diǎn)視頻輸入中恢復(fù)詳細(xì)且時空一致的幾何形狀,將基于高斯的性能跟蹤與幾何感知的高斯光柵化有機(jī)地結(jié)合在一起。前者擅長運(yùn)動跟蹤,后者擅長靜態(tài)幾何恢復(fù),研究人員將它們統(tǒng)一在一個coarse-to-fine優(yōu)化框架中。

具體來說,使用粗略關(guān)節(jié)高斯函數(shù)來追蹤非剛性運(yùn)動,使用密集蒙皮高斯函數(shù)來保留復(fù)雜的幾何細(xì)節(jié)。團(tuán)隊采用了一種魯棒優(yōu)化過程,集成了法向一致性、光度一致性和時間正則化,以提高幾何精度和平滑度。這使得使用幾何感知光柵器從密集高斯中獲得準(zhǔn)確的深度和正常恢復(fù),為材質(zhì)分解和重照明提供了堅實的基礎(chǔ)。

研究人員進(jìn)一步解耦密集的4D高斯函數(shù),以恢復(fù)詳細(xì)的材質(zhì)屬性,實現(xiàn)高質(zhì)量的物理渲染。他們專注于準(zhǔn)確地將粗糙度,環(huán)境遮擋(AO)和基色屬性與高斯函數(shù)關(guān)聯(lián)起來,確保在不同照明條件下的逼真和適應(yīng)性渲染。為了實現(xiàn)這一目標(biāo),采用循序漸進(jìn)的方法來解開屬性。

具體來說,首先使用材質(zhì)擴(kuò)散模塊與多視圖條件生成粗略紋理。然后,對于AO和基色,采用2D-to-3D策略,在輸入視圖中估計屬性來烘烤2D材質(zhì)貼圖,然后在3D空間中優(yōu)化成相應(yīng)的密集高斯分布。

所述策略有效地降低了噪點(diǎn),平滑了解糾纏,提高了重照明質(zhì)量。對于進(jìn)一步的2D AO和基色分解,可以使用現(xiàn)成的工具估計捕獲過程中的照明環(huán)境,而幾何屬性和粗糙度則在前一階段獲得。因此,通過仔細(xì)地重新檢查和簡化渲染方程,團(tuán)隊確定了一個關(guān)鍵的見解:在光追過程中,可以通過積累的特定方向上特定點(diǎn)的可見性信息準(zhǔn)確地導(dǎo)出2D AO和基色。

團(tuán)隊定制了基于高斯的追蹤器來計算這種可見性,并采用了一種基于密集高斯的alpha blending策略。這有效地捕獲了可見性信息,為估計輸入視點(diǎn)中的AO和基色圖奠定了基礎(chǔ)。

一旦材質(zhì)屬性烘烤到密集動態(tài)高斯,4D資產(chǎn)與傳統(tǒng)的CG引擎無縫集成,以支持靈活的渲染工作流程。對于實時渲染,采用延遲著色來提供沉浸式和高效的可視化,而離線渲染則利用光追來精確捕獲復(fù)雜的陰影和遮擋。

團(tuán)隊進(jìn)一步開發(fā)了一個Unity插件,以將4D資產(chǎn)無縫集成到各種平臺中,從而在不同的照明條件下進(jìn)行實時,逼真的交互。

團(tuán)隊進(jìn)行了用戶研究。他們在捕獲的數(shù)據(jù)集評估了所提出方法,將其與R-3DGS, GS-IR和D-2DGS進(jìn)行比較,并要求30個用戶選擇最佳選項。

對于GS-IR和R3DGS,分別訓(xùn)練了200幀的高斯模型,并將每幀的法線貼圖連接起來。對于所提出方法和D-2DGS,從一個200幀的動態(tài)高斯序列光柵化一個法線貼圖序列。在時間重建質(zhì)量方面,95.65%的用戶更喜歡團(tuán)隊的方法。偏好結(jié)果清楚地表明,所提出方法比競爭方法有顯著的優(yōu)勢,證明了它在這兩個方面的優(yōu)越性能。

當(dāng)然,盡管實現(xiàn)了高質(zhì)量的沉浸式渲染,但所提出方案存在一定的局限性。首先,將新屬性集成到原始高斯中會導(dǎo)致動態(tài)高斯序列的大量存儲需求,所以未來的研究將考慮壓縮相關(guān)序列。其次,他們近似渲染方程來獲得二維材質(zhì)貼圖,這在解耦的材質(zhì)結(jié)果中引入了誤差,并且不能準(zhǔn)確地反映真實的物理世界,所以未來的工作可能會通過結(jié)合大模型來解決這個問題。

相關(guān)論文:BEAM: Bridging Physically-based Rendering and Gaussian Modeling for Relightable Volumetric Video

不過,所述方法與傳統(tǒng)CG引擎高度兼容,為增強(qiáng)渲染真實感和靈活性提供了巨大的潛力。