從音頻中生成富有表現力和多樣性的人類姿態

(中國AI網 2025年06月12日)從音頻中生成富有表現力和多樣性的人類姿態在VR等領域至關重要。盡管現有的方法已經取得了顯著的性能,但由于數據集的多樣性和音頻輸入的信息量有限,它們經常表現出局限性。

為了應對所述挑戰,中國傳媒大學,三星和北京航空航天大學團隊提出了VarGes。這個variation-driven框架旨在通過整合視覺樣式線索來增強語音姿態生成,同時盡量保持自然。

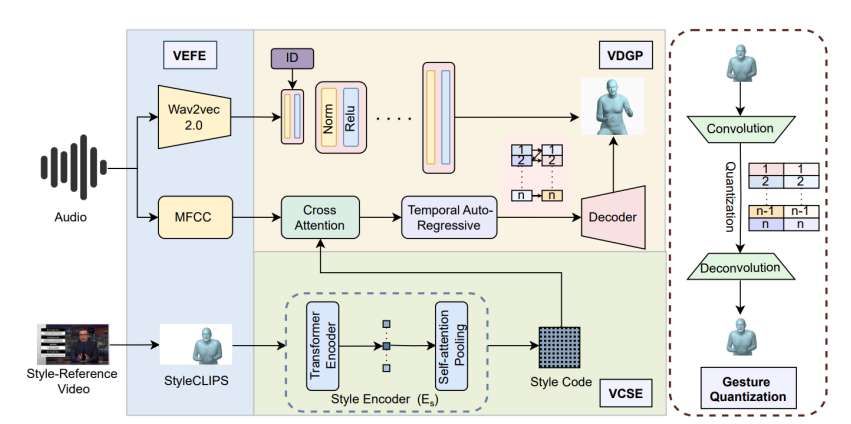

所述方法從Variation-Compensation Style Encoder(VEFE)模塊開始,無縫地將樣式參考視頻數據整合到3D人體姿勢估計網絡中以提取StyleCLIPS,從而豐富輸入的樣式信息。

隨后,采用Variation-Compensation Style Encoder(VCSE)來對不同的StyleCLIPS表示進行魯棒編碼,并有效地管理樣式變化。最后,Variation-Driven Gesture Predictor (VDGP)模塊通過交叉注意將MFCC音頻特征與StyleCLIPS編碼融合,將融合的數據注入交叉條件自回歸模型中,以基于音頻輸入和樣式線索調制3D人體姿態生成。

這一解決方案的有效性在基準數據集得到了驗證,在姿態多樣性和自然性方面優于現有方法。

頭部、手部和身體手勢是人類交際的重要組成,在增強語言表達、傳遞情感和態度、促進對話協調等方面發揮著關鍵作用。隨著虛擬化身在教育、娛樂和醫療等不同領域的使用越來越多,基于語音生成自然且情境合適的姿態已成為一項重大的研究挑戰。

這一挑戰涉及多個學科,包括計算機視覺、自然語言處理和人機交互等。與語音同步生成頭部、手部和身體姿態的任務大致可分為三種主要方法:基于規則的方法,基于統計模型的技術,以及基于學習的方法。

基于學習的方法已經明顯成為這一領域的前沿,在產生既流暢又自然的姿態方面表現出非凡的熟練程度,可以捕獲到人類表情的復雜動態。相關方法通過有效地將語音與手勢的細微差別結合起來,樹立了非常高的標準。然而,實現廣泛多樣的3D人體姿態依然是一個重大挑戰。

盡管近來業界取得了進步,但相關方法經常受到限于特定人物的數據集的限制,從而限制了它們可以生成的姿態樣式的廣度,并導致了固定模式的學習,阻礙了在不同語音輸入中的可變性。

為了解決這一限制,中國傳媒大學,三星和北京航空航天大學團隊提出了VarGes,一種從語音片段中生成各種3D人類姿態的方法。

團隊旨在通過結合視覺和音頻信息來增強3D姿態生成的多樣性和自然性。通過整合這兩種方式,研究人員希望以一種反映人們如何自然地使用視覺和聲音來解釋姿態的方式來實現人類表現力的豐富性。

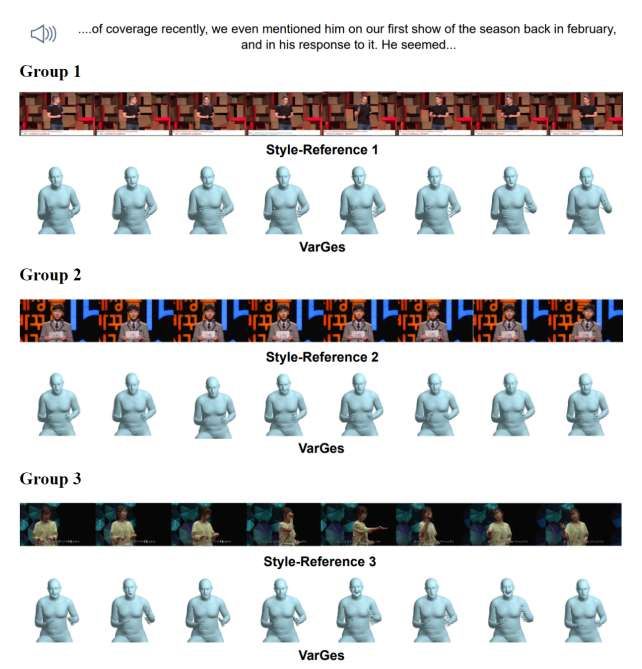

具體來說,在VarGes中,視覺信息由樣式參考視頻表示,并編碼為樣式代碼來指導生成過程。特別是,團隊認為樣式是一種穩定和個性化的特征,它通過影響動作的整體特征(如振幅、節奏和力量)來指導生成,而不是直接決定具體的動作路徑。

在這種樣式指導下,即使生成的動作與樣式參考視頻不同,都可以在整體特征上保持一致,從而實現自然多樣的3D姿態生成。例如,正如指揮使用音樂家肢體語言的視覺線索和樂器的聽覺線索來指導管弦樂隊一樣,團隊提出的方法尋求利用視覺和音頻數據的互補優勢。

圖1說明了所提出方法的核心思想,在給定任意音頻剪輯的情況下,所提出方法可以生成自然、多樣和逼真的姿態,展示了克服現有限制的潛力。

VarGes是一個復雜的框架,包括三個關鍵模塊:VEFE,VCSE和VDGP。VEFE模塊旨在通過無縫集成從樣式參考視頻中提取的StyleCLIPS來豐富語音衍生功能。這種整合捕獲了手勢節奏和幅度等信息,從而增加了輸入的樣式多樣性。

在此之后,VCSE采用了一個基于transformer的編碼器,以使StyleCLIPS的魯棒編碼成為深度學習表示,從而擴大了它們對姿態生成的影響。最后,VDGP模塊通過交叉注意和交叉條件自回歸模型巧妙地結合了樣式代碼和MFCC音頻特征,促進了多樣化和自然3D手勢的生成。

實驗結果證明了所述方法的顯著有效性,在姿態多樣性和自然度方面都明顯優于現有方法。

相關論文:VarGes: Improving Variation in Co-Speech 3D Gesture Generation via StyleCLIPS

總的來說,團隊介紹了一種基于音頻的三維人體姿態生成框架VarGes,其重點是增強姿態的變化。VarGes的核心集成了三個協同模塊:VEFE將樣式參考視頻集成到3D姿態估計器中以提取StyleCLIPS,捕獲整體運動特征,如幅度,節奏和強度,從而豐富樣式細微差別的輸入。

VCSE對多種樣式表示進行魯棒編碼,而VDGP通過交叉注意集成了MFCC音頻特征和樣式編碼,以調制交叉條件自回歸模型,生成與音頻輸入一致的多種自然3D姿態。

在基準數據集上的大量實驗驗證了所提出方法在保持自然度的同時顯著增強姿態變化的優越性。

當然,盡管取得了可喜的成果,但研究面臨著一定的局限性。首先,目前的方法尚未完全優化多人場景,需要進一步的探索和擴展。其次,盡管已經成功地整合了音頻特征和樣式信息來增強姿態生成的多樣性,但在多樣性和自然度之間的平衡方面依然有很大的優化空間。未來的研究將側重于將應用擴展到多人場景,引入更深層次的語義理解,并進一步提高生成姿態的自然度和多樣性。